Article body

Introduction

En 2008, dans le New Palgrave, Francesco Guala déplorait que « l’histoire de l’économie expérimentale rest[ât] encore à écrire » (Guala, 2008 : 152). Les recherches récentes permettent de retracer avec une précision croissante le processus par lequel l’économie expérimentale est progressivement devenue une sous-discipline à part entière du domaine, scientifique et académique, de la théorie économique et de ses applications (Roth, 1995; Serra, 2012a). Il ne s’agira pas ici de retracer le détail de cette histoire, mais de rappeler quelques-uns des grands jalons qui, depuis le milieu du XXe siècle, ont marqué l’institutionnalisation croissante de l’économie expérimentale – et, par là, la constitution des faits expérimentaux en objets légitimes de la théorie économique.

A la suite d’Alvin Roth, l’historiographie considère souvent le paradoxe de Saint-Pétersbourg, formulé par Daniel Bernoulli, comme l’une des premières expériences en économie. Paradoxalement, tout semble pourtant commencer avec l’interdit jeté sur la possibilité même de procéder à des expérimentations en économie par celui qui faisait figure de meilleur spécialiste de la méthodologie économique de son temps, John Stuart Mill. Dans le texte rédigé sous le titre On the Definition of Political Economy; and on the Method of Investigation Proper To It (Mill, 1836, 1967)[1], dont il fera le Livre V du System of Logic, Ratiocinative and Inductive, John Stuart Mill, pourtant farouche défenseur de la méthode inductive, seul moyen selon lui d’avancer dans un processus de découverte scientifique, refuse aux « sciences morales » la possibilité de se livrer à des expérimentations contrôlées et reproductibles.

L’interdit posé par John Stuart Mill fait office de règle épistémologique jusqu’au début du XXe siècle, lorsqu’à la suite du Methodenstreit, les auteurs nord-américains rattachés au courant institutionnaliste étayent les critiques qu’ils adressent aux théories marginalistes sur une revendication inductive et expérimentale. Pour reprendre la distinction proposée par Leo Corry entre image of knowledge et body of knowledge (Corry, 1989), il y a là un curieux cas d’ « image de savoir » qui précèderait un « corps de savoir ». Aux États-Unis, les années de haute théorie sont des années de quête d’une nouvelle scientificité expérimentale – une scientificité qui confèrerait à la discipline économique la possibilité de mettre en oeuvre des protocoles de même nature que ceux qui fleurissaient déjà depuis de longues années en physique, en chimie, en biologie, en médecine et dans la discipline qui fournira leurs protocoles aux premières expériences économiques : la psychologie sociale. Associé à l’institutionnalisation de l’économétrie[2] et à la pratique croissante de la modélisation, le thème est omniprésent. En 1924, à Chicago, dans l’allocution présidentielle qu’il prononce devant le 37e congrès de l’American Economic Association, Wesley Clair Mitchell invoque la nécessité pour l’économie de se transformer en science expérimentale (Mitchell, 1925). La même année, Rexford G. Tugwell coordonne un bilan sur l’état de la discipline, sous le titre The Trend of Economics (Tugwell, 1924). Il y consacre sa propre contribution, intitulée « Experimental Economics », à une économie expérimentale purement programmatique, sans que ni ses objets, ni ses protocoles ne soient précisés[3]. À Chicago, Henry Schultz, alors engagé dans ses recherches sur l’estimation statistique des fonctions de demande, incite l’un de ses collègues, le psychologue Louis Leon Thurstone, connu pour ses travaux de « psychophysique » et de « psychométrie », à construire expérimentalement une courbe d’indifférence[4] en soumettant à une collaboratrice une série de choix binaires entre des chapeaux et des chaussures, puis des chapeaux, des manteaux et des chaussures[5]. L’enjeu explicite de l’article, selon son auteur, concerne l’avenir des relations entre les deux disciplines : « The writer dares not venture far into the economic theory which may be implied in this psychophysical problem », écrit Thurstone, « but it is clear that here is a fertile field for investigation in a very old problem that overlaps economic theory and psychophysical experimentation » (Thurstone, 1931 : 139). À Berkeley et à Harvard, des universitaires construisent des bases de données soumises à un contrôle qualifié d’« expérimental » sur la consommation des ménages et leur appliquent des techniques, encore balbutiantes, de randomisation. À Harvard, toujours, les médecins, sociologues, anthropologues et économistes du Fatigue Laboratory lancent la première « expérience artificielle de terrain », à mi-chemin entre le terrain et le laboratoire, à l’usine Hawthorne de la Western Electric située à Cicero, dans la banlieue de Chicago (Cot, 2011).

On le voit, dès cette époque, le tabou posé par John Stuart Mill est discuté, critiqué, remis en cause – cela d’autant que d’autres sciences humaines, comme la psychologie, utilisent largement l’expérimentation. Mais aucun programme de recherche réellement structuré n’émerge encore de ces différentes initiatives.

Ce sera la grande affaire de la seconde moitié du vingtième siècle. On se restreindra donc dans cet article à la période qui suit la Seconde Guerre mondiale, au cours de laquelle se mettent en place les fondements du « tournant expérimental » en économie.

Si le récit de l’histoire de l’économie expérimentale est toujours en cours de construction, plusieurs de ses fondations ont déjà été posées. Les chronologies proposées reflètent des positions historiographiques différentes, selon qu’elles insistent sur l’histoire analytique, sur l’histoire des méthodes et des protocoles ou sur l’histoire plus institutionnelle de l’acclimatation progressive de l’économie expérimentale au sein des instruments de recherche et des dispositifs de preuves en économie. Nous emprunterons à ces différentes histoires pour insister sur un point précis, qui engage l’ensemble du projet expérimental : la construction et l’utilisation de faits économiques d’un type nouveau, les faits expérimentaux. Ces derniers, mis en évidence au sein d’environnements contrôlés, s’imposent petit à petit comme des faits économiques légitimes, fondés empiriquement, permettant tout à la fois de réaliser des inférences, de tester les théories existantes, d’en construire de nouvelles sur le fondement des régularités observées, en laboratoire ou sur le terrain, ou encore de fournir des arguments normatifs sur les « meilleures » manières d’orienter les comportements d’acteurs « réels » (Roth, 1995). En cela, ils deviennent des faits économiques, au même titre que les faits stylisés tirés de l’histoire économique ou des données statistiques compilées par les instituts de statistiques. Un long processus a été nécessaire pour fonder les conventions statistiques comme des catégories pertinentes pour décrire le réel. De la même manière, il a fallu plusieurs décennies pour que l’économie expérimentale réussisse à faire accepter qu’un laboratoire puisse constituer un meilleur poste d’observation pour faire surgir des faits que l’observation immédiate et directe du monde empirique. En ce sens, l’économie expérimentale sera considérée ici, à la suite de Vernon L. Smith, comme une méthode, un outil potentiellement applicable à de nombreux domaines, et non comme une théorie particulière de l’analyse économique[6]. On insistera principalement sur les expériences de laboratoire stricto sensu.

Nous proposons ici de retracer cette évolution autour de trois grands mouvements. Le premier, qui va de 1945 à 1970, correspond à une période de recherche éclatée, sans réflexion épistémologique construite sur la nature des faits expérimentaux. Le deuxième, qui court du début des années 1970 jusqu’à la fin des années 1980, est marqué par la mise en place de méthodes partagées par les expérimentalistes sur la définition des faits expérimentaux et des protocoles qui président à leur production. Émergent alors des faits stylisés nouveaux, réplicables, qui donnent naissance à autant de questions empiriques – anomalies, faits contre-intuitifs, confirmations sous conditions de prédictions théoriques – pour le cadre microéconomique standard. La troisième période (1990-2010), qui s’ouvre à la fin des années 1980, est celle de la reconnaissance de la légitimité des faits expérimentaux comme d’authentiques faits économiques. Ces derniers peuvent alors dialoguer d’une manière nouvelle avec la théorie, qu’elle soit positive ou normative, et avec ses applications.

1. Les premiers tâtonnements de l’après-guerre (1945-1970)

La théorie économique sort de la guerre profondément modifiée. Elle est devenue une science « instrumentée » (tool-based), selon le mot de Mary S. Morgan et se structure analytiquement autour de nouvelles méthodes (l’économétrie, l’axiomatisation, la modélisation, etc.). Par ailleurs, elle trouve dans les principes méthodologiques édictés par Milton Friedman en 1953 une épistémologie qui lui convient, faisant la part belle à l’instrumentalisme et excluant tout débat sur le réalisme des hypothèses.

Il peut dès lors paraître étonnant que ce soit précisément dans le contexte des années 1950 que l’on trouve des tentatives d’expérimentations qui marqueront durablement le programme expérimental. C’est au moment même où Leonard Savage axiomatise la théorie de la décision que Maurice Allais propose son paradoxe, tiré d’un questionnaire hypothétique (Allais, 1953a; 1953b); c’est au moment où Nash propose son concept d’équilibre en théorie des jeux que Merrill M. Flood cherche à en tester les prédictions (Flood, 1952; 1958); c’est au moment où Kenneth Arrow et Gérard Debreu axiomatisent la théorie de l’équilibre général que Vernon L. Smith, suivant en cela Edward H. Chamberlin (1948), effectue ses premières expériences de marché sur la convergence vers l’équilibre[7] (Smith, 1962).

Années de tâtonnements, l’après-guerre voit naître des idées qui seront développées de manière plus systématique par la suite. L’économie expérimentale s’articule alors autour de trois domaines principaux, bien identifiés : la théorie de la décision, la théorie des jeux et l’organisation industrielle[8]. Nous rappellerons d’abord les différentes expériences qui ont lieu dans ces domaines (section 1.1) pour ensuite en proposer une synthèse (section 1.2).

1.1 De l’organisation industrielle à la théorie des jeux et à la théorie de l’utilité espérée

Le premier domaine où les expériences sont conçues comme un outil de connaissance économique est celui de l’organisation industrielle. Edward H. Chamberlin propose, le premier, à ses étudiants, pour faire pièce aux critiques adressées à sa Theory of Monopolistic Competition (Chamberlin, 1933), de tester en cours différentes configurations de marché, à partir de la reproduction artificielle d’un marché de concurrence parfaite. Les résultats de cette expérience seront publiés après la Seconde Guerre mondiale (Chamberlin, 1948)[9]. Vernon L. Smith, qui y avait participé alors qu’il était graduate student à Harvard[10], reprend à l’Université Purdue, où il a été nommé en 1955, le programme expérimental d’Edward H. Chamberlin. À partir de 1956, il reproduit l’expérience inaugurale tout en en modifiant le protocole : il met en oeuvre une répétition d’un même marché et introduit le mécanisme de « double enchère publique » dont il estime qu’il reproduit le fonctionnement des marchés boursiers de manière plus « réaliste » que le processus de négociation bilatérale retenu par Edward H. Chamberlin[11]. Cela le conduit alors à corroborer, là où Edward H. Chamberlin cherchait à la critiquer, la théorie standard de la convergence vers un équilibre concurrentiel (voir Mirowski, 2002 : 546 sq. et Heukelom, 2014b).

Testant de nombreuses variantes de l’expérience initiale, Vernon L. Smith commence à être entendu. Après un premier rejet, plusieurs rapports négatifs et deux demandes de révision[12], son premier article, qui reprend 6 années de recherche et 10 expériences différentes, est publié en 1962 par le Journal of Political Economy. En 1963, Vernon L. Smith crée un séminaire de doctorat en économie expérimentale, auquel participent Don Rice, Hugo Sonnenschein, Norm Weldon et Tom Muench[13]. En 1963 et en 1964, il organise à Carnegie Mellon, en collaboration avec Lester Lave et avec le soutien de Dick Cyert, James March et Herbert A. Simon, une école d’été d’économie expérimentale financée par la Ford Foundation.

Pendant les années 1960 se mettent en place des expériences dans des situations de monopole bilatéral, de duopole ou d’oligopole. Le programme se développe d’abord à Berkeley, où Austin Hoggatt organise les premières expériences informatisées sur les marchés oligopolistiques (Hoggatt, 1959). La même année, à Penn State[14], Sidney Siegel, spécialiste de psychologie sociale expérimentale, et l’économiste Lawrence E. Fouraker entreprennent une série d’expériences sur les négociations en situation d’oligopole (Siegel et Fouraker, 1960; Fouraker et Siegel, 1963). Ces expériences contribuent à cristalliser trois aspects importants dans les protocoles : l’anonymat des sujets, l’importance du lien entre rémunération en monnaie et performances expérimentales des sujets et la relation entre les conditions d’information des sujets et les résultats de l’expérience[15] (Innocenti, 2010). Sidney Siegel rejoint ensuite un groupe de chercheurs déjà constitué à Stanford, qui associe, ici encore, économistes et psychologues, où il participe à un programme d’expériences sur la théorie de la décision en avenir risqué (Siegel, 1957; Davidson, Suppes et Siegel, 1957; Siegel, 1961). C’est là que, peu avant de mourir, il rencontre Vernon L. Smith. Enfin, il serait erroné de croire que cette histoire est uniquement américaine puisque c’est aussi à cette même époque que se structure, en Allemagne, un groupe d’expérimentalistes autour de Heinz Sauermann, Reinhard Tietz et Reinhard Selten (Dimand, 2005 : 17; Selten, 2008). Convaincu de la pertinence de l’approche expérimentale, Reinhard Selten développe des expériences sur les oligopoles (modèle de Cournot multipériode) qui annoncent les développements ultérieurs des années 1970 en économie industrielle.

Les expériences se développent également en matière de théorie des jeux. Fondée sur une analyse des interactions entre un nombre peu élevé de joueurs, la théorie des jeux se prêtait d’emblée à des tests sous forme de jeux expérimentaux. Au cours de l’été 1952, à Santa Monica[16], un séminaire de deux mois, financé par la Ford Foundation, la RAND Corporation, l’ONR (Office of Naval Research) et la Cowles Commission, est consacré au thème des expériences sur les processus de décision (« The Design of Experiments in Decision Processes »). Organisé à l’initiative du psychologue Clyde Coombs et du mathématicien Robert M. Thrall, il réunit des psychologues (Leon Festinger, David Beardslee, William Estes)[17], des mathématiciens (Stefan Vail, John von Neumann, John Nash, Merrill M. Flood, Lloyd S. Shapley) et des économistes (Jacob Marschak, Howard Raiffa, Gérard Debreu, Tjalling Koopmans, Armen Alchian, Oskar Morgenstern, Frederick Mosteller, Roy Radner, Herbert Simon)[18].

En 1950, Merrill M. Flood s’engage avec Melvil Dresher dans un programme d’expérimentations portant sur la notion d’équilibre non coopératif théorisée par John Nash. L’une de ces expériences mobilisait deux de leurs collègues de la Rand, Armen Alchian et le mathématicien John Williams, toujours appariés entre eux et confrontés l’un à l’autre au sein d’un « dilemme du prisonnier ». Les paiements du jeu se faisaient en dollars et, à la fin de l’expérience, les sujets recevaient une somme d’argent correspondant à ce qu’ils avaient gagné au cours du jeu. La conclusion de Merrill M. Flood et Melvil Dresher les incitait à rejeter le point d’équilibre de Nash pour lui préférer un argument coopératif du type ‘split the difference’ (Flood, 1952 pour le document de travail de la RAND Corporation; Flood, 1958, pour les réponses croisées de Nash et de Flood; ou encore Roth, 1995; ou Mirowski, 2002).

Ces expériences pouvaient apparaître comme assez naturelles aux théoriciens des jeux, habitués depuis quelques années, notamment à Princeton, à la pratique du gaming. Lorsqu’il évoque ces années, Martin Shubik rappelle cette habitude de sessions de jeux – connus ou inventés – entre théoriciens, souvent à l’heure du thé, pour discuter « de manière informelle des paradoxes ou des pathologies de certains jeux et de la possibilité d’inventer des jeux illustrant ces propriétés » (Shubik, 1992 : 158-159). John F. Nash, Martin Shubik, Lloyd S. Shapley, McCarthy, Mel Hausner, s’y adonnaient de manière avant tout ludique. « Nous ne nous intéressions pas directement aux jeux expérimentaux (experimental games), expliquera plus tard Martin Shubik, nous nous intéressions plutôt aux jeux auxquels nous pouvions jouer nous-mêmes (playable games) pour illustrer des paradoxes ou des aspects délicieux (cute aspects) et contre-intuitifs de la théorie des jeux. Ainsi, ‘So Long Sucker’, un jeu inventé par John Nash, Martin Shubik, Mel Hausner et Lloyd S. Shapley (dont le nom original était ‘Fuck Your Buddy’, Nasar, 1998 : 102), a été bricolé à Fine Hall pour montrer comment la trahison peut devenir une nécessité virtuelle si l’on veut gagner. » (cité par Smith, 1992b : 249 et sq.). Cette habitude perdurera tout au long des années 1960 dans les communautés académiques de jeunes mathématiciens. Dans son article de 1961 sur l’usage des jeux expérimentaux en sciences politiques, Thomas C. Schelling s’en montre d’ailleurs l’héritier légitime lorsqu’il affirme que les jeux expérimentaux peuvent devenir un outil heuristique de tout premier ordre afin de mieux comprendre la théorie, dans ses forces comme dans ses faiblesses (Schelling, 1961).

Le panorama de ce qui se joue dans les années 1950 ne serait pas complet sans rappeler enfin les expériences en théorie de la décision – et notamment les tests de la théorie de l’utilité espérée. En 1952, lors du « Colloque international sur le risque » qu’il organise à Paris du 12 au 17 mai[19], Maurice Allais propose à son collègue Jimmie Savage un « questionnaire expérimental »[20] sur les apories de la théorie de l’utilité espérée, dont il tirera un « paradoxe » (Allais, 1953)[21]. Le questionnaire apparaît très simple puisqu’il s’agit de deux choix hypothétiques entre des séries de loteries, A et B d’une part et C et D d’autre part, avec

A : Gagner 100 millions de francs de manière certaine

B : 0,89 chance de gagner 100 millions de francs, 0,01 chance de ne rien gagner, 0,1 chance de gagner 500 millions de francs.

C : 0,89 chance de ne rien gagner et 0,11 chance de gagner 100 millions

D : 0,9 chance de ne rien gagner et 0,1 chance de gagner 500 millions

Le questionnaire est ainsi rédigé que les loteries A et C d’une part, et B et D d’autre part sont liées. Dès lors, un agent rationnel pourrait tout à fait choisir A plutôt que B (ceci dépend de ses préférences et de son attitude par rapport au risque) mais dans ce cas, la rationalité lui impose de choisir C plutôt que D. Autrement dit, les couples (A, C) et (B, D) sont rationnels mais les couples (A, D) et (B, C) ne le sont pas et violent l’un des axiomes de la théorie de l’utilité espérée[22]. Pourtant, Savage, suivi par bon nombre des participants au colloque de Paris également interrogés, choisit A et D. Ce « résultat », qui ne sera appelé « paradoxe » qu’au cours des années 1970, suscite à l’époque de nombreuses réponses. Certains, comme Jimmie Savage, y voient simplement le fait que les acteurs peuvent faire des erreurs. Et, tout comme une erreur de calcul ne remet pas en cause l’arithmétique toute entière, une erreur de choix n’implique pas qu’il faille renoncer à la théorie de l’utilité espérée. D’autres, comme Jacob Marschak, voient dans ce résultat la preuve que la théorie de l’utilité espérée est une théorie normative, qui indique comment un agent rationnel doit se comporter, et non une théorie descriptive, qui dépeindrait des comportements effectifs[23].

La brèche ouverte par Maurice Allais contre les fondements de la théorie de la décision est très rapidement approfondie. En 1961, Daniel Ellsberg propose une expérience sur les décisions individuelles prises en environnement incertain, dont les résultats montrent l’existence d’une aversion à l’ambiguïté, c’est-à-dire une critique (passée à la postérité sous le nom de « paradoxe d’Ellsberg ») de l’hypothèse selon laquelle les sujets expriment des jugements probabilistes (Ellsberg, 1961). Parallèlement, à l’Université du Michigan, dont deux chercheurs avaient organisé le séminaire de Santa Monica, le psychologue Ward Edwards lance un programme d’expériences sur la théorie de l’utilité espérée (Edwards, 1961)[24].

1.2 Que retenir des premiers pas de l’après-guerre?

Dans chacun de ces trois domaines, les économistes qui réalisent des expériences communiquent peu entre eux. Ils échangent et discutent plutôt avec les théoriciens de leurs sous-disciplines respectives : Merrill M. Flood avec John Nash; Maurice Allais et Daniel Ellsberg avec Jimmie Savage; Vernon L. Smith avec les défenseurs des théories walrasienne et marshallienne. En aucun cas, on ne trouve de projet commun structuré regroupant ces différentes contributions et cela pour trois raisons.

D’abord, chacun des concepteurs d’expériences a son propre agenda : il s’agit de fonder une critique radicale de la théorie de l’utilité espérée – à la fois comme théorie descriptive et comme théorie normative – pour Maurice Allais; de tester les propriétés mathématiques des jeux lors de gaming pour Martin Shubik ou d’en montrer la force heuristique pour Thomas C. Schelling; de donner corps à « l’hypothèse de Hayek » pour Vernon L. Smith.

Ensuite, ces expériences se développent selon des méthodologies propres, dont l’ensemble est finalement assez disparate. Tandis que des paiements en monnaie sont utilisés par Merrill M. Flood, ils ne le sont pas par Edward H. Chamberlin; les choix sont réels chez Vernon L. Smith mais hypothétiques chez Maurice Allais. Dès lors, l’expérience tombe sous la critique déjà ancienne de W. Allen Wallis et Milton Friedman lorsqu’ils commentaient les premières tentatives des années 1930 :

(…) il est douteux qu’un agent dans une situation expérimentale aussi artificielle puisse savoir quels choix il ferait dans une situation économique; sans le savoir, il est presque inévitable qu’il systématiserait, de bonne foi, ses réponses de sorte à produire des résultats plausibles mais faux.

Et les auteurs ajoutent

de plus, pour qu’une expérience soit satisfaisante, il est essentiel que les agents réagissent réellement à des stimuli réels. Les questionnaires ou les autres moyens fondés sur des conjectures en réponses à des stimuli hypothétiques ne satisfont pas cette nécessité. Les réponses sont sans valeur car les agents ne peuvent pas savoir comment ils réagiraient [dans un contexte réel].

Wallis et Friedman (1942 : 179-180)

Enfin, parmi les principaux acteurs des années 1950, beaucoup, pour diverses raisons, se détournent de l’expérimentation, ou la considèrent comme un domaine secondaire de leur recherche. Il manque clairement à cette génération une constance et une foi dans l’expérience. Merrill M. Flood et Melvil Dresher publieront finalement peu leurs travaux, Maurice Allais ne reviendra pas à son paradoxe avant de longues années, Sidney Siegel disparaît prématurément en 1961; Thomas C. Schelling, Martin Shubik ou John Nash voient l’expérimentation comme un complément utile mais non comme une priorité pour la théorie des jeux. Seul Vernon L. Smith continuera dans les années 1960 mais restera relativement isolé.

Mais si les hommes partent ou se détournent, restent cependant certaines idées structurantes pour la suite du développement du programme expérimental (Roth, 1995). D’abord, il apparaît clairement que l’économie expérimentale peut être féconde dans un nombre important de domaines de la théorie économique. L’étude de la rationalité et de ses paradoxes est promise à un bel avenir, auquel participeront largement certains des élèves de Ward Edwards, comme Amos Tversky et Paul Slovic. C’est également le cas des tests de jeux simples illustrant des dilemmes sociaux (dilemme du prisonnier, jeu de l’ultimatum, jeu du dictateur, jeu du bien public…).

Du point de vue méthodologique, trois questions ont été éclaircies à la fin de cette période. Premièrement, il semble nécessaire d’avoir recours à des choix réels lors des expériences et d’accompagner ces choix de paiements en monnaie. C’est la conviction initiale de Siegel, qui devient également celle de Vernon L. Smith dans les années 1960. Deuxièmement, le fait d’induire les valeurs chez les individus par le truchement de disponibilités à payer ou à vendre imposées dans le cadre de l’expérience (et ne correspondant donc pas nécessairement aux vraies préférences des joueurs) constitue un pas méthodologique important. Sous l’hypothèse selon laquelle les acteurs cherchent à maximiser leur utilité, le fait de leur imposer des disponibilités à payer ou à vendre permet de comparer de manière stricte les résultats des interactions réalisées lors de l’expérience avec les prédictions théoriques, puisqu’il est simple de calculer les quantités et les prix d’équilibre concurrentiel. Troisièmement, les résultats sont extrêmement sensibles aux protocoles et aux règles du jeu que ces derniers mettent en place. C’est la leçon principale des expériences de Vernon L. Smith comparées à celle d’Edward H. Chamberlin. En substituant une règle de double enchère publique à la procédure de négociation bilatérale décentralisée avec affichage des transactions utilisée par Edward H. Chamberlin, Vernon L. Smith obtient des performances très différentes. Ainsi, « le marché » ne signifie rien sans une spécification extrêmement précise des institutions qui régissent les échanges. Sidney Siegel et Lawrence E. Fouraker parviennent à la même conclusion, sur le fondement de laquelle se développera très largement la méthodologie de l’économie expérimentale dans la période suivante (sous l’impulsion, notamment, de Vernon L. Smith et de Charles R. Plott). Tout fait expérimental devra faire l’objet d’une construction méthodologique minutieuse : que l’on modifie même marginalement le protocole, et les résultats comme les comportements peuvent en être affectés.

2. Fonder de nouvelles méthodes, construire de nouveaux faits (1970-1990)

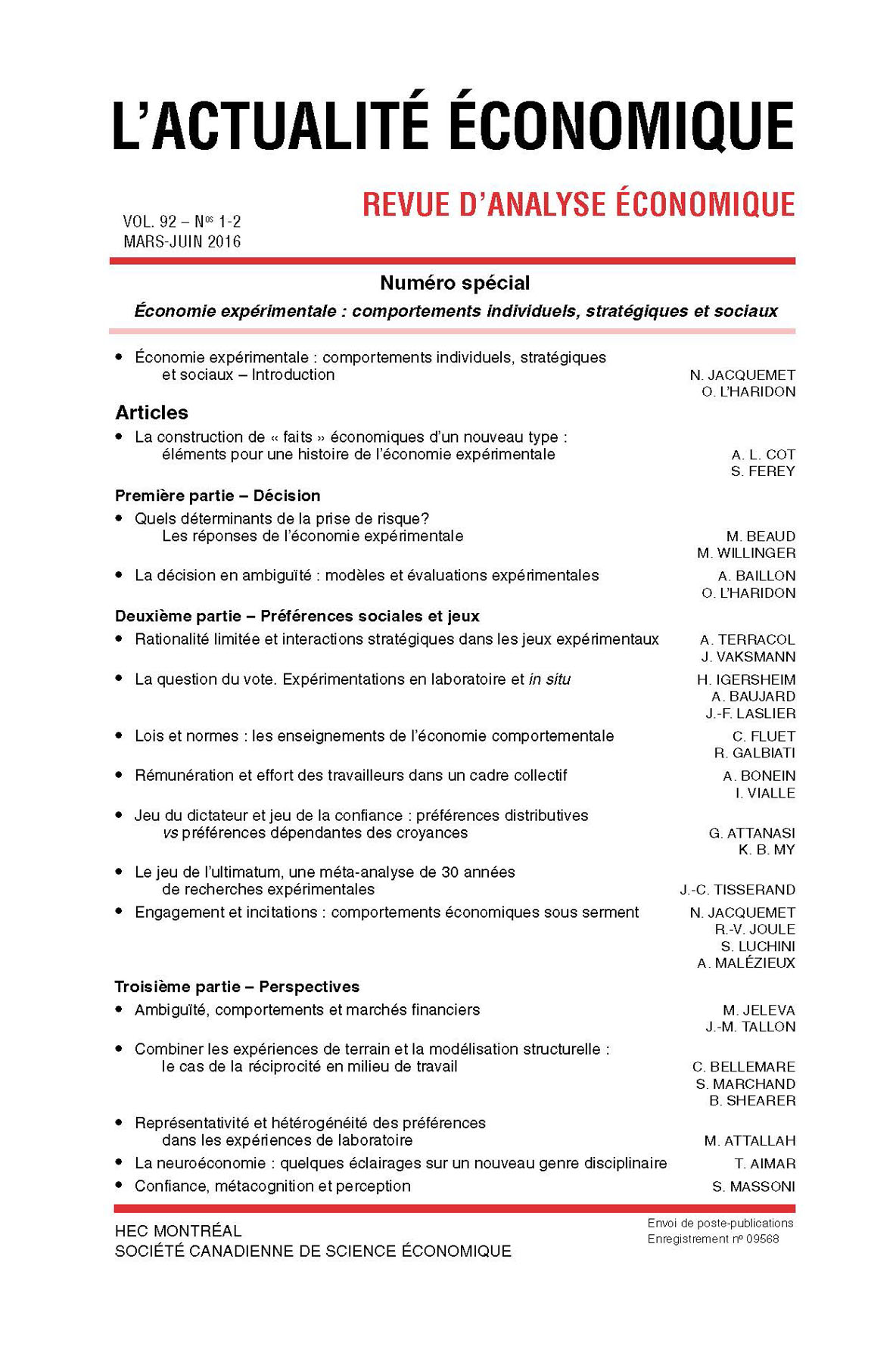

La période qui s’étend du début des années 1970 à la fin des années 1980 constitue la période fondatrice du domaine. L’économie expérimentale se construit alors comme un champ disciplinaire ayant des objets et une méthode clairement identifiés et produisant des résultats suffisamment solides pour constituer de nouveaux « faits » économiques. Ce processus débouche sur la création, en 1986, d’une nouvelle société scientifique, l’Economic Science Association[25], suivie d’une nouvelle sous-section dans la nomenclature du Journal of Economic Literature nommée « Experimental EconomicMethods », puis, sous le même intitulé, d’une section entière en 1991.

Deux éléments participent de ce changement d’échelle des travaux expérimentaux. D’une part, les premières réflexions systématiques apparaissent sur les méthodes et les protocoles à disposition de l’économie expérimentale. Émergent alors progressivement une manière de faire parler les faits de laboratoire et un ensemble de conventions scientifiques partagées par une communauté de chercheurs, sur la nature des expériences et des protocoles (section 2.1). D’autre part, de nombreuses expériences couvrant un large spectre de la théorie économique se mettent progressivement en place, suivant en cela les lignes ouvertes à la période précédente (section 2.2).

2.1 Méthodes, protocoles et conventions scientifiques

Après des années de marginalité au sein de la discipline, l’économie expérimentale commence à s’institutionnaliser. En 1975, Vernon L. Smith rejoint l’Université de l’Arizona pour y mettre en place, avec Arlington Williams, un important laboratoire d’économie expérimentale, l’Economic Science Laboratory. Quatre ans plus tard, en 1979, il coordonne et publie un volume de recherches en économie expérimentale (Smith, 1979)[26]. Dès lors, le rythme de l’institutionnalisation de l’économie expérimentale s’accélère rapidement. Des laboratoires se créent dans plusieurs universités américaines, à l’initiative de Raymond C. Battalio et John H. Kagel à la Texas A&M University; de Charles R. Plott à Caltech pour le Laboratory for Experimental Economics and Political Science; d’Arlington Williams et James Walker à l’Université de l’Indiana; de Robert Forsythe à l’Université de l’Iowa; de Austin Hoggatt à Berkeley; d’Alvin Roth à Pittsburgh; de Charles Holt à l’Université de Virginie[27].

Parallèlement à ces percées dans le paysage académique nord-américain, Amos Tversky entame en 1969 une collaboration avec Daniel Kahneman à l’Université hébraïque de Jérusalem sur les jugements et les décisions des individus. Elle s’élargit à d’anciens élèves de Ward Edwards, comme Paul Slovic. Produits de ces nouveaux échanges, deux articles marquent cette période, celui d’Amos Tversky et Daniel Kahneman de 1974 sur les biais et les heuristiques et celui de Sarah Lichtenstein et Paul Slovic de 1971 sur le renversement des préférences.

En Europe, si le mouvement est plus tardif de quelques années, il suit néanmoins celui des États-Unis[28]. En Allemagne, où les recherches en économie expérimentales ont commencé depuis les années 1950, Reinhard Selten monte le Laboratory of Experimental Economics à Bonn. Viennent ensuite l’Angleterre (l’Experimental Economic Center (EXEC) à York), les Pays-Bas (le Center for Research in Experimental Economics and Political Decision Making–CREED–à Amsterdam), la Catalogne (le Laboratori d’Economia Experimental–LeeX–à Barcelone), l’Italie, ou encore la France où Bertrand Munier monte à Paris, en 1989, le Groupe de Recherche sur l’Information et la Décision (GRID)[29]. Les publications des économistes expérimentalistes gagnent en importance. S’il a été difficile pour James Friedman de convaincre les éditeurs de la Review of Economic Studies de publier un symposium sur le sujet en 1969, les grandes revues généralistes (comme l’American Economic Review) commencent à publier des articles d’économie expérimentale et de nouvelles revues voient le jour au cours de la période 1970-1990. La moyenne annuelle des articles publiés passe de 30 par an dans les années 1970 à plus de 100 par an dans les années 1990. Même s’il faut prendre avec précaution ce type de données puisque le nombre de revues a fortement évolué pendant cette période et que le total des publications en économie expérimentale reste faible par rapport à l’ensemble des publications en économie, il reste que ceci témoigne d’un intérêt croissant pour ce type de méthode. Les Handbooks, les Surveys et les manuels d’économie expérimentale suivent le même mouvement, à l’instar de ceux d’Alvin E. Roth, de Vernon L. Smith, de John Hey ou de Charles R. Plott.

L’économie expérimentale dispose également de soutiens de plus en plus affirmés de la part des fondations de recherche. Ainsi, à partir de 1984, la fondation Alfred P. Sloan et la Russell Sage Foundation soutiennent le programme d’économie comportementale de Daniel Kahneman, Amos Tversky et Richard Thaler. Après un premier colloque organisé en 1984 à Princeton, suit toute une série d’initiatives pour permettre aux chercheurs intéressés par la nouvelle théorie de pouvoir échanger et travailler de manière collective (Heukelom, 2012). Richard Thaler, avec le soutien d’Eric Wanner de la Russell Sage Foundation, joue un rôle central pour développer en économie les idées et le programme de recherche de psychologie porté par Daniel Kahneman et Amos Tversky. Grâce à ces soutiens, il développe, avec Robert J. Shiller, le domaine de la finance comportementale[30] et publie à partir de 1987 une série d’articles sur les « anomalies » comportementales en économie dans les colonnes du Journal of Economic Perspectives.

Cette effervescence autour de l’économie expérimentale aurait pu constituer un feu de paille si cette période n’avait été celle de la consolidation méthodologique des protocoles. À partir du milieu des années 1970, plusieurs expérimentalistes cherchent à codifier les méthodes et à réfléchir sur la nature des faits expérimentaux, comme le révèlent les articles de Vernon L. Smith (1976, 1982, 1985), de Charles R. Plott (1982) ou encore, un peu plus tard, de Alvin E. Roth (1988).

Pour les tenants de l’approche expérimentale, il importe de préciser les concepts méthodologiques fondamentaux qui assurent que les faits produits dans le laboratoire puissent être considérés comme « objectifs ». En définissant ce qu’est un système microéconomique, Vernon L. Smith donne des fondements consensuels à la méthode expérimentale. Selon lui, le laboratoire reproduit un système microéconomique constitué de trois éléments : l’environnement, les institutions et une mesure de la performance. L’environnement est constitué de caractéristiques qui ne peuvent être modifiées par les agents lorsqu’ils interagissent entre eux (Smith, 1982 : 924), comme leur nombre, la technologie qui est à leur disposition, leurs dotations ou leurs fonctions d’utilité. Cet environnement est complété par des institutions qui précisent les manières de communiquer entre les agents ou les règles d’échange (comme les règles d’enchère). Enfin, il est nécessaire de disposer d’une mesure de la performance – c’est-à-dire d’un critère d’efficacité – des résultats obtenus. Pour créer cette méthodologie, l’économie expérimentale emprunte ainsi à l’économie du bien-être (le critère de performance) et à la théorie des mécanismes (mechanisms design). À l’intérieur de ce système, les comportements individuels peuvent être observés. Il s’agit alors de savoir si des institutions différentes ou des variations de l’environnement conduisent à des résultats différents, mesurés par les performances du système microéconomique ainsi défini.

Dans ce cadre, l’expérience permet d’observer un nombre plus important d’éléments que d’autres méthodes empiriques. Ainsi, non seulement les comportements des acteurs peuvent être très précisément observés mais également leur niveau d’information sur leur environnement, sur les incitations des autres joueurs ou encore sur la structure du contexte de leur interaction et sur les institutions dans lesquelles ils effectuent leur choix. L’expérience permet surtout de contrôler certaines variables. C’est la clef de la méthode expérimentale (Guala, 2012). Le point crucial, qui donne lieu à un débat entre Ronald A. Heiner et Vernon L. Smith en 1985, porte sur le contrôle des préférences : reprenant la théorie de la valeur induite (induced value theory) qu’il avait introduite en 1976, Vernon L. Smith légitime l’un des aspects essentiels de la méthode expérimentale : les expériences n’utilisent pas les « vraies » préférences des acteurs, mais des préférences induites par l’expérience, par exemple sous la forme de disponibilité à payer ou à vendre prédéterminées par le protocole expérimental[31]. Une partie des éléments inobservables dans le monde économique réel devient ainsi un artifice que l’expérimentaliste peut connaître et contrôler.

Quatre préceptes méthodologiques sont alors posés par Vernon L. Smith : non-satiety (la non-satiété) saliency (la proéminence), dominance (la dominance), et privacy (le secret)[32]. Respecter ces quatre préceptes permet d’assurer la validité interne de l’expérience, c’est-à-dire le fait que l’hypothèse testée est validée ou non. Mais cette validité est évidemment réduite aux conditions de l’expérience et aux agents y ayant participé et rien n’assure qu’il soit possible d’en généraliser les résultats. La validité interne ouvre alors sur le problème de la validité externe ou, pour reprendre les termes de Vernon L. Smith, du parallélisme entre les phénomènes de laboratoires et les phénomènes économiques en dehors du laboratoire. Pour Vernon L. Smith, comme pour Charles R. Plott (Plott, 1982), les lois économiques s’appliquent partout – et notamment au sein du laboratoire : « les propositions concernant le comportement des individus et les performances des institutions qui ont été testées au sein des microéconomies de laboratoires s’appliquent aussi aux microéconomies en dehors du laboratoire (nonlaboratory microeconomies) » (Smith, 1982 : 936). Assurer ces principes permet une réplication des expériences qui conforterait leur objectivité et garantirait également une variété dans les traitements suffisante pour espérer faire ressortir des faits et des régularités robustes[33].

Ces principes amènent alors à caractériser différents types d’expériences. Une première typologie est fonctionnelle, selon que l’on teste une variation de l’environnement ou des institutions. Une seconde est plus épistémologique et distingue les expériences établissant des lois, qui cherchent à tester de manière directe les prédictions théoriques, les expériences heuristiques cherchant à explorer de nouveaux faits non prévus par les théories et les boundary-experiences qui ont pour vocation de tester les limites d’une théorie. En suivant ces conventions méthodologiques, les expérimentalistes peuvent proposer des faits stylisés expérimentaux (Smith, 1982 : 943).

Dans un langage très inspiré de l’épistémologie falsificationniste de Karl Popper, qu’il cite dans son article, Vernon L. Smith conclut :

La recherche de laboratoire en microéconomie depuis les deux dernières décennies s’est focalisée sur les plus simples et les plus élémentaires des questions. Ceci parce que les prémisses de cette recherche sont que nous possédons très peu de savoir qui peut être démontré, que les fondements de notre discipline requièrent un réexamen complet et que nous n’en sommes qu’au commencement de ce processus. Surtout, nous avons besoin de développer un corps de connaissance qui clarifie la différence entre ce que nous avons créé (la théorie comme hypothèse) et ce que nous avons découvert (des hypothèses falsifiées ou non par l’observation).

Smith (1982 : 952)

À ce stade de son développement, cette méthode répond aux deux arguments principaux qui avaient été élevés contre l’expérimentation en économie : l’effet de taille et le manque d’accès aux données. La formalisation des systèmes microéconomiques permet à Vernon L. Smith et à Charles R. Plott de concevoir les lois économiques comme des lois générales, qui s’appliquent aussi à des faits particuliers. La notion de valeur induite répond à l’argument du manque d’accès aux données. Cependant, ce qui préoccupe les expérimentalistes concerne avant tout la validité interne de l’expérience, c’est-à-dire les conditions sous lesquelles elle permet d’identifier des liens de causalité, soit par le contrôle de l’environnement, soit par la variation des institutions. Quant à la question de savoir si les faits mis en évidence au sein du laboratoire peuvent être pertinents pour décrire le monde économique hors du laboratoire, elle est traitée de manière pour le moins expéditive et laisse au lecteur un sentiment de frustration intellectuelle.

Les règles méthodologiques proposées par Vernon L. Smith ont joué un rôle important d’unification des protocoles expérimentaux, permettant leur réplication et leur comparaison. Une unification qui n’est cependant que partielle : elle échoue à s’imposer à tous les travaux des expérimentalistes et notamment aux recherches inspirées de la psychologie, qui ne suivent pas nécessairement ces conventions scientifiques et restent attachées aux méthodes héritées de leur discipline, laissant la possibilité de choix hypothétiques ou d’entretiens individuels. De plus, en insistant sur la réplication, la falsification et la validité interne, elle tend à séparer, d’une part, les expériences de laboratoire et, d’autre part, les expériences de terrain, qui trouvent un certain retentissement depuis qu’elles sont utilisées pour étudier les conséquences de dispositifs de politiques publiques (Smith, 1982 : 930)[34].

2.2 Expériences fondatrices et faits stylisés expérimentaux

Au tournant des années 1970 se mettent en place les expériences fondatrices qui consolident la « réception passive » de l’économie expérimentale[35] et qui lui confèrent son statut de sous-discipline à part entière de l’économie. Ces expériences paradigmatiques, aujourd’hui encore largement commentées, répliquées ou discutées, ont permis à l’économie expérimentale de s’imposer comme une méthode capable de découvrir de nouveaux faits : non seulement des contre-exemples ou des paradoxes, comme c’était le cas dans les années 1950, mais des régularités suffisamment robustes en termes de réplication ou de sensibilité aux protocoles pour devoir être considérées comme des faits économiques légitimes..

Il s’agit du basculement le plus significatif de cette période. Des faits d’abord perçus comme anormaux, anecdotiques ou tout simplement dus à des manques de réflexion ou d’attention de la part des sujets, sont désormais conçus comme des comportements réguliers – et donc « normaux ». Ces derniers posent à la théorie des questions concernant son domaine de validité et questionnent les ressources dont elle dispose pour expliquer ces nouveaux faits.

Présenter toutes les expériences qui ont lieu à cette époque dépasserait largement le cadre de cet article : le développement de l’économie expérimentale est alors à la fois en croissance extensive (le nombre de domaines couverts par les expériences augmente significativement « enchères, jeu du bien public, jeu de l’ultimatum, biais comportementaux » et en croissance intensive (chaque domaine fait l’objet de plusieurs expériences). Le seul dilemme du prisonnier a par exemple donné lieu à des centaines d’expériences. Nous prendrons plutôt quelques exemples paradigmatiques, tirés des principaux domaines, pour comprendre comment un certain nombre de faits stylisés expérimentaux se sont imposés.

Le premier grand domaine d’expériences concerne la rationalité. Les résultats qui portent sur des comportements difficiles à traiter au sein de la théorie standard, comme le renversement des préférences, la temporalité des actions, les biais et heuristiques (statu quo, ancrage, disponibilité), les violations répétées de certains axiomes de la théorie de l’utilité espérée, les effets de cadrage ou encore l’endowment effect (différence entre la disponibilité à payer et la disponibilité à vendre un même bien) deviennent trop robustes pour qu’il reste possible de les ignorer. Ils commencent à être systématiquement étudiés.

Le paradoxe d’Allais en fournit un bon exemple. Les travaux de cette période donnent « au paradoxe d’Allais son statut actuel de résultat expérimental » (Mongin, 2014 : 753). Plusieurs études (MacCrimmon, 1968; Moskowitz, 1974; Slovic et Tversky, 1974; Kahneman et Tversky, 1979; MacCrimmon et Larsson, 1979) reprennent l’intuition de Maurice Allais pour en tester la robustesse et en faire varier les paramètres (montants en jeu, manière de présenter le choix, forme du paradoxe)[36]. Ces études montrent qu’un nombre substantiel de sujets violent la théorie de l’utilité espérée en faisant des choix qui s’avèrent incohérents du point de vue de la rationalité formelle. Elles permettent également de comprendre pourquoi les sujets font ces choix, par le truchement d’entretiens et d’explication du paradoxe aux acteurs. Pourtant, même à l’issue de ces entretiens, certains sujets s’en tiennent à leurs choix initiaux, ce qui exclut de la sorte que le paradoxe soit simplement dû à un manque d’attention ou à une erreur passagère.

Dans l’exemple du paradoxe d’Allais, c’est par le biais de la réplication que se forme un consensus sur sa signification empirique. Il est considéré comme un fait contredisant la portée descriptive de la théorie de l’utilité espérée, alors même que l’idée initiale de Maurice Allais, qui visait une remise en cause de la portée normative de la théorie, tombe peu à peu dans l’oubli (Mongin, 2014). Ces multiples expériences s’accompagnent d’une théorisation poussée afin d’en expliquer les ressorts comportementaux. Ainsi, l’escompte hyperbolique vient expliquer pourquoi les préférences peuvent se renverser à travers le temps; la théorie des perspectives de Daniel Kahneman et Amos Tversky fournit une rationalisation des différents effets comportementaux mis en évidence dans les expériences. Et grâce à cette théorisation, les résultats expérimentaux peuvent trouver de nombreux domaines d’application en dehors du laboratoire stricto sensu.

Dans d’autres domaines, la construction de faits expérimentaux se fait d’une manière différente. L’exemple de la malédiction du vainqueur en théorie des enchères – un des domaines majeurs de l’économie expérimentale à partir des années 1970 – est ici topique. Dans sa version moderne, on parle de malédiction du vainqueur dans le cas des enchères à valeur commune c’est-à-dire lorsque l’objet vendu a la même valeur pour tous les enchérisseurs (les réserves d’un puits de pétrole, par exemple). Or, même si les acteurs ne se trompent pas en moyenne sur la vraie valeur du bien, l’évaluation individuelle peut s’en écarter à la hausse ou à la baisse de manière aléatoire. Dès lors, celui qui gagnera l’enchère sera celui qui valorise le plus le bien : ce sera aussi celui qui se trompe le plus à la hausse sur sa vraie valeur. Gagner l’enchère devient ainsi une mauvaise nouvelle puisque cela concrétise le fait que l’on s’est le plus trompé. Initialement, ce phénomène provient d’études empiriques réalisées au début des années 1970 sur les concessions pétrolières (Capen, Clapp et Campbell, 1971). La réponse théorique ne s’est pas fait attendre et a consisté à montrer que ce phénomène ne peut pas avoir lieu avec des agents rationnels, chacun faisant des offres conditionnées au fait d’être vainqueur (Cox et Isaac, 1984). L’économie expérimentale permet de trancher le débat : en faveur de l’existence du phénomène, contre la théorie (Bazerman et Samuelson, 1983; Thaler, 1988).

Un troisième exemple est donné par les dilemmes sociaux illustrés par le jeu du bien public (Ledyard, 1995). Les expériences développées par Robyn M. Dawes (Dawes, McTawish, Shaklee, 1977; Marwell et Ames, 1979) se concentrent sur l’une des prédictions de la théorie pure des biens publics, selon laquelle un mécanisme décentralisé de fourniture de bien public n’atteindra jamais l’optimum lorsque chaque agent a intérêt à resquiller (comportement de passager clandestin). Cette prédiction prend une tonalité nouvelle avec la publication de Garrett Hardin sur la tragédie des communs, largement reprise ensuite par la nouvelle histoire économique et par la théorie des coûts de transaction développée par Douglass C. North, qui insistera sur le rôle des droits de propriété privés pour mettre fin à cette « tragédie ».

Pourtant, les premiers résultats des expériences apparaissent d’emblée en demi-teinte. On n’y voit pas de confirmation de la prédiction théorique : les sujets ont tendance à contribuer volontairement au bien public, mais moins que ce que requerrait l’optimum. Autrement dit, l’expérience débouche sur une double interrogation, empirique et théorique, et l’hypothèse d’égoïsme et d’absence de coopération ne semble pas complètement pertinente. Ces premières expériences ouvrent alors sur une série de questions plus intéressantes sur l’existence possible d’environnements et d’institutions qui favoriseraient la coopération (type de communication, anonymat, effet de seuil).

Cet exemple du jeu du bien public est révélateur de ce qui se passe pendant cette période. L’économie expérimentale ne se contente plus de tester des prédictions théoriques, elle s’appuie sur ses résultats pour développer son propre programme de recherche. En ce sens, on peut dire que ce programme devient réellement progressif, pour reprendre le terme de Imre Lakatos, à ce moment précis où non seulement il répond à des questions qui lui sont posées de l’extérieur, mais où il produit également de nouvelles questions sur le fondement des régularités observées. Ce dernier exemple illustre ainsi un troisième usage des faits expérimentaux : d’un côté, ils ont une signification au sein de théorisations préalables (le montant de la contribution volontaire par exemple); de l’autre, ils ouvrent sur des significations nouvelles : les thèmes de la réciprocité, ou des normes sociales, deviennent déterminants pour expliquer les résultats expérimentaux[37], modifiant en retour à la fois les protocoles des expériences[38] et l’articulation entre la théorie économique et les autres sciences sociales (comme la sociologie ou la psychologie). Les travaux empiriques plus récents sur les biens publics, comme ceux d’Elinor Ostrom, sont clairement les héritiers de ces premières recherches expérimentales.

3. Le succès de l’économie expérimentale (1990-2010)

L’économie expérimentale connaît un succès grandissant pendant les années 1990-2000, étroitement lié à sa reconnaissance institutionnelle – le lancement de la revue Experimental Economics en 1998, le prix Nobel décerné en 2002 à Daniel Kahneman et Vernon L. Smith – et au renouvellement du statut des faits expérimentaux et de leur usage en dehors des laboratoires (section 3.1).

L’économie expérimentale est alors suffisamment sûre de ses préceptes et de sa production scientifique pour affronter les critiques concernant la signification empirique de ses résultats.

Si plus personne ne doute que les « faits » produits en laboratoire sont bien des faits économiques, en revanche, la signification de ces faits en dehors du laboratoire reste un objet de débats. L’articulation simple entre expériences et tests laisse place à des réflexions renouvelées sur les relations entre faits expérimentaux et théories, qui impliquent des usages multiples de ces nouveaux faits. Aussi le thème du parallélisme (validation externe) prend-il de l’ampleur, développé aussi bien par les expérimentalistes, que par les économistes non expérimentalistes et les philosophes des sciences (section 3.2).

Enfin, les années 1990 marquent une scission de plus en plus importante entre le programme comportemental et le programme expérimental stricto sensu. Si cette scission était déjà en germe dans la période précédente, comme le montre la difficulté de Richard Thaler à structurer au sein de la Russell Sage Foundation des recherches qui allient économie comportementale et économie expérimentale, celle-ci se consolide autour de deux oppositions, méthodologique et théorique (section 3.3).

3.1 Pourquoi faire des expériences? Les nouveaux usages des faits expérimentaux

Période de maturité selon Daniel Serra (Serra, 2012a), les années 1990-2000 clarifient la place de l’économie expérimentale au sein de la discipline économique. Ainsi, Vernon L. Smith (1992) ou Alvin E. Roth (1987 et 1995) ont-ils eu l’occasion de préciser leurs conceptions de l’usage des faits expérimentaux en économie. Il est frappant de voir combien, lors de l’inauguration du Leex, le laboratoire d’économie expérimentale de l’Université Pompeu Fabra, le propos de Vernon L. Smith est plus assuré sur ce que peut réaliser l’économie expérimentale (Smith, 1992a, repris dans Smith, 1994). Sept objectifs lui sont clairement assignés (Smith, 1992a : 8; Smith, 1994 : 113-115) : tester les théories ou les sélectionner entre elles, comparer les institutions, comparer les environnements, explorer les causes de l’échec d’une théorie, établir des régularités empiriques comme fondement de nouvelles théories, évaluer les politiques publiques, utiliser le laboratoire comme un banc d’essai du design institutionnel[39]. Ces objectifs ne sont certes pas nouveaux[40], mais les deux derniers définissent l’une des évolutions majeures de ces 20 dernières années, au cours desquelles l’économie expérimentale se pose de plus en plus comme un outil d’aide à la décision publique.

3.1.1 Évaluation des politiques et aide à la décision publique

C’est là l’une des caractéristiques majeures de la période récente : l’économie expérimentale apparaît désormais comme un outil incontournable d’évaluation des politiques publiques et des cadres réglementaires. Il ne s’agit plus simplement de comparer les performances d’institutions différentes au sein du laboratoire mais d’en tirer des conséquences pour comparer des institutions réelles, qu’il s’agisse de dispositifs incitatifs ou cognitifs, de réglementations, de lois et de dispositifs juridiques, ou encore d’institutions informelles. Les expériences de laboratoires peuvent, en cela, servir au politique de test d’une modification du cadre institutionnel. C’est ainsi, par exemple, que les expériences sont mobilisées dans le cadre des processus de dérégulation des marchés dans les années 1990, ou dans les mécanismes d’organisation de certains marchés, ceux de l’électricité ou des permis d’émissions de souffre aux États-Unis (Rassenti et al., 2002). Elles le sont aussi lorsque certaines pratiques contractuelles particulières, sur un marché donné, peuvent être considérées par le régulateur de la concurrence comme anticoncurrentielles, car favorisant les ententes, mais sans que des arguments purement théoriques ou modélisés soient déterminants. David M. Grether et Charles R. Plott proposent ainsi de tester ces pratiques contractuelles en laboratoire afin d’en évaluer le potentiel anticoncurrentiel (Grether et Plott, 1984; Smith, 1992). Les mises aux enchères des licences UMTS dans le secteur de la téléphonie mobile en Grande-Bretagne donnent un bon exemple de ce nouvel usage de faits expérimentaux. Le gouvernement anglais avait missionné une équipe de chercheurs sous la direction de Paul Kemplerer pour réfléchir au design optimal de l’enchère. Celui-ci compléta son analyse fine du marché (nombre d’enchérisseurs probables, possibilité d’entrée sur le marché, risque de collusion, etc.) par des expériences en laboratoire (Kemplerer, 2004 : 180). Et ces expériences eurent, selon lui, un rôle important dans la confiance que l’agence de télécommunication anglaise attribua à la procédure proposée.

Les années 1990-2000 ont également vu se développer une forme de convergence entre les expériences en laboratoire et les expériences de terrain. Nous analyserons plus tard les raisons méthodologiques de ce rapprochement, mais on peut dès maintenant noter qu’il n’est pas rare que les publications d’économie expérimentale envisagent aujourd’hui leur champ de recherche du double point de vue de la littérature pertinente des expériences en laboratoires et de celle des expériences de terrain contrôlées.

Ainsi, l’économie du développement, l’analyse de la pauvreté, l’économie du travail ou l’économie publique (éducation, santé, discriminations) ont-elles été fortement renouvelées par l’approche expérimentale (Shafir, 2012). Ce type d’expériences se multiplie, notamment à la demande des pouvoirs publics, pour évaluer certains dispositifs de politique publique – comme, par exemple, le programme de recherche défendu par Esther Duflo et Abhijit Banerjee, qui cherche à identifier les causes comportementales et cognitives de la pauvreté (Banerjee et Duflo, 2012). L’enjeu de ces travaux consiste à montrer, à l’aide d’expériences randomisées, que des modifications parfois très mineures de l’environnement, des institutions ou des incitations peuvent avoir de grandes conséquences sur la sortie de la pauvreté, en cassant certaines dynamiques comportementales inefficaces, comme la procrastination ou le renversement des préférences[41]. On teste alors de manière expérimentale différents dispositifs techniques ou économiques supposés lutter contre ces déficiences de la rationalité afin de sélectionner la politique la plus efficace au moindre coût.

Parallèlement, l’économie expérimentale a trouvé dans les normes juridiques un important domaine d’application (Sunstein, 2001). Dès lors que l’on prend au sérieux les faits stylisés comportementaux et les échecs de la rationalité individuelle, certains dispositifs juridiques limitant la liberté individuelle ou l’autonomie de la volonté, que la théorie standard jugerait inefficaces, peuvent être rationalisés comme autant de dispositifs permettant d’aider les acteurs à surmonter leurs biais cognitifs (Ferey, Jacquemet et Gabuthy, 2013).

3.1.2 Économie expérimentale et théorie normative

Enfin, la période contemporaine a été celle d’une articulation plus fine entre méthode expérimentale et théorie normative, où les faits expérimentaux nourrissent le renouveau de l’économie normative comme de la philosophie morale et politique[42]. Ce mouvement a plusieurs dimensions et se déploie sur un large spectre, allant de l’usage de protocoles expérimentaux en théorie du choix social – comme les tests de procédures d’élection – à des perspectives plus originales, qui cherchent à refonder la théorie normative sur le socle des résultats expérimentaux en théorie de la décision et des marchés. Le redressement cognitif, le paternalisme libéral ou le paternalisme asymétrique relèvent de cette catégorie, puisqu’il s’agit de justifier la légitimité politique ou morale d’interventions publiques inspirées par des faits stylisés comportementaux (Thaler et Sunstein, 2003, 2008; Camerer et al., 2003). Ainsi, pour le paternaliste libéral, la puissance publique est justifiée à influencer le comportement d’un agent en utilisant des nudges – des dispositifs utilisant les biais cognitifs dont souffrent les agents pour favoriser leur propre bien-être. Il peut s’agir, par exemple, de créer un certain contexte de décision pour jouer sur des heuristiques de cadrage (framing effects), ou encore des règles de défaut pour utiliser le biais de statu quo. L’opposition classique en philosophie morale et politique entre paternalisme et libéralisme prend alors une forme nouvelle, dans la mesure où ces politiques paternalistes respectent les choix formels des acteurs. Cette position paternaliste-libérale a suscité de nombreux débats normatifs (Saint Paul, 2011). On trouve d’ailleurs d’autres positions normatives défendues par les économistes expérimentaux lorsque ceux-ci insistent, au contraire, sur la capacité de certains cadres institutionnels à rendre les agents plus rationnels. Sans entrer dans le détail de ces controverses (Ferey, 2011), il s’agit ici de mettre en lumière le chemin parcouru au cours de la période contemporaine, dans la mesure où l’un des objectifs de l’économie expérimentale est maintenant de faire des faits expérimentaux le support de positions normatives argumentées.

3.2 L’évolution des débats méthodologiques

Un tel succès ne pouvait ignorer les questions de méthode et d’épistémologie. Pendant la période contemporaine, la réflexion sur les méthodes et la signification des tests expérimentaux s’enrichit et dépasse progressivement le seul cercle des expérimentalistes. Philosophes, sociologues et historiens commencent à s’intéresser à l’économie expérimentale pour en caractériser le domaine de validité (Guala, 2005; Morgan, 2005; Fontaine et Leonard, 2005; Cordeiro Dos Santos, 2010; Heukelom, 2014). Si l’on suit Francesco Guala, on peut résumer les lignes de force de ces débats autour de deux grandes questions épistémologiques : l’inférence et la validité interne des expériences d’une part, la représentativité des expériences de phénomènes économiques – leur validité externe – d’autre part.

En poussant à l’extrême le parallèle entre les domaines expérimentaux – l’économie expérimentale se présentant comme la dernière-née des sciences expérimentales, après la physique ou la chimie –, ses fondateurs prêtaient le flan à ce que les critiques à l’encontre de celles-ci s’appliquent aussi à celle-là. Or, l’une des questions récurrentes en sciences « dures » est de savoir s’il est possible de tester de manière isolée une hypothèse par le biais d’une expérience : c’est le problème dit de Duhem-Quine. Comme l’écrit Francesco Guala, « les résultats expérimentaux n’indiquent pas la vérité/fausseté d’une hypothèse théorique isolée, mais plutôt de tout un corps de savoir liant entre elles des hypothèses théoriques et des hypothèses auxiliaires » (Guala, 2012 : 606-607). Comment savoir, dès lors, que l’expérience infirme l’hypothèse testée ou que l’infirmation vise une autre hypothèse de la théorie? C’est toute la question de l’inférence au sein du laboratoire qui se trouve posée. De plus en plus conscient de ce problème au cours de cette période[43], Vernon L. Smith, suivi en cela par certains épistémologues, pense qu’il est possible, en répliquant les expériences, en faisant suffisamment varier les protocoles, les environnements et les institutions, de sortir du dilemme de Duhem-Quine.

Même si l’on suppose le problème parfaitement résolu, l’inférence au sein du laboratoire ne doit pas faire oublier un autre type de validité : la validité externe, ou parallélisme. Ici encore, la réflexion s’est largement étoffée, pendant la période contemporaine, par rapport aux années 1980. On ne souscrit plus, par exemple, à la thèse de Charles R. Plott selon laquelle les lois économiques s’appliquent partout y compris dans les laboratoires[44]. Il s’agit de savoir si les faits observés au sein du laboratoire ont une « nature » similaire à ceux qui se développent dans l’économie réelle – et s’ils sont « représentatifs » de ces derniers (Hogarth, 2005). Prenons le cas des jeux de contribution au bien public. L’un des faits stylisés qui ressort de ces expériences montre une contribution très au-delà de ce que prévoit l’équilibre de Nash dans les premières itérations du jeu, puis une décroissance dans les itérations suivantes pour se rapprocher de l’équilibre de Nash. Quelles itérations doit-on considérer comme représentatives? Les premières itérations du jeu, qui montrent que les acteurs sont prêts à contribuer au bien public en renonçant à jouer passager clandestin? Ou les dernières, qui mettent en avant leur pure rationalité stratégique, indépendamment des conséquences sociales néfastes de leur comportement? Lequel de ces deux faits est finalement représentatif du comportement d’acteurs réels, contribuant à un bien public réel, c’est-à-dire en dehors du laboratoire (Loewenstein, 1999) ?

La question est d’autant plus complexe que l’économie expérimentale doit ici faire un arbitrage : soit construire un environnement et des institutions suffisamment artificiels pour être facilement contrôlés, mais au risque de perdre en représentativité; soit faire correspondre le plus possible le laboratoire aux contextes réels pour assurer la représentativité de l’expérience, mais au risque de ne pas contrôler correctement les différentes variables.

C’est dans ce contexte que les expériences de terrain – qu’elles soient naturelles ou contrôlées – sont de plus en plus apparues comme une synthèse prometteuse, capable d’assurer tout à la fois représentativité et contrôle[45]. Levitt et List considèrent, par exemple, que les expériences de terrains (field experiments) « provide a bridge between laboratory and naturally-occurring data in that they represent a mixture of control and realism usually not achieved in the lab or with uncontrolled data » (Levitt et List, 2009 : 2). On observe donc, ces dernières années, une forme de convergence, qui n’apparaissait pas au cours de la période précédente, où les deux littératures se développaient de manière autonome, ici sur les expériences de terrain, là sur les expériences de laboratoire – une convergence qui témoigne du questionnement de plus en plus important de l’économie expérimentale sur sa validité externe. Cette convergence est également liée à l’évolution, depuis quelques décennies, du langage de la causalité. En effet, alors que le concept de causalité était considéré en philosophie des sciences avec beaucoup de circonspection – notamment sous l’influence du positivisme logique qui y voyait une catégorie essentiellement métaphysique –, les années récentes ont vu une résurgence importante du langage de la causalité, qu’illustrent par exemple les théories contrefactuelles (Mackie, 1976; Hausman, 1992). Or, de ce point de vue, expériences de terrain et expériences en laboratoire partagent un point commun, qui concerne les manières possibles de considérer la construction d’un contrefactuel pertinent pour isoler un mécanisme causal (Guala, 1992).

Enfin, certaines recherches méthodologiques replacent les règles de l’expérimentation, non plus au sein des méthodes des sciences en général, mais au sein des méthodes de la théorie économique. C’est le cas de celles de Mary S. Morgan, qui analyse les expérimentations comme des « médiateurs » entre faits et théorie, comme le sont les modèles (Morgan, 2012). Simplement, à la différence du modèle, qui ne peut que surprendre le scientifique – en tirant toutes les conclusions d’hypothèses initiales parfaitement explicites –, l’expérience peut à la fois le « surprendre et [le] déconcerter » (surprise and confound). Contrairement au modèle, l’expérience travaille sur la même réalité que le système général qu’elle prétend étudier : elle est ainsi plus opaque que le modèle, mais également plus riche en enseignements[46]. Or, pour déconcerter l’expérimentaliste, il faut garantir, au sein de l’expérience, une certaine liberté d’action des sujets. C’est là tout l’art subtil de concevoir des expériences suffisamment contrôlées pour pouvoir être exploitées, sans pourtant que les comportements des sujets ne soient complètement déterminés par les contours (design) de l’expérience (Cordeiro dos Santos, 2010 : 143; Morgan, 2005 : 324).

Ces nouveaux débats méthodologiques n’affaiblissent pas l’économie expérimentale : ils justifient très largement la pertinence et la légitimité de l’approche expérimentale, tout en précisant les conditions de validité. Mais on trouve également des oppositions plus radicales, provenant de théoriciens comme Ken Binmore ou Ariel Rubinstein (Rubinstein, 2001)[47], qui reprochent moins à l’économie expérimentale de se tromper sur ce qu’est une expérience que de se tromper sur ce qu’est l’analyse économique elle-même. Ainsi, pour Rubinstein, qui s’appuie ici sur une position qu’avait tenue Robert J. Aumann au milieu des années 1980, l’analyse économique ne cherche pas à prédire mais à comprendre (au double sens de understand et de comprehend) le monde extérieur. Certes, l’application d’une théorie peut participer de la compréhension du monde, mais elle n’est en aucune façon réductible à cela. « Comprendre » signifie ici à la fois ramener de l’inconnu à du connu, s’interroger sur nos représentations du monde économique, relier des phénomènes entre eux pour en montrer la structure commune ou encore participer à la simplification du réel en réduisant l’observation complexe à des schèmes de base relativement simples (Aumann, 1985). Dans ce cadre, l’économie expérimentale ne peut constituer qu’une partie modeste de ce qu’essaye d’accomplir la théorie économique.

3.3 La rationalité, une fois encore

Pour conclure ce panorama – sélectif – des recherches contemporaines et de leur méthodologie, nous terminerons en insistant sur l’une des oppositions qui structure désormais l’économie expérimentale et la scinde en plusieurs branches : l’analyse de la rationalité individuelle et de sa place au sein de l’analyse économique. Les différences d’appréciation entre expérimentalistes qui se manifestaient dans la période précédente se sont approfondies au cours de la période contemporaine (Loewenstein, 1999)[48]. Une première branche de l’économie expérimentale reste attachée au programme de recherche comportemental. La méthode expérimentale y est utilisée pour évaluer l’hypothèse de rationalité. Héritière des travaux de Daniel Kahneman et Amos Tversky, elle considère que la théorie de l’utilité espérée axiomatisée par Jimmie Savage constitue une « bonne » théorie normative, en ce qu’elle décrit comment un agent rationnel doit se comporter, mais qu’elle ne constitue pas, en revanche, une bonne théorie descriptive (Heukelom, 2014). Dès lors, le seul usage raisonnable de la théorie de l’utilité espérée est de servir de trébuchet auquel comparer les actions réelles afin de constater l’écart plus ou moins grand entre comportements effectifs et comportements rationnels. Trois éléments attachés au concept de rationalité économique sont ainsi critiqués par ces auteurs. D’une part, la rationalité-cohérence : le fait d’avoir des préférences cohérentes et stables ne constitue pas une donnée empirique solide puisque ces préférences peuvent être changeantes, selon les contextes ou selon les époques. Ensuite, la conception de la rationalité comme processus d’adéquation optimale des moyens aux fins est elle aussi critiquée sur le fondement de l’imparfaite capacité des acteurs à traiter l’information de manière rationnelle. Les acteurs font des « erreurs » qui peuvent persister à travers le temps et même résister à toute opération de réflexivité ou d’explicitation. Un auteur comme Cass Sunstein illustre bien l’évolution de l’économie comportementale sur cette question. Après avoir défendu au milieu des années 2000 l’idée qu’il était possible de redresser les erreurs cognitives des acteurs (de les débiaiser : debiasing), il en vient à douter de la capacité des institutions (comme le droit ou la politique) à lutter efficacement contre ces biais. Enfin, à ceux qui identifient rationalité et recherche de l’intérêt personnel, l’économie comportementale répond que bon nombre d’actions sont dues à l’application de normes morales ou sociales et non à la recherche mécanique de l’intérêt individuel strictement défini.

Quelque peu différente, mais toujours au sein du programme comportemental, une deuxième branche de l’économie expérimentale tente de maintenir la notion de rationalité, tout en l’enrichissant pour la rendre cohérente avec les faits expérimentaux. On peut classer dans cette catégorie les théories des préférences sociales. Ici, ce sont moins les aspects cognitifs qui importent que la forme des préférences : l’utilité de l’agent se compose alors d’arguments proprement personnels et d’éléments de réputation ou de conformité sociale (Kuran, 1995). La littérature développée depuis le milieu des années 1990 autour des motivations intrinsèques et des motivations extrinsèques en est une illustration (Frey, 1997; Bénabou et Tirole, 2003)[49]. La même stratégie analytique est suivie par Ernst Fehr et Klaus M. Schmidt (1999), lorsqu’ils introduisent l’aversion à l’inégalité dans la fonction d’utilité des sujets. La maximisation de l’utilité ne provient alors plus uniquement des revenus possédés en propre par un individu, mais également des revenus des autres individus, par le biais de l’écart entre ceux-ci et celui-là. Des comportements altruistes pourraient ainsi être considérés comme des comportements maximisateurs, dès lors que l’agent gagne davantage de bien-être à diminuer l’inégalité qu’il n’en gagne à voir son revenu augmenter.

Enfin, une troisième branche de l’économie expérimentale se reconnaît davantage dans la rationalité écologique développée par Vernon L. Smith. Dans ce cadre, et dans une vision finalement proche de celle de Friedrich A. Hayek, il serait impossible de discuter de la rationalité des acteurs en tant que telle indépendamment du contexte de l’action. Pour le dire autrement, la rationalité n’est pas ici une caractéristique intrinsèque des individus mais un produit conjoint de leur action, de leur apprentissage, ainsi que des institutions et de l’environnement qui les entourent (Smith, 1994 : 117-118)[50].

On peut tirer deux conséquences principales de cette représentation. La première est que des institutions adéquates peuvent améliorer la rationalité individuelle et discipliner les acteurs, notamment par l’apprentissage. La seconde est que, pour Vernon L. Smith, la rationalité des marchés ne dérive pas uniquement de la rationalité des acteurs (Smith, 2003 : 481). Dès lors, chercher à tester, comme le fait l’économie comportementale, l’irrationalité supposée d’acteurs individuels ne serait pas pertinent puisque ces erreurs passagères n’ont pas nécessairement de conséquences inefficaces sur les résultats sociaux et économiques des interactions et qu’il est possible d’atteindre un résultat optimal, cela même avec des agents limités en termes d’information ou de rationalité. Comme l’affirmait Friedrich A. Hayek, et Vernon L. Smith reprend cette thèse à son compte, la rationalité des marchés ne provient pas uniquement de la rationalité des acteurs. D’où la thèse de Francesco Guala, selon qui l’économie expérimentale conduit à deux ensembles importants de résultats : la théorie néoclassique peut prévoir le résultat agrégé d’un processus de marché et, dans le même temps, la théorie néoclassique du choix individuel est falsifiée de manière répétée par les expériences (Guala, 2012). On comprend ainsi comment la notion de rationalité écologique proposée par Smith peut lui permettre de rendre cohérents ces deux énoncés et comment une telle position contribue au clivage persistant entre économie expérimentale et économie comportementale.

Conclusion

L’économie expérimentale a incontestablement marqué une évolution majeure de la théorie économique contemporaine. Elle a participé aux renouvellements profonds des méthodes empiriques, des instruments, des questionnements théoriques. Elle a réussi à construire une nouvelle classe de « faits économiques » et en a assuré la légitimité, scientifique, épistémologique et institutionnelle, auprès de l’ensemble de la communauté des économistes. Elle a placé ces faits à la même hauteur analytique que les théories qu’ils ne faisaient au départ que vérifier ou tester[51]. Elle a ensuite promu ces faits d’un type nouveau auprès des experts, des décideurs politiques ou encore des tribunaux, où leur performativité rhétorique est aujourd’hui largement reconnue.

Parallèlement, à mesure que l’économie expérimentale étendait ses domaines d’application, son succès témoignait d’un éclatement de plus en plus marqué de la discipline, comme le montrent les oppositions qui persistent autour de la notion de rationalité. Cet éclatement signe la fin – provisoire? – de la recherche d’explications autour de modèles abstraits et généraux, capables de couvrir des classes importantes de phénomènes, au profit d’explications plus locales ou plus circonstanciées. À l’image des faits retenus par la micro-storia, les faits expérimentaux apparaissent ainsi comme une collection de mécanismes et de relations de causalité qui ne visent plus à l’universalisme. On ne peut sans doute se risquer à faire des prédictions sur la fin des grands récits analytiques qui caractérisaient la discipline jusqu’aux années 1980. Pour autant, l’un des principaux défis pour l’économie expérimentale consiste à concilier la multitude d’effets qu’elle met en lumière avec une approche théorique capable de couvrir tous ces nouveaux faits empiriques sous des théories ayant un fort degré de généralité.

Appendices

Notes

-

[1]

« There is a property common to almost all the moral sciences, and by which they are distinguished from many of the physical; this is, that it is seldom in our power to make experiments in them. » (Mill, 1836, 1967 : 327)

-

[2]

Rappelons que la Société d’économétrie (Econometric Society) a été créée le 29 décembre 1930 à Cleveland, à la double initiative de Ragnar Frisch et d’Irving Fisher.

-

[3]

Tugwell (1924). Ces premières acceptions du terme d’« économie expérimentale » sont ainsi largement antérieures à celle de l’Allemand Heinz Sauermann à la fin des années 1960, que mentionne Alvin Roth dans son historique (Roth, 1995 : 19).

-

[4]

« The formulation of this problem is due to numerous conversations about psychophysics with my friend Professor Henry Schultz of the University of Chicago », note Louis Leon Thurstone dès les premières lignes de son article, « It was at his suggestion that experimental methods were applied to this problem in economic theory. According to Professor Schultz, it has probably never before been subjected to experimental study. » (Thurstone, 1931 : 139).

-

[5]

Cette première construction « expérimentale » d’une courbe d’indifférence sera critiquée par Mordecai Ezekiel lors de la présentation du papier au congrès de l’Econometric Society à Syracuse (New York), en juin 1932, puis par Nicholas Georgescu-Roegen. Quelques années plus tard, en 1942, W. Allen Wallis et Milton Friedman reviennent à la charge contre l’expérience de Thurstone, en lui reprochant deux aspects de son protocole : le caractère hypothétique des choix et l’absence de stimuli réels (Wallis et Friedman, 1942). Cette critique conduira 10 ans plus tard Frederick Mosteller à mettre en place à Harvard une expérience sur des choix réels en environnement risqué (Mosteller et Nogee, 1951; Moscati, 2007; Heukelom, 2014a : 13-17).

-

[6]

« It is a tool – a methodology – not a field of economics : most significantly, it changes the way you think about economics in all its application » (Smith, 1992a : 2).

-

[7]

Voir infra, note 11.

-

[8]

Il est certain que la naissance de la théorie des jeux a joué un rôle de catalyseur en faisant le lien entre les mathématiciens d’une part et les expérimentalistes d’autre part.

-

[9]

On le sait, Vernon Smith était l’un des étudiants qui avait participé, quelques années plus tard (en 1952) à ces classroom experiments. Il en relate le déroulement dans l’autobiographie qu’il rédige pour le site du prix de la Banque de Suède à la mémoire d’Alfred Nobel : « Many generations of Harvard graduate students had been exposed to E. H. Chamberlin’s beginning graduate course in Monopolistic Competition. On the first day he would set the stage for the semester using a classroom demonstration experiment showing that competitive price theory was an unrealistic idealization of the real world. He gave half the class buyer reservation values, and the other half seller reservation costs. The value/cost environment was like Bohm-Bawerk’s […] representation of supply and demand in a horse marketwith multiple buyers and sellers in two-sided competition–perhaps Chamberlin’s source of inspiration. […] Chamberlin, unlike Bohm-Bawerk’s description, had the buyers and sellers circulate, form pairs, and bargain over a bilateral trade; if successful the price was posted on the blackboard; if not successful, each would seek a new trading partner. This continued until the market was closed. The prices in sequence were volatile and failed to support the equilibrium prediction. Chamberlin used this first-day exercise to set the stage for his theory of monopolistic competition. » (Smith, 2002).

-

[10]