Abstracts

Résumé

Cet article introduit au dossier « synchroniser / synchronizing » qui propose aussi bien d’esquisser une archéologie des modes de (dé)synchronisation qu’interroger leur multiplicité actuelle à la croisée des arts des images et de ceux du son et de la musique.

Abstract

This article introduces the “synchroniser / synchronizing” issue of Intermédialités / Intermediality by tracing an archeology of various types of (de)synchronizations at the crossroads between the realms of images, sound and music.

Article body

However hard writers might try, there is one feat they cannot achieve, and that is to put into writing, in the same tense, two events that have occurred simultaneously[1].

Tout acte social met en jeu des modes précis de coordination : coordination des gestes du corps propres aux diverses techniques ; accord entre exécutants d’une action commune ; mais aussi nécessaire articulation des activités humaines à la temporalité du cosmos. Si ces formes caractéristiques de négociation d’un espace-temps partagé supposent l’apprentissage de rythmes complexes, quand peut-on dire qu’elles appellent une synchronisation ? Dans quels contextes spécifiques l’action de « synchroniser » a-t-elle été conceptualisée, et en quoi les sens actuels de ce concept en héritent-ils ? Quelles sont les modalités significatives de synchronisation, et avec quels effets, dans notre monde contemporain ? C’est ce que ce dossier propose d’explorer à partir de ces noeuds médiatiques que sont le corps, les écritures et les objets techniques. Il voudrait aussi bien esquisser une archéologie des modes de (dé)synchronisation qu’interroger leur multiplicité actuelle à la croisée des arts des images et de ceux du son et de la musique[2].

Sans doute, les sociétés d’oralité primaire ont-elles connu des techniques efficaces de « synchronisme » – comme dans le chant de groupe – qui se passaient de toute notation. De même, l’activité sociale a traditionnellement été structurée en fonction des cycles saisonniers qui se succèdent rythmés par des moments rituels. Ce sont les calendriers qui ont constitué la première formalisation écrite du temps – et ce, bien avant que les horloges autorisent une coordination plus poussée du travail et des échanges sociaux. Il est alors caractéristique que les festivités carnavalesques, temps du désoeuvrement et du débordement, aient lieu pendant la période intercalaire instituée dès l’Antiquité pour « recaler » calendrier officiel et année astronomique. Mais un tel ajustement n’est pas encore appelé une synchronisation. Car dans un sens performatif, le terme même de synchroniser suppose une conception très particulière, mesurable, d’un temps objectivé qui est le produit d’une histoire spécifiquement occidentale.

Orientation et mesure spatio-temporelle – L’adjectif synchronous, avec lequel débute l’étymologie en question, n’a pas été formé en anglais avant le 17e siècle. Employé en contexte narratif dans le sens ancien de coincident in time, c’est au sein du discours expérimental qu’il prend, selon l’Oxford British Dictionary, la signification de keeping time with, d’abord en référence aux phénomènes vibratoires dans la physique des sons instrumentaux. Par emprunt, synchrone apparaîtra directement comme terme de physique et de mécanique dans les ouvrages de référence français au milieu du 18e siècle, au moment où la question d’une mesure précise du temps est pour la première fois posée dans toute son acuité.

Ce sont d’abord les nécessités d’orientation spatiale et de cartographie qui ont présidé à l’affinement de la maîtrise des régularités temporelles. L’institution de l’observatoire de Greenwich (construit en 1675) et de son méridien en est devenue le symbole européen, puis mondial. Car pour connaître son point géographique, non seulement en latitude mais aussi en longitude, il faut pouvoir « synchroniser » l’observation de mêmes phénomènes en des lieux différents. Du fait du mouvement de rotation terrestre, il existe une asymétrie fondamentale entre le positionnement nord-sud donné par la hauteur relative du Soleil et celui sur l’axe est-ouest qui suppose deux points de repère. La distance longitudinale a dû, pour cette raison, être convertie en une différence de temps qu’il convenait de mesurer précisément.

Problème majeur de navigation jusque dans le dernier tiers du 18e siècle, la détermination de la longitude en mer a en effet appelé le premier grand chantier technico-scientifique de synchronisation de l’heure – supervisé par une institution spécifique, le Board of Longitude[3]. Il a vu la concurrence entre une méthode astronomique procédant par observation de la position relative de la Lune prise comme témoin de l’heure d’un lieu origine et une détermination « chronométrique » utilisant des automates à même de « garder le temps » du point de départ : les time-keepers. La première méthode demandait la mise au point d’instruments optiques capables de mesures précises en mer – du quadrant à réflexion au sextant – (Fig. 1a)[4] et supposait une validation définitive de la théorie newtonienne de la gravitation dans sa prédictibilité du mouvement lunaire. La démonstration a mobilisé les principaux concours et institutions académiques de l’époque entre 1715 et 1775, depuis la Royal Society of London, encore présidée par Newton, jusqu’aux observatoires européens, entre autres Greenwich à la tête duquel Nevil Maskelyne sera nommé astronome royal pour avoir eu la primeur de sa mise en oeuvre en 1763.

Fig. 1a

Hadley’s octant, Philosophical Transactions of the Royal Society of London, no 420, 1731, p. 157 (gauche).

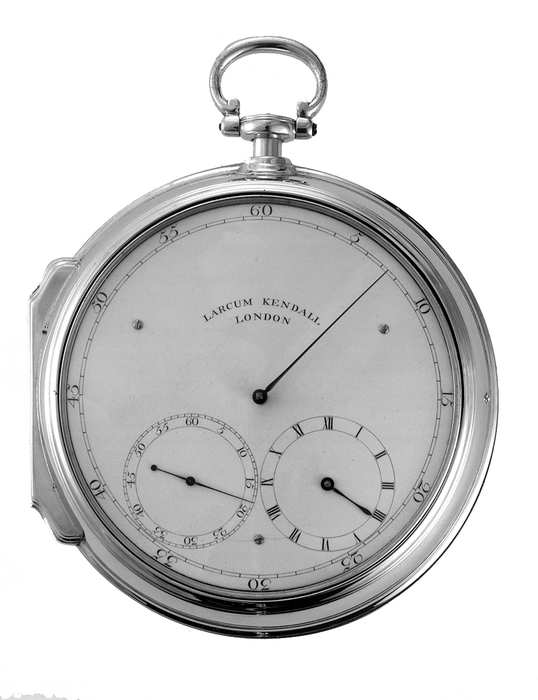

Par contraste, c’est dans un milieu d’artisans qu’ont été développées les premières horloges marines de précision : ces time-keepers de Harrison et Kendall en mesure de conserver l’heure du lieu d’origine pour, par différence avec le temps local, déterminer avec assez d’exactitude la longitude d’un lieu (Fig. 1b). Cette solution concurrente, purement technique, de mécanique horlogère consistait à stabiliser la précision des montres sur de longues périodes en les rendant peu sensibles aux conditions extérieures de mouvement, de température et d’humidité. Ces « garde-temps » seront à l’origine des chronomètres modernes. Et c’est à travers la diffusion et la généralisation des techniques astronomique et chronométrique de point en mer au 19e siècle que s’imposera finalement le lieu Greenwich comme méridien origine des cartes et son heure comme temps universel reconnu par l’ensemble des nations à partir de 1884. Ces méthodes seront utilisées jusqu’à l’introduction, au début du 20e siècle, de la télégraphie sans fil qui assurera une ubiquité de l’heure de référence – notre système de positionnement GPS n’étant que le dernier avatar électronique de ces procédés.

Fig. 1b

On voit combien les processus de synchronisation dépendent directement de la connaissance précise d’une temporalité considérée comme référentiel absolu. Tout au long du 19e siècle, ce sont les astronomes qui restent les détenteurs du temps sur lequel les horloges doivent se régler. Comme l’a montré Simon Schaffer dans une étude désormais classique, la précision croissante de la mesure renvoie, dans ce domaine comme ailleurs, autant à une histoire de techniques que de normes et de discipline institutionnelle[5]. Condition nécessaire de la maîtrise d’un temps cosmique validé, l’objectivation des mesures – problème de la dite « équation personnelle » des astronomes – a été résolue grâce à une mise en réseau des grands observatoires et, via un régime chronométrique de surveillance, par une mécanisation et une quantification de plus en plus poussées de l’observation.

Introduit dans le langage scientifique et technique seulement dans le dernier tiers du 19e siècle, « synchroniser » signifiera coupler ou asservir (au moins) deux processus pour les rendre simultanés. Encore fallait-il, pour définir la synchronie, être assuré d’une échelle de temps commun. La remise en question des conceptions mécaniques du temps et de l’espace absolus – qui trouvent leurs conséquences dans les catégories kantiennes a priori – appartenait à la physique électromagnétique. C’est en réfléchissant à la difficulté de définir la simultanéité temporelle en des points éloignés que le mathématicien Poincaré, travaillant pour le Bureau des Longitudes français, et le jeune physicien Einstein alors sans poste académique, en sont venus à remettre en cause le système newtonien. Tous deux ont considéré autour de 1904 que la simultanéité devait se définir par une procédure de convention visant à synchroniser des horloges éloignées par des signaux électromagnétiques. Einstein oeuvrait à cette époque au Bureau des brevets de Berne, au moment où l’on cherchait à synchroniser de manière électrique les horloges en Suisse[6]. C’est en transposant et en adaptant au contexte de l’électrodynamique des corps mobiles la synchronisation horlogère par échange de signaux électriques que le physicien a trouvé son modèle de principe pour la théorie de la relativité. Le temps devenait désormais procédural, c’est-à-dire relatif à des observateurs devant s’entendre au préalable sur leurs moyens de se synchroniser – avec une seule constante limite donnée par la vitesse de la lumière. Cette méthode a contribué, au tournant des 19e et 20e siècles, à détrôner les astronomes de leur rôle de seuls maîtres du temps et les a réduits à partager leur pouvoir avec les tenants de la physique ondulatoire. Elle a non seulement ouvert l’espace-temps à la relativité qui constitue encore notre cadre de pensée, mais provoqué un déplacement des références vers l’infiniment petit et les horloges atomiques.

Travail machiné et synchronisation image/son – Occupant une position inégalée à la jonction des savoirs et des formes de pouvoir, la synchronisation aura eu, dès cette époque, ses effets jusque dans l’asservissement des corps. Face à la machine moderne, le corps a dû apprendre à se synchroniser au sens propre. Alors que dans les techniques traditionnelles il obéissait à un rythme interne ou à celui du collectif, le mouvement corporel se trouve désormais dicté par une cadence automatisée, un temps externe non humain auquel il lui faut se soumettre. En ce sens, ce n’est pas un hasard si la nécessaire recomposition des gestes du travail en fonction des machines a appelé leur étude systématique par reproduction mécanisée. Dès leur origine, la chronophotographie et les techniques cinématographiques ont en effet accompagné et servi le procès de rationalisation industrielle. Aujourd’hui en partie voués à la disparition, les gestes à la machine continuent à être documentés et deviennent un enjeu esthétique sensible : c’est le cas de l’Encyclopaedia of Manual Operations d’Anette Rose dont nous présentons un aperçu en dossier visuel et qui explore – souvent en double screen – toute la complexité du procès de synchronisation entre mains, appareillage et champ visuel des personnes au travail[7].

Avant même qu’il ne devienne un art de masse, le cinéma des premiers temps a également recherché une reproduction conjointe de l’image et du son. L’histoire de leur synchronisation renvoie à un enjeu anthropologique de premier ordre dans le reformatage de la sensibilité et de la temporalité modernes. Elle semble singulièrement répéter au 20e siècle les inflexions qui furent, aux précédents, celles des techniques d’orientation spatio-temporelle : d’abord optique et mécanique, puis électrique et électronique. Rappelons que l’hétérogénéité d’ordre physique entre l’image, qui n’existe qu’en tant qu’artéfact de dimension spatiale, et le son, vibration constituée par une oscillation dans le temps, rend leur synchronisation – que notre cerveau effectue spontanément[8] – particulièrement complexe. De plus, en raison de la sensibilité plus importante de notre oreille aux variations de fréquences que de celle de notre oeil aux différences de vitesse du mouvement, c’est toujours l’audition qui détermine pour le récepteur la qualité d’une synchronisation. Il s’agit là d’un point que l’on peut particulièrement mettre en relief quand on compare la sonorisation au théâtre à la pratique généralisé du synchronisme au cinéma, comme le fait ici Daniel Deshays à partir de son expérience de créateur sonore.

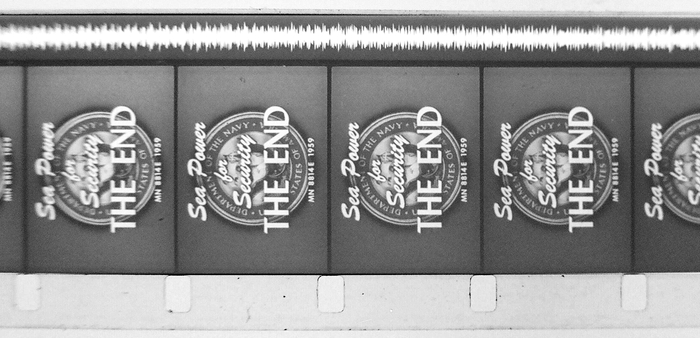

La reproduction optique du son instaure un premier seuil de synchronisation qui s’est imposé dans les studios de production au tournant des années 1920-1930[9]. Celle-ci opère par spatialisation du déroulement temporel sonore, en photographiant de manière continue, à même le support filmique, l’onde électrique visualisée du son capté en même temps que l’image (Fig. 2). D’où la lourdeur et une certaine fragilité du dispositif : réduit à l’état d’image, sensible à toute coupure ou détérioration, le son se reproduit et se transmet de manière limitée. Cette technique a néanmoins contribué à fixer les genres du « parlant » que nous connaissons jusqu’à aujourd’hui. Elle a métamorphosé le rôle de l’acteur qui a rarement pu en réfléchir la puissance – sauf chez de rares comiques comme Jerry Lewis dont Serge Cardinal montre, dans l’essai qu’il lui consacre, combien le jeu est une mise en abîme du dispositif de synchronisme sonore.

Fig. 2

Quant aux techniques de synchronisation légères qui ont émergé au tournant des années 1950-1960, à la suite du développement de l’enregistrement magnétique du son, elles ont procédé selon une voix hybride. Le son et l’image conservent ici leur propre médium et leur synchronicité est réalisée soit en asservissant par un câble les moteurs du magnétophone et de la caméra à la même commande électrique, soit en inscrivant par le biais d’un signal radio l’heure précise sur chacun des deux supports. Comme le rappelle Vincent Bouchard dans son étude qui souligne le rôle spécifique de l’Office national du film du Canada dans cette évolution, ce mode de synchronisation à partir du son reproduit magnétiquement a donné naissance au cinéma direct et révolutionné durablement des formes documentaires, notamment en extérieur, qui trouveront leur continuité en vidéo.

Tout à l’opposé du « son optique », un troisième mode de synchronisation a consisté à décomposer l’image en lignes discrètes à intensité lumineuse variable assimilable à un courant électrique – homogène à un phénomène temporel et, par là même, au son adjacent. Ce procédé, élaboré pour la télévision et réalisé dans son principe dès le tournant des années 1920-1930, se situe à l’origine de la technique vidéo. Avec la métamorphose électrique complète de l’image-son, sa transmission instantanée, par câble ou ondes hertziennes, devenait réalisable. Il s’agit dès lors d’une double synchronisation, du son et de l’image, mais aussi de l’événement capté et de sa reproduction audiovisuelle, qui ouvre la voie au régime d’information ubiquitaire et instantané qui s’est généralisé depuis les années 1950 avec la télévision (la diffusion de la vidéo et du magnétoscope à partir des années 1970 en a été le corollaire). Ce régime mondialisé reste encore foncièrement le nôtre, y compris à l’ère des techniques numériques et d’Internet.

Vu l’hétérogénéité fondamentale du son et de l’image, à laquelle répondait celle de leurs premiers procédés de reproduction, il n’y avait aucun déterminisme technologique à ce que synchroniser les deux s’impose rapidement. À partir du moment toutefois où cela apparaît comme un but nécessaire, il n’est pas étonnant que les techniques du son viennent dans ce procès dominer celles de l’image, et que le médium électrique qui les sous-tend, puis l’électronique se substitue de plus en plus à l’optique et à la mécanique[10]. En un sens, l’histoire de la sonorisation et de la synchronisation électrique de l’image est aussi celle de sa paradoxale évanescence optique. Et le passage de l’image cinématographique à la vidéo renverse finalement le rapport au son, avec toutes ses caractéristiques esthétiques ou d’évidence du réel : alors qu’en technique cinématographique, synchroniser reste une préoccupation nécessaire quoi qu’il en soit, l’image vidéo est produite d’emblée sonorisée et la seule option ouverte consiste à la désynchroniser. Peut-être n’est-ce qu’en déconstruisant le concept même d’audiovisuel, comme le propose Peter Szendy dans son essai sur le routage des sens au cinéma, qu’il redevient possible de saisir les modes de (dis)jonction singuliers par lesquels le regard et l’écoute peuvent frayer leur voie l’un vis-à-vis de l’autre.

Retour sur trois écritures – C’est bien la généralisation du cinéma « parlant » à partir des années 1930 qui a fait passer le verbe synchroniser – puis postsynchroniser – dans la langue courante. Voici même comment un observateur décrivait dès 1910 l’une des premières expérimentations dans le domaine : « The movements of the mouths of the characters on the scene synchronize with the utterance of the phonograph[11]. » Imperceptiblement, cette « scène primitive » de la reproduction conjointe de l’image et du son semble en rappeler une autre, beaucoup plus ancienne. Elle donne à penser qu’une « synchronisation » des dimensions spatiales et temporelles des techniques reproductives renvoie à un enjeu qui n’est rien moins que récent. L’asservissement du mouvement de la main traçant des signes graphiques sur l’espace du support à l’articulation d’une parole dans le temps caractérisait déjà en effet les écritures phonographiques depuis les syllabaires de l’ancien Orient. Interrogeant le processus anthropologique de « réflexion entre les deux miroirs du geste technique et du symbolisme phonique », André Leroi-Gourhan avait constaté « le synchronisme étroit [existant] entre l’évolution des techniques et celles du langage » : à travers l’extériorisation du discours dans une trace linéaire, l’écriture pourrait marquer un premier seuil de synchronisation prothétique[12].

Dans un ouvrage remarquable, Clarisse Herrenschmidt a plus précisément montré comment se sont articulés entre eux, sur la très longue durée, trois régimes d’écritures : langue, nombre et code, qui forment le socle de notre culture écrite jusqu’aux techniques numériques[13]. La notation des langues débuterait selon ses hypothèses au Moyen-Orient (vers -3300) par des marques de quantités désignant des choses sur des bulles-enveloppes en argile. C’est dans la comptabilisation des biens, par un assemblage entre dénombrement et nomination, que l’écriture de symboles linguistiques trouverait son origine. Avec le développement, en contexte d’échange multilingue, des syllabaires qui inscrivent un signe pour chaque syllabe, une coordination symétrisée de la parole dite et de la main écrivant est atteinte. Réduisant radicalement le nombre de signes nécessaires, les écritures consonantiques, puis alphabétiques, ont constitué de puissants moyens de rationalisation de ce procès de réciprocité médiale. L’écriture de langues transcrit spatialement, sur une ligne discrète, des différenciations sonores de la parole suffisantes pour qu’elle puisse être lue et réarticulée. En assurant, dans ses formes phonographiques, un synchronisme de l’oeil et de la main du scripteur avec le flux du discours, elle permet de « désynchroniser » l’échange entre locuteur et lecteur-auditeur. C’est dans ce double procès qu’elle peut devenir une forme de parole à distance – dans l’espace et dans le temps.

L’écriture de nombres verrait quant à elle ses débuts en Grèce avec la monnaie frappée (5e siècle av. J.-C.). Notation d’un type différent, elle exprime, tout d’abord par des figures géométriques, des rapports monétaires. Mais c’est bien plus tard, par le biais de l’emprunt des chiffres indo-arabes, que le système de numération positionnel ouvre à la notation des nombres comme entités proprement arithmétiques et non plus comme des unités linguistiques liées à une langue particulière. L’écriture arithmétique, qui en sera le produit et apparaît au 14e siècle avec la lettre de change, permet de transcrire (et éventuellement calculer) des rapports mesurables dans la société ou dans la nature. Introduite comme médiation technique pour puissamment « désynchroniser » l’échange monétaire, l’écriture numérale indique le rapport exact entre les monnaies de métal en jeu, garantissant la validité et la possible « resynchronisation » de transactions marchandes en des lieux éloignés. Mais elle sera aussi un vecteur fondamental de la mathématisation du monde par les savoirs expérimentaux fondés sur la reproductibilité à distance.

Cette écriture de nombres se trouve elle-même à l’origine d’un troisième type : les codes, qui ont d’abord servi à transcrire en chiffres des séquences linguistiques, puis à faire traiter celles-ci par des machines. C’est, on le sait, l’articulation du code binaire sur une différence électrique qui constitue la base même de l’informatique. Les technologies électroniques et numériques ne rendent pas seulement possible la transmission instantanée des messages ou des valeurs, mais également une véritable écriture à distance – ouvrant un nouveau chapitre de la synchronisation des opérations dans les sociétés humaines. L’écriture téléinformatique réticulaire réorganise en effet toutes les données numérisées en paquets adressés afin d’établir une communication potentiellement simultanée indépendamment d’un circuit de connexion particulier. Rappelons que ce type de transmission fonctionne dans un réseau comme Internet en rationalisant les potentiels de flux libre, soit en mettant à profit la désynchronisation de l’activité humaine due aux décalages jour/nuit entre les régions du monde.

Si l’on suit les développements d’Herrenschmidt, ce serait dans un double procès de « désynchronisation-resynchronisation » que chacun des régimes d’écriture viendrait finalement autoriser un nouveau type d’échange performatif à distance qui n’existait au préalable qu’en présence : échange de paroles, d’argent, de données binaires. Chacun d’eux a toujours accompagné l’échange d’une attestation, que ce soit le sceau du scripteur ou l’étalon monétaire, une garantie néanmoins sans équivalent tangible en écriture téléinformatique. Que nos ultimes garanties se situent désormais dans la puissance de calcul d’algorithmes tenus secrets apparaît comme la conséquence de la tendance à la synchronisation électronique totale de nos modes de communication et de transaction.

Incidences musicales – C’est aussi du rapprochement entre plusieurs régimes d’écriture – à savoir la langue, le codage alphabétique des hauteurs et la notation graphique (neumatique) des inflexions mélodiques[14] – que procède la notation musicale solfégique apparue, depuis Guido d’Arezzo, dans l’Europe médiévale. À partir du 12e siècle, le développement de la musique polyphonique, sa codification et sa complexification sont étroitement liés à l’établissement de ce système d’écriture qui en prescrit les consonances et en dispose les différentes voix dans un cadre temporel relativement homogène, défini par une métrique et une pulsation.

Toutefois, la problématique de la synchronisation en musique est loin de se restreindre à sa domestication par l’écriture – comme l’a notamment montré Alfred Schütz en critiquant les thèses de Maurice Halbwachs sur la notation comme infrastructure sociale de la mémoire des musiciens, pour mettre plutôt en relief les dimensions non conceptuelles et non sémantiques de la communication musicale. Schütz place, de ce point de vue, sur un plan d’égalité les manières de « faire de la musique ensemble » qui s’appuient sur l’écrit (comme la pratique du quatuor à cordes) et celles qui s’appuient sur d’autres prérequis et anticipations (comme l’improvisation de jazz[15]). Précisément lorsqu’il aborde cette généralisation, le vocabulaire que mobilise Schütz pour enrichir son concept de « syntonie[16] » (tuning-in) s’étend à la « synchronisation » (synchronization). Alors que la première notion désigne ce que partagent les flux de conscience du compositeur, des interprètes et des auditeurs dans le déroulement d’un processus musical, la seconde se focalise plus spécifiquement sur la manifestation physique, « dans le temps externe », de l’événement esthétique vécu par les participants « en face- à-face », « dans un présent vivant[17] ». Ces notions complémentaires, si elles peuvent être ainsi distinguées, se trouvent englobées dans l’usage courant du concept de synchronisation musicale. Par ce terme en effet, on peut désigner aussi bien les techniques et les méthodes au moyen desquelles plusieurs entités musiciennes parviennent à jouer de façon coordonnée, que l’expérience collective vécue par les personnes coprésentes dans un chronotope musical – où ces dernières, comme l’écrit encore Schütz, « vieillissent ensemble » dans le même flux[18].

Suivant Schütz, la compréhension des relations de syntonie musicale doit ouvrir la voie à une meilleure connaissance sociologique des formes de communication. Éclairer les ressorts de la synchronisation entre musiciens, ou entre « musiquants », apparaît alors comme une tâche difficile, mais fondamentale pour le musicologue aussi bien que pour le sociologue ou le psychologue. Il s’agit de pointer l’infrastructure interactionnelle, cognitive, technique et médiologique de la production collective d’un phénomène apparemment bien ordinaire : jouer ensemble. Cette capacité n’existe pas seulement dans le strict domaine musical, mais peut être mise en relation (plus ou moins organiquement) avec bien d’autres situations de synchronisation humaine, de l’interaction vocale entre parent et nourrisson à l’organisation d’une chaîne de production dans une entreprise, en passant par la prise de parole dans une conversation. Deux articles de ce dossier abordent la synchronisation musicale sous cet angle. Maya Gratier et Julien Magnier, d’un côté, s’appuient sur un large corpus d’études en psychologie du développement et en musicologie pour mettre en évidence le caractère structurant de la pulsation, de la mélodie et de la narration dans la genèse de formes complexes de communication allant des premiers mois de la vie à diverses pratiques musicales contemporaines dont le jazz. D’un autre côté, Rémy Campos met en évidence l’historicité des compétences collectives à « jouer ensemble » dans la musique occidentale moderne : bien qu’elle nous apparaisse aujourd’hui absolument normale, la synchronisation a longtemps été une exigence insatisfaite pour la pratique d’ensemble, donnant lieu à de nombreux témoignages, critiques, propositions de réforme au cours du 19e siècle.

C’est précisément parce qu’il relève en même temps d’une construction socioculturelle et d’une compétence ancrée dans le développement psychologique individuel que l’enjeu de la synchronisation a connu une profonde remise en question par les avant-gardes musicales de l’après-Seconde Guerre mondiale, au même titre que la tonalité ou que le thématisme. Comme l’écrit Witold Lutosławski dans une conférence de 1962 :

Nous savons tous que la direction du développement de l’art du jeu d’ensemble était basée, jusqu’à maintenant, sur un degré croissant de synchronisation, une précision de plus en plus grande lors de l’exécution simultanée des différentes parties. […] Aujourd’hui de grands ensembles composés de cent personnes jouent comme si un seul instrument ayant de multiples timbres était utilisé. On y trouve évidemment une forme particulière de beauté, qui peut même fasciner l’auditeur. Dans ce perfectionnement du jeu d’ensemble, il reste néanmoins peu de place pour l’expression artistique individuelle des interprètes, qui sont plutôt des éléments d’un mécanisme collectif fonctionnant de manière merveilleuse plutôt que des co-interprètes autonomes de la composition. Cette réalité s’est fait durement sentir dans les oeuvres récentes, qui fixaient des exigences particulièrement difficiles sur le plan de la rythmique et du jeu d’ensemble. […] Dans cette situation, l’avènement de l’aléatorisme fut véritablement libérateur, redonnant à l’interprète la possibilité d’exploiter ses atouts naturels, contrairement aux techniques préalables qui menaient vers […] l’automatisme[19].

La technique compositionnelle dite d’« aléatoire contrôlé », développée par Lutosławski, consiste précisément en une désynchronisation : le temps d’une section, voire d’un mouvement entier de l’oeuvre, chaque musicien joue sa partie, mais les barres de mesure, et donc les gestes du chef d’orchestre (s’il y en a un), sont supprimés (Fig. 3). L’objectif n’est pas – ou pas seulement – d’émanciper le musicien d’orchestre. L’écriture musicale, en renonçant à sa prérogative de coordination temporelle, fait surtout advenir des agencements singuliers de phrasé et de timbre, radicalement opposés à la « forme particulière de beauté » en quoi consiste le jeu homogène et discipliné des orchestres modernes : les partitions de Lutosławski ont ainsi capté quelque chose de la libre respiration d’un collectif, évoquant davantage, sur le plan de la sonorité orchestrale, les moments où les musiciens s’installent et s’accordent que ceux où ils se laissent conduire par le chef. Tant sur le plan sonore que politique, cette position de Lutosławski réfutait ainsi par avance la dialectique fellinienne, implacable et désenchantée, d’une Prova d’orchestra (Répétition d’orchestre, 1978) au cours de laquelle les musiciens ne pouvaient censément que se rebeller contre l’autorité du chef, générant l’anarchie la plus complète avant que cette dernière ne se résolve, tout aussi nécessairement, en un brutal retour à l’ordre (synchronique).

Fig. 3

Exemple de passage désynchronisé entre clarinette, célesta et harpe, Witold Lutosławski, Symphony no 3, chiffre 91 (page 91, détail), Londres : Chester Music, 1984.

Si nous avons cité spécifiquement le compositeur polonais, c’est d’abord parce qu’il représente dans la création musicale de l’après-guerre une médiation, un point d’équilibre entre l’âge du plus grand déterminisme (l’avant-garde sérielle des années 1950) et celui de la plus grande ouverture (sous-détermination du texte musical chez Cage, musique intuitive chez Stockhausen, rétrogradation ou suppression du chef chez Kagel, bascule dans l’improvisation avec Globokar et bien d’autres). Mais c’est aussi parce que ce texte a paru, dans une traduction inédite, au sein de la dernière livraison de Circuit : musiques contemporaines[20] : conçu en dialogue avec les coordinateurs du présent dossier, le sommaire du plus récent numéro de cette revue décline en effet la question des « Arts de la synchronisation » dans le champ spécifique de la musique contemporaine, avec des contributions sur la musique mixte (associant instruments classiques et sons/traitements électroacoustiques), le contrôle gestuel de processus sonores informatisés, et une critique néo-cagienne des formes autoritaires de communication et de synchronisation entre musiciens. Ces différents articles, auxquels nous renvoyons le lecteur, constituent autant d’indices notables de l’actualité de notre problématique pour l’invention aussi bien musicale que technologique.

Revenant à la question du jeu orchestral, il apparaît clairement que la synchronisation est devenue, au 20e siècle, un enjeu de composition à part entière : comment agencer des entités musicales (concrètes ou notationnelles) de façon à ce que leur ensemble dessine un même cadre temporel ? Chez Ives, en particulier, l’oeuvre a pu être comprise comme le lieu d’émergence d’une temporalité singulière à partir de la convergence, ou du conflit, entre des temporalités hétérogènes exprimées simultanément. Une synchronisation redoutablement périlleuse entre sous-ensembles de l’orchestre, ou orchestres concurrents, permet de produire pour l’auditeur le sentiment d’une absence de synchronisation. Un demi-siècle plus tard, chez le Stockhausen de Gruppen (1955-1957) par exemple, plusieurs chefs coordonnés les uns aux autres dirigent autant d’ensembles orchestraux dans des tempi distincts, l’asynchronie apparente étant subordonnée à une unité d’ordre supérieur, exprimée notamment dans des rapports de proportions. Du fait même que l’enjeu de la synchronisation – jadis limité à la pratique musicale d’ensemble – a été absorbé par les techniques compositionnelles, leur remise en cause passera aussi, désormais, par l’exploitation du potentiel de dérèglement propre à la désynchronisation, déjà symbolisée de façon radicale en 1962 par le Poème symphonique pour cent métronomes de Ligeti.

Enfin, à peine explorée la relation dialectique entre synchronisation et non-synchronisation, cette problématique réapparaîtra dès les années 1970 sous la forme d’un enjeu autant technologique et informatique que compositionnel, à travers le développement des musiques mixtes associant sons produits par des instruments de musique traditionnels et sons préenregistrés, ou générés dans le temps même de la performance – en tout cas diffusés par des haut-parleurs sur scène et/ou autour du public. Dans ce type de musique, les modalités de coexistence entre le monde instrumental et le monde électronique (notamment leur degré très variable d’interaction) sont, pour chaque oeuvre, réfléchies à la racine même du projet compositionnel. Avec les diverses tentatives d’inscrire les traitements audionumériques du son dans la temporalité de l’exécution par des humains, la question de la synchronisation est redevenue un problème à résoudre dans le domaine de l’informatique musicale. S’y est ajouté l’horizon d’une intégration technologique multimédia dans laquelle les différentes disciplines artistiques (danse, photographie, vidéo, etc.), désormais de plus en plus nativement numériques, se trouvent de fait dans des rapports de synchronie, potentielle ou effective.

* * *

Il semble alors d’autant plus urgent de relire l’histoire de l’art à partir des modes de synchronisation et de désynchronisation des arts entre eux et avec leur infrastructure technique, comme l’a fait par exemple Laurent Guido à propos de l’« âge du rythme » configuré par le cinématographe en ses premières décennies[21]. On décrypterait ainsi les questions esthétiques jadis soulevées par les démarches artistiques, scientifiques et techniques qui ont fait de la synchronisation leur objectif ou leur condition de réalisation – du cinéma expérimental à la comédie musicale –, aussi bien que leur repoussoir ou leur question – des Temps modernes de Chaplin à la reconfiguration radicale de la relation danse/musique par Cunningham et Cage.

Pour s’en tenir au cas de la musique, le présent numéro propose deux fragments d’une telle archéologie, aussi dissemblables que possible au premier abord bien que tous deux hautement représentatifs de ce que l’on pourrait appeler l’« âge de la synchronisation télévisuelle ». D’un côté, l’article de Sébastien Denis sur la série d’animation LesShadoks en tant que moment privilégié de la synchronisation, tant esthétique qu’institutionnelle, entre recherche musicale et recherche audiovisuelle autour de Pierre Schaeffer au tournant des années 1960 et 1970. De l’autre, l’extrait d’un documentaire inédit de 1975 dans lequel Glenn Gould explicite sa pratique – quasi compositionnelle – de la réalisation radiophonique : à l’imperceptible synchronisation des contrepoints vocaux de sa pièce The Idea of North (que le musicien situe, en passant, par rapport aux pseudo-cacophonies de Ives) répondait, au moment où avait lieu l’entretien dont nous proposons la transcription, une démarche de remédiation destinée à la télévision canadienne.

Si The Clock de Christian Marclay[22] est l’un des emblèmes artistiques de notre temps, et si notre actuel horizon technologique se définit par la synchronisation permanente et généralisée des objets techniques grâce au cloud computing, puisse le rire gouldien sur l’image duquel se referme la présente publication résonner encore longtemps dans les interstices rouverts sans cesse par le jeu intermédial.

Appendices

Notes biographiques

Philippe Despoix enseigne la littérature comparée à l’Université de Montréal où il dirige la revue Intermédialités. De double formation, scientifique et philosophique, il s’est en particulier intéressé à une archéologie de la synchronisation dans sa monographie Le monde mesuré. Dispositifs de l’exploration à l’âge des Lumières (2005). Ses recherches récentes, menées notamment au Centre canadien d’études allemandes et européennes, portent sur la fonction des médias dans les processus mémoriels et de transferts culturels. Il a entre autres codirigé le volume collectif Siegfried Kracauer, Penseur de l’Histoire (2006) et prépare un ouvrage sur le médium photographique dans une perspective intermédiale.

Nicolas Donin est musicologue, responsable de l’équipe de recherche « Analyse des pratiques musicales » à l’Ircam-Centre Pompidou (UMR CNRS 9912). Ses travaux portent principalement, d’une part sur l’histoire des pratiques d’écoute attentive et d’analyse musicale en France et en Allemagne depuis la fin du 19e siècle, d’autre part sur les pratiques musicales savantes contemporaines, en particulier la composition et l’interprétation. Il est l’auteur de nombreuses publications, papier et multimédia, sur ces sujets. Il a entre autres dirigé avec Philippe Despoix un double numéro de la Revue de Synthèse (2/3, 2008) sur les moyens techniques de l’art.

Notes

-

[1]

Jose Saramago, The Stone Raft, San Diego, Harcourt Brace & Co., 1995, p. 5.

-

[2]

Nous tenons à remercier tous ceux qui ont de près ou de loin contribué à l’élaboration de ce numéro, en particulier Serge Cardinal, Michel Chion, Mario Gauthier, Jonathan Goldman et l’équipe de Circuit, Clarisse Herrenschmidt, Simon Schaffer, ainsi que la CBC pour nous avoir autorisé à retranscrire l’entretien inédit avec Glenn Gould et le CCEAE pour son soutien à la réalisation du dossier artiste.

-

[3]

Voir entre autres Williams J. H. Andrewes (dir.), The Quest for Longitude, Cambridge (Mass.), Harvard University Press, 1996.

-

[4]

Dans cet ensemble d’appareils qui mène du quadrant réflecteur à l’octant puis au sextant d’Hadley, on a introduit un miroir qui fait coïncider l’image des astres dont la distance angulaire est à déterminer, synchronisant ainsi les deux visées nécessaires de sorte que le mouvement du navire ne trouble plus la mesure, voir Philippe Despoix, Le monde mesuré. Dispositifs de l’exploration à l’âge des Lumières, Genève, Droz, 2005, en particulier p. 50-52.

-

[5]

Voir en particulier Simon Schaffer, « Astronomers Mark Time : Discipline and the Personal Equation », Science in Context, vol. 2, n° 1, 1988, p.115-145.

-

[6]

Voir Peter Galison, Einstein’s Clocks, Poincaré’s Maps. Empires of Time, New York et Londres, W.W. Norton & Company, 2003, en particulier chap. 1 et 5.

-

[7]

Oeuvre en constante progression, introduite ici par Ines Lindner. Voir pour un premier état : Anette Rose, Enzyklopädie der Handhabungen 2006-2010, Bielefeld-Leipzig-Berlin, Kerber Art, 2010.

-

[8]

Phénomène pour lequel Michel Chion a formé le terme de « synchrèse ». Voir entre autres : Un art sonore, le cinéma, Paris, Cahiers du cinéma, coll. « Essais », 2003.

-

[9]

Voir Donald Crafton, The Talkies. American Cinema’s Transition to Sound, 1926-1931, Berkeley et Los Angeles, University of California Press, 1999 ; Martin Barnier, En route vers le parlant. Histoire d’une évolution technologique, économique et esthétique du cinéma (1926-1934), Liège, Éditions du Céfal, 2002.

-

[10]

Il est en effet frappant que les solutions techniques qui ont présidé à la « double synchronisation » soient issues d’industries spécialisées dans la diffusion électrique du son : la téléphonie, la phonographie, les dispositifs d’amplification et la radiophonie. Voir aussi à ce sujet la partie consacrée à l’image électrique dans Olivier Asselin, Silvestra Mariniello, Andrea Oberhuber (dir.), L’ère électrique – The Electric Age, Ottawa, Les Presses de l’Université d’Ottawa, 2011.

-

[11]

Chambers’s Journal, March 1910, 206/1.

-

[12]

André Leroi-Gourhan, Le geste et la parole, vol. 1, Paris, Albin Michel, 1964, p. 298, et les commentaires qu’en propose Bernard Stiegler dans La technique et le temps 1. La faute d’Épiméthée, Paris, Galilée, 1994, chap. 3, un auteur qui s’interroge aussi régulièrement sur les questions de synchronisation.

-

[13]

Clarisse Herrenschmidt, Les trois écritures. Langue, nombre, code, Paris, Gallimard, 2007 ; sur l’articulation entre écritures et supports techniques, voir également Harold Innis, Empire and Communications [1950], Toronto, University of Toronto Press, 2007 ; ainsi que l’essai de synthèse : Philippe Despoix, « Questions et hypothèses à partir des systèmes d’écritures : remédiation ou plurimédialité ? », Intermédialités, n° 6, automne 2005, p. 95-106.

-

[14]

Voir Marie-Noël Colette, « Guy d’Arezzo et notre notation musicale moderne. La transmission écrite du chant dans le haut Moyen Âge », Revue de synthèse, vol. 129, n° 3, 2008, p. 363-387, notamment p. 369-370, 374-375.

-

[15]

Alfred Schütz, Écrits sur la musique (1924-1956), Bastien Gallet et Laurent Perreau (éd.), Paris, MF, 2007, p. 137.

-

[16]

La participation au flux de l’expérience de l’autre dans le temps interne, cette existence continue d’un présent vécu en commun, constitue […] la relation de syntonie, l’expérience du “Nous”qui est au fondement de toute communication possible

ibid., p. 133 -

[17]

Ibid., p. 138.

-

[18]

Ibid., p. 134.

-

[19]

Witold Lutosławski, « Sur l’aléatorisme. Quelques notes en marge de l’oeuvre Jeux vénitiens », Circuit : musiques contemporaines, vol. 22, n° 1, p. 61-62.

-

[20]

Version électronique sous : www.erudit.org/revue/circuit/2012/v22/n1/index.html Cette revue publiée aux Presses de l’Université de Montréal explore, chaque année, trois thématiques intéressant la création musicale contemporaine canadienne et internationale. Initialement prévus pour une publication simultanée, les projets jumeaux de Circuit et d’Intermédialités auront finalement paru avec quelques mois d’écart, soit de façon légèrement asynchrone – involontaire rappel du propos qui nous réunit.

-

[21]

Laurent Guido, L’âge du rythme. Cinéma, musicalité et culture du corps dans les théories françaises des années 1910-1930, Lausanne, Payot, 2007.

-

[22]

Cette installation vidéo, distinguée par le Lion d’Or à la Biennale de Venise en 2011, présente un montage (d’une durée de 24 heures) de plusieurs milliers de séquences de films dénotant le passage du temps chronométrique. L’oeuvre doit être synchronisée avec l’heure locale du musée où elle est projetée, de sorte que l’heure figurée à chaque seconde dans l’extrait de film en cours correspond à l’heure qu’il est réellement pour le spectateur.

List of figures

Fig. 1a

Fig. 1b

Fig. 2

Fig. 3