Abstracts

Résumé

Les modalités de cours hybrides, qui combinent des activités synchrones (en classe ou virtuelles) et en ligne asynchrones, représentent un terrain potentiel d’augmentation du niveau d’engagement des étudiants dans leurs cours. L’étude de l’engagement des étudiants dans ces modalités nécessite toutefois l’élaboration d’une échelle de mesure, soit l’objectif de cet article. La nouvelle Échelle multidimensionnelle d’engagement des étudiants dans des modalités de cours hybrides (EMEECH) vient outiller chercheurs et formateurs pour mesurer l’engagement des étudiants dans ces modalités selon une perspective multidimensionnelle. Nous présentons son élaboration ainsi que des preuves de validité pour sa structure interne obtenues par analyses factorielles exploratoires et de cohérence interne sur la base de données diversifiées provenant de trois institutions universitaires. Un premier échantillon (n1 = 234) a permis d’identifier trois dimensions de l’engagement des étudiants : émotionnelle-cognitive, sociale et comportementale. Un second échantillon (n2 = 231) a appuyé la structure interne de la nouvelle échelle en confirmant sa structure factorielle et en présentant une très bonne cohérence interne.

Mots-clés :

- enseignement supérieur,

- cours hybrides,

- engagement des étudiants,

- élaboration d’une échelle de mesure,

- analyses factorielles

Abstract

Blended learning course environments combine synchronous activities (in face-to-face or virtual classrooms) with asynchronous online activities, and they represent a fertile ground for enhancing student engagement. However, studying student engagement in these environments requires the development of a measurement scale, which is the purpose of this paper. The new measurement scale Échelle multidimensionnelle d’engagement des étudiants dans des modalités de cours hybrides (EMEECH) provides researchers and instructors with tools for assessing student engagement in blended courses (blended, blended online or blended synchronous) from a multidimensional perspective. Its elaboration is presented, accompanied by evidence of validity for its internal structure obtained through exploratory factor and internal consistency analyses based on diversified data from three academic institutions. A first sample (n1=234) allowed identifying three dimensions to student engagement: emotional-cognitive, social and behavioral. A second sample (n2=231) provided further evidence of the internal structure of the new scale by confirming its factorial structure and its very good internal consistency.

Keywords:

- higher education,

- blended courses,

- student engagement,

- scale development,

- factor analysis

Resumo

As modalidades de cursos híbridos, que combinam atividades síncronas (em sala de aula ou virtuais) e assíncronas online, representam um campo potencial para aumentar o nível de envolvimento dos estudantes nos seus cursos. O estudo do envolvimento dos estudantes nestas modalidades requer, em todo o caso, o desenvolvimento de uma escala de medição, que é o objetivo deste artigo. A nova Escala Multidimensional para o Envolvimento dos estudantes em modalidades de cursos híbridos (EMEECH) fornece um instrumento para investigadores e formadores medirem o envolvimento dos estudantes nestas modalidades a partir de uma perspetiva multidimensional. Apresentamos a sua elaboração, bem como as provas de validade da sua estrutura interna obtidas por análises fatoriais exploratórias e coerência interna, tendo por base diversos dados de três instituições universitárias. Uma primeira amostra (n1 = 234) identificou três dimensões do envolvimento dos estudantes: emocional-cognitiva, social e comportamental. Uma segunda amostra (n2 = 231) apoiou a estrutura interna da nova escala, confirmando a sua estrutura fatorial e apresentando uma coerência interna muito boa.

Palavras chaves:

- ensino superior,

- cursos híbridos,

- envolvimento dos estudantes,

- elaboração de uma escala de medição,

- análises fatoriais

Article body

Introduction

Les modalités de cours hybrides et en ligne sont de plus en plus populaires en enseignement supérieur, particulièrement dans les institutions universitaires (Donovan, 2019). Cela résulte notamment de la démocratisation des études et de la diversification des apprenants qui s’ensuit, avec de nombreux étudiants aux responsabilités scolaires, personnelles et professionnelles pour lesquels des cours en classe conviennent peu (Boelens et al., 2018 ; Conseil supérieur de l’éducation, 2015, 2020). Facilitées par les avancées du numérique, les nouvelles modalités de cours permettent aux étudiants de réaliser en ligne une proportion variable des activités d’enseignement et d’apprentissage. Cela leur accorde une plus grande flexibilité en temps, en espace ou même en rythme d’apprentissage, et répond ainsi aux besoins ou préférences d’une population étudiante diversifiée (Boelens et al., 2017, 2018).

Dans cette étude, nous nous sommes intéressées plus particulièrement aux modalités hybrides, que nous définissons comme une combinaison d’activités d’enseignement et d’apprentissage en classe ou en ligne synchrones (classe virtuelle) et d’activités en ligne asynchrones (Heilporn et al., 2021a ; Lakhal et al., 2020). Offrant une plus grande flexibilité que dans des cours en classe, ces modalités préservent des interactions en temps réel entre les étudiants et avec l’enseignant, ce qui minimise les désavantages généralement associés à des cours en ligne asynchrones tels que le manque de soutien, un sentiment d’isolement ou la faiblesse des interactions (Berry, 2019 ; Dumford et Miller, 2018 ; Watts, 2016). Ainsi, la combinaison d’activités synchrones et asynchrones tout comme les opportunités offertes par le numérique permettent d’enrichir les activités au-delà d’un cours en classe ou en ligne asynchrone (Garrison et Vaughan, 2008 ; Taylor et al., 2018), dans une approche pédagogique centrée sur l’apprentissage des étudiants. De ce fait, de nombreux auteurs identifient les cours hybrides comme un terrain ayant le potentiel d’augmenter l’engagement des étudiants (Drysdale et al., 2013 ; Halverson et al., 2014 ; Manwaring et al., 2017 ; Spring et al., 2016).

L’engagement des étudiants ayant de nombreuses retombées, entre autres sur la persévérance, sur l’apprentissage en profondeur, sur la satisfaction et sur la réussite scolaire (Christenson et al., 2012 ; Halverson et Graham, 2019 ; Kahu, 2013 ; Mandernach, 2015 ; Manwaring et al., 2017), il améliore de manière générale les expériences éducatives des étudiants (Halverson et Graham, 2019). Dans une perspective multidimensionnelle, l’engagement des étudiants dans un cours se manifeste sous différentes facettes ou dimensions, telles que leurs réactions affectives, leur participation, leurs efforts ou leur utilisation de stratégies d’apprentissage et métacognitives. Mesurer l’engagement des étudiants selon cette perspective apporte des informations détaillées aux chercheurs et formateurs puisque chaque dimension fournit une cible exploitable (Fredricks et al., 2019). De plus, les chercheurs pourront mettre en relation ces dimensions, par exemple avec des caractéristiques individuelles des étudiants ou des indicateurs de réussite scolaire.

Cependant, dans les écrits scientifiques francophones, à notre connaissance, il n’existe pas de tel outil de mesure à l’ordre universitaire pour des modalités hybrides. Par conséquent, l’objectif de cette étude vise à élaborer une échelle, soit l’Échelle multidimensionnelle d’engagement des étudiants dans des modalités de cours hybrides (EMEECH) et à apporter des preuves de sa validité dans ce contexte.

Définitions et recension des écrits

Modalités de cours hybrides

Derrière la mention de cours hybride se cachent des significations multiples (Hrastinski, 2019). Généralement situé sur un continuum entre un cours en classe et en ligne (Lakhal et Meyer, 2019), un cours hybride est souvent défini comme une combinaison d’activités d’enseignement et d’apprentissage en classe et en ligne (Bonk et Graham, 2012). Certains auteurs explicitent aussi la nécessité d’une réduction du temps en classe au profit d’activités en ligne (Conseil supérieur de l’éducation, 2015 ; Graham, 2013). Toutefois, une définition plus large inclut, dans les modalités hybrides, des cours composés d’activités d’enseignement et d’apprentissage en ligne synchrones et asynchrones, en proportions variables (Heilporn et al., 2021a ; Lakhal et al., 2017, 2020 ; Fadde et Vu, 2014 ; Power, 2008 ; Raes et al., 2019). En effet, les avancées du numérique et l’étendue des nouvelles modalités de cours remettent de plus en plus en question la nécessité de rencontres en classe au profit de rencontres synchrones en ligne. Ces modalités sont généralement classifiées comme :

des cours hybrides (combinaison d’activités en classe et en ligne) ;

des cours hybrides en ligne (combinaison d’activités en ligne synchrones et asynchrones) ; et

des cours hybrides-mixtes ou comodaux (les activités en classe sont simultanément en ligne et synchrones dans un même cours, combinant ainsi des étudiants dans différentes modalités).

C’est donc dans une optique de pérennité et d’applicabilité de l’échelle à un grand nombre de cours que nous avons choisi cette définition plus large.

Engagement des étudiants dans un cours

Souvent considéré comme un processus psychosocial multidimensionnel, l’engagement des étudiants est ancré dans l’action (Christenson et al., 2012 ; Kahu, 2013 ; Lawson et Lawson, 2013). De nombreux auteurs (Christenson et al., 2012 ; Fredricks et al., 2019 ; Kahu, 2013 ; Lawson et Lawson, 2013 ; Manwaring et al., 2017) se réfèrent à la typologie proposée dans la revue de littérature de Fredricks et al. (2004), qui propose une perspective tridimensionnelle : comportementale, émotionnelle et cognitive.

D’abord, la dimension comportementale d’engagement des étudiants réfère à leur participation à des activités ainsi qu’au suivi des règles ou des normes. Dans un cours, cette dimension est donc associée aux efforts[1], à la persévérance, à la concentration ou à l’attention des étudiants ainsi qu’au fait qu’ils posent des questions et participent aux discussions.

Ensuite, la dimension émotionnelle d’engagement des étudiants concerne leurs réactions affectives face aux activités, à leurs pairs ou à l’enseignant (p. ex., leur intérêt, plaisir, joie, ennui ou anxiété), ainsi que leur sentiment d’appartenance dans le cours.

Enfin, la dimension cognitive d’engagement des étudiants concerne leur investissement psychologique et leur volonté de déployer les efforts nécessaires pour maîtriser des idées ou contenus complexes. Cette dimension réfère aussi à l’utilisation de stratégies d’apprentissage, métacognitives ou d’autorégulation.

Cette perspective multidimensionnelle d’engagement des étudiants, la plus citée dans les écrits scientifiques, propose une caractérisation riche et pertinente de leur état psychologique et comportemental (Fredricks et al., 2004 ; Kahu, 2013).

Dans l’élaboration de cette nouvelle échelle sur l’engagement des étudiants dans des modalités de cours hybrides, nous avons visé à bien distinguer l’engagement de ses antécédents ou conséquences. Notamment, l’engagement est à distinguer de la motivation, qui peut être considérée comme un antécédent, une condition influente, mais toutefois insuffisante à l’engagement des étudiants (Appleton et al., 2006). En effet, la motivation représente une intention, tandis que l’engagement est ancré dans l’action (Christenson et al., 2012 ; Lawson et Lawson, 2013).

Dans les écrits scientifiques, l’engagement des étudiants est aussi souvent confondu avec des antécédents comme des conditions pédagogiques facilitantes (voir p. ex. Martin et Bolliger, 2018) ou des conséquences comme la réussite scolaire des étudiants (voir p. ex. Handelsman et al., 2005), ce qui porte à confusion (Halverson et Graham, 2019). Dans l’échelle proposée (EMEECH), la mesure de l’engagement est basée sur les indicateurs du construit proprement dit et est distincte de ses antécédents ou conséquences.

Synthèse des échelles existantes à l’ordre universitaire

La plupart des échelles d’engagement des étudiants ont été conçues en contexte anglophone et recensées dans des études récentes (Henrie et al., 2015 ; Mandernach, 2015). Un portrait des échelles existantes en contexte anglophone ou francophone est présenté dans les sous-sections suivantes.

Échelles d’engagement des étudiants en contexte anglophone

Dans les écrits scientifiques anglophones, l’échelle la plus connue en Amérique du Nord est le National Survey of Student Engagement (NSSE), qui évalue des aspects très diversifiés de l’expérience universitaire des étudiants dans leur institution (Mayer, 2019), bien au-delà de leur engagement. Le but premier de cette échelle est d’évaluer la qualité de l’enseignement dans des institutions, même si cette échelle est aussi utilisée dans des publications de recherche (voir p. ex. Vaughan, 2014). Notons qu’il existe aussi des équivalents du NSSE dans d’autres continents, notamment l’Australasian Survey of Student Engagement (AUSSE ; Coates, 2007 ; Krause et Coates, 2008). De façon générale, ces échelles visent l’évaluation de la qualité des expériences éducatives vécues par les étudiants dans leur institution plus que leur engagement, et elles ne distinguent pas non plus différentes dimensions de l’engagement.

Dans une perspective multidimensionnelle, l’échelle University Student Engagement Inventory (USEI ; Maroco et al., 2016) mesure l’engagement des étudiants dans une institution selon des dimensions comportementale, émotionnelle et cognitive. Des analyses factorielles exploratoires (n = 313) ont mis en évidence ces trois dimensions, et de bons indices de cohérence interne ont été rapportés (α de Cronbach respectivement de 0,74 ; 0,88 et 0,82 pour cinq items par dimension). Des analyses factorielles confirmatoires ont aussi produit de bons indices d’ajustement (χ2/df = 2,26 ; CFI = 0,97 ; TLI = 0,97 ; RMSEA = 0,06). Toutefois, l’engagement des étudiants est ici mesuré dans l’institution et pour des cours en classe[2], et l’échelle n’a pas non plus été adaptée en français.

Dans le cadre d’un cours, il existe une variante du NSSE appelée Classroom Survey of Student Engagement (CLASSE ; Ouimet et Smallwood, 2005). Celle-ci est proposée en deux versions, pour les formateurs et les étudiants, afin d’évaluer leurs perceptions respectives de la qualité de l’enseignement dans un cours en classe (Mandernach, 2015). L’échelle ne comporte donc aucun item spécifique à des activités en ligne ni ne distingue les différentes dimensions de l’engagement. Ses propriétés psychométriques n’ont pas non plus été étudiées et elle n’a pas été adaptée en français.

Plusieurs autres échelles de mesure de l’engagement des étudiants dans un cours, dont le Student Course Engagement Questionnaire (SCEQ ; Handelsman et al., 2005) et sa variante pour un cours en ligne Online Student Engagement Scale (OSE ; Dixson, 2010), sont mentionnées dans les écrits scientifiques. Une cohérence interne globale de 0,91 (19 items ; n = 186) a été rapportée pour l’OSE (Dixson, 2010). Toutefois, l’OSE n’a pas été élaborée selon la perspective multidimensionnelle de Fredricks et al. (2004) et ses items n’en couvrent pas complètement les trois dimensions, en particulier la dimension cognitive, non abordée. L’échelle n’a pas non plus été adaptée en français.

D’autres questionnaires de mesure de l’engagement des étudiants dans un cours ont aussi été présentés de façon plus isolée dans les écrits scientifiques, dont celui d’Alvarez-Bell et al. (2017), qui s’inspire d’items provenant du NSSE et d’une autre échelle d’engagement des étudiants dans leur institution de Schreiner et Louis (2011). Toutefois, les échelles existantes applicables dans le cadre d’un cours, non adaptées en français, ne couvrent pas les trois dimensions définies par Fredricks et al. (2004), alors que plusieurs auteurs soulignent l’importance de considérer l’engagement des étudiants selon une perspective multidimensionnelle (Brault-Labbé et Dubé, 2010 ; Krause et Coates, 2008 ; Maroco et al., 2016).

Échelles d’engagement des étudiants en contexte francophone

En contexte francophone, il existe peu d’échelles d’engagement des étudiants. Une version canadienne en français de l’échelle d’engagement du NSSE, renommée Enquête nationale de participation étudiante puisqu’elle dépasse largement l’engagement des étudiants (Mayer, 2019), vise l’évaluation de l’enseignement dans une institution et ne distingue pas les différentes dimensions de l’engagement.

Prenant en compte une perspective multidimensionnelle, Brault-Labbé et Dubé (2010) ont proposé une échelle de mesure de l’engagement des étudiants dans leurs études en enseignement supérieur. Celle-ci comporte des dimensions relatives à l’enthousiasme des étudiants envers les études, à leur persévérance dans les tâches scolaires et à leur réconciliation du positif et du négatif dans leurs études, dimensions qui ont été confirmées par des analyses factorielles exploratoires (extraction par axes principaux avec rotation oblimin, n = 266), avec de bons indices de cohérence interne (α de Cronbach respectivement de 0,88, 0,80 et 0,68 pour 6, 3 et 4 items ; Brault-Labbé et Dubé, 2010). Toutefois, les items de cette échelle sont relatifs aux études des étudiants de façon générale et correspondent à un niveau beaucoup plus large que celui d’un cours. Les dimensions de persévérance et de réconciliation du positif et du négatif définies par Brault-Labbé et Dubé (2010) ne couvrent donc pas complètement les différentes dimensions de l’engagement des étudiants dans un cours selon la définition de Fredricks et al. (2004). De plus, aucun item n’est spécifique à une modalité de cours hybrides.

Enfin, Parent (2017) a récemment utilisé dans sa thèse de doctorat sa propre échelle d’engagement des étudiants, déclinée en des dimensions comportementale, émotionnelle et cognitive, et élaborée pour des cours en classe incluant le numérique. Inspirée d’échelles d’engagement connues comme celle du NSSE, mais aussi d’autres échelles ne relevant pas de l’engagement des étudiants, elle comporte certains items qui ne correspondent pas à la définition d’engagement de Fredricks et al. (2004). De plus, le processus d’élaboration de cette échelle n’a pas été rapporté, ni ses propriétés psychométriques.

Par conséquent, aucune échelle existante ne répondait à nos besoins d’un instrument i) en contexte francophone, ii) applicable à des modalités de cours hybrides et iii) mettant en évidence le caractère multidimensionnel de l’engagement des étudiants. Pour ces raisons, nous avons procédé à l’élaboration d’un nouveau questionnaire d’engagement des étudiants inspiré des différentes échelles existantes rapportées dans les écrits scientifiques.

Méthodologie

L’Échelle multidimensionnelle d’engagement des étudiants dans des modalités de cours hybrides (EMEECH) a été élaborée selon les étapes proposées par DeVellis (2016). Tout au long du processus, des éléments de preuve ont été accumulés dans une perspective intégratrice et unifiée de validité de l’interprétation des résultats d’une échelle pour un usage proposé, comme suggéré par Messick (1995) et reprise dans les plus récents Standards for Educational and Psychological Testing de l’American Educational Research Association (AERA, 2014). Des éléments de preuve de contenu (revue de la littérature, détermination de l’objet de mesure, génération des items et révision du bassin par des experts) et de processus de réponse (choix d’un questionnaire autoadministré, sélection du format de mesure) ont été collectés au cours du processus d’élaboration de l’échelle relaté dans la suite du texte, tandis que des éléments de preuve de la structure interne de l’échelle sont apportés à l’étape d’évaluation des items. Enfin, des éléments de preuve de conséquence de l’utilisation de l’échelle pour l’usage proposé sont abordés dans la discussion de cet article.

Construction de l’échelle

Détermination de l’objet de mesure

Selon DeVellis (2016), il est important de commencer le processus d’élaboration d’un outil de mesure par une délimitation claire et précise des frontières du phénomène d’intérêt, soit ici l’engagement des étudiants dans des modalités de cours hybrides universitaires. Nous avons cherché à mettre en évidence la perspective multidimensionnelle d’engagement telle qu’elle est présentée par Fredricks et al. (2004, 2016, 2019), qui inclut des dimensions comportementale, émotionnelle et cognitive présentées plus haut.

Par ailleurs, le contexte, la population et, le cas échéant, la discipline peuvent aider à déterminer le niveau de spécificité désiré, de telles bornes d’évaluation permettant de mieux cerner le phénomène d’intérêt et ainsi de guider la génération subséquente des items de l’échelle (DeVellis, 2016). En l’occurrence, cette étude a ciblé des étudiants ayant suivi un cours universitaire dans une modalité hybride, en contexte francophone et dans n’importe quelle discipline. Le fait qu’il s’agisse de modalité hybride implique que les items mesurent l’engagement des étudiants dans des activités d’enseignement et d’apprentissage tant en mode en ligne asynchrone que synchrone (en classe ou virtuelles). De plus, les items doivent rester suffisamment généraux pour qu’ils prennent sens dans n’importe quelle discipline universitaire, ce qui incite donc à la prudence quant à leur niveau de spécificité.

Génération d’un bassin initial d’items

Un bassin initial de 69 items a été élaboré par la première auteure de notre étude en s’inspirant des principales échelles d’engagement des étudiants des écrits scientifiques, et au regard d’exemples d’indicateurs des dimensions de l’engagement indiqués par Henrie et al. (2015) ainsi que Halverson et Graham (2019). Ainsi, des items des échelles d’engagement existantes en contexte anglophone ont été traduits en français, puis adaptés aux modalités de cours hybrides, le cas échéant. D’autres items ont été repris ou adaptés des échelles francophones (p. ex., Parent, 2017) pour refléter les indicateurs des dimensions de l’engagement qui n’auraient pas été couverts. Une attention particulière a été portée aux spécificités relatives aux modalités de cours hybrides (tenant compte d’activités en ligne) ainsi que dans la distinction entre les dimensions comportementale, émotionnelle et cognitive de l’engagement des étudiants.

Les items ont été formulés suivant les recommandations des écrits scientifiques à ce propos, qui concernent entre autres leur neutralité, leur structure grammaticale, leur niveau de langage et de vocabulaire, ainsi que la formulation d’items similaires pour chaque indicateur (Clark et Watson, 1995 ; DeVellis, 2016). Les questions négatives ont aussi été évitées, en accord avec une argumentation de DeVellis (2016), qui estime que les inconvénients de telles questions supplantent leurs avantages potentiels.

Le bassin initial d’items comportait respectivement 21, 20 et 28 items pour les dimensions comportementale, émotionnelle et cognitive de l’engagement des étudiants.

Sélection d’un format de mesure

Les choix de réponses ont été présentés sous la forme d’une échelle de Likert, un format fréquemment utilisé pour mesurer le degré d’accord de participants avec des opinions ou attitudes (DeVellis, 2016). En réponse à des items énoncés sous une forme déclarative, les niveaux de l’échelle font état de degrés d’accord variables avec les affirmations proposées. Toutefois, un manque de discrimination et une surcharge cognitive des participants peuvent être observés au-delà de sept niveaux (Streiner et al., 2015). Un nombre de niveaux inférieur à cinq mène par contre à un risque de perte d’information et, par conséquent, à une diminution de la fidélité de l’échelle (Streiner et al., 2015). De plus, un nombre impair de niveaux a le désavantage de permettre aux participants de choisir une réponse centrale comme non-choix (parce qu’ils ne savent ou ne veulent pas s’exprimer sur la question, par fatigue ou par paresse), et non comme totalement neutre, alors qu’un nombre pair de niveaux force les participants à s’affirmer positivement ou négativement sur chaque question (Sturgis et al., 2014). Puisque nous estimons que la position des étudiants au regard des items formulés ne serait jamais totalement neutre, nous avons retenu une échelle à six niveaux présentant une grande variabilité de choix, sous la forme : 1) tout à fait en désaccord, 2) en désaccord, 3) plutôt en désaccord, 4) plutôt d’accord, 5) d’accord et 6) tout à fait d’accord.

Révision du bassin initial d’items par des experts

À cette étape, le bassin initial d’items a été examiné par sept professeurs universitaires, chercheurs en mesure et évaluation, sur l’engagement des étudiants ou sur les modalités hybrides. À cette fin, les définitions retenues de modalités hybrides et d’engagement des étudiants leur ont été présentées. Les experts ont ensuite été invités, pour chaque item, à en évaluer la clarté et la pertinence sur une échelle de 1 (faible) à 3 (élevée) ainsi qu’à nous soumettre des commentaires et suggestions d’amélioration. Cette étape du processus a permis de clarifier les items ainsi que d’éviter une surreprésentation ou une sous-représentation de construit (AERA, 2014). Suivant cette consultation, 13 items ont été reformulés, car ils ne présentaient pas un niveau de clarté élevé selon les experts. Une discussion entre les coauteures de cette étude a ensuite mené à la suppression de 30 items qui ne présentaient pas un niveau de pertinence suffisamment élevé[3] (AERA, 2014). Aucun item additionnel n’a été suggéré.

Enfin, une double vérification des items par rapport aux exemples d’indicateurs suggérés dans les écrits scientifiques (Halverson et Graham, 2019 ; Henrie et al., 2015) a été réalisée. Le bassin d’items préliminaire à la collecte de données comportait respectivement 13, 10 et 16 items pour les dimensions comportementale, émotionnelle et cognitive de l’engagement des étudiants. Remarquons qu’afin d’éviter tout biais dans les résultats, l’ensemble des 39 items a été présenté dans un ordre aléatoire à chaque participant lors de la passation du questionnaire, sans référence à aucune dimension de l’engagement.

Considération de l’inclusion d’items de validation

Puisque nous ne considérons pas l’échelle d’engagement des étudiants élaborée comme un sujet délicat, nous avons décidé de ne pas inclure d’échelle ou d’items relatifs à un biais de désirabilité sociale des participants, et ce, à des fins de concision.

Administration auprès d’un échantillon

Participants et recrutement

Afin d’assurer une représentativité de la population ciblée, soit ici des étudiants ayant suivi un cours universitaire dans une modalité hybride en contexte francophone, nous avons visé des étudiants ayant suivi un tel cours à la session d’automne 2019 dans trois universités (provinces canadiennes du Québec et de l’Ontario) proposant de nombreux cours hybrides. Après l’approbation du projet par les différents comités d’éthique à la recherche, ces étudiants ont été invités à participer au projet par le biais de listes génériques de courriels au cours du mois de janvier 2020. Il s’agit donc d’un échantillon de convenance, car seuls les étudiants volontaires ont répondu au questionnaire en ligne (durée annoncée de 10 minutes) proposé sur la plateforme SurveyMonkey (questionnaire clôturé le 31 janvier 2020). De plus, étant donné la définition assez large de cours hybrides adoptée dans ce projet et afin d’assurer une élaboration adéquate de l’échelle, les proportions de participants dans les différentes modalités de cours (hybrides, hybrides en ligne, hybrides-mixtes) ont été collectées afin d’assurer la diversité de l’échantillon par rapport à celles-ci.

Par ailleurs, DeVellis (2016) suggère qu’une échelle en élaboration devrait être soumise à au moins 300 participants, bien qu’il mentionne que des échelles ont souvent été élaborées, en pratique, avec des échantillons plus petits. Les risques relatifs à un trop petit échantillon sont liés à la variance résiduelle entre participants ainsi qu’aux covariances entre items qui, lorsque plus instables, pourraient mener à des erreurs d’interprétation et, par conséquent, d’élaboration de l’échelle. Toutefois, la taille minimale d’un échantillon dépend de la robustesse des mesures obtenues, par exemple des communautés (communalities), à l’issue d’analyses factorielles (Maccallum et al., 1999). En conséquence, plusieurs auteurs (Costello et Osborne, 2005 ; DeVellis, 2016 ; Yong et Pearce, 2013) recommandent de cibler un rapport participants-item suffisamment élevé, soit de 5 à 10 participants par item. Puisque notre bassin préliminaire comportait 39 items au total, nous avons visé un échantillon d’au moins 195 participants afin d’obtenir un rapport minimal de 5:1.

Après nettoyage de l’échantillon collecté et suppression des données relatives à 22 participants suggérant des risques de valeurs aberrantes univariées ou multivariées selon l’analyse des distances de Mahalanobis et de Cook (Tabachnick et Fidell, 2007), la taille de l’échantillon s’est élevée à 465 participants. Ceux-ci proviennent de cours et de programmes variés, à tous les cycles universitaires et dans les différentes modalités de cours hybrides. Quelques statistiques descriptives relatives aux caractéristiques sociodémographiques des participants sont présentées au Tableau 1 et démontrent la diversité de l’échantillon collecté.

Tableau 1

Caractéristiques sociodémographiques des participants (n=465)

Évaluation des items

Étant donné le rapport de plus de 10 participants par item obtenu, les données ont été divisées aléatoirement en deux échantillons de taille similaire (n1 = 234 et n2 = 231). Des tests d’indépendance du khi carré (α = 5 %) ont montré qu’il n’y avait pas de différence significative entre les deux échantillons pour les caractéristiques Genre (p = 0,72), Âge (p = 0,76), Cycle (p = 0,09) et Modalité (p = 0,96).

Le premier échantillon (É1) a été utilisé pour mener des tests exploratoires sur les items visant à construire une échelle d’engagement des étudiants dans des modalités de cours hybrides. Ainsi, un examen initial de la performance des items (difficulté, discrimination, asymétrie, corrélations item-échelle et corrélations item-item) a d’abord été réalisé, suivi par des analyses factorielles exploratoires (AFE). En effet, dans le cas de l’élaboration d’une nouvelle échelle, des AFE sont recommandées pour explorer sa structure interne (Worthington et Whittaker, 2006). Celles-ci sont particulièrement pertinentes dans notre étude du fait que la multidimensionnalité de l’engagement des étudiants a été peu étudiée en enseignement supérieur, ni aucunement, à notre connaissance, dans des modalités de cours hybrides. Les items montrant de faibles communautés (<0,32), qui ne saturaient significativement sur aucun facteur (<0,32) ou qui saturaient significativement sur plusieurs facteurs (>0,32) ont été supprimés (Tabachnick et Fidell, 2007 ; Worthington et Whittaker, 2006). Après obtention d’une structure simple, les items qui présentaient une faible saturation (<0,40) sur leur facteur ont aussi été supprimés (Pituch et Stevens, 2016). Soulignons que l’ensemble du processus de nettoyage des items a été réalisé en apportant une grande importance au sens conceptuel des items et des facteurs latents sous-jacents. Des analyses de cohérence interne (ACI) ont alors été réalisées sur chacun des facteurs identifiés.

Par la suite, l’échelle finale a été testée sur le second échantillon (É2) par AFE et ACI afin de recueillir des preuves de validité supplémentaires pour appuyer sa structure interne. Les analyses ont été effectuées avec le logiciel SPSS version 25.0.

Résultats

Examen initial de la performance des items

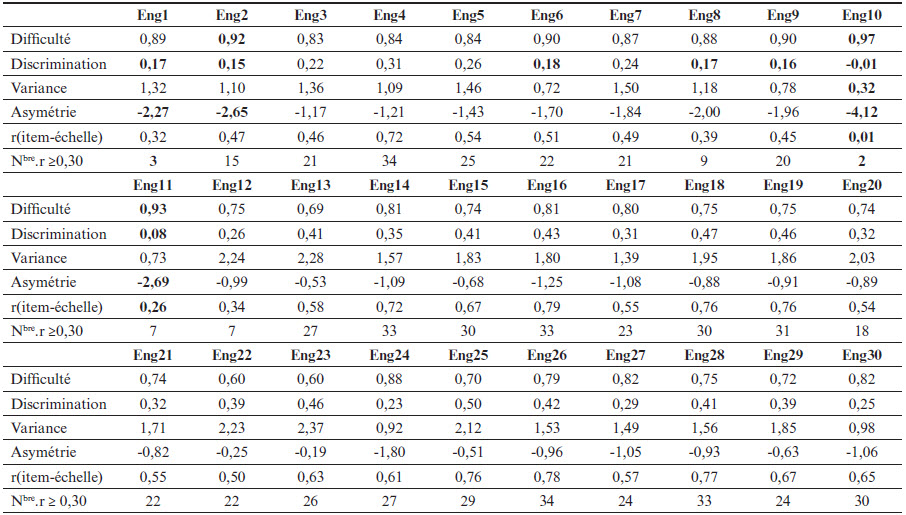

Une analyse d’items a d’abord été réalisée afin d’orienter le processus de sélection subséquent (Laveault et Grégoire, 2014). Les variances et coefficients d’asymétrie ont aussi été calculés, ainsi que les corrélations entre items et les corrélations item-échelle (DeVellis, 2016). Les indices de difficulté et de discrimination, les variances ainsi que les coefficients d’asymétrie et des items sont présentés au Tableau 2 ainsi que, pour chaque item, la corrélation item-échelle et le nombre de corrélations item-item (≥0,30).

Après l’examen initial de ces mesures, quatre items ont été supprimés, car ils présentaient de fortes asymétries, des indices de difficulté élevés (>0,90) et de discrimination faibles (<0,20) (Laveault et Grégoire, 2014) : Eng1 « J’ai participé aux séances synchrones (en classe ou virtuelles) du cours », Eng2 « J’ai visité la plateforme en ligne du cours chaque semaine », Eng10 « J’ai remis les travaux du cours à temps » et Eng11 « J’ai respecté l’échéancier proposé pour les différentes activités du cours ». Certains d’entre eux avaient des corrélations item-échelle faibles (<0,30) ou un grand nombre de corrélations item-item inférieures à 0,30 (DeVellis, 2016 ; Pituch et Stevens, 2016).

Après suppression, la difficulté moyenne des items restants est de 0,78 (ÉT = 0,08) et la discrimination moyenne est de 0,33 (ÉT = 0,09). Les items discriminent donc bien (>0,30 en moyenne), mais sont de faible difficulté (Laveault et Grégoire, 2014).

Par ailleurs, l’item Eng18 « Je me suis senti(e) enthousiaste par rapport à ce cours » a été éliminé, car il présentait une corrélation très forte avec les items Eng19 « J’ai eu du plaisir dans ce cours » (r = 0,83) et Eng25 « J’avais hâte de participer aux activités de ce cours » (r = 0,82), et ce, afin d’éviter tout risque de colinéarité (Bourque et al., 2007 ; Tabachnick et Fidell, 2007). La corrélation item-échelle moyenne est de 0,60 (ÉT = 0,12). Remarquons aussi que tous les items présentent une asymétrie négative, signe d’une non-normalité des variables, qui a été confirmée par la significativité du test de Shapiro-Wilk (p = 0,000).

Tableau 2

Examen initial de la performance des items (É1)

Note. r(item-échelle) = corrélation item-échelle ; nbre.r = nombre de corrélations item-item ≥0,30. Les valeurs présentées en gras sont celles identifiées comme problématiques.

Analyses factorielles exploratoires

À ce stade, la structure interne de l’échelle a été analysée. L’adéquation des données avec des AFE dépend de la possibilité de décomposer la matrice de corrélation en facteurs, et peut être vérifiée grâce au test de sphéricité de Bartlett (p < 0,05) et à l’indice de Kaiser-Meyer-Olkin (KMO ≥ 0,7). Pour les données de l’É1, la significativité du test de Bartlett (p = 0,000) indique que la matrice des corrélations n’est pas une matrice identité et qu’il existe donc des corrélations entre les items, tandis que l’indice KMO de 0,94 suggère un très bon ajustement des items aux facteurs latents sous-jacents (Bourque et al., 2007). Une extraction par factorisation en axes principaux avec rotation oblique (oblimin) a ensuite été réalisée, comme recommandé dans les écrits scientifiques lorsque les facteurs relatifs au construit théorique (ici, les dimensions de l’engagement) sont en intercorrélation (Costello et Osborne, 2005 ; Worthington et Whittaker, 2006).

Suivant les recommandations de Yong et Pearce (2013), le nombre de facteurs retenus a été choisi en fonction de l’analyse des valeurs propres (>1), du tracé d’effondrement et du caractère interprétable de la matrice des facteurs obtenue d’un point de vue conceptuel. Bien qu’une AFE initiale ait révélé cinq facteurs de valeurs propres (13,82 ; 3,14 ; 1,99 ; 1,32 et 1,21), la matrice après rotation ne permettait pas une interprétation claire des facteurs obtenus et le tracé d’effondrement suggérait plutôt une structure en trois facteurs. Ces trois facteurs principaux expliquaient 39,34 %, 7,91 % et 4,46 % de la variance partagée des données, pour un total de 51,71 %.

Ensuite, la matrice des facteurs après rotation a été analysée, puis les AFE ont été poursuivies par élimination d’items, jusqu’à l’obtention d’une structure simple et facilement interprétable d’un point de vue conceptuel (Pituch et Stevens, 2016 ; Tabachnick et Fidell, 2007 ; Worthington et Whittaker, 2006). Ainsi, les items Eng8 « J’ai réalisé les activités proposées dans les séances synchrones (en classe ou virtuelles) du cours », Eng9 « J’ai réalisé les activités proposées en ligne dans ce cours », Eng31 « J’ai pensé de façon critique dans ce cours » et Eng37 « J’ai exploré certains sujets du cours plus en profondeur que ce qui était demandé » présentaient de faibles communautés (communalities h2) inférieures à 0,32 (Tabachnick et Fidell, 2007) respectivement de 0,25, 0,29, 0,31 et 0,31, et ils ont été supprimés. L’item Eng35 « J’ai évalué les forces et les faiblesses de mes propres idées sur un sujet du cours » a aussi été éliminé, car il ne saturait significativement (≥0,32) sur aucun facteur (Tabachnick et Fidell, 2007). De plus, puisque les items Eng23 « J’ai eu le sentiment d’appartenir à une communauté dans ce cours », Eng26 « Je me suis investi(e) psychologiquement dans ce cours » et Eng28 « J’ai exploré en profondeur les sujets du cours » saturaient significativement sur plusieurs facteurs, ils ont été supprimés. À l’obtention d’une structure simple, les items Eng30 « J’ai tenu compte de plusieurs points de vue dans les travaux et activités du cours » et Eng36 « J’ai réfléchi sur ma façon d’apprendre dans ce cours », qui présentaient respectivement des saturations de 0,39 et 0,36, soit inférieures à 0,40 (Pituch et Stevens, 2016 ; Worthington et Whittaker, 2006) sur leur facteur, ont aussi été supprimés.

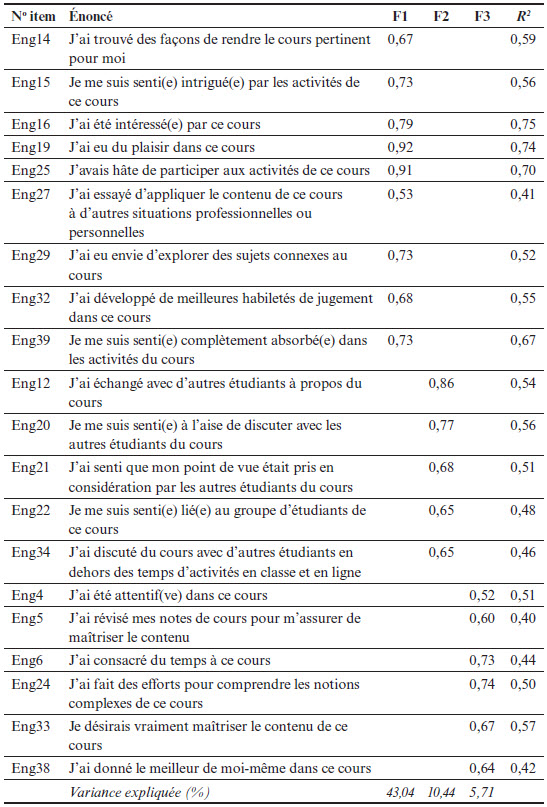

À l’obtention d’une structure simple, Worthington et Whittaker (2004) soulignent l’importance du caractère interprétable des facteurs retenus d’un point de vue conceptuel, au-delà de toute considération empirique. Dans cette échelle, le premier facteur (F1) correspond aux dimensions émotionnelle et cognitive d’engagement des étudiants. Il décrit leur intérêt et leur enthousiasme, desquels découle un investissement cognitif et une exploration plus en profondeur dans le cours.

Le second facteur (F2) est relatif à une dimension sociale d’engagement, car il relève des interactions ainsi que des liens de confiance ou relationnels entre étudiants. Il s’agit ici d’une nouvelle dimension qui, dans la perspective multidimensionnelle d’engagement de Fredricks et al. (2004), apparaissait plutôt à l’intérieur des dimensions émotionnelle (réactions affectives face aux pairs et sentiment d’appartenance) et comportementale (participation aux discussions).

Le troisième facteur (F3) concerne la dimension comportementale de l’engagement des étudiants dans le cours. Plus que la réalisation des activités, il inclut aussi des items relatifs aux efforts des étudiants pour comprendre des notions complexes ainsi que le fait que ceux-ci donnent le meilleur d’eux-mêmes dans le cours, deux items qui avaient été initialement élaborés pour la dimension cognitive d’engagement selon la définition de Fredricks et al. (2004).

Analyses de cohérence interne

Une ACI a ensuite été menée pour chaque facteur issu des AFE. Quatre items présentant des carrés de corrélation multiple (R2) inférieurs à 0,40, signe d’une faible proportion de variance commune avec les autres items du facteur correspondant, ont été supprimés (DeVellis, 2016 ; Worthington et Whittaker, 2006). Ainsi, l’item Eng17 « Je me suis senti(e) en confiance dans ce cours » a été supprimé (R2 = 0,38) du facteur F1 ; l’item Eng13 « J’ai participé activement à des discussions dans ce cours » a été supprimé (R2 = 0,35) du facteur F2 ; et les items Eng3 « J’ai réalisé les lectures suggérées dans ce cours » et Eng7 « J’ai travaillé chaque semaine pour ce cours » ont été supprimés (R2 = 0,33 et 0,37) du facteur F3.

Pour chaque facteur, de nouvelles ACI ont présenté des résultats satisfaisants, avec des coefficients α de Cronbach de 0,94 (F1), 0,86 (F2) et 0,86 (F3), ce qui montre leur très bonne cohérence interne. L’échelle finale, qui comporte 9 items pour F1, 5 items pour F2 et 6 items pour F3, est présentée au Tableau 3.

Enfin, le facteur émotionnel-cognitif d’engagement des étudiants (F1) montrait une corrélation forte de 0,61 avec le facteur comportemental (F3) et une corrélation moyenne de 0,40 avec le facteur social (F2). Par contre, les facteurs comportemental et social d’engagement des étudiants ne présentaient qu’une corrélation faible de 0,25 entre eux.

Validation de la structure finale

Afin de valider les résultats obtenus grâce au premier échantillon de données (É1), la structure factorielle finale a été testée sur le second échantillon (É2) par AFE et ACI, apportant ainsi des preuves supplémentaires de la structure de l’échelle.

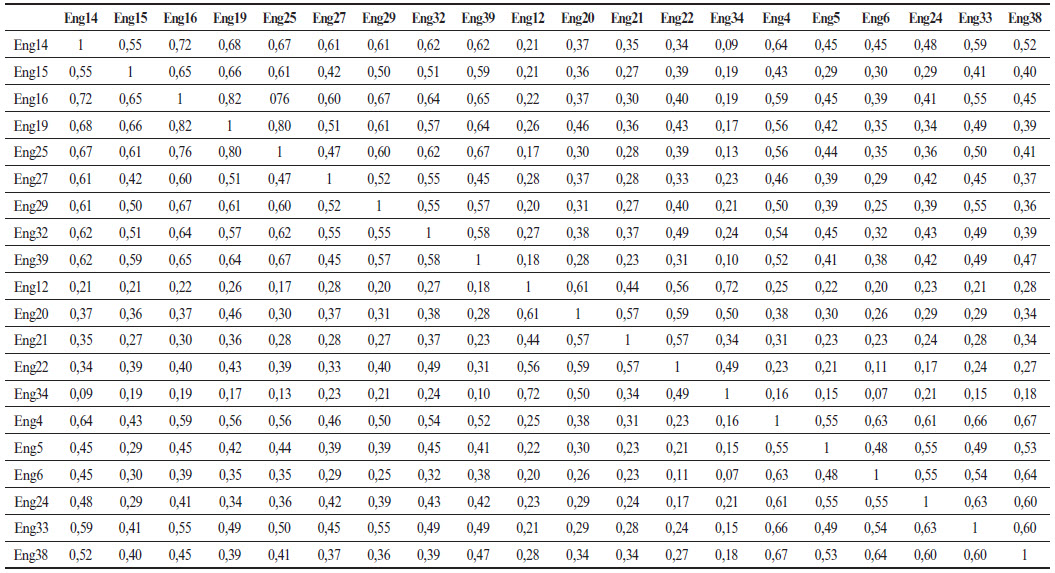

Sur la base des 20 items retenus à l’issue des tests précédents, le tracé d’effondrement d’une AFE (KMO = 0,94) sur l’É2 suggérait clairement une structure en 3 facteurs principaux permettant d’expliquer 60,48 % de la variance partagée des données. La structure factorielle obtenue est identique à celle obtenue pour l’É1, ce qui confirme les dimensions précédemment identifiées.

Les résultats des ACI ont aussi confirmé la très bonne cohérence interne des facteurs, avec des coefficients α de Cronbach de 0,93 (F1), 0,85 (F2) et 0,89 (F3) ainsi que des R2 supérieurs ou égaux à 0,40, signe d’une bonne proportion de variance commune entre les items de chaque facteur.

Les résultats finaux pour l’É2 sont présentés au Tableau 4. Le facteur émotionnel-cognitif d’engagement des étudiants (F1) montrait une corrélation forte de 0,60 avec le facteur comportemental (F3) et une corrélation moyenne de 0,39 avec le facteur social (F2). Les facteurs social et comportemental d’engagement des étudiants présentaient une corrélation moyenne de 0,30 entre eux, légèrement plus élevée que dans le premier échantillon. La matrice de corrélations item-item, pour l’échelle finale, est aussi présentée en annexe.

Tableau 3

Saturations et carrés de corrélation multiple de l’échelle finale (É1)

Tableau 4

Saturations et carrés de corrélation multiple de l’échelle finale (É2)

Discussion et conclusion

Dans cette étude, nous avons proposé l’Échelle multidimensionnelle d’engagement des étudiants dans des modalités de cours hybrides (EMEECH), qui combine activités d’enseignement et d’apprentissage synchrones (en classe ou virtuelles) et asynchrones, selon les lignes directrices suggérées par DeVellis (2016). Différents éléments de preuve de validité ont été récoltés au fil du processus d’élaboration afin d’assurer la robustesse de l’interprétation des résultats de cette échelle pour l’usage proposé (AERA, 2014 ; DeVellis, 2016).

À partir d’une recension des écrits récents sur l’évaluation de l’engagement des étudiants en enseignement supérieur, des items ont été formulés pour les dimensions comportementale, émotionnelle et cognitive d’engagement des étudiants (Fredricks et al., 2004) en s’inspirant des échelles existantes et d’exemples d’indicateurs des écrits scientifiques. Leur clarté et leur pertinence ont été vérifiées par un panel d’experts composé de sept professeurs-chercheurs.

Ainsi, le processus d’élaboration suivi a permis d’apporter divers éléments de preuve de contenu de la nouvelle EMEECH. La structure interne de l’échelle a aussi été étudiée par des AFE et ACI sur deux échantillons de données diversifiées (modalité de cours hybrides, cycle universitaire, discipline, etc.) provenant de trois institutions universitaires des provinces du Québec et de l’Ontario. Alors que le premier échantillon a permis de déterminer une structure en trois facteurs principaux démontrant une très bonne cohérence interne, le second échantillon a apporté des preuves supplémentaires de la validité de cette structure.

Le premier facteur identifié relève des dimensions émotionnelle et cognitive de l’engagement des étudiants. Les résultats suggèrent que ces deux dimensions théoriques sont intrinsèquement liées en pratique, selon les étudiants. Ce facteur explique aussi le plus grand pourcentage (43 %) de la variance partagée des données, ce qui reflète son importance dans l’engagement des étudiants et sa prépondérance par rapport aux autres facteurs dans des modalités de cours hybrides.

Le second facteur identifié met de l’avant une dimension sociale d’engagement des étudiants qui concerne spécifiquement leurs interactions et liens au groupe-cours. Toutefois, les items correspondants étaient répartis initialement, tant selon les exemples d’indicateurs des écrits scientifiques (Bond et Bedenlier, 2019 ; Henrie et al., 2015) que lors de leur génération pour cette échelle, dans les dimensions comportementale, émotionnelle et cognitive définies par Fredricks et al. (2004). Le nouveau facteur social d’engagement des étudiants, à considérer comme une dimension à part entière (10 % de la variance partagée des données), rappelle les dimensions sociale et collaborative d’un cadre conceptuel présenté par Redmond et al. (2018) sur l’engagement des étudiants en ligne à l’ordre universitaire, qui n’a toutefois pas été testé empiriquement et est encore peu connu. Il reflète aussi les résultats d’études très récentes (Hoi et Le Hang, 2021 ; Zhoc et al., 2019) qui confirment l’adéquation de l’inclusion d’une dimension sociale à l’engagement des étudiants en enseignement supérieur.

Enfin, un troisième facteur, plus minime (6 % de la variance partagée des données), relève de la dimension comportementale de l’engagement des étudiants. Il inclut aussi des items relatifs aux efforts des étudiants, associés dans les écrits scientifiques à la dimension comportementale ou cognitive, selon les auteurs (Halverson et Graham, 2019).

Ces trois facteurs ne correspondent pas exactement aux dimensions de l’engagement des étudiants de Fredricks et al. (2004). Cela pourrait s’expliquer par le fait que ces dernières ont été définies d’un point de vue conceptuel, mais peu testées empiriquement en enseignement supérieur et jamais appliquées à des modalités hybrides (Halverson et Graham, 2019). Notre étude fournit aussi, par conséquent, des preuves de la prépondérance d’un facteur émotionnel-cognitif d’engagement ainsi que de la présence d’un nouveau facteur social. Par rapport aux études existantes incluant des échelles d’engagement des étudiants dans des cours, tant en contexte anglophone que francophone, notre étude se distingue par la diversité des éléments de preuve de validité apportés au fil de l’élaboration de l’EMEECH.

En ce qui concerne la structure interne de cette dernière, le fait de l’avoir explorée par des analyses factorielles exploratoires permet de rendre compte de la perspective des étudiants sur leur engagement dans des modalités de cours hybrides[4]. Par ailleurs, des éléments de preuve supplémentaires de la structure interne de l’EMEECH ont été recueillis lors d’une collecte de données subséquente réalisée dans des cours hybrides en ligne[5], collecte qui visait à mettre en relation les dimensions de l’engagement des étudiants et des catégories de stratégies pédagogiques influentes (Heilporn, 2021a ; Heilporn et al., 2021b). Les analyses du modèle de mesure correspondant ont confirmé l’unicité d’une dimension émotionnelle-cognitive ainsi que la dimension sociale d’engagement des étudiants.

La version finale de l’EMEECH, qui comporte 20 items, est concise et ne nécessite pas d’optimisation de longueur supplémentaire[6] (DeVellis, 2016). Remarquons aussi que les questions spécifiques à un seul mode d’un cours hybride (soit les séances synchrones seulement ou les activités en ligne seulement) ont été éliminées au cours du processus d’évaluation des items. Cela signifie que l’engagement des étudiants est mesuré par le biais d’items relatifs à un cours dans sa globalité, ce qui souligne l’importance de considérer la combinaison d’activités d’enseignement et d’apprentissage synchrones et asynchrones comme un tout dans l’étude de l’engagement des étudiants dans les modalités de cours hybrides.

En ce qui concerne les conséquences de l’usage de l’EMEECH et de l’interprétation de ses résultats, notons qu’elle est rapide à remplir pour les étudiants (du fait du nombre restreint d’items), tout en fournissant des informations détaillées aux formateurs sur différentes dimensions de l’engagement des étudiants. Les formateurs peuvent donc facilement dresser un portrait de l’engagement de leurs étudiants et mettre en place des améliorations, si nécessaire. Par contre, les formateurs devraient s’abstenir d’évaluer l’engagement des étudiants sur la base du seul score global à l’échelle. En effet, il se pourrait que certains étudiants très renfermés ou gênés par une situation de handicap obtiennent de moins bons scores sur les items concernant la dimension sociale d’engagement, raison pour laquelle il est important que les formateurs interprètent chacune des dimensions de l’échelle en tenant compte des caractéristiques personnelles des étudiants.

En conclusion, l’échelle de mesure élaborée dans cet article vise à outiller chercheurs et formateurs francophones dans l’étude de l’engagement des étudiants dans des modalités de cours hybrides selon une perspective multidimensionnelle. Les bénéfices de l’usage de cette nouvelle échelle et de l’interprétation des résultats sont importants puisqu’elle fournit des informations détaillées sur différentes dimensions de l’engagement des étudiants en tant que cibles exploitables par les formateurs dans leurs cours. L’échelle peut aussi être utilisée par les chercheurs pour mesurer l’engagement des étudiants selon leurs caractéristiques individuelles, selon les activités ou stratégies mises en place par des formateurs, ou encore en relation avec des indicateurs de réussite scolaire des étudiants en enseignement supérieur. De plus, au-delà des modalités hybrides, l’échelle finale obtenue peut facilement être adaptée pour n’importe quel cours en enseignement supérieur, bien qu’elle n’ait pas été testée empiriquement dans de tels contextes.

Limites et pistes de recherche

Cette étude comporte plusieurs limites. D’abord, l’échantillon était de convenance. Bien que sa taille respecte les standards recommandés pour l’élaboration d’échelles en sciences sociales (Boateng et al., 2018 ; DeVellis, 2016), il est possible que ce soient les étudiants les plus engagés dans leurs études qui aient répondu au questionnaire. Les résultats sont donc à interpréter avec prudence, compte tenu de ce fait.

Ensuite, une collecte de données unique a été réalisée peu après la fin d’une session universitaire, alors que l’engagement peut varier dans le temps, selon le contexte et les activités. Les items proposés étaient aussi très généraux afin qu’ils soient indépendants de disciplines, situations ou activités particulières. Par conséquent, les participants devaient se rappeler leur engagement au fil du cours, dans différentes situations et activités, et en donner une mesure globale, ce qui comporte des risques quant à l’exactitude des résultats. Toutefois, nous avons veillé à faciliter l’appréciation des étudiants pour chacun des items en les formulant de manière simple et concise. Des collectes de données multiples (à plusieurs reprises au cours d’une session universitaire) pourraient être menées dans des recherches futures afin de mieux capturer l’évolution de l’engagement des étudiants au fil du temps ou selon les activités d’enseignement et d’apprentissage.

Enfin, même s’il était avantageux d’apporter des preuves de relations des résultats de la nouvelle échelle avec d’autres variables d’engagement des étudiants dans un cours (AERA, 2014), aucune échelle dont les propriétés psychométriques ont été étudiées n’a pu être identifiée en contexte francophone. Toutefois, le processus d’élaboration détaillé de la nouvelle échelle, présenté dans cet article, apporte déjà de nombreuses preuves de validité. Afin de confirmer la robustesse des facteurs obtenus et de fournir des éléments de preuve supplémentaires concernant la validité de l’interprétation des résultats de l’EMEECH pour l’usage proposé, des études complémentaires sur de nouveaux échantillons permettront de vérifier la stabilité de sa structure interne, notamment par le biais d’analyses factorielles confirmatoires. L’échelle pourra aussi aisément être testée en parallèle avec des items relevant des antécédents (p. ex., des conditions facilitantes) ou des conséquences de l’engagement des étudiants, notamment des indicateurs de leur réussite scolaire.

Appendices

Annexe

Tableau 5

Corrélations item-item pour l’échelle finale

Notes

-

[1]

Selon Fredricks et al. (2004), « il convient de distinguer l’effort principalement comportemental, qui consiste simplement à réaliser les activités, et l’effort axé sur l’apprentissage et la maîtrise du contenu » (p. 64, trad. libre), qui relève de la dimension cognitive.

-

[2]

Par exemple, « I don’t feel very accomplished at this school » (Je n’éprouve pas vraiment de sentiment d’accomplissement dans cette institution) ou bien « When I have doubts I ask questions and participate in debates in the classroom » (Quand j’ai des doutes, je pose des questions et participe à des débats en classe) (Maroco et al., 2016, p. 8).

-

[3]

La règle de décision utilisée est qu’un item est supprimé lorsqu’au moins trois experts lui attribuent une pertinence moyenne ou bien lorsque deux experts lui attribuent une pertinence faible ou moyenne.

-

[4]

Par opposition à des études récentes comme celles de Hoi et Le Hang (2021) ou Zhoc et al. (2019), qui ont imposé quatre items par facteur sans discuter du choix des items ni de leur nombre et qui ont vérifié l’adéquation de leur échelle pour l’engagement des étudiants par le biais d’analyses factorielles confirmatoires avec, dans certains cas, des résultats mitigés sur certaines dimensions (p. ex., saturations très faibles des items de la dimension comportementale dans l’étude de Hoi et Le Hang en 2021, avec des saturations croisées [crossloadings] plus fortes de ces items sur d’autres dimensions).

-

[5]

En contexte de pandémie, à l’issue de la session universitaire d’été 2020 (n = 482), raison pour laquelle des données relatives à d’autres modalités de cours hybrides n’ont pu être recueillies.

-

[6]

Bien que le premier facteur émotionnel-cognitif d’engagement des étudiants comporte neuf items, il paraissait prématuré d’éliminer certains de ceux-ci dès la première collecte de données.

Références

- Alvarez-Bell, R. M., Wirtz, D. et Bian, H. (2017). Identifying keys to success in innovative teaching: Student engagement and instructional practices as predictors of student learning in a course using a team-based learning approach. Teaching & Learning Inquiry, 5(2), 128‑146. https://journalhosting.ucalgary.ca/index.php/TLI/article/view/57489/43250

- American Educational Research Association (AERA). (2014). Standards for Educational and Psychological Testing. AERA.

- Appleton, J. J., Christenson, S. L., Kim, D. et Reschly, A. L. (2006). Measuring cognitive and psychological engagement: Validation of the Student Engagement Instrument. Journal of School Psychology, 44(5), 427‑445. https://doi.org/10.1016/j.jsp.2006.04.002

- Berry, S. (2019). Teaching to connect: Community-building strategies for the virtual classroom. Online Learning, 23(1). https://doi.org/10.24059/olj.v23i1.1425

- Boateng, G. O., Neilands, T. B., Frongillo, E. A., Melgar-Quiñonez, H. R. et Young, S. L. (2018). Best practices for developing and validating scales for health, social, and behavioral research: A primer. Frontiers in Public Health, 6. https://doi.org/10.3389/fpubh.2018.00149

- Boelens, R., De Wever, B. et Voet, M. (2017). Four key challenges to the design of blended learning: A systematic literature review. Educational Research Review, 22(Supplément C), 1‑18. https://doi.org/10.1016/j.edurev.2017.06.001

- Boelens, R., Voet, M. et De Wever, B. (2018). The design of blended learning in response to student diversity in higher education: Instructors’ views and use of differentiated instruction in blended learning. Computers & Education, 120, 197‑212. https://doi.org/10.1016/j.compedu.2018.02.009

- Bond, M. et Bedenlier, S. (2019). Facilitating student engagement through educational technology: Towards a conceptual framework. Journal of Interactive Media in Education, 1(11), 1-14. https://doi.org/10.5334/jime.528

- Bonk, C. J. et Graham, C. R. (2012). The handbook of blended learning: Global perspectives, local designs. John Wiley & Sons.

- Bourque, J., Poulin, N. et Cleaver, A. F. (2007). Évaluation de l’utilisation et de la présentation des résultats d’analyses factorielles et d’analyses en composantes principales en éducation. Revue des sciences de l’éducation, 32(2), 325‑344. https://doi.org/10.7202/014411ar

- Brault-Labbé, A. et Dubé, L. (2010). Engagement scolaire, bien-être personnel et autodétermination chez des étudiants à l’université. Revue canadienne des sciences du comportement, 42(2), 80-92. https://doi.org/10.1037/a0017385

- Christenson, S. L., Reschly, A. L. et Wylie, C. (dir.). (2012). Handbook of research on student engagement. Springer.

- Clark, L. A. et Watson, D. (1995). Constructing validity: Basic issues in objective scale development. Psychological Assessment, 7(3), 309-319. https://doi.org/10.1037/1040-3590.7.3.309

- Coates, H. (2007). A model of online and general campus-based student engagement. Assessment & Evaluation in Higher Education, 32(2), 121‑141. https://doi.org/10.1080/02602930600801878

- Conseil supérieur de l’éducation. (2015). Formation à distance dans les universités québécoises : un potentiel à optimiser. Gouvernement du Québec. https://www.cse.gouv.qc.ca/publications/formation-distance-universites-50-0486

- Conseil supérieur de l’éducation. (2020). Éduquer au numérique. Gouvernement du Québec. https://www.cse.gouv.qc.ca/publications/eduquer-au-numerique-50-0534

- Costello, A. B. et Osborne, J. W. (2005). Best practices in exploratory factor analysis: Four recommendations for getting the most from your analysis. Exploratory Factor Analysis, 10(7), 1‑9. https://scholarworks.umass.edu/cgi/viewcontent.cgi?article=1156&context=pare

- DeVellis, R. F. (2016). Scale development: Theory and applications (4e éd.). SAGE Publications.

- Dixson, M. D. (2010). Creating effective student engagement in online courses: What do students find engaging? Journal of the Scholarship of Teaching and Learning, 10(2), 1‑13. https://files.eric.ed.gov/fulltext/EJ890707.pdf

- Donovan, D. T. (2019). Tracking online and distance education in Canadian universities and colleges: 2018. Canadian Digital Learning Research Association.

- Drysdale, J. S., Graham, C. R., Spring, K. J. et Halverson, L. R. (2013). An analysis of research trends in dissertations and theses studying blended learning. The Internet and Higher Education, 17, 90‑100. https://doi.org/10.1016/j.iheduc.2012.11.003

- Dumford, A. D. et Miller, A. L. (2018). Online learning in higher education: Exploring advantages and disadvantages for engagement. Journal of Computing in Higher Education, 30(3), 452‑465. https://doi.org/10.1007/s12528-018-9179-z

- Fadde, P. J. et Vu, P. (2014). Blended online learning: Benefits, challenges, and misconceptions. Dans P. R. Lowenthal, C. S. York et J. C. Richardson (dir.), Online learning: Common misconceptions, benefits and challenges (p. 33-48). Nova Science Publishing.

- Fredricks, J. A., Blumenfeld, P. C. et Paris, A. H. (2004). School engagement: Potential of the concept, state of the evidence. Review of Educational Research, 74(1), 59‑109. https://doi.org/10.3102/00346543074001059

- Fredricks, J. A., Filsecker, M. et Lawson, M. A. (2016). Student engagement, context, and adjustment: Addressing definitional, measurement, and methodological issues. Learning and Instruction, 43, 1-4. https://doi.org/10.1016/j.learninstruc.2016.02.002

- Fredricks, J. A., Reschly, A. L. et Christenson, S. L. (2019). Conclusion: Status of student engagement interventions. Dans J. A. Fredricks, A. L. Reschly et S. L. Christenson (dir.), Handbook of student engagement interventions (p. 375‑389). Elsevier.

- Garrison, D. R. et Vaughan, N. D. (2008). Blended learning in higher education: Framework, principles, and guidelines. John Wiley & Sons.

- Graham, C. R. (2013). Emerging practice and research in blended learning. Dans M. G. Moore (dir.), Handbook of distance education (3e éd., p. 333‑350). Routledge.

- Halverson, L. R. et Graham, C. R. (2019). Learner engagement in blended learning environments: A conceptual framework. Online Learning, 23(2). https://doi.org/10.24059/olj.v23i2.1481

- Halverson, L. R., Graham, C. R., Spring, K. J., Drysdale, J. S. et Henrie, C. R. (2014). A thematic analysis of the most highly cited scholarship in the first decade of blended learning research. The Internet and Higher Education, 20, 20‑34. https://doi.org/10.1016/j.iheduc.2013.09.004

- Handelsman, M. M., Briggs, W. L., Sullivan, N. et Towler, A. (2005). A measure of college student course engagement. The Journal of Educational Research, 98(3), 184-192. https://doi.org/10.3200/JOER.98.3.184-192

- Heilporn, G. (2021). Stratégies favorisant l’engagement des étudiants dans des modalités de cours hybrides en enseignement supérieur [thèse de doctorat, Université de Sherbrooke]. Savoirs UdeS. https://savoirs.usherbrooke.ca/handle/11143/18359

- Heilporn, G., Lakhal, S. et Bélisle, M. (2021a). An examination of teachers’ strategies to foster student engagement in blended learning in higher education. International Journal of Educational Technology in Higher Education, 18(1), 1-25. https://doi.org/10.1186/s41239-021-00260-3

- Heilporn, G., Lakhal, S. et Bélisle, M. (2021b). Relationships, relevance and sustained pace are key to foster student engagement in blended online courses [document soumis pour publication]. Département de pédagogie, Faculté d’éducation, Université de Sherbrooke.

- Henrie, C. R., Halverson, L. R. et Graham, C. R. (2015). Measuring student engagement in technology-mediated learning: A review. Computers & Education, 90, 36‑53. https://doi.org/10.1016/j.compedu.2015.09.005

- Hoi, V. N. et Le Hang, H. (2021). The structure of student engagement in online learning: A bi-factor exploratory structural equation modelling approach. Journal of Computer Assisted Learning, 1-13. https://doi.org/10.1111/jcal.12551

- Hrastinski, S. (2019). What do we mean by blended learning? TechTrends, 63, 564-569. https://doi.org/10.1007/s11528-019-00375-5

- Kahu, E. R. (2013). Framing student engagement in higher education. Studies in Higher Education, 38(5), 758‑773. https://doi.org/10.1080/03075079.2011.598505

- Krause, K. et Coates, H. (2008). Students’ engagement in first-year university. Assessment & Evaluation in Higher Education, 33(5), 493‑505. https://doi.org/10.1080/02602930701698892

- Lakhal, S., Bateman, D. et Bédard, J. (2017). Blended synchronous delivery mode in graduate programs: A literature review and its implementation in the master teacher program. Collected Essays on Learning and Teaching, 10, 47‑60. https://files.eric.ed.gov/fulltext/EJ1147188.pdf

- Lakhal, S. et Meyer, F. (2019). Blended learning. Dans A. Tatnall (dir.), Encyclopedia of education and information technologies (p. 1-9). Springer.

- Lakhal, S., Mukamurera, J., Bédard, M.-È., Heilporn, G. et Chauret, M. (2020). Features fostering academic and social integration in blended synchronous courses in graduate programs. International Journal of Educational Technology in Higher Education, 17(5). https://doi.org/10.1186/s41239-020-0180-z

- Laveault, D. et Grégoire, J. (2014). Introduction aux théories de tests en psychologie et en sciences de l’éducation. De Boeck Supérieur.

- Lawson, M. A. et Lawson, H. A. (2013). New conceptual frameworks for student engagement research, policy, and practice. Review of Educational Research, 83(3), 432-479. https://doi.org/10.3102/0034654313480891

- Maccallum, R. C., Widaman, K. F., Zhang, S., Hong, S., Maccallum, R. C., Zhang, S. et Hong, S. (1999). Sample size in factor analysis. Psychological Methods, 4(1), 84-99. http://citeseerx.ist.psu.edu/viewdoc/download?doi=10.1.1.536.6317&rep=rep1&type=pdf

- Mandernach, B. J. (2015). Assessment of student engagement in higher education: A synthesis of literature and assessment tools. International Journal of Learning, Teaching and Educational Research, 12(2), 1‑14. https://www.ijlter.org/index.php/ijlter/article/view/367

- Manwaring, K. C., Larsen, R., Graham, C. R., Henrie, C. R. et Halverson, L. R. (2017). Investigating student engagement in blended learning settings using experience sampling and structural equation modeling. The Internet and Higher Education, 35(Supplément C), 21‑33. https://doi.org/10.1016/j.iheduc.2017.06.002

- Maroco, J., Maroco, A. L., Campos, J. A. D. B. et Fredricks, J. A. (2016). University student’s engagement: Development of the University Student Engagement Inventory (USEI). Psicologia: Reflexão e Crítica, 29(1), 1‑12. https://doi.org/10.1186/s41155-016-0042-8

- Martin, F. et Bolliger, D. U. (2018). Engagement matters: Student perceptions on the importance of engagement strategies in the online learning environment. Online Learning, 22(1). https://doi.org/10.24059/olj.v22i1.1092

- Mayer, D. (2019). Comparaison entre les étudiants de première et de seconde génération : engagement, rendement et persévérance. Nouvelles perspectives en sciences sociales, 14(2), 303-333. https://doi.org/10.7202/1062513ar

- Messick, S. (1995). Validity of psychological assessment: Validation of inferences from persons’ responses and performances as scientific inquiry into score meaning. American Psychologist, 50(9), 741-749. https://psycnet.apa.org/doi/10.1037/0003-066X.50.9.741

- Ouimet, J. A. et Smallwood, R. A. (2005). Assessment measures: CLASSE – The Class-Level Survey of Student Engagement. Assessment Update, 17(6), 13‑15.

- Parent, S. (2017). Perception des étudiants et des enseignants quant à l’aspect novateur du numérique dans un cours d’introduction au collégial. Revue canadienne des jeunes chercheur(e)s en éducation, 8(2), 30-39. https://journalhosting.ucalgary.ca/index.php/cjnse/article/view/42917

- Pituch, K. A. et Stevens, J. (2016). Applied multivariate statistics for the social sciences: Analyses with SAS and IBM’s SPSS (6th ed.). Routledge/Taylor & Francis Group.

- Power, M. (2008). The emergence of a blended online learning environment. MERLOT Journal of Online Learning and Teaching, 4(4), 503‑514.

- Raes, A., Detienne, L., Windey, I. et Depaepe, F. (2019). A systematic literature review on synchronous hybrid learning: Gaps identified. Learning Environments Research, 23, 269-290. https://doi.org/10.1007/s10984-019-09303-z

- Redmond, P., Abawi, L. A., Brown, A., Henderson, R. et Heffernan, A. (2018). An online engagement framework for higher education. Online Learning, 22(1), 183-204. http://dx.doi.org/10.24059/olj.v22i1.1175

- Schreiner, L. A. et Louis, M. (2011). The engaged learning index: Implications for faculty development. Journal on Excellence in College Teaching, 22(1), 5‑28.

- Spring, K. J., Graham, C. R. et Hadlock, C. A. (2016). The current landscape of international blended learning. International Journal of Technology Enhanced Learning, 8(1), 84‑102. https://doi.org/10.1504/IJTEL.2016.075961

- Streiner, D. L., Norman, G. R. et Cairney, J. (2015). Health measurement scales: A practical guide to their development and use (5th ed.). Oxford University Press.

- Sturgis, P., Roberts, C. et Smith, P. (2014). Middle alternatives revisited: How the neither/nor response acts as a way of saying “I don’t know”? Sociological Methods & Research, 43(1), 15‑38. https://doi.org/10.1177/0049124112452527

- Tabachnick, B. G. et Fidell, L. S. (2007). Using multivariate statistics (5th ed.). Pearson.

- Taylor, M., Vaughan, N., Ghani, S. K., Atas, S. et Fairbrother, M. (2018). Looking back and looking forward: A glimpse of blended learning in higher education from 2007-2017. International Journal of Adult Vocational Education and Technology, 9(1), 1‑14. https://doi.org/10.4018/IJAVET.2018010101

- Vaughan, N. (2014). Student engagement and blended learning: Making the assessment connection. Education Sciences, 4(4), 247‑264. https://doi.org/10.3390/educsci4040247

- Watts, L. (2016). Synchronous and asynchronous communication in distance learning: A review of the literature. Quarterly Review of Distance Education, 17(1), 23‑32. https://www.proquest.com/openview/f83c30d3f7e7d1cd69754d1fa52eaff5/1?pq-origsite=gscholar&cbl=29705

- Worthington, R. L. et Whittaker, T. A. (2006). Scale development research: A content analysis and recommendations for best practices. The Counseling Psychologist, 34(6), 806‑838. https://doi.org/10.1177/0011000006288127

- Yong, A. G. et Pearce, S. (2013). A beginner’s guide to factor analysis: Focusing on exploratory factor analysis. Tutorials in Quantitative Methods for Psychology, 9(2), 79‑94. https://doi.org/10.20982/tqmp.09.2.p079

- Zhoc, K. C., Webster, B. J., King, R. B., Li, J. C. et Chung, T. S. (2019). Higher Education Student Engagement Scale (HESES): Development and psychometric evidence. Research in Higher Education, 60(2), 219-244. https://doi.org/10.1007/s11162-018-9510-6

List of tables

Tableau 1

Caractéristiques sociodémographiques des participants (n=465)

Tableau 2

Examen initial de la performance des items (É1)

Tableau 3

Saturations et carrés de corrélation multiple de l’échelle finale (É1)

Tableau 4

Saturations et carrés de corrélation multiple de l’échelle finale (É2)

Tableau 5

Corrélations item-item pour l’échelle finale

10.7202/014411ar

10.7202/014411ar