Résumés

Résumé

Les institutions universitaires doivent implanter des mécanismes de suivi en continu de leurs programmes pour s’assurer de leur pertinence et pour répondre à différents besoins d’évaluation. Parmi les outils et les méthodes pouvant leur venir en aide se trouvent les tableaux de bord, pour centraliser et exploiter des indicateurs pertinents à ce suivi, la cartographie de programme, afin d’analyser la cohérence de ceux-ci, ainsi que les plans de cours, comme matière première à ce suivi. Après avoir présenté ces trois éléments, la méthodologie de l’École de bibliothéconomie et des sciences de l’information (EBSI) de l’Université de Montréal est présentée pour en illustrer l’application.

Abstract

Universities must implement mechanisms that allow for the continuous evaluation of their programmes in order to ensure their relevance and to meet the different evaluation challenges. Management charts are just one of the tools that can be used to monitor the relevant indicators of the evaluation mechanism and to assess the coherence of the programmes. Curriculum mapping and course outlines can also be used to monitor the indicators. Following a description of these three elements, the methodology used by the École de bibliothéconomie et des sciences de l’information (EBSI) of the Université de Montréal is described, illustrating the application of continuous evaluation.

Resumen

Las instituciones universitarias deben implementar mecanismos de seguimiento permanente en sus programas, a fin de garantizar su pertinencia y de responder a las diferentes necesidades de evaluación. Entre las herramientas y los métodos que pueden ser útiles, encontramos los cuadros de mando, que permiten centralizar y explotar indicadores pertinentes a este seguimiento; la cartografía de programas, destinada a analizar su coherencia, y los planes de estudio, como base de este seguimiento. Tras la presentación de estos tres elementos, se introduce la metodología de la Escuela de Bibliotecología y Ciencias de la Información (EBSI) de la Universidad de Montreal para ilustrar su aplicación.

Corps de l’article

Introduction

Les institutions d’enseignement universitaires doivent, pour différentes raisons, mettre en place des mécanismes afin de suivre leurs offres de formation en temps presque réel et de manière continue. Dans un contexte de changements fréquents et parfois même d’instabilité, les gestionnaires de programme et les enseignants doivent développer des stratégies afin de maintenir des programmes de formation cohérents, efficaces et alignés aux besoins (Veltri, Webb, Matveev & Zapatero 2011, 31). Ces institutions gravitent dans un environnement qui se caractérise par une évolution rapide et constante, tant sur le plan disciplinaire que sur celui des marchés visés pour leurs diplômés. De plus, elles doivent faire face à des contraintes financières ou liées aux ressources humaines. Leur capacité à offrir des programmes adaptés à cette mouvance est un véritable avantage stratégique. Certains programmes de formation font l’objet de demandes d’évaluation de la part de leur institution d’attache, mais aussi parfois d’associations professionnelles, exacerbant ainsi le besoin de stratégies permettant leur suivi (Cuevas, Matveev & Feit 2009, 23). La mise en place de tels mécanismes permet aux institutions de répondre de manière efficiente aux besoins d’évaluation.

Les institutions d’enseignement universitaires qui offrent des formations en sciences de l’information (SI) n’échappent pas au besoin de suivre leurs programmes sur la durée pour s’assurer qu’ils demeurent pertinents et reconnus. Les SI font l’objet de transformations constantes, ne serait-ce que sous la poussée du numérique qui est venu changer aussi bien l’objet au coeur de leur préoccupation – l’information – que les processus et les outils associés; pour qu’elles conservent leur bien-fondé, les formations doivent être constamment ajustées. Aux changements disciplinaires s’ajoutent les besoins d’évaluation des universités d’attache, mais aussi d’associations professionnelles telles que l’American Library Association (ALA) pour les programmes de maîtrise en sciences de l’information (MSI) qui en reçoivent leur agrément[1]. Une réflexion constante doit ainsi être faite afin de développer des outils et des méthodes efficaces de suivi.

La première partie de cet article propose un tour d’horizon de la littérature concernant trois éléments pertinents au suivi des programmes de formation : les tableaux de bord pour la gestion de programme, la cartographie de programme et les plans de cours. Dans la deuxième partie, une implantation concrète d’une méthodologie d’évaluation continue de programme est présentée, soit le cas de l’École de bibliothéconomie et des sciences de l’information (EBSI) de l’Université de Montréal.

Revue de la littérature

On retrouve dans la littérature certaines méthodologies et différents outils permettant de faciliter le suivi de programmes de formation. La première section de cette revue de la littérature s’intéresse au tableau de bord comme outil de centralisation et d’exploitation des indicateurs de suivi. La deuxième section présente la cartographie de programme, une méthodologie permettant de mesurer la cohérence d’un programme. La troisième section explicite les avantages des plans de cours comme matière première pour l’évaluation de programme.

Tableau de bord pour la gestion de programme[2]

Plusieurs mécanismes sont implantés au sein des écoles et des départements universitaires pour recueillir des données sur les programmes : sondages auprès des étudiants et des diplômés, profils statistiques des clientèles, etc. Ces mécanismes génèrent une toile dense et riche de données. L’objectif de la mise en place d’une méthodologie générale d’évaluation continue de programme n’est donc pas de créer un nouveau mécanisme, mais plutôt d’exploiter plus efficacement l’existant. Il importe de mettre à jour régulièrement cette base de connaissances, mais aussi de l’organiser et de la synthétiser afin d’assurer un suivi efficace. Le défi est double : (1) identifier les informations auxquelles il faut porter une attention particulière (indicateurs de suivi) et; (2) mettre en place un système permettant de centraliser et de gérer ces indicateurs pour en extraire du sens.

Les informations créées par les différents mécanismes de suivi sont variées, parfois d’importance inégale, mais surtout dispersées dans plusieurs documents (rapports, procès-verbaux, fichiers Excel par exemple). Cet éclatement des informations rend difficile l’obtention du portrait d’un programme, à un moment t, afin de l’évaluer. Face à un défi similaire, Coker et Friedel (1991) proposent un modèle matriciel afin d’agréger les résultats de plusieurs sondages à des fins d’évaluation de programme. Ce modèle rejoint l’idée du tableau de bord qui, par le regroupement de différents indicateurs – ici les éléments d’information sur un programme –, permet de générer une vision globale de celui-ci, que l’on peut exploiter pour en permettre le suivi et la comparaison avec des structures équivalentes (Carbone 2002; Voyer 1999). Un tableau de bord fait ressortir les écarts, les résultats significatifs ainsi que les tendances (Voyer 1999, 40).

Le tableau de bord ne fait pas que répondre à des besoins d’évaluation a posteriori, mais il peut s’insérer dans une stratégie de suivi en continu pour procéder à des ajustements au fur et à mesure des besoins (Carbone 2002, 250; Voyer 1999, 29). Il permet un regard sur le passé et sur le présent pour se projeter dans l’avenir. Un tableau de bord est un outil de gestion qui soutient la prise de décision et le dialogue (Voyer 1999, 28). Il s’adresse en premier lieu aux gestionnaires, afin qu’ils puissent rendre compte, sur la base de données chiffrées, de l’évolution de leurs activités (Voyer 1999, 29). Afin d’obtenir une représentation réaliste des activités, la démarche doit être soutenue par l’ensemble du personnel dès la formulation des objectifs ou le choix des indicateurs (Carbone 2002, 246). L’élaboration d’un tableau de bord passe par quatre étapes principales : le cadrage (la définition des objectifs du suivi), le choix des indicateurs, leur mise en forme et la précision des modalités de la mise en oeuvre (Carbone 2002, 215).

Une fois les objectifs définis, le défi est donc d’identifier les indicateurs qui permettent de synthétiser les caractéristiques du programme afin de les inscrire au sein d’un processus d’évaluation intégré dans l’action (Carbone 2002). Ces indicateurs peuvent être de différents types. Certains sont factuels, de nature quantitative, chiffrant plusieurs des éléments et des activités gravitant dans l’écosystème d’un programme de formation : nombre d’étudiants admis, profils des étudiants, budgets, etc. D’autres sont qualitatifs, rendant compte de la cohérence des programmes : liens entre les cours, niveaux des objectifs, etc. Si la difficulté pour les premiers est d’arriver à en faire un inventaire pour y repérer les plus pertinents, les seconds génèrent des réflexions d’une autre nature, interpellant la mécanique sous-jacente à la structure d’un programme. Il s’agit de « mesurer » la cohérence des différentes composantes d’un programme pour voir comment il soutient un étudiant dans sa démarche d’acquisition de compétences pertinentes à son projet professionnel et à son bagage antérieur.

Les modalités de mise en oeuvre recouvrent, entre autres, le choix d’un système d’information pour soutenir les objectifs du tableau de bord qui permette de structurer les indicateurs et d’en faciliter la visualisation sous différents angles, afin de donner à la fois une vision globale ou, au besoin, l’exposition de certains détails. Le système doit allier convivialité, personnalisation, évolutivité et souplesse (Voyer 1999). L’offre de plateformes soutenant ce type d’exercice est variée. Selon l’ampleur de la tâche, on peut adopter une solution simple comme l’utilisation d’un tableur pour structurer et visualiser les indicateurs. Il est aussi possible d’aller vers des environnements plus complets comme des systèmes d’information décisionnels (business intelligence and analytics platforms) qui permettent, entre autres, de modéliser et de combiner les données, et de produire des tableaux de bord interactifs soutenant l’exploration visuelle des données. Parmi les chefs de file de cette catégorie de plateformes se retrouvent Tableau (<www.tableau.com>) et Qlik (<www.qlikview.com>), reconnus comme d’excellents systèmes d’information décisionnels (Sallam et al. 2015).

En résumé, le tableau de bord est un outil de gestion qui soutient le suivi de certaines activités sur la base d’indicateurs choisis pour en représenter l’essence. Par le biais d’une plateforme conviviale qui permet aux acteurs impliqués d’y saisir les informations pertinentes, il est possible d’en extraire des synthèses facilitant l’identification des éléments significatifs et d’apporter les ajustements nécessaires. Le choix des indicateurs est crucial. Quoique ceux-ci soient principalement quantitatifs, certains sont de nature qualitative et donnent l’occasion d’évaluer la cohérence d’un programme de formation. Une méthodologie pouvant contribuer à qualifier cette cohérence est la cartographie de programme, méthodologie qui fait l’objet de la prochaine section.

Cartographie de programme

Une des stratégies qui met en exergue la cohérence d’un programme de formation est la cartographie de programme (curriculum mapping), une approche analytique qui identifie les principales composantes d’un programme et leurs interconnexions, le tout sous forme visuelle (Cuevas et al. 2009, 24; Willett 2008, 786). Cette approche vise à mesurer la cohérence d’un programme par rapport à ce qui y est enseigné (Cuevas et al. 2009, 24; Veltri et al. 2011, 32) en répondant à trois questions : (1) qui fait quoi?; (2) comment le travail s’aligne-t-il avec les objectifs du programme?; (3) travaillons-nous efficacement et avec efficience? (Jacobs 2004, cité dans Uchiyama & Radin 2009, 275) Il est ainsi possible d’identifier les lacunes et les redondances au sein d’un programme (Willett 2008, 786). En plus d’évaluer l’alignement de l’enseignement aux standards régissant le programme, la cartographie favorise le développement d’unités d’enseignement bien intégrées, l’établissement de lignes directrices pour la révision des programmes, l’identification des besoins en formation du personnel et, finalement, le soutien à la communication au sein de l’équipe (Koppang 2004, 155).

L’idée de la cartographie de programme comme espace de communication revient à maintes reprises dans la littérature comme un des bénéfices de cette approche. Ce processus inclut souvent la mise en commun des cartes produites et la discussion de ces dernières par les membres du personnel, en particulier le corps enseignant (Cuevas et al. 2009, 26; Koppang 2004, 157; Uchiyama & Radin 2009, 273-274; Veltri et al. 2011, 33). Ces discussions deviennent des occasions pour les enseignants de connaître leurs expertises respectives et d’examiner leurs positions individuelles et collectives sur les questions de l’enseignement et de l’apprentissage (Uchiyama & Radin 2009, 273). Cette coconstruction d’une cartographie de programme par les enseignants devient ainsi un espace de collaboration pour partager les stratégies d’enseignement (Koppang 2004, 157). Uchiyama et Radin (2009, 277), lors d’un exercice de cartographie, ont découvert de manière imprévue cette valeur ajoutée du processus en notant l’augmentation de la collégialité et de la collaboration entre les 11 enseignants impliqués dans l’exercice. Ils y voient un moyen de briser l’isolement vécu par plusieurs enseignants en début de carrière dans un système qui, parfois, favorise les réalisations individuelles plus que les réalisations collectives (Uchiyama & Radin 2009, 271-272).

La cartographie de programme a été introduite au début des années 1970 comme méthode d’alignement entre la description écrite des programmes et ce qui y est réellement enseigné (Koppang 2004, 155). Jerome J. Hausman, un pionnier de cette approche (Willett 2008, 786), la décrit en utilisant la métaphore des cartes géographiques (Hausman 1974, 193), image que reprend Willett :

Thus, a curriculum could be represented as a map to be used by individuals in view of their own particular needs, insights, and values. Rather than projecting a single, linear, and sequentially-based series of learning activities, the view of curriculum from which I would proceed involves developing varying alternatives that might be linked or clustered in varying ways depending upon the unique circumstances of a particular classroom situation. Thus the analogy with mapping. What I am seeking is a way to develop maps of differing degrees of complexity and detail, charting a range of instructional territories. Teachers seeking to navigate the territory of their own curricula might then be thought of as turning for guidance to maps, using them to plot itineraries that would differ depending upon the particular circumstances of their schools as well as their own interests and abilities.

2008, 786

Selon Veltri et al. (2011, 32), qui citent de nombreux auteurs en appui, la cartographie de programme est une méthode très répandue dans les universités et les collèges britanniques, australiens et canadiens. Il ressort de leur examen de la littérature américaine sur l’enseignement supérieur que cette technique a été étudiée sous différents angles : pour l’évaluation, pour répondre à des besoins d’agrément dans le domaine des affaires, de l’ingénierie et de la pharmaceutique, comme un processus pour améliorer les programmes ou comme outil de développement pour les enseignants – chacun de ces angles ayant fait l’objet d’une ou de plusieurs publications.

Willett (2008) est aussi arrivé à la conclusion que plusieurs écoles de médecine au Canada et en Grande-Bretagne s’intéressent à la cartographie de programme, et plus particulièrement à la cartographie numérique de programme, afin d’améliorer leur processus, même si on trouve peu de références à ce sujet dans la littérature disciplinaire. Il fait toutefois remarquer que la cartographie a récemment fait l’objet de plusieurs présentations par affiche ou communications dans des congrès liés à l’enseignement de la médecine (Willett 2008, 786).

La réalité semble toutefois varier selon les disciplines. Veltri et al. relèvent le manque d’études conceptuelles sur la cohérence du curriculum dans le domaine des systèmes d’information, constat qui les étonne vu l’accent mis dans ce domaine sur les systèmes. Même si la visualisation de la structure des programmes de formation dans le domaine des systèmes d’information n’est pas nouvelle, la publication d’études présentant des exercices formels de cartographie de ces programmes est quant à elle plutôt récente (Daigle, Longenecker, Landry & Pardue 2004; Landry, Daigle, Longenecker & Pardue 2006; White & McCarthy cités dans Veltri et al. 2011, 32).

La cartographie de programme se divise en quatre grandes phases : (1) la collecte des données; (2) le stockage des données; (3) la présentation des données et; (4) l’analyse des données (Eisenberg & Berkowitz 1988). Les processus qui les sous-tendent peuvent être complexes, variant selon les perspectives adoptées. La collecte, par exemple, peut impliquer différentes sources d’information puisque la cartographie peut porter sur divers éléments, dont des personnes (apprenants et enseignants), des activités (apprentissage et évaluation), des cours, des résultats et des objectifs, des ressources pour l’apprentissage, des thèmes et des localisations (Willett 2008, 786).

Différents types de curriculum, correspondant à des représentations différentes d’un même programme, peuvent être utilisés. Cuevas et al. (2009, 24) en distinguent quatre : le curriculum prévu, le curriculum conçu, le curriculum implanté et le curriculum évalué. À ces quatre types, Veltri et al. (2011, 32), qui se sont inspirés entre autres du modèle proposé par Cuevas et al. (2009), en ajoutent un cinquième, soit le curriculum communiqué (Tableau 1).

Tableau 1

Types de curriculum présentés par Cuevas et al. (2009) et Veltri et al. (2011)

Les processus proposés par ces auteurs viennent s’ancrer autour de l’étude de ces différents types de curriculum, décrivant ainsi un processus centré sur les sources de données exploitées (Tableau 2).

Tableau 2

Processus de cartographie de programme « centré-sources de données » selon Veltri et al. (2011), inspiré de celui de Cuevas et al. (2009)

Un ajout intéressant de Veltri et al. (2011) au processus de cartographie de programme est la définition d’indicateurs quantitatifs ayant des fonctions « diagnostic » par rapport à un programme. Ces indicateurs[3] permettent de calculer : (1) le niveau relatif de représentation intentionnelle des objectifs de programme dans les plans de cours; (2) le poids relatif des objectifs de programme dans le curriculum; (3) le degré relatif d’emphase sur les objectifs de programme dans les évaluations; (4) la contribution relative des cours au développement des objectifs de programme en ce qui a trait à l’ampleur de leur couverture ainsi que la profondeur de celle-ci.

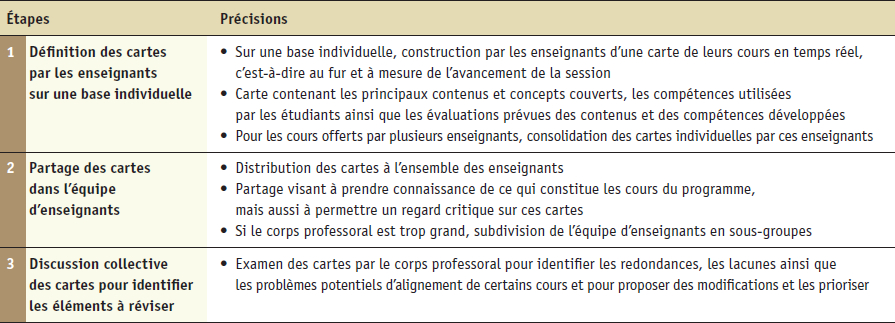

D’autres auteurs présentent un processus de cartographie qui gravite plutôt autour du rôle des différents acteurs impliqués, mettant moins l’accent sur les données à la source de la cartographie (Tableau 3). Koppang (2004, 155) et Uchiyama et Radin (2009, 272) insistent sur le fait que la cartographie de programme s’intéresse à ce qui est réellement enseigné dans les écoles. Ils rejettent ainsi l’utilisation des plans de cours pour la cartographie de programme puisque ces derniers sont une projection de ce que l’enseignant envisage de faire dans le cours, projection qui peut différer de ce qui est réellement fait (Uchiyama & Radin 2009, 272). Ils privilégient la construction par les enseignants, en temps réel ou presque, d’une carte de ce qu’ils enseignent, représentant ainsi en partie ce que Cuevas et al. (2009) et Veltri et al. (2011) appellent le curriculum implanté et le curriculum évalué.

Tableau 3

Processus de cartographie de programme « centré-acteurs impliqués » selon Koppang (2004) et Uchiyama et Radin (2009)

À ces trois étapes, Uchiyama et Radin (2009) ajoutent, afin de « boucler la boucle », la révision effective des cours et l’implantation de ces révisions. De plus, il est intéressant de noter que les auteurs indiquent que ce processus est cyclique, l’étape ultime étant de le recommencer.

Une autre différence du processus centré-acteurs est l’absence d’une mention explicite des objectifs de programme. Cet élément, mentionné explicitement dans le processus centré-sources comme première étape, semble ici implicite. Il est en effet raisonnable de penser que l’étape de discussion des cartes impliquera, d’une manière ou d’une autre, de grands objectifs afin d’identifier, notamment, des lacunes ou des problèmes d’alignement. Un référentiel-programme semble en effet souhaitable à cette fin.

En résumé, l’idée centrale de la cartographie de programme est de révéler des traces donnant l’occasion aux acteurs impliqués de dégager l’articulation des cours au coeur d’un programme pour voir comment ceux-ci réussissent, ou non, à permettre aux étudiants d’en atteindre les objectifs. Le processus présenté par Cuevas et al. (2009) et Veltri et al. (2011) permet d’identifier différentes représentations d’un programme pouvant servir de matière première à un exercice de cartographie. Koppang (2004) et Uchiyama et Radin (2009) proposent un processus complémentaire étant centré sur les acteurs impliqués. La prochaine section portera sur une des représentations du programme, le plan de cours, pour en évaluer l’utilité dans un processus d’évaluation de programme.

Plan de cours

Le plan de cours peut jouer un rôle important dans un processus de cartographie de programme. Certains auteurs l’incluent explicitement comme moyen de représenter le curriculum communiqué (Cuevas et al. 2009; Veltri et al. 2011). Ceux qui le rejettent, notamment Koppang (2004) et Uchiyama et Radin (2009), le font parce qu’il ne correspond pas nécessairement à ce qui est réellement enseigné dans les cours. Cette position devrait être nuancée, à notre avis, un plan de cours pouvant correspondre à ce qui est vu en classe; il ne faut pas en minimiser l’importance. Ce type de document présente plusieurs avantages : il s’agit d’un document obligatoire et mis à jour régulièrement, et ce, de manière distribuée, correspondant à un genre de documents relativement « normé » qui peut refléter à la fois les contenus, les apprentissages visés et les moyens de mesurer l’atteinte des objectifs. Il possède un grand potentiel pour l’implantation d’un processus de cartographie de programme sur une base continue puisqu’il représente le curriculum communiqué (résultats attendus et activités d’enseignement et d’apprentissage) qui, par la mise en lien avec le curriculum prévu (objectifs de programme), permet d’en évaluer la cohérence et d’en discuter au regard des apprentissages effectués (curriculum évalué). Il importe ainsi de s’attarder sur le genre de document qu’est le plan de cours.

Dans le système d’éducation nord-américain, les plans de cours sont monnaie courante; dans plusieurs universités, ils doivent obligatoirement être remis aux étudiants par l’enseignant au début d’un cours. L’intérêt pour les plans de cours, et la recherche sur ces questions, résident principalement du côté des États-Unis. Mais l’intérêt n’est pas aussi grand qu’on pourrait le penser. À la lumière de l’importance des plans de cours dans l’enseignement, certains s’inquiètent du peu d’attention qui leur est accordée (Bers, Davis & Taylor 1996; Slattery & Carlson cités dans Eberly, Newton & Wiggins 2001, 59).

Les fonctions des plans de cours sont multiples, leurs buts diversifiés et ils interviennent sur plusieurs plans (Figure 1).

Figure 1

Différentes facettes des plans de cours

La première fonction d’un plan de cours en est une de communication entre l’enseignant et ses étudiants puisqu’on y retrouve formalisées et consignées différentes informations en lien avec le cours (Eberly et al. 2001, 56; Majetka & Kurke 1994). La présentation du plan de cours lors de la première séance d’un cours et la discussion qui s’ensuit définissent le ton qui sera donné à ce cours (Appleby 1999; Littlefield 1999; Office of Teaching Effectiveness and Faculty Development cité dans Slattery & Carlson 2005, 159). Le plan de cours intervient sur la dimension interpersonnelle, la première impression d’un cours par un étudiant provenant bien souvent de sa présentation en classe (Danielson cité dans Eberly et al. 2001, 59; Matejka & Kurke 1994, 115).

Le plan de cours sert aussi au développement des cours puisque sa visée structurelle (Slattery & Carlson 2005, 160) concourt à expliciter les responsabilités respectives des étudiants et des enseignants, tout en demandant aux enseignants l’effort de structuration des différentes composantes de leur enseignement. Lorsque bien construit, il offre aux étudiants et aux enseignants un cadre leur permettant de comprendre où ils vont et ce qu’il faut faire pour s’y rendre. Il sert ainsi de carte cognitive à l’enseignant pour guider les étudiants dans le voyage intellectuel que représente le cours (Majetka & Kurke 1994).

Finalement, le plan de cours intervient sur le plan administratif, rejoignant l’idée de preuve avancée par Slattery et Carlson (2005, 160), puisqu’il peut servir à régler d’éventuels litiges ou comme moyen d’évaluer l’équivalence entre des cours. Ce document officiel sert d’entente et constitue une forme de contrat entre les enseignants et les étudiants. De plus, en raison de la description qui y est faite des cours, il peut servir à des besoins d’évaluation de programme par des entités externes (comités d’agrément par exemple) puisqu’il offre un portrait synthétique de ce qu’un enseignant communique à ses étudiants.

Eberly et al. (2005) démontrent la nature multifonctionnelle de l’outil dans une analyse de contenu de 145 plans de cours offerts en 1997-1998 dans le programme d’éducation général de l’Université d’Oakland. Il ressort de leur analyse que les sections d’un plan de cours couvrent principalement les aspects administratifs ainsi que ceux liés au développement des cours, mais que seulement une des sections s’est révélée en lien avec la dimension interpersonnelle (Eberly et al. 2005, 68).

Bien qu’aucun consensus ferme n’émerge de la littérature quant aux composantes d’un plan de cours, certains contenus sont attendus au regard des buts définis. Le Centre d’études et de formation en enseignement supérieur (CEFES) de l’Université de Montréal[4] suggère de retenir l’idée de l’alignement pédagogique proposé par Claude Magnan (2003) pour y inclure les éléments permettant de répondre aux questions « Quoi? Pourquoi? Comment? Quand? » dans un tout cohérent révélant la logique sous-jacente du cours (Figure 2).

Figure 2

Modèle de l’alignement pédagogique proposé par Claude Magnan (2003) et présenté par le CEFES[5] (notre adaptation)

Slattery et Carlson (2005, 160-163) préconisent des plans de cours détaillés pour minimiser l’inquiétude chez les étudiants. Cette idée est appuyée par Parkes, Fix et Harris (2003), qui se sont plus particulièrement intéressés, dans leur analyse d’un corpus de plans de cours, à la question de l’information communiquée aux étudiants concernant les évaluations. Ils constatent l’absence de nombreuses informations sur les évaluations dans plusieurs plans de cours et concluent qu’une meilleure communication, plus cohérente, est nécessaire pour améliorer l’apprentissage des étudiants et diminuer leur inquiétude.

Les contenus, présentés à la Figure 2, rejoignent les observations de Slattery et Carlson (2005, 160-163) dans leur modèle des meilleures pratiques en termes de construction d’un plan de cours, modèle établi à partir de l’analyse des écrits sur ce sujet ainsi que d’exemples anecdotiques. Ce modèle est similaire, dans ses grandes lignes, à ce que Matejka et Kurke (1994) proposent pour soutenir la vocation de contrat et de planification de l’outil. À ces composantes, Slattery et Carlson (2005) ajoutent la description des services de l’université ainsi que des messages de motivation (politiques d’absence, etc.).

La grille d’analyse des plans de cours utilisée par Eberly et al. (2005) présente des composantes de même nature, entre autres pour ce qui est des informations de base sur le cours et sur les pratiques d’évaluation. Les éléments de motivation s’y retrouvent aussi sous la forme de rappel de la responsabilité des étudiants vis-à-vis de leur apprentissage, cette dernière information n’étant toutefois que peu présente, à leur grand étonnement, dans les plans de cours analysés. Bien qu’ils ne parlent pas de la justification du cours, ils s’attardent à la présence de mentions du programme générique, donc une forme de contextualisation qui rejoint la même idée.

De manière générale, les plans de cours doivent être attrayants et en adéquation avec l’atmosphère du cours. Ils doivent être faciles à parcourir sur le Web et chaleureux. Il est important qu’ils soient cohérents et mis à jour à la fin de chaque semestre en fonction des observations sur le déroulement du cours (Eberly et al. 2005, 163).

En résumé, s’il contient tous les éléments attendus, le plan de cours est un document porteur pour le suivi des programmes de formation. On y retrouve à la fois de l’information sur les cibles définies et sur les contenus ainsi que sur les activités d’évaluation. Une utilisation rigoureuse et cohérente du plan de cours dans une unité d’enseignement peut concourir à améliorer le suivi.

Tableau de bord, cartographie de programme et plan de cours sont trois éléments qui contribuent à améliorer le suivi, en continu, des programmes de formation, que ce soit pour s’assurer de leur pertinence en regard du domaine ou du marché, ou pour des besoins d’évaluation.

La seconde partie de cet article présente un cas concret d’utilisation de ces trois éléments combinés au sein d’une méthodologie d’évaluation continue de programme.

Le cas de l’École de bibliothéconomie et des sciences de l’information

Depuis une dizaine d’années, l’École de bibliothéconomie et des sciences de l’information (EBSI) de l’Université de Montréal se penche sur la question de l’évaluation continue de son programme de maîtrise en sciences de l’information (MSI). Comme ce dernier est agréé par l’American Library Association (ALA), il est important d’en faire un suivi systématique pour le faire évoluer dynamiquement et pour pouvoir en rendre compte de manière efficace et efficiente. Bien que la méthodologie développée s’intéresse tout particulièrement à la MSI, elle s’applique aussi aux autres programmes de l’EBSI qui, même s’ils ne sont pas soumis au processus d’agrément, doivent demeurer pertinents puisqu’ils sont évalués par l’Université de Montréal.

Au fil des années, les réflexions sur le suivi de la MSI ont porté sur trois aspects principaux : (1) l’intégration d’un tableau de bord pour centraliser les principaux indicateurs; (2) l’évaluation des contenus des cours par le truchement de leurs objectifs et; (3) l’application de la cartographie de programme pour mesurer la cohérence du programme de MSI. Ces trois aspects sont détaillés dans les sections suivantes.

Tableau de bord

Au regard de la multitude des processus de suivi en place et des dimensions qui y sont mesurées, l’adoption d’un tableau de bord pour faciliter la gestion de l’évaluation du programme semble aller de soi. L’examen des différents processus fait ressortir la diversité des mécanismes implantés (Figure 3). On retrouve, entre autres, des évaluations récurrentes tout au long de l’année académique, dont les évaluations des cours à la fin de chaque trimestre, l’évaluation du programme en fin d’année universitaire, la réunion-bilan annuelle et le sondage auprès des diplômés. De plus, sur un cycle complet d’un programme, d’une durée de neuf ou dix ans, on effectue à mi-parcours la révision des objectifs de programme et un sondage auprès des milieux. Le tout mène, en fin de cycle, à la révision du programme.

Figure 3

Mécanismes de suivi du programme de MSI de l’EBSI

L’examen de ces mécanismes permet de faire ressortir la diversité des intervenants impliqués (étudiants, professeurs et chargés de cours, professionnels et personnel administratif, direction, diplômés et associations professionnelles), que ce soit sur une base individuelle ou comme membres de comités (par exemple, le comité des études, le comité de la maîtrise ou l’assemblée départementale). Ces intervenants peuvent agir comme sources de données sur certaines facettes du programme : les étudiants sont une source de données pour l’évaluation des cours par exemple. Ils peuvent également agir comme utilisateurs de données lorsque vient le temps de la prise de décision : la direction utilise les données, par le truchement d’instances décisionnelles, pour apporter des modifications au programme (Figure 4).

Figure 4

Intervenants impliqués dans les mécanismes de suivi du programme de MSI de l’EBSI

Un tableau de bord est nécessaire pour centraliser les principaux indicateurs qui sous-tendent entre autres ces différents mécanismes de suivi. Ce dernier se retrouve au coeur de la méthodologie en développement pour systématiser le suivi du programme de maîtrise (Figure 5).

Figure 5

Méthodologie de suivi du programme de MSI de l’EBSI

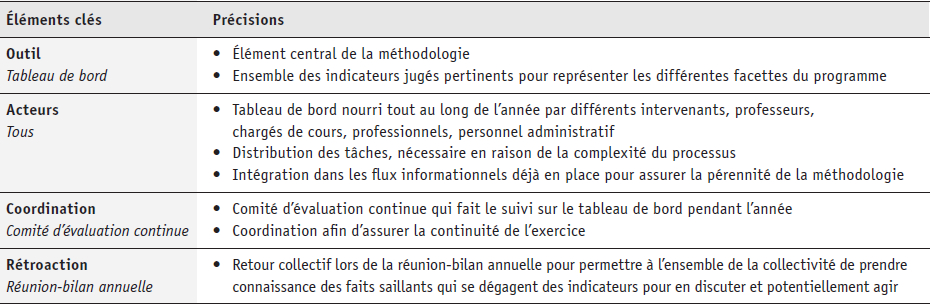

Quatre éléments clés s’y retrouvent : un outil, des acteurs, un mécanisme de coordination et de la rétroaction (Tableau 4).

Tableau 4

Éléments clés de la méthodologie de l’EBSI pour l’évaluation continue de la MSI

La rétroaction collective est un élément crucial dans cette démarche puisqu’elle ajoute une plus-value qualitative aux indicateurs :

[R]ecueillir des chiffres n’a que peu d’intérêt si la finalité de la démarche n’est pas une réflexion sur les processus et les pratiques. La démarche visant à recueillir des données quantitatives n’a donc pour autre but que de s’inscrire dans une visée qualitative.

Carbone 2002, 9

Cette méthodologie permet, par la centralisation des données nécessaires au suivi continu des programmes et par leur utilisation, d’appuyer le processus d’évaluation continue, d’obtenir une image complète et à jour du programme, de soutenir les discussions lors des réunions-bilans annuelles et de faciliter la préparation des rapports d’évaluation.

Quatre dimensions à couvrir ont été identifiées dans le tableau de bord lors de l’exercice récent du renouvellement de l’agrément du programme de MSI par l’ALA : les étudiants, les ressources humaines, les ressources matérielles et financières, et le curriculum (Figure 6). Pour chacune de ces dimensions, un inventaire des indicateurs permet d’identifier ceux qui sont pertinents au suivi, par exemple la répartition des charges d’enseignement et les profils de poste pour les ressources humaines, le nombre d’admis et leurs caractéristiques sociodémographiques pour les étudiants, les espaces et le budget pour les ressources matérielles et financières, et pour le curriculum, le type de cours et les milieux de stage.

Figure 6

Dimensions et exemples d’indicateurs identifiés pour le tableau de bord

La majorité des indicateurs sont des indicateurs factuels. Le défi est d’identifier où ils se trouvent et les personnes qui les rencontrent dans le cadre de leurs tâches habituelles et qui se chargeront de les consigner dans le tableau de bord. Le choix de la plateforme est aussi un élément important. Jusqu’à présent, les indicateurs ont été saisis dans des classeurs Excel comprenant à la fois les données ainsi que des métadonnées associées (auteur de la saisie, date de la mise à jour par exemple). Les données sont structurées afin d’en faciliter l’importation dans une plateforme intégrée pour la gestion d’un tableau de bord. Un exercice est en cours pour définir les caractéristiques attendues d’un tel environnement et évaluer certaines solutions proposées pour une éventuelle implantation.

Un autre indicateur qui est apparu important est celui de la cohérence du programme. Il constitue un défi méthodologique abordé, dans un premier temps, par le biais de l’analyse des objectifs des cours et, dans un deuxième temps, par l’intégration de la cartographie de programme. Ces deux étapes sont présentées dans les sections subséquentes.

Objectifs des cours

Les premières réflexions du groupe de travail sur l’évaluation continue du programme de maîtrise ont porté sur l’identification d’indicateurs permettant de rendre compte du contenu des cours[6]. Trois questions ont été identifiées :

Question 1 : Fait-on ce que l’on annonce faire?

Question 2 : Le programme est-il toujours pertinent par rapport à l’évolution de la discipline?

Question 3 : Le programme est-il toujours pertinent par rapport aux besoins du marché?

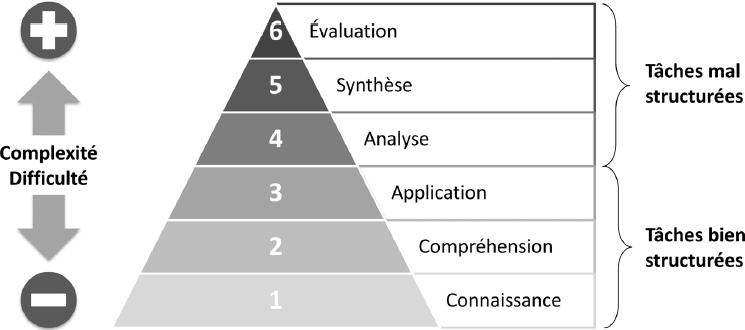

Sous-jacent à ces trois questions, se trouve le besoin de bien connaître ce qui est fait dans les cours. Depuis la révision de 1998 du programme de maîtrise, l’EBSI a adopté une approche par objectifs, centrée sur l’apprenant et ses apprentissages. Les objectifs des cours ont été identifiés comme matière première pour arriver, par leur analyse, à décrire ce qui est fait dans les cours. La taxonomie des objectifs d’apprentissage du domaine cognitif de Benjamin Bloom est utilisée pour qualifier le degré de complexité des objectifs. Cette taxonomie structure les objectifs en une hiérarchie à six niveaux augmentant en complexité et en difficulté, les objectifs des niveaux supérieurs ne pouvant être atteints si ceux des niveaux inférieurs ne le sont pas (Figure 7).

Figure 7

Taxonomie des objectifs d’apprentissage du domaine cognitif de Bloom (adaptation de Bloom & Krathwohl 1956-1964)

L’exercice de catégorisation des objectifs spécifiques à l’aide de la taxonomie de Bloom a été inséré à même un processus existant afin d’en garantir la pérennité, soit la mise à jour des plans de cours. Plusieurs facteurs appuient le choix des plans de cours à cette fin. Le principe d’une évaluation continue sous-entend que les méthodologies employées vont être adoptées sur une base durable et permanente. Un soin particulier doit être pris pour s’assurer que les systèmes mis en place résistent au passage du temps. Là où l’efficacité est de mise, ces méthodologies doivent exploiter au maximum les ressources présentes. De plus, elles doivent s’intégrer harmonieusement aux processus existants afin de minimiser la potentielle résistance au changement. L’effort de mise à jour est ainsi partagé entre les enseignants responsables des cours, les mieux placés pour évaluer de manière juste les objectifs de leurs cours en termes de complexité.

L’infrastructure recherchée pour soutenir cet exercice se devait d’être centralisée (pour rejoindre l’idée d’un tableau de bord regroupant les indicateurs), facile d’utilisation et accessible sur toutes les plateformes. Comme aucun système possédant ces caractéristiques pour la création, la mise à jour et la gestion des plans de cours n’a été trouvé, un système maison a été développé. Une architecture Web a été retenue afin d’éliminer la barrière des plateformes. L’utilitaire des plans de cours développé à ce moment consistait en un ensemble de formulaires Web sécurisés, une technologie familière aux internautes, connectés à une base de données Access par le truchement de pages ASP[7]. Cette solution permettait aussi de réutiliser facilement les informations, par exemple pour générer dynamiquement les plans de cours et les rendre accessibles sur le Web[8].

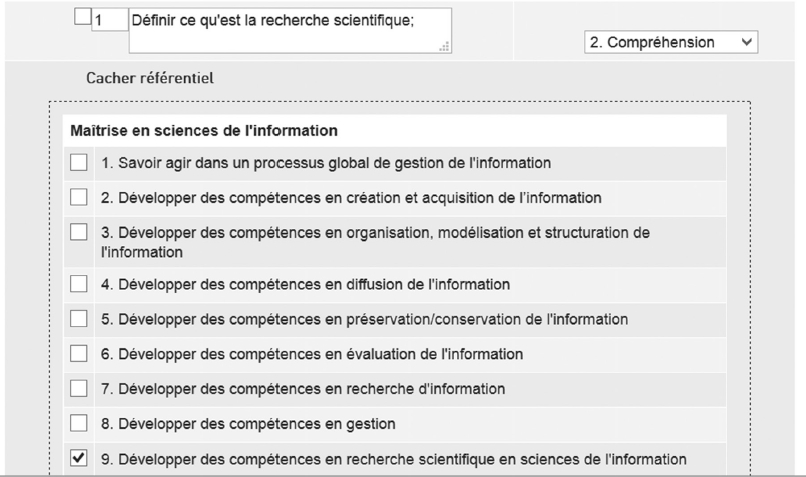

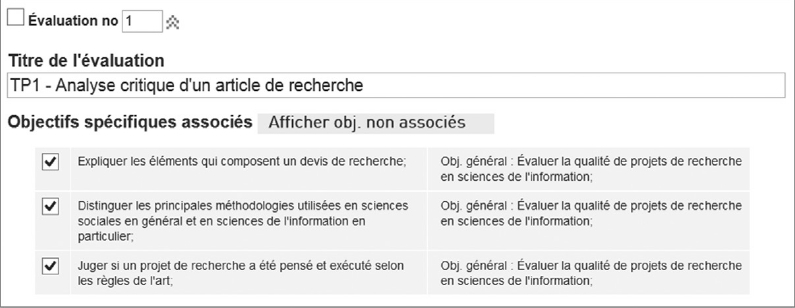

L’ensemble des sections d’un plan de cours peut être modifié par les responsables de cours. La section du plan de cours qui contient les objectifs permettait au départ, pour chacun des objectifs généraux et spécifiques, de l’associer à un niveau de la taxonomie. La version actuelle de l’utilitaire consiste à montrer, si désiré, le lien hiérarchique entre un objectif général et les objectifs spécifiques qui en découlent (Figure 8).

Figure 8

Interface pour l’édition des objectifs d’un cours dans l’utilitaire des plans de cours

L’analyse des niveaux de Bloom associés à chaque objectif assure la bonne articulation des cours du programme, les cours obligatoires de tronc commun visant par exemple des niveaux plus bas tandis que certains cours au choix atteignent des niveaux plus élevés. Deux projets pilotes ont permis de valider ce potentiel, mais ont aussi fait ressortir la principale difficulté de l’exercice. La qualité de la synthèse est en effet tributaire de la qualité des objectifs formulés. Or, la formulation d’objectifs d’apprentissage bien construits et l’utilisation correcte de l’échelle de Bloom ne sont pas des exercices faciles.

Pour que l’exercice soit porteur, il faut assurer un accompagnement régulier, notamment auprès des nouveaux enseignants. De plus, l’exercice n’est complet et utile que si le plus grand nombre participe. Il faut donc prévoir des stratégies pour préserver un bon taux de participation. L’intégration de nouvelles façons de faire à même les processus existants peut engendrer une certaine résistance. Si l’outil lui-même est perçu comme un obstacle, les chances d’en maintenir l’utilisation sur une base continue diminuent. Comme il est préconisé dans la littérature concernant l’implantation d’un changement technologique et organisationnel, différents mécanismes ont été mis en place pour en faciliter l’intégration aux pratiques, entre autres : s’assurer de l’adhésion des acteurs (Cadix & Pointet 2002), en particulier du soutien de la direction (Adams 2003), penser à une stratégie de communication appropriée et privilégier une approche anthropocentrée qui place les utilisateurs au centre du développement et de l’implantation (Cadix & Pointet 2002).

L’utilisation de la taxonomie de Bloom a été une première étape qui, par la mise en perspective des niveaux visés par les objectifs, cherchait à prendre en considération les objectifs de chaque cours dans la perspective globale du programme. L’étape suivante, soit l’intégration de la cartographie de programme, visait à élargir cette vision.

Cartographie de programme

En plus de considérer les objectifs de cours en eux-mêmes, la réflexion a été poussée plus loin pour trouver une manière de les mettre en relation les uns avec les autres afin de considérer le programme dans son ensemble et d’en évaluer la cohérence. Une version allégée des processus de cartographie proposés dans la littérature a été adoptée, ciblant trois types de curriculums, soit : (1) le curriculum prévu défini par les objectifs de programme; (2) le curriculum communiqué par l’examen des objectifs spécifiques de chaque cours et; (3) le curriculum évalué à travers les activités d’évaluation. Le plan de cours, déjà intégré dans les pratiques en raison de l’utilitaire développé, était la matière première logique à exploiter comme reflet du curriculum communiqué et du curriculum évalué. La proposition de Koppang (2004) et d’Uchiyama et Radin (2009) de construire des cartes n’a pas été retenue en raison de la charge de travail impliquée. L’exploitation des plans de cours, pratique systématisée par le biais de l’utilitaire développé, apporte une solution plus légère et plus porteuse pour une méthodologie implantée de manière continue.

Le maillage entre les trois curriculums devenait nécessaire pour mesurer la cohérence du programme : les objectifs de programme se déclinent en objectifs spécifiques dans les cours, et l’atteinte de ces objectifs est mesurée par les différents modes d’évaluation prévus (Figure 9). Il est ainsi possible de porter le regard sur la couverture des objectifs de programme au sein des cours qui y sont prévus et on peut valider la manière dont les apprentissages sont évalués.

Figure 9

Maillage entre le curriculum prévu, le curriculum communiqué par les objectifs et le curriculum évalué

Des modifications à l’utilitaire des plans de cours ont été apportées afin de permettre ce maillage :

un module a été ajouté afin d’y saisir un référentiel d’objectifs de programme;

le module de saisie des objectifs de cours a été modifié pour permettre aux enseignants d’associer les objectifs spécifiques à un ou plusieurs objectifs de programme (Figure 10);

Figure 10

Interface pour l’association des objectifs spécifiques aux objectifs de programme

un module supplémentaire a été défini pour permettre la saisie des activités d’évaluation et leur association aux objectifs spécifiques (Figure 11);

Figure 11

Interface pour l’association des évaluations aux objectifs spécifiques

différentes possibilités de visualisation des associations ont été implantées (Figure 12).

Figure 12

Visualisation des évaluations associées aux objectifs de programme

Une semaine de travail intensive a été organisée pour permettre à l’équipe des enseignants et des professionnels de s’attarder aux objectifs de programme. Cet exercice a permis d’établir collectivement – suivant la recommandation de Cuevas et al. (2009) et de Veltri et al. (2011) – 13 objectifs de programme que les enseignants ont eu la possibilité ensuite d’associer à leurs propres objectifs de cours. Suivant le processus proposé par Koppang (2004) et Uchiyama et Radin (2009), un retour collectif a été fait à la réunion-bilan annuelle pour discuter du portrait ainsi obtenu. Ce retour collectif est nécessaire, le maillage entre les objectifs de programme, les objectifs de cours et les évaluations ne pouvant réussir à eux seuls à décrire les apprentissages effectués.

Tout comme pour l’association des objectifs de cours à la taxonomie de Bloom, le talon d’Achille de cette approche réside, d’une part, dans la participation des enseignants et, d’autre part, dans la qualité des objectifs spécifiques ainsi que dans la compréhension partagée des objectifs de programme. Un suivi régulier est nécessaire pour maintenir les efforts des enseignants ainsi que pour faciliter la prise en main de cet environnement par les nouveaux enseignants.

Conclusion

Dans les institutions ayant pour mission la formation, l’importance de mettre en place des mécanismes d’évaluation continue afin de s’assurer que les programmes demeurent alignés à l’évolution des disciplines et pour en démontrer la pertinence, n’est plus à démontrer. Le défi est d’implanter des mécanismes pérennes ni trop intrusifs ni trop lourds à gérer. Pour y arriver, il faut privilégier des méthodologies s’imbriquant aux processus en place et bénéficier de la force collective par l’implication de tous les joueurs clés. La mise en place d’une structure de coordination ainsi que de moments de rétroaction collective sont deux stratégies importantes pour s’assurer de la continuité de l’évaluation et pour l’ancrer dans l’action. Tableaux de bord de gestion, cartographie de programme et plans de cours sont des outils et des méthodologies qui peuvent être mis à profit pour soutenir le suivi de programmes de formation. L’expérience de l’EBSI en démontre le potentiel, mais aussi les écueils à éviter. La participation de l’ensemble des acteurs est un des facteurs de réussite pour assurer à la fois pérennité et qualité à l’exercice de suivi en continu d’un programme. Enfin, il demeure important de développer des stratégies d’accompagnement pour faciliter cette participation.

Parties annexes

Notes

-

[1]

Pour plus d’information sur le processus d’agrément de l’ALA, voir l’article de Clément Arsenault dans le présent numéro.

-

[2]

Nos remerciements vont à Anne-Marie Duchesneau, étudiante à la maîtrise en sciences de l’information de l’EBSI, pour certaines informations sur les tableaux de bord extraites de sa recherche individuelle (SCI6850) faite sous notre supervision.

-

[3]

Le lecteur intéressé retrouvera le détail des calculs de ces indicateurs dans le Tableau 1 de l’article de Veltri et al. (2011, 35).

-

[4]

Ce service fait maintenant partie des Services de soutien à l’enseignement (SSE).

-

[5]

Voir le Guide d’élaboration d’un plan de cours du CEFES, <www.cefes.umontreal.ca/ressources/guides/Plan_cours/avant.htm>.

-

[6]

Plus de détails sur cette première réflexion peuvent être trouvés dans Dufour (2007).

-

[7]

L’utilitaire des plans de cours a évolué depuis vers une base de données MySQL et des formulaires en PHP pour des questions de stabilité ainsi qu’en raison de leur caractère libre.

-

[8]

Les plans de cours sont disponibles sur le site web de l’EBSI à l’adresse <cours.ebsi.umontreal.ca>.

Bibliographie

- Adams, John D. 2003. Successful change: Paying attention to the intangibles. OD Practitioner 35 (4) : 3-7.

- Appleby, Drew C. 1999. How to improve your teaching with the course syllabus. In Lessons Learned: Practical Advice for the Teaching of Psychology, sous la direction de Baron Perlman, Lee I. McCann & Susan H. McFadden. Washington, DC : American Psychological Society, 19-24.

- Bers, Trudy, Diane Davis & William Taylor. 1996. Syllabus analysis: What are we teaching and telling our students? Assessment Update 8 (6) : 1-2, 14-15.

- Bloom, Benjamin & David R. Krathwohl. 1956-1964. Taxonomy of Educational Objectives. Handbook 1: The Cognitive Domain. New York : Longman.

- Cadix, Alain & Jean-Marc Pointet. 2002. Le management à l’épreuve des changements technologiques : impacts sur la société et les organisations. Paris : Éditions d’Organisation.

- Carbone, Pierre (dir.). 2002. Construire des indicateurs et des tableaux de bord. Villeurbanne : Presses de l’enssib.

- Centre d’études et de formation en enseignement supérieur (CEFES). Guide d’élaboration d’un plan de cours. www.cefes.umontreal.ca/ressources/guides/Plan_cours/avant.htm (consulté le 4 mai 2015).

- Coker, Dana Rosenberg & Janice Nahra Friedel. 1991. The data collection matrix model: A tool for functional area and program evaluation. Research in Higher Education 32 (1) : 71-81.

- Cuevas, Nuria M., Alexei G. Matveev & Marvin D. Feit. 2009. Curriculum mapping: An approach to study the coherence of program curricula. Department Chair 20 (1) : 23-26.

- Daigle, Roy J., Herbert E. Longenecker Jr, Jeffrey P. Landry & J. Harold Pardue. 2004. Using the IS 2002 model curriculum for mapping an IS curriculum. Information Systems Education Journal 2 (1) : 3-6.

- Danielson, M. A. 1995. The role of course syllabi in classroom socialization. In Meeting of the Central States Communication Association, Indianapolis, IN.

- Dufour, Christine. 2007. L’évaluation continue de programme comme stratégie d’ajustement aux environnements disciplinaire et professionnel pour les écoles de bibliothéconomie et des sciences de l’information. In Partage de l’information dans un monde fragmenté : franchir les frontières. 35e Congrès annuel de l’Association canadienne des sciences de l’information (Montréal, Québec), sous la direction de Clément Arsenault & Kizim Dalkir. www.cais-acsi.ca/proceedings/2007/dufour_2007.pdf (consulté le 7 mai 2015).

- Eberly, Mary B., Sarah E. Newton & Robert A. Wiggins. 2001. The syllabus as a tool for student-centered learning. JGE: The Journal of General Education 50 (1) : 56-74.

- Eisenberg, Michael B. & Robert E. Berkowitz. 1988. Curriculum Initiative: An Agenda and Strategy for Library Media Programs. Norwood, NJ : Ablex Publishing Corporation.

- Hausman, Jerome J. 1974. Mapping as an approach to curriculum planning. Curriculum Theory Network 4 (2/3) : 192-198.

- Jacobs, Heidi Hayes (dir.). 2004. Getting Results with Curriculum Mapping. Alexandria, VA : Association for Supervision and Curriculum Development.

- Koppang, Angela. 2004. Curriculum mapping: Building collaboration and communication. Intervention in School and Clinic 39 (3) : 154-161.

- Landry, Jeffrey P., Roy J. Daigle, Herbert E. Longenecker Jr & J. Harold Pardue. 2009. IS 2002 and ABET accreditation: Meeting the ABET program outcome criteria. In Proceedings of the ISECON 2009. Washington, DC : EDSIG, 1534.

- Littlefield, V. M. 1999. My syllabus? It’s fine. Why do you ask? Or the syllabus: A tool for improving teaching and learning. In Society for Teaching and Learning in Higher Education, Calgary, Canada.

- Matejka, Ken & Lance B. Kurke. 1994. Designing a great syllabus. College Teaching 42 (3) : 115-117.

- Office of Teaching Effectiveness & Faculty Development. 1999. Launching a teaching system: A higher-level syllabus – 1. Nutshell Notes 7 (1). www.csuci.edu/facultynewsletter/documents/nnbootmaster.pm.pdf (consulté le 25 juin 2015).

- Parkes, Jay, Tracy K. Fix & Mary B. Harris. What syllabi communicate about assessment in college classrooms. Journal on Excellence in College Teaching 14 (1) : 61-83.

- Sallam, Rita L., Bill Hostmann, Kurt Schlegel, Joao Tapadinhas, Josh Parenteau & Thomas W. Oestreich. 2015. Magic Quadrant for Business Intelligence and Analytics Platforms. www.gartner.com/technology/reprints.do?id=1-2ADAAYM&ct=150223&st=sb (consulté le 4 mai 2015).

- Slattery, Jeanne M. & Janet F. Carlson. 2005. Preparing an effective syllabus: Current best practices. College Teaching 53 (4) : 159-164.

- Uchiyama, Kay P. & Jean L. Radin. 2009. Curriculum mapping in higher education: A vehicle for collaboration. Innovative Higher Education 33: 271-280.

- Veltri, Natasha F., Harold W. Webb, Alexei G. Matveev & Enrique G. Zapatero. 2011. Curriculum mapping as a tool for continuous improvement of IS curriculum. Journal of Information Systems Education 22 (1) : 31-42.

- Voyer, Pierre. 1999. Tableaux de bord de gestion et indicateurs de performance. 2e éd. Sainte-Foy : Presses de l’Université du Québec.

- White, Bruce A. & Richard V. McCarthy. 2007. The development of a comprehensive assessment plan: One campus’ experience. Information Systems Education Journal 5 (35) : 3-16.

- Willett, Timothy G. 2008. Current status of curriculum mapping in Canada and the UK. Medical Education 42 (8) : 786-793.

Liste des figures

Figure 1

Différentes facettes des plans de cours

Figure 2

Modèle de l’alignement pédagogique proposé par Claude Magnan (2003) et présenté par le CEFES[5] (notre adaptation)

Figure 3

Mécanismes de suivi du programme de MSI de l’EBSI

Figure 4

Intervenants impliqués dans les mécanismes de suivi du programme de MSI de l’EBSI

Figure 5

Méthodologie de suivi du programme de MSI de l’EBSI

Figure 6

Dimensions et exemples d’indicateurs identifiés pour le tableau de bord

Figure 7

Taxonomie des objectifs d’apprentissage du domaine cognitif de Bloom (adaptation de Bloom & Krathwohl 1956-1964)

Figure 8

Interface pour l’édition des objectifs d’un cours dans l’utilitaire des plans de cours

Figure 9

Maillage entre le curriculum prévu, le curriculum communiqué par les objectifs et le curriculum évalué

Figure 10

Interface pour l’association des objectifs spécifiques aux objectifs de programme

Figure 11

Interface pour l’association des évaluations aux objectifs spécifiques

Figure 12

Visualisation des évaluations associées aux objectifs de programme

Liste des tableaux

Tableau 1

Types de curriculum présentés par Cuevas et al. (2009) et Veltri et al. (2011)

Tableau 2

Processus de cartographie de programme « centré-sources de données » selon Veltri et al. (2011), inspiré de celui de Cuevas et al. (2009)

Tableau 3

Processus de cartographie de programme « centré-acteurs impliqués » selon Koppang (2004) et Uchiyama et Radin (2009)

Tableau 4

Éléments clés de la méthodologie de l’EBSI pour l’évaluation continue de la MSI