Résumés

Résumé

Il est reconnu que toute organisation qui souhaite se développer se doit d’évaluer ses employés afin de rester compétitive, de viser l’amélioration continue, de permettre le développement des compétences de ses individus, de retenir, de motiver et de mobiliser ses troupes. Toutefois, la littérature fait état du fait qu’actuellement, les systèmes et outils d’évaluation des compétences ne fonctionnent pas ou n’atteignent pas leur plein potentiel, car les organisations éprouvent souvent des problèmes majeurs dans leur élaboration, leur utilisation et leur gestion, rendant ainsi l’atteinte des objectifs de départ extrêmement difficile, voire impossible. Au terme d’une consultation où 57 chefs d’équipe de la fonction publique québécoise se sont prononcés, les constats vont dans le sens que le système d’évaluation multisource utilisé donne des retombées positives. En effet, ces chefs font état de 153 actions concrètes qui ont été entreprises à la suite de la réception de leur feedback, et ce, en vue de l’amélioration de leurs compétences puis de leur organisation. Une catégorisation de ces actions a été effectuée, jetant ainsi les bases de la recherche future dans le domaine de la gestion et du développement des compétences dans le secteur public.

Mots-clés :

- évaluation,

- feedback,

- compétences,

- gestion,

- multisource

Abstract

It is well recognized that any organization who wishes to develop must assess employees to remain competitive, aim at the continuous improvement, allow the development of the competencies, retain and motivate its forces. However, the literature states the fact that the systems and the evaluation tools of competencies do not reach their objectives or they do not reach their full potential because they experience major problems in their elaboration, use and management thus making the achievement of initial objectives extremely difficult or impossible. After a consultation where 57 leaders of the public administration of Quebec have responded, we notice that the system of multisource evaluation used gives positives effects, since 153 concrete actions were taken following the reception of their feedback in order to improve their competencies and the organization. A categorization of these actions was made, a primer in this domain.

Keywords:

- evaluation,

- feedback,

- competencies,

- management,

- multisource

Resumo

É reconhecido que toda a organização que deseja desenvolver-se deve avaliar os seus colaboradores para continuar competitiva, visar a melhoria contínua, permitir o desenvolvimento de competências dos indivíduos, reter, motivar e mobilizar as suas tropas. No entanto, a literatura confirma que, atualmente, os sistemas e instrumentos de avaliação de competências não funcionam ou não atingem o seu potencial, uma vez que as organizações experimentam grandes problemas na sua elaboração, utilização e gestão, o que torna muito difícil ou até impossível atingir os objetivos de partida. Na conclusão de uma consulta à qual 57 chefes de equipa da função pública do Quebeque responderam, constata-se que o sistema de avaliação multifontes utilizado tem efeitos positivos, na medida em que 153 ações concretas foram tomadas na sequência da receção do feedback no sentido da melhoria das suas competências e das da organização. Uma categorização destas ações foi realizada, lançando, assim, as bases da investigação futura no domínio da gestão e do desenvolvimento de competências no setor público.

Palavras chaves:

- avaliação,

- feedback,

- competências,

- gestão,

- multifontes

Corps de l’article

Introduction

L’évaluation des compétences est considérée comme étant un processus permettant la collecte et l’organisation de données en vue de les transmettre à un individu cible afin qu’il les utilise pour se développer et améliorer ses compétences puis, ultimement, contribuer au développement et à l’amélioration de l’organisation. La transmission d’un feedback dans ce contexte consiste en un échange de données concernant le statut et la qualité du produit du travail (Lee, 2006). Il correspond également à une source potentielle d’augmentation de la satisfaction et de la motivation au travail (DeNisi & Kluger, 2000). De fait, il est censé générer des attitudes positives et des intentions permettant de rehausser la performance. D’emblée, il semble que les individus répondent différemment au feedback (Beaulieu & Love, 2006). Par exemple, les hauts dirigeants d’entreprise ne réagissent pas de la même façon que leurs subordonnés. Également, les hauts dirigeants de la fonction publique ne réagissent pas non plus de la même façon que les hauts dirigeants d’une entreprise privée, ou comme la plupart des personnes évaluées en général (Brassard, 2009).

Le système de feedback multisource (FMS), dont fait partie le très reconnu feedback 360 degrés, s’avère une des pratiques innovatrices en matière d’évaluation des compétences. Il implique une collecte de données en provenance d’au moins deux sources, en vue de la transmettre à un individu cible sur une ou plusieurs dimensions de sa performance, dans un but d’amélioration des compétences individuelles et, par ricochet, d’une bonification de la performance organisationnelle. La littérature suggère plusieurs expressions pour parler de ce processus. En français, les expressions suivantes sont utilisées : « évaluation multisource », « évaluation 360-degrés », « feedback 360-degrés » et « feedback multisource ». Dans la littérature anglophone, les expressions : « 360-degree feedback », « multirater assessment », « multirater feedback », « multi-source assessment », « full-circle feedback » et « upward feedback » sont principalement employées. Une source est considérée comme étant toute personne disposant d’une perspective pertinente pour observer et apprécier une ou plusieurs dimensions de la performance du travailleur concerné, dont le travailleur lui-même. Il existe cependant certaines nuances à effectuer pour faire preuve de justesse dans l’utilisation des termes. Par exemple, il faut spécifier qu’une évaluation à 360 degrés est une évaluation multisource puisqu’elle prévoit faire le tour complet (le 360 degrés) des perspectives pertinentes pour évaluer la performance de l’individu cible. Elle fait donc partie de la famille des évaluations multisources puisqu’elle compte au moins deux sources évaluatives. En revanche, l’inverse n’est pas vrai puisque les évaluations multisources peuvent ne faire appel qu’à deux sources sans toutefois effectuer le tour complet des perspectives pertinentes disponibles. Dans le présent article, le terme « feedback multisource » (FMS) sera donc utilisé.

L’expansion des systèmes FMS dans les organisations remonte à une vingtaine d’années à peine. Toutefois, dans la littérature, il est possible de retracer les origines au cours des années 1960 (Brassard, 2009 ; Brutus & Derayeh, 2002; Hedge, Borman, & Birkeland, 2001; Smither, London, Flautt, Vargas, & Kucine, 2003). En revanche, son utilisation s’est rapidement propagée en raison de sa popularité et des avantages qu’il était permis d’en retirer (Atkins & Wood, 2002; Bailey & Fletcher, 2002; Bracken, Timmreck, Fleenor, & Summers, 2001; London & Smither, 1995). Il importe également de noter que les pratiques d’élaboration et d’utilisation de ces systèmes varient grandement d’une organisation à l’autre (Brassard & Pettersen, 2012; Healy, Walsh, & Rose, 2003).

La littérature stipule qu’un outil d’évaluation de type multisource, mis sur pied à des fins de développement des compétences et utilisé en tant que tel, peut contribuer à orienter l’évalué vers des intentions puis, vers la mise en oeuvre d’actions concrètes en vue du développement des compétences évaluées (Brassard & Pettersen, 2012). Pour ce faire, le but ultime de l’utilisation du FMS pour l’évaluation des compétences devrait cibler uniquement le développement de ces dernières. Ainsi, l’organisation devrait mettre l’accent sur la comparaison intrapersonne afin de sensibiliser l’individu cible sur les compétences à développer, et ce, selon trois perspectives, soit :

les compétences de type identitaire qui méritent la reconnaissance et que l’individu doit acquérir ;

celles de type potentiel dont une certaine maîtrise est reconnue et pour lesquelles l’individu devrait être encouragé à poursuivre le maintien et le développement et,

celles de type à améliorer pour lesquelles l’organisation doit diriger l’individu dans un processus de développement (Foucher, 2010).

Le principe à la base de ce type d’évaluation est que la multiplicité des sources résulte en une information plus fiable et plus complète, visant le travail, les comportements et les compétences individuelles (Antonioni & Woehr, 2001). Lorsqu’un individu reçoit de l’information concernant une ou plusieurs dimensions de sa performance en provenance de différentes sources, il s’attend à ce que cette information soit pertinente, précise, juste et honnête. Notons que dans le cadre d’un FMS, la validité des inférences faites à partir des données obtenues à l’outil mais, surtout la perception d’un bon niveau de cette validité s’avère presque aussi importante, ce qui signifie que l’évalué doit percevoir l’information comme étant valable et pertinente (Brutus & Brassard, 2011 ; Greguras, Ford, & Brutus, 2003). Par conséquent, si l’individu évalué attribue peu de valeur à l’information reçue, sa réaction risque de s’en trouver automatiquement affectée de manière défavorable.

Bon nombre d’organisations utilisent un système FMS. Cependant, chercheurs et utilisateurs s’interrogent à propos de son impact réel sur l’individu et sur l’organisation. Ce manque de résultats concluants engendre du scepticisme chez ceux qui l’utilisent de sorte que certains se questionnent sérieusement sur l’efficacité du système et décident tout simplement de l’abandonner après un certain temps (Balzer, Greguras, & Raymark, 2004; Brutus & Derayeh, 2002; DeNisi & Griffin, 2001; Timmreck & Bracken, 1997; Waldman & Atwater, 1998). Par conséquent, certains chercheurs précisent qu’il est temps de se demander dans quelles conditions et pour qui le FMS s’avère le plus bénéfique (Smither, Wohlers, & London, 1995). Plusieurs recherches en arrivent à des conclusions ou à des résultats contradictoires engendrant ainsi certains doutes (Balzer et al., 2004; Brutus & Derayeh, 2002; DeNisi & Griffin, 2001; Waldman & Atwater, 1998). De plus, la réaction de l’évalué est très peu étudiée (Albright-Funderburg & Levy, 1997; Brutus & Derayeh, 2002). Il en résulte qu’encore à ce jour, un questionnement persiste quant aux effets réels du FMS, puisqu’il s’agit d’un processus complexe dont plusieurs aspects se trouvent encore incompris (Berry, 2007 ; Brassard, 2009).

L’évaluation des compétences est considérée comme une pratique de gestion importante, mais délicate d’application. Il s’avère reconnu que cette pratique permet aux hauts dirigeants de mieux mesurer l’efficacité des individus dans leur situation de travail, y compris la leur. Toutefois, les organisations hésitent encore à se doter d’outils d’évaluation ou à exploiter ceux qui sont disponibles, soit par manque de ressources, soit par manque de connaissances sur le sujet. De nouvelles pratiques et de nouveaux systèmes émergent néanmoins. Dans le souci de répondre aux exigences ou aux critères de la compétitivité, les organisations ou les hauts dirigeants les utilisent tant bien que mal, sans en connaître toutes les incidences. La littérature va même jusqu’à dire que ces systèmes d’évaluation ne fonctionnent pas ou encore, ne donnent rien. Mais qu’en est-il en réalité ?

En ce sens, la présente étude a pour objectif de démontrer que l’utilisation d’un outil d’évaluation des compétences de type multisource peut contribuer à guider la personne évaluée vers la mise en place d’actions visant le développement de ses compétences et l’amélioration de l’organisation. Ainsi donc, il est à même de prétendre qu’il peut apporter une information utile dans un contexte où il n’existe pas, en principe, d’autres points de repère pour travailler au développement de ses compétences. En conséquence, la présente étude comporte deux objectifs interreliés, le second étant conditionnel au résultat du premier. Dans cette perspective, il vise à découvrir si des actions ont été entreprises à la suite de la réception du rapport de feedback issu du FMS en vue de développer ou d’améliorer ses compétences de gestion. Si tel est le cas, cela voudrait dire que le système d’évaluation multisource utilisé répond à son objectif et donne quelque chose. Le second objectif vise à s’assurer, s’il y a lieu, de la nature des actions entreprises en vue de l’amélioration des compétences à la suite de la réception du rapport d’évaluation. La connaissance de la nature de celles-ci permet ensuite de relever les actions entreprises, des les catégoriser puis d’en déterminer l’utilité.

Il faut toutefois préciser que dans la littérature, certains facteurs d’influence ou de non-influence d’actions subséquentes sont précisés pour l’entreprise à la suite de la réception d’un feedback en provenance de multiples sources, soit l’acceptation du feedback, le besoin de changement perçu ou encore la perception qu’un changement est possible (Brassard, 2009 ; Brassard & Pettersen, 2012). Par conséquent, certaines questions ont été adressées aux participants afin de faire ressortir une information pouvant justifier l’entreprise ou non d’actions. En somme, le présent article se concentre davantage à l’entreprise ou non d’actions et à la précision de la nature de celles mises en place en vue d’en effectuer une catégorisation. Il n’en existe aucune à ce jour dans la littérature concernant les chefs d’équipe de la fonction publique québécoise, alors qu’il en existe une concernant les chefs d’entreprise du secteur privé (Brassard & Pettersen, 2012).

Méthodologie

La population visée consiste en tout professionnel nouvellement chef d’équipe, c’est-à-dire oeuvrant depuis moins de deux ans dans un ministère ou un organisme, et qui participe à un programme de formation pour les fonctions de professionnel chef d’équipe de la fonction publique québécoise. Notons que la participation au programme d’évaluation est volontaire. Dans le cadre du programme, 199 personnes ont souhaité se faire évaluer par le biais du Profil de compétences gouvernementales 360-degrés (PCG-360º), outil d’évaluation multisource développé, géré et administré par le Service d’évaluation des compétences (SEDEC) de l’École nationale d’administration publique (ÉNAP). L’évaluation du participant (chef d’équipe) a été produite par dix personnes, à savoir un supérieur ; quatre employés, quatre pairs et l’évalué lui-même. Les évaluations terminées devaient être directement acheminées au SEDEC en vue de conserver l’anonymat des participants ; autrement, il aurait pu être facile d’identifier les évaluateurs dont quelques-uns sont les subordonnés de la personne évaluée. Par la suite, des employés du SEDEC procédaient à la compilation informatique des données puis à la formulation du feedback à transmettre à chacun des chefs d’équipe évalué. Après compilation et formulation du feedback, le rapport transmis à l’évalué comportait la moyenne des évaluations fournies par le chef lui-même, ainsi qu’une moyenne des évaluations produites par les autres évaluateurs. Les moyennes ainsi produites permettent d’effectuer une comparaison des données puis de mesurer les écarts de perception relatifs aux compétences de gestion soumises à l’évaluation. Subséquemment, une rencontre de rétroaction avait lieu quelques semaines après la réception du rapport de feedback, et ce, afin de guider les évalués vers des intentions d’actions et de les aider à se diriger vers des actions concrètes en vue du développement de leurs compétences.

Processus de sélection des sujets

L’échantillon comportait 57 participants issus d’une population de 199 personnes présentant les caractéristiques souhaitées. Les 199 personnes ayant été évaluées par le biais du PCG-360º ont été invitées à répondre à un questionnaire par le biais d’un courriel contenant le lien pour y accéder. Les questionnaires ont été expédiés au moins six mois après que la rencontre de transmission de feedback ait eu lieu, et ce, afin de permettre aux évalués d’envisager la possibilité d’entreprendre des actions concrètes. À l’automne 2011, après la première invitation électronique, deux relances ont été effectuées à dix jours d’intervalle chacune afin d’augmenter le taux de participation. Il s’agit donc d’un échantillon de convenance où 57 personnes se sont portées volontaires pour répondre, ce qui correspond à un taux de réponse de 28,6 %.

Outils utilisés

Rappelons que le PCG-360º s’avère l’outil multisource utilisé permettant l’évaluation complète des 19 compétences du Profil gouvernemental de compétences du personnel d’encadrement de la fonction publique québécoise (Secrétariat du Conseil du trésor, 2005). D’ailleurs, la liste de ces 19 compétences est répertoriée au tableau 1.

Tableau 1

Liste des 19 compétences du personnel d’encadrement de la fonction publique

Rappelons qu’il s’agissait d’un questionnaire en ligne comportant 42 questions auquel les participants étaient invités à répondre par le biais d’un courriel. L’objectif visé par l’élaboration d’un tel questionnaire : vérifier le bien-fondé du PCG-360º et, dans l’affirmative, préciser les actions mises en oeuvre par les chefs d’équipe évalués afin d’améliorer leurs compétences.

Résultats de l’étude

Il est à noter qu’un peu plus de la moitié des participants, soit 52,6 %, sont des femmes. L’âge médian des chefs d’équipe au sein de la fonction publique québécoise se situe parmi les 41 à 50 ans (voir tableau 2) alors que 42,2 % d’entre eux se distribuent de manière égale parmi les 31 à 40 ans et 51 à 60 ans. Ceci permet d’établir que peu de jeunes fonctionnaires issus des 21 à 30 ans deviennent chefs d’équipe en début de carrière. Notons également que les chefs d’équipe évoluent dans différentes sphères de l’administration publique par exemple, le secteur des finances, de l’éducation, de la santé et des services sociaux.

Tableau 2

Descriptif des participants selon l’âge

À la compilation des questionnaires, il est possible de constater que pour 94,7 % (n = 54) des participants, ceux-ci utilisent le programme de PCG-360º pour la première fois. Un nombre de 70,2 % des participants ont reçu leur rapport d’évaluation depuis moins d’un an (entre six mois et un an) alors que 29,8 % l’ont reçu depuis un an et plus.

La littérature mentionne que plusieurs facteurs peuvent influencer l’entreprise d’actions subséquentes à la réception d’un feedback de type multisource. C’est le cas, notamment, des motifs à la base de la volonté de se faire évaluer par son entourage. Or, il importe d’interroger les participants quant aux motifs sous-jacents à leur volonté d’utiliser le PCG-360º pour l’évaluation de leurs compétences de gestion afin de déterminer si les motifs quant à l’utilisation de cet outil peuvent contribuer à influencer l’entreprise d’actions subséquentes. Pour ce faire, il leur a été demandé de préciser les raisons pour lesquelles ils souhaitaient se faire évaluer par le biais de cet outil. À cet effet, la question suivante leur a été posée : « Quels objectifs pensiez-vous atteindre avec l’utilisation d’un tel outil ? ». Une liste de quatre motifs leur a été présentée et le participant devait indiquer sur une échelle allant de 0 à 4 (soit de « Pas du tout important » jusqu’à « Extrêmement important »), le degré d’importance de chacun des motifs présentés. Un espace était également prévu pour ajouter un ou plusieurs motifs si cela s’avérait requis. Le tableau 3 illustre les résultats concernant les motifs jugés comme étant « Très important » et « Extrêmement important » (niveaux 3 et 4) pour lesquels les participants disent avoir utilisé le programme PCG-360º. Les résultats montrent que les premiers motifs invoqués sont dirigés vers la connaissance des forces et faiblesses ainsi que vers l’amélioration des compétences ou des comportements. Sans pousser davantage l’analyse, à première vue, les motifs des participants vont dans le sens d’une intention d’amélioration ou vers le développement lui-même des compétences de gestion.

Tableau 3

Motifs invoqués pour utiliser le PCG-360º

D’autres facteurs peuvent contribuer à influencer l’entreprise d’actions (Brassard, 2009 ; Brassard & Pettersen, 2012). En outre, c’est le cas de l’acceptation du feedback (Jahawar, 2006), la perception d’un besoin d’amélioration ou le besoin de changement perçu (Maurer, Mitchell, & Barbeite, 2002) et la perception qu’un changement est possible, changement qui s’apparente au sentiment d’auto-efficacité tel que décrit par Bandura (2007). Une série de 20 questions ont été posées aux participants afin d’en apprendre davantage sur ces facteurs. Toutefois, cet aspect exige une investigation plus substantielle qui ne fera pas l’objet du présent article.

Par conséquent, en vue de répondre aux objectifs principaux de la présente étude, le questionnaire visait à savoir si, premièrement, les chefs d’équipe de la fonction publique québécoise participants avaient entrepris des actions en vue du développement ou de l’amélioration de leurs compétences de gestion à la suite de la réception de leur feedback et, deuxièmement, de quelle nature étaient ces actions entreprises. Afin d’y parvenir, la question suivante leur a été posée : « Depuis que vous avez reçu votre rapport d’évaluation, quelles sont les actions que vous avez entreprises pour améliorer vos compétences ou vos comportements de chef d’équipe ? ». Cette question ouverte permettait d’indiquer si de 0 à 5 actions avaient été entreprises, et de les nommer s’il y a lieu et ainsi, d’en connaître la nature. Ce questionnaire a été élaboré à l’aide du logiciel « Openfieldsystem » et les participants ont été invités à y répondre par courriel en cliquant sur le lien. Cette procédure permettait la compilation automatisée des résultats, réduisant ainsi les erreurs de transcription et augmentant la rapidité du traitement.

L’entreprise d’actions subséquentes au feedback

Voici comment se répartissent les réponses. C’est 51 des 57 participants qui disent avoir entrepris au moins une action à la suite de la réception de leur feedback (89,5 % des participants) ; 38 disent en avoir entrepris deux ; 21 trois ; 17 quatre, et 13 disent en avoir entrepris cinq, pour une moyenne approximative de trois actions entreprises par participants (n = 51). Une liste de ces actions a été dressée. Au total, 153 actions concrètes ont été entreprises. Toutefois, il est à préciser que 10,5 % des chefs ont mentionné n’avoir entrepris aucune action à la suite de la réception de leur feedback, ce qui demeure tout de même à considérer.

Catégorisation des actions

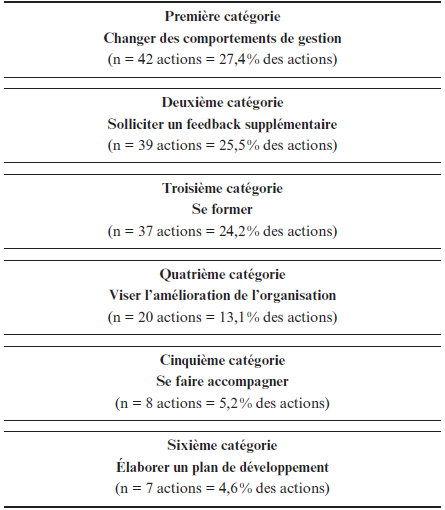

À partir de la liste des actions entreprises, une première catégorisation a été effectuée. Voyons maintenant de quelle nature sont ces actions. La littérature portant sur le sujet a déjà fait état d’une catégorisation d’actions amorcées par des chefs d’entreprises privées. D’ailleurs, celle-ci a servi de modèle de départ afin de dégager les différentes catégories d’actions déterminées et, ensuite, de classer les actions à partir de celles-ci (Brassard, 2009 ; Brassard & Pettersen, 2012). Six catégories distinctes sont représentées.

La première catégorie « Changer des comportements de gestion » touche directement les actions entreprises visant spécifiquement le développement des compétences ou le changement des comportements de chef d’équipe. L’analyse des réponses montre que 42 actions entreprises visent l’amélioration des compétences, ce qui représente au total 27,4 % des actions. À titre d’exemple, parmi ces actions on retrouve « Faire valoir avec enthousiasme la mission et les orientations de l’organisation » et « Planifier mes rencontres avec Outlook ».

Figure 1

Catégorisation des actions entreprises par les chefs d’équipe de la fonction publique

La deuxième catégorie a trait à « Solliciter un feedback supplémentaire ». Ces actions vont de la demande d’information additionnelle à une ou plusieurs personnes jusqu’au partage, avec l’équipe, des objectifs visant l’amélioration. Cette catégorie compte 39 actions pour un total de 25,5 % des actions entreprises.

La troisième catégorie touche à la formation soit « Se former ». Cette catégorie comporte des activités de recherche d’information qui consiste en l’ensemble des opérations, méthodes ou procédures ayant pour but d’extraire des données relatives à l’exercice de ses fonctions professionnelles. De plus, des activités de formation proprement dite y figurent qui, elles, correspondent à l’ensemble des connaissances théoriques ou pratiques acquises en vue d’une modification volontaire du comportement dans l’exercice de ses fonctions professionnelles. Ces activités comportent habituellement les phases de définition des objectifs en termes de comportement, de construction du programme, d’application du programme avec appel éventuel à diverses techniques de communication et de validation (p. ex., formation continue, formation d’appoint, formation à distance, formation aux adultes, formation professionnelle, formation en entreprise). À titre d’exemple, 24 chefs ont mentionné avoir fait des lectures supplémentaires pour leur développement. Également 13 autres se sont formés en assistant à des colloques, ateliers, séminaires ou formations diverses. Cette catégorie compte 37 actions soit 24,2 % des actions entreprises.

La quatrième catégorie « Viser l’amélioration de l’organisation » concerne une modification comportementale visant directement l’amélioration du service, du département ou de l’organisation en tant que telle. Par exemple, il est possible de constater que les actions entreprises portent sur deux aspects de l’organisation :

l’amélioration des processus de gestion et

l’amélioration de la communication organisationnelle.

Un nombre de huit actions portant sur le premier aspect sont répertoriées et 12 sur le second, pour un total de 20 actions soit 13,1 % des actions entreprises.

La cinquième catégorie d’actions « Se faire accompagner » porte sur la recherche d’une forme ou d’une autre de coaching ou d’accompagnement en vue du développement des compétences. Ainsi, huit chefs ont mentionné avoir eu recours à du coaching, à du mentorat ou à l’expertise d’un consultant, ce qui compte pour 5,2 % des actions.

La sixième catégorie d’actions entreprises à la suite de l’obtention du rapport de feedback a trait à « Élaborer un plan de développement ». Il est à même de penser qu’il s’agit là d’intention d’action, de réflexion ou d’intention de modification des attitudes, mais le fait de procéder à l’élaboration de ce plan ou à la formulation d’une intention peut être considéré comme une septième action en soi (London & Tornow, 1998). Ce sont sept actions entreprises en ce sens pour 4,6 % des actions entreprises.

Discussion

Rappelons que la participation au programme puis à la réponse au questionnaire de recherche sont volontaires. La présente étude visait à déterminer si un système d’évaluation de type multisource tel le PCG-360º fonctionne, c’est-à-dire, s’il contribue à propulser ses évalués vers l’amélioration pour ce qui est d’entreprendre des actions concrètes visant le développement des compétences de chef. À la lumière des résultats, comme premier constat, il ressort que l’évaluation 360º associée à la transmission du rapport de feedback génère des retombées positives et répond donc à son objectif de départ, soit l’amélioration subséquente. Il est donc possible de croire que le système d’évaluation de type 360º utilisé génère certainement des retombées positives quant à l’amélioration des compétences de chef d’équipe. De plus, le nombre de même que la nature des actions que les participants disent avoir entreprises permettent de croire que le processus d’évaluation multisource utilisé pour constituer le rapport de feedback, engendre réellement des intentions, puis des actions concrètes entreprises dans le sens du développement et de l’amélioration des compétences ou de l’organisation.

La littérature stipule également que les chefs se sentent souvent laissés à eux-mêmes quant au développement de leurs compétences. Le fait de leur donner la possibilité d’être évalués, de s’évaluer et d’en discuter, lors d’une rencontre de transmission de rétroaction effectuée par un tiers neutre, agit peut-être comme une forme de coaching ou d’accompagnement permettant de passer au-delà des intentions et de favoriser la propulsion vers des actions concrètes permettant le développement réel des compétences.

En somme, la catégorisation des actions issue de la présente étude permet de faire le point sur les compétences principales ciblées pour le développement dans le cadre de l’exercice d’une fonction de chef d’équipe dans la fonction publique québécoise. Le fait de procéder à la catégorisation des actions permet non seulement de préciser la nature des actions entreprises mais aussi l’ampleur de cette entreprise dans chacune des catégories d’actions. Un constat ressort à l’effet que même s’ils sont chefs dans la fonction publique, bon nombre visent tout de même précisément l’amélioration subséquente de l’organisation (13,1 %). Une étude subséquente pourrait toutefois compléter le présent article et analyser plus en profondeur quels pourraient être les facteurs qui justifient davantage l’entreprise d’actions chez les chefs d’équipe de la fonction publique québécoise.

Limites de l’étude

Notons que certaines limites de l’étude doivent toutefois être considérées. D’abord, il faut mentionner que la taille de l’échantillon justifie le fait de faire preuve de prudence quant à l’analyse des résultats et à la généralisabilité de ceux-ci. En effet, seuls 57 des participants volontaires au dispositif d’évaluation multisource sur 199 ont choisi de répondre au questionnaire de suivi. Le choix de non-réponse peut donc être considéré comme étant important. Il faut se questionner sur le fait qu’il existe peut-être un lien entre le choix de non-réponse et l’absence d’actions entreprises subséquemment à la réception du feedback. Toutefois, il demeure que ceux qui ont répondu relèvent un bon nombre d’actions entreprises. En conséquence, il devient hasardeux d’affirmer, sans aucun doute, que le système FMS « fonctionne vraiment » dans le sens du déclenchement d’actions de développement des compétences sur la base des réponses produites par un échantillon « de convenance » comportant moins d’un tiers des utilisateurs du dispositif. Il importe cependant de noter que les résultats obtenus vont dans le sens de ce que la littérature relève sur le sujet. De plus, cette tentative de catégorisation des actions jette les bases à la recherche future dans le domaine.

La littérature mentionne toutefois qu’il se peut que le simple fait d’avoir été évalué et d’avoir reçu un rapport de feedback ait déclenché l’entreprise d’actions. Il se peut également que des actions soient déployées dès la fin de la réponse au questionnaire, avant même la réception du feedback, puisque l’étendue des sujets discutés dans le PCG-360º oblige le chef d’équipe à s’arrêter pour évaluer un grand nombre de décisions pour lesquelles il doit adopter un comportement particulier, alors qu’il peut parfois ne pas s’en rendre compte. Or, dans la période où le chef d’équipe procède à son autoévaluation, il se doit de faire le tour de l’ensemble de ses actions ou de ses comportements ou de ses décisions de gestion. En soi, cela pourrait déjà constituer une prise de conscience de certains comportements à modifier ou de certaines actions à entreprendre et ce, bien avant la réception du rapport de feedback. Cela entraînerait donc une diffusion des actions dont le début ne se trouve pas à la réception du rapport, mais bien avant.

L’objectif premier ne visait pas la détermination des facteurs d’influence de l’entreprise d’actions tels l’acceptation du feedback, le besoin de changement perçu ou encore le sentiment d’autoefficacité mais plutôt, de déterminer s’il y avait entreprise ou non d’actions et de quelle nature étaient ces actions. Or, une recherche future devra certainement se pencher sur les facteurs pouvant faire varier cette entreprise d’actions de manière plus approfondie que ce qui a été effectué dans le cadre de la présente étude.

Conclusion

La présente étude permet de retenir qu’un processus d’évaluation de type multisource peut fonctionner et donner quelque chose de positif, puisqu’il en ressort que les participants disent entreprendre des actions concrètes en vue de l’amélioration de leurs compétences de gestion à la suite de la réception du rapport de feedback en découlant. De plus, ces actions s’avèrent en nombre assez suffisant pour en effectuer une catégorisation, permettant ainsi de jeter les bases à la recherche future portant sur le développement des compétences de gestion des chefs d’équipe de la fonction publique.

Bien qu’il s’agisse d’une recherche menée auprès de chefs d’équipe de la fonction publique québécoise, il demeure intéressant d’effectuer une comparaison en vue de déterminer si les chefs d’équipe du secteur privé réagissent de la même manière que ceux de la fonction publique, pour ce qui est de la quantité et de la nature des actions entreprises à la suite d’un processus d’évaluation de type multisource. Par conséquent, une comparaison pourrait également être effectuée dans le cadre d’un article subséquent en vue d’en relever les distinctions.

Enfin, la recherche future devrait certainement se pencher sur les variables ou facteurs qui déterminent ou influencent l’entreprise d’actions ainsi que sur ceux qui déterminent ou influencent la nature des actions. Ainsi, il sera possible de mettre en place les conditions favorisant cette entreprise d’actions afin de mieux diriger les efforts vers le développement efficace des compétences.

Parties annexes

Note

-

[1]

Adaptation de définitions fournies par l’Office de la langue française.

Références

- Albright-Funderburg, S., & Lévy, P. E. (1997). The influence of individual and contextual variables on 360-degree feedback system attitudes. Group and Organization Studies, 22(2), 210-235.

- Antonioni, D., & Woehr, D. J. (2001). Improving the quality of multi-source rater performance. In D. W. Bracken, C. W. Timmreck, & A. H. Church (Eds.) The handbook of multi-source feedback (pp. 114-129). San Francisco, CA: Jossey-Bass.

- Atkins, P. W. B., & Wood, R. E. (2002). Self-versus-others’ ratings as predictors of assessment center ratings: validation of evidence for 360-degree feedback programs. Personnel Psychology, 55(4), 871-904.

- Bandura, A. (2007). Auto-efficacité : Le sentiment d’efficacité personnelle. Paris, France : De Boeck.

- Bailey, C., & Fletcher, C., (2002). The impact of multiple source feedback on management development: findings from a longitudinal study. Journal of Organizational Behavior, 23, 853-867.

- Balzer, W. K., Greguras,G. J., & Raymark, P.H. (2004). Multisource feedback. In J. C. Thomas (Ed.). Comprehensive Handbook of Psychological Assessment, 4 (pp. 390-411). Hoboken, NJ: Wiley.

- Beaulieu, R. P., & Love, K. G. (2006). The impact of level of performance on feedback strategy. Performance Improvement Quaterly, 19(1), 67-82.

- Berry, M. (2007). 360-degree feedback analysis reveals manager shortcomings. Personal Today, May, 6.

- Bracken, D. W., Timmreck, C. W., Fleenor, J. W., & Summers, L., (2001). 360-degree feedback from another angle. Human Resource Management, 40(1), 3-20.

- Brassard, N. (2009). Réactions du chef de PME après utilisation d’un système d’évaluation multi-source, thèse de doctorat non publiée, Université du Québec à Trois-Rivières, Trois-Rivières, Québec.

- Brassard N., & Pettersen, N. (2012). Démarches des dirigeants de PME pour améliorer leurs compétences à la suite d’une évaluation multisource. Journal of Small Business and Entrepreneurship, 25(3), 349-356.

- Brutus, S., & Derayeh, M., (2002). Multi-source assessment programs in organizations: an insider’s perspective. Human Resource Development Quarterly, 13(2), 187-202.

- DeNisi, A. S., & Griffin, R. W. (2001). Human Resource Management. Boston, MA: Houghton Mifflin.

- DeNisi, A. S., & Kluger, A. N. (2000). Feedback effectiveness: Can 360-degree appraisals be improved? The Academy of Management Executive, 14(1), 129-139. doi: 10.5465/AME

- Foucher, R. (dir.) (2010). Tome 1 : Fondements de la gestion des talents et des compétences, Montréal, Québec : Éditions Nouvelles.

- Greguras, G. J., Ford, J. M., & Brutus, S. (2003). Manager attention to multisource feedback. Journal of Management Development, 22(4), 345-361.

- Healy, M. C., Walsh, A. B., & Rose, D. S. (2003, Summer). A benchmarking study of North American 360-degree feedback practices. Paper presented at the Annual conference of the Society for Industrial and Organizational Psychology (18th), Orlando, FL.

- Hedge, J. W., Borman, W. C., & Birkeland, S. A., (2001). History and development of multi-source feedback as a methodology. In D. W. Bracken, C. W. Timmreck, & A. H. Church (dir.) The handbook of multi-source feedback (pp. 15-32). San Francisco, CA: Jossey-Bass.

- Jahawar, I. M. (2006). An investigation of potential consequences of satisfaction with appraisal feedback. Journal of Leadership and Organizational Studies, 13(2) 14-28.

- Lee, C. D., (2006). Feedback, not appraisal. Human Relations,51, 111-114.

- London, M., & Smither, J. W. (1995). Can multi-source feedback change perceptions of goal accomplishment, self-evaluations, and performance-related outcomes. Theory-based applications and direction for research. Personnal Psychology, 48(4), 803-839.

- London, M., & Tornow, W. W. (1998). 360-degree feedback- more than a tool! In M. London & W. W. Tornow (Eds.). Maximizing the value of 360-degree feedback (pp. 1-8). Greensboro, NC: Center for Creative Leadership.

- Maurer, T. J., Mitchell, D. R. D., & Barbeite, F. G. (2002). Predictors of attitudes toward a 360 degree feedback system and involvement in post-feedback management development activity. Journal of Occupational and Organizational Psychology, 75(1), 87-107.

- Secrétariat du Conseil du trésor, Directions des communications (2005). Profil gouvernemental de compétences du personnel d’encadrement. Québec, QC : Secrétariat du Conseil du trésor.

- Smither, J. W., London, M., Flautt, R., Vargas, Y., & Kucine, I. (2003). Can working with an executive coach improve multi-source feedback ratings over time? A quasi-experimental field study. Personnel Psychology, 56(1), 23-44.

- Smither, J. W., Wohlers, A. J., & London, M. (1995). A field study of reactions to normative versus individualized upward feedback. Group and Organization Management, 20(1), 61.

- Timmreck, C. W., & Bracken, D. W. (1997). Multi-source feedback: A study of its use in decision making. Employment Relations Today, 24(1), 21-27.

- Waldman, D. A., & Atwater, L. E. (1998). The power of 360-degree feedback: how to leverage performance evaluations for top productivity. Houston, TX: Gulf.

Liste des figures

Figure 1

Catégorisation des actions entreprises par les chefs d’équipe de la fonction publique

Liste des tableaux

Tableau 1

Liste des 19 compétences du personnel d’encadrement de la fonction publique

Tableau 2

Descriptif des participants selon l’âge

Tableau 3

Motifs invoqués pour utiliser le PCG-360º