Résumés

Résumé

Le texte étudie les changements intervenus en trente-cinq ans dans la politique de lutte contre la pollution atmosphérique en France. Notre approche privilégie l’analyse des instruments (réglementaires, techniques et scientifiques) en caractérisant à la fois leurs effets propres et la mobilisation des acteurs qui en préconisent l’utilisation. Les transformations sont étudiées en quatre phases : la première part de l’approche réglementaire du problème, la deuxième traite de ses critiques à partir de l’intrusion de nouveaux instruments de mesure, la troisième montre l’impact de la combinaison de nouveaux instruments juridiques et épidémiologiques, la quatrième est centrée sur le processus de stabilisation récent où s’est imposée une nouvelle catégorisation du problème public et des réseaux d’acteurs en charge de sa gestion. Les instruments ont joué un rôle central dans cette dynamique en objectivant le phénomène, en fournissant une grille d’interprétation des causes et en orientant le choix des mesures de gestion. En cela ils sont d’excellents traceurs des changements.

Abstract

This article analyzes the changes that occurred during the past thirty-five years in the field of public policies dealing with atmospheric pollution control in France. Our approach is based on the analysis of the instruments of public policy : regulation, techniques, and scientific innovations. We concentrate on both the effective results of these instruments and the mobilization of actors involved in policy design. Changes are studied from four different angles. We start with the regulatory approach of the problem, we reveal its main critics, and then we try to show the impact of the combination of new legal and epidemiological instruments. Finally, we focus our attention on the recent process of stabilization where a new categorization of public problems and actor networks have been imposed in the management of air quality. Instruments played a central role in this dynamics by objectifying the phenomenon, by providing an interpretation grid of the causes, and by directing the choice of management measures. In that respect they are excellent indicators of change.

Corps de l’article

Le présent article s’inscrit dans un courant de recherche sur l’action publique qui s’attache à la caractérisation et à la compréhension des changements observés sous l’angle des instruments (des techniques de régulation). Cette approche considère en effet que les instruments constituent une dimension aussi déterminante dans les changements observables que les intérêts et les mobilisations des acteurs, leur organisation et leurs croyances. En suivant la diversification des instruments d’action publique utilisés dans la politique de lutte contre la pollution atmosphérique depuis trente-cinq ans, nous pensons pouvoir saisir les principaux ressorts des transformations observées, en France comme dans beaucoup de pays industrialisés. Bref, la conception initiale du risque (datant du xixe siècle), qui voyait dans cette pollution une externalité industrielle techniquement traitable, a été reconfigurée dans les années 1990 en risque de santé publique à impact épidémiologique majeur et corrélé aux effets des moyens de transport (routier principalement)[1]. Au-delà des discours officiels et des multiples justifications tant technico-scientifiques que politiques, l’approche par les instruments permet de mieux cerner ces transformations de la pollution atmosphérique en tant que problème public, ainsi que les modifications intervenues dans les réseaux d’acteurs et les actions menées.

On reconnaît que le domaine de « l’environnement » est un secteur d’action publique particulièrement propice à l’expérimentation de nouveaux instruments d’intervention (du classement d’espèces et de sites aux marchés de droit à polluer)[2]. Ce foisonnement, par ailleurs plus sensible que dans d’autres secteurs, s’explique de deux façons principales. Tout d’abord, lors de leur émergence comme enjeux publics, les questions environnementales étaient peu ou mal réductibles à d’autres enjeux déjà structurés. Le transfert de solutions préexistantes était souvent insatisfaisant. Ensuite, chaque enjeu environnemental était porteur d’une complexité particulière basée sur la coexistence de dimensions scientifiques, techniques, économiques, sociales et politiques qu’il fallait coordonner. Les arbitrages nécessaires se prêtaient peu aux formes classiques d’action réglementaire ou fiscale. L’innovation dans les dispositifs de régulation était une nécessité liée aux incertitudes et aux contraintes multiformes de ces enjeux[3]. Les démarches contemporaines du développement durable confirment amplement cette dynamique[4].

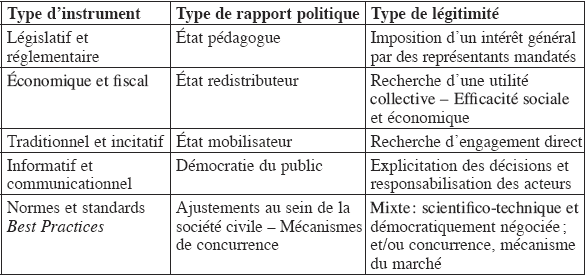

L’instrumentation de l’action publique, c’est-à-dire le choix et les usages des techniques de régulation et des modes d’opérer, est une question qui est souvent un impensé de la sociologie politique. Elle est traitée soit comme une notion d’évidence (gouverner, c’est réglementer, taxer, contracter…), soit comme une activité relevant d’une simple rationalité de moyens sans portée autonome. Les instruments sont alors considérés comme disponibles et ne posent que des questions d’adéquation aux objectifs retenus[5]. Les travaux pionniers de Christopher Hood, de Staffan Linder et B. Guy Peters, de Michael Howlett et de Michael Howlett et M. Ramesh ont montré l’importance décisive de la question des instruments dans la définition du policy design et ont mis l’accent sur leur dimension cognitive ainsi que leur impact sur la mise en oeuvre[6]. Des travaux anglo-saxons et allemands ultérieurs ont intégré la question des instruments dans la réflexion sur la gouvernance des réseaux d’action publique, en faisant ressortir les problèmes posés par la coexistence d’instruments au sein des mêmes politiques, mises en place de façon souvent désordonnée, et les difficultés de coordination qui en découlent[7]. De façon complémentaire, nous avons développé une approche plus interniste qui prend appui sur la sociologie des sciences et s’attache aux propriétés techniques et politiques des instruments et à leur capacité à générer des effets propres, au-delà des intentions des décideurs. Une première série de travaux novateurs en sociologie des organisations industrielles porte, depuis les travaux de Karl E. Weick, sur le rôle des outils de gestion[8]. Dans le même sens, Alain Desrosières a montré comment la production statistique véhicule un langage commun et des représentations qui créent des effets de vérité et d’interprétation du monde s’imposant à tous les acteurs et naturalisant les situations sociales qu’elle saisit[9]. Cette approche a pu être élargie à un ensemble d’instruments d’action publique, en rompant avec l’illusion de leur neutralité et en spécifiant les effets et les problèmes de légitimité de chacun[10]. Les instruments d’action publique ne sont pas inertes ; librement disponibles pour des mobilisations sociopolitiques, ils détiennent une force d’action autonome. Ils ne sont pas réductibles à de la pure technique, ils produisent des effets indépendants des objectifs affichés (des buts qui leur sont assignés), ils structurent en partie l’action publique selon leur logique propre et reposent sur une conception spécifique du rapport gouvernant / gouverné. Pour préciser cela, il convient de s’attacher à la dynamique spécifique de l’instrumentation. Mais avant, faisons un point de définition. Appliquée à l’action publique, nous retiendrons comme définition de travail de l’instrument qu’il est : un dispositif technique à vocation générique porteur d’une conception concrète du rapport politique / société et soutenu par une conception de la régulation. Il est possible de différencier les niveaux d’observation en distinguant instrument, technique et outil. L’instrument est un type d’institution sociale (le recensement, la cartographie, la réglementation, la taxation), la technique, un dispositif concret opérationnalisant l’instrument (la nomenclature statistique, le type de figuration graphique, le type de loi ou de décret), et l’outil, un microdispositif au sein d’une technique (la catégorie statistique, l’échelle de définition de la carte, le type d’obligation prévu par un texte, une obligation prévue par un texte, une équation calculant un indice).

Sur la base des travaux déjà effectués, nous pouvons relever trois principaux effets de l’instrument.

Tout d’abord, l’instrument crée des effets d’agrégation. Il constitue un point de passage obligé et participe à ce que Michel Callon nomme les activités de traduction qui permettent à des acteurs hétérogènes de se retrouver dans un réseau sur des questions qu’ils acceptent de travailler en commun[11]. Cet apprentissage exige de la part des acteurs engagés des déplacements, des détours par rapport à leur conceptualisation initiale. Corrélativement, l’instrument crée des effets d’inertie qui expliquent une grande part de la résistance au changement et aux pressions extérieures (conflits d’intérêts entre acteurs-utilisateurs, impacts des changements politiques globaux). Nous montrerons comment, à partir des obligations de mesure de la pollution atmosphérique, des obligations d’information du public et de la constitution des réseaux de surveillance d’origine associative, a été construit un « acteur-réseau[12] » qui tient aujourd’hui une place centrale dans la définition de la politique et de ses changements.

Ensuite, l’instrument est producteur d’une représentation spécifique de l’enjeu qu’il traite ; il a en ce sens un effet cognitif direct. Il impose des définitions communes des faits sociaux basées sur des conventions et fournit une grille de catégorisation. Nous montrerons la façon dont des mesures de la pollution atmosphérique se sont imposées et comment un indice unique a progressivement été négocié (ATMO)[13]. Cet indice a fortement évolué dans ses composants et dans les pondérations qui sont faites entre eux. C’est pourquoi il constitue un artefact qui donne une représentation de l’état de la pollution atmosphérique sous une forme agrégée qui, pour être simplificatrice, n’en tient pas moins un rôle central dans la communication que cet indice permet sur le risque à un moment donné.

Enfin, l’instrument induit une problématisation particulière de l’enjeu dans la mesure où il hiérarchise des variables et peut aller jusqu’à induire un système explicatif. Le calcul de moyennes et de pondération et la recherche de régularités ont induit des systèmes d’interprétation causaux qui se présentent toujours comme justifiés par la science. Nous montrerons comment les outils de gestion de la pollution atmosphérique, en particulier par l’information et l’alerte, permettent de repérer d’autres effets de problématisation. Il y a là également un effet cognitif indirect de l’instrument.

Nous allons raisonner ici à partir d’un instrument d’information et de communication qui fait partie de ce que l’on nomme commodément les « nouveaux instruments d’action publique » qui ont été développés en complément et parfois comme alternative aux instruments classiques du type command and control. Afin de préciser la place des instruments dans les technologies de gouvernement, nous proposons avec Patrick Le Galès d’en différencier les formes et de distinguer cinq grands modèles. Cette typologie s’appuie en partie sur celle de C. Hood qui se fondait sur les ressources mobilisées par les autorités publiques (modality, authority, pressure, institution)[14]. Nous l’avons reformulée et complétée en tenant compte des types de rapport politique organisés par les instruments et des types de légitimité sur lesquels ils reposent.

Les instruments « communicationnel et informatif » s’inscrivent dans le développement de ce que l’on nomme en général la « démocratie du public » ou « de l’opinion », où l’espace public s’autonomise de la sphère politique traditionnelle. La source peut être trouvée dans un deuxième âge de la démocratie où la définition du bien commun ne relève plus du seul monopole des gouvernants légitimes. Cette perspective a été analysée par Bernard Manin qui montre que l’offre politique est de plus en plus reliée aux demandes du public[15]. Celles-ci sont d’autant plus fortes que s’affirme une « liberté de l’opinion publique[16] » distincte des clivages partisans classiques. L’information publique devient ainsi un enjeu considérable qui permet d’orienter les demandes et « les termes du choix ». Pour ma part, j’ai cherché à caractériser le couple « droit à l’information / obligation d’informer » comme un nouvel « arcane du pouvoir ». L’exercice du pouvoir s’est effectué pendant longtemps par le prélèvement et la centralisation d’informations qui guident les décisions politiques, mais restent le monopole des autorités publiques. Avec le développement des États-providence, de leur interventionnisme et du néo-corporatisme, l’interpénétration croissante des espaces publics et privés a rendu nécessaire un assouplissement des rapports gouvernant / gouverné. Sous couvert de « modernisation », de nouveaux instruments « participatifs » s’efforcent d’assurer une meilleure fonctionnalité de la gestion publique en créant une subjectivation croissante des rapports politiques et la reconnaissance de « droits–créances » des citoyens vis-à-vis de l’État. Une nouvelle relation est alors établie entre droit à l’expression politique et droit à l’information. Après avoir organisé des droits d’accès nécessitant un rôle actif du citoyen, l’État a mis en place diverses obligations d’informer (information required ou mandatory disclosure[17]) qui pèsent sur le détenteur, qu’il soit public (ex. : catastrophes naturelles) ou privé (ex. : industrie chimique). L’objectif recherché est double : d’une part, assurer l’information du public sur des situations de risque ; d’autre part, exercer une pression normative sur l’émetteur en l’incitant à mieux cadrer ses pratiques. De façon plus large, Giandomenico Majone, dans sa réflexion sur les nouvelles formes de régulation, estime que les agences européennes tendent de plus en plus à substituer à la régulation réglementaire command and control une régulation par l’information qui privilégie la persuasion[18].

Notre démonstration porte sur la généalogie et les effets de la mise en oeuvre d’un instrument d’information en matière de lutte contre la pollution atmosphérique qui a reconfiguré cet enjeu social. Nous procéderons en quatre étapes : la première situe le point de départ du processus et le premier effort de réforme politique par la loi de 1961 ; la deuxième montre le développement dans le courant des années 1970 d’initiatives locales mettant en cause l’approche étatique et se dotant de nouveaux instruments autonomes de mesure ; la troisième concerne les années 1990 avec la conjonction de nouvelles contraintes instrumentales d’origine européenne (obligations d’informer le public) et l’entrée en scène de nouveaux acteurs qui utilisent des techniques scientifiques spécifiques (épidémiologiques) ; enfin, la quatrième illustre la période de stabilisation en cours depuis la fin des années 1990 avec la redéfinition de la pollution atmosphérique comme question de santé publique et le développement continu de techniques d’évaluation de ce type d’impact. Nous formulons l’hypothèse que cette dynamique a été portée en très grande partie par des réseaux-acteurs constitués autour des instruments d’objectivation tant de la pollution que de ses effets sanitaires.

Astuces et limites d’un outil réglementaire

En France les externalités industrielles sont traitées, depuis le début du xixe siècle (1810), par une technique judicieuse d’autorisation administrative accordée aux propriétaires d’établissements industriels (initialement nommés « incommodes et insalubres ») dits « établissements classés[19] ». Le gain principal de cet instrument réglementaire est de substituer, en cas de contestation (dommages chroniques ou dus à un accident), l’autorité administrative (source de l’autorisation) à l’acteur économique. Avant d’obtenir réparation, le plaignant doit d’abord contester l’autorisation administrative accordée (ou démontrer sa violation). En échange de ce système de limitation des contentieux, les manufacturiers sont censés prendre un certain nombre de mesures pour limiter leurs rejets ; on ne s’attache alors qu’aux aspects les plus visibles : les fumées et les odeurs. Si le texte de réforme de la législation sur les installations classées de 1917 est d’inspiration hygiéniste, il ne change rien de fondamental à l’approche initiale. D’autres lois symboliques sont adoptées, comme celle de 1932 qui interdit « toute diffusion de fumée » (elle restera sans application) ou un texte de 1948 qui traite de l’utilisation de l’énergie et encourage à moderniser les équipements techniques pour réduire les émissions. L’approche technico-administrative prévaut toujours.

Pourtant plusieurs événements significatifs, prenant souvent la forme de catastrophe, ont révélé les limites de ce type de régulation et l’impact sanitaire dramatique de la pollution atmosphérique chronique dans certains contextes météorologiques particuliers. Ainsi en 1930, dans la vallée de la Meuse, en Belgique, un pic de pollution (oxyde de soufre et d’azote) entraîne une augmentation massive des décès (multipliés par 6). En 1948 à Donora (Pennsylvanie, É.-U.), un épisode de pollution mortelle à l’oxyde de soufre suscite une mobilisation sociale et politique nouvelle sur les effets sanitaires du smog. Et en 1952 c’est une crise liée au fog londonien qui cause le décès de 4 000 personnes. Une série d’échanges scientifiques internationaux se développe à partir de là et de nombreux pays créent des législations spécifiques pour lutter contre la pollution atmosphérique : Clean Air Act anglais dès 1956, Clean Air Act étasunien en 1963, en Italie et en Suisse en 1966, etc. Mais, dans tous ces programmes, la question sanitaire demeure marginale, même si elle a servi de déclencheur. La loi sur l’air française de 1961 se situe dans ce mouvement ; son principal apport est de prévoir des plans d’alerte en cas de crise et de mettre en place des systèmes de mesure de la composition de l’air dans les zones à forte concentration industrielle. La gestion de la pollution atmosphérique est alors non seulement fragmentée, mais elle consacre la toute-puissance de coalitions « bureaucratico-économiques[20] ». L’expertise des industriels associés au ministère de l’Industrie et la puissance montante du lobby des constructeurs automobiles en relation étroite avec le ministère des Transports instaurent un système d’acteurs qui cantonne les discussions et les ajustements de la mise en oeuvre de la loi de 1961 entre les administrations et les acteurs économiques [21].

La contestation de la politique publique et l’invention d’équipements

Si la pollution atmosphérique est une préoccupation politique depuis le xixe siècle, les renseignements sur les polluants atmosphériques et l’état de la qualité de l’air sont infimes. La seule information produite l’est par les directions régionales du ministère de l’Industrie (DRIR) dans leur suivi des « établissements classés », en particulier dans les zones définies à risque par la loi de 1961. Et elle n’est, bien sûr, pas publique. C’est pourquoi à partir de 1973 des groupes associatifs mêlant environnementalistes et scientifiques développent des réseaux de surveillance. Pour contester l’action publique, les mouvements associatifs s’équipent, autant sur le plan technique, en se dotant d’appareils de mesure, que sur le plan critique, en enrichissant leurs argumentaires de contenus de plus en plus scientifiques. Leurs activités n’ont depuis cessé de s’étendre à d’autres zones ni de se diversifier en s’intéressant aux différentes sources de polluants. Deux réseaux ont eu un rôle pionnier : l’ASPA (Association de surveillance et d’étude de la pollution atmosphérique basée à Strasbourg) et l’AIRPARIF (Association interdépartementale pour la gestion du réseau automatique de surveillance de la pollution atmosphérique et d’alerte en région d’Île-de-France). Au départ, ils se définissent comme des contre-pouvoirs locaux. Ils cherchent à exercer des pressions sur les industriels (en soulignant l’importance des rejets) et sur les DRIR (en mettant en cause leur système de mesure et leur information). En outre, au nom de la santé des populations, ils cherchent des appuis auprès de collectivités locales qui deviennent rapidement un « financeur » important. Au milieu des années 1980 l’État prend en partie le relais avec la création de l’Agence de la qualité de l’air (1982) et surtout l’instauration d’une taxe parafiscale (1985) qui assure aux réseaux des ressources financières stables.

L’extension de ces réseaux et de leurs moyens s’accompagne surtout d’une évolution dans la précision des mesures de la qualité de l’air ambiant : longtemps on n’a évalué que les taux de dioxyde de souffre et d’azote. Les mesures prennent peu à peu en compte (contrairement à celles des DRIR) les taux de métaux lourds (plomb), l’ozone et les particules émanant de la combustion du diesel. L’Union européenne joue ici un rôle initiateur décisif en fixant, à partir de 1980, par voie de directive, des taux limites pour un certain nombre de substances (dioxyde de soufre, plomb, oxyde d’azote, etc.)[22]. En plus des mesures substance par substance (en microgramme par mètre cube) et du repérage classique de seuils d’alerte, les réseaux innovent en élaborant des indices synthétiques, donnant en continu des résultats globaux sur la qualité de l’air[23]. Au cours des années 1980 la généralisation d’associations locales de surveillance de la qualité de l’air sur tout le territoire s’accompagne d’un début de coordination et les premières « journées inter-réseaux » se déroulent à Montpellier en 1982. Dès lors, l’ensemble des acteurs se regroupe chaque année pour échanger sur leurs pratiques et mener des concertations sur l’évolution des dispositifs de surveillance de la qualité de l’air.

Leur démarche veut combiner la rigueur scientifique avec le souci de sensibilisation des publics. C’est pourquoi, à partir de 1989, l’ASPA décide de se doter d’outils de communication dans le but de transmettre au grand public de l’information qu’elle veut « transparente, pertinente et évolutive[24] ». À la même période, l’AIRPARIF teste différentes méthodes permettant d’élaborer un indice de la qualité de l’air. Au-delà des différences dans les démarches employées et les configurations organisationnelles, une préoccupation commune est ouvertement affichée : intéresser le public et les élus locaux à cet enjeu afin de contourner le lobby industrialo-administratif dominant[25]. L’ASPA modifie la première mouture de son indice qui donne de l’information sur les polluants en microgramme par mètre cube ; l’AIRPARIF opte pour un indice qualifié de dynamique : « L’indice évolue suffisamment de jour en jour et offre au public une vision changeante plutôt qu’une répétition monotone d’une même classe de qualité de l’air au fil des jours[26]. » La capacité de mobiliser l’attention de la presse et du public est ainsi un des critères explicitement retenus pour constituer un indice de la qualité de l’air. Celui-ci est typiquement un artefact (une construction abstraite basée sur des calculs), un instrument hybride qui comporte des éléments scientifiques et de communication. C’est pourquoi la création d’indices de qualité de l’air unifiés au début des années 1990 constitue un événement significatif qui deviendra un facteur essentiel de changement.

Nouveaux instruments et nouvelle science

La période du début des années 1990 est marquée par un double changement qui repose sur la mobilisation de nouveaux instruments, légaux d’une part, scientifiques de l’autre.

Le premier facteur de changement réside dans la reconnaissance juridique d’un droit à l’information sur la qualité de l’air. La réglementation communautaire européenne tient un rôle central dans cette dynamique qui conduit à l’abandon de l’approche par sources d’émission, à la prise en compte globale de l’état de l’air et à une information du public à base scientifique : tout d’abord, le processus amorcé dès 1980 de fixation de normes seuils par substance se poursuit ; puis un droit général à l’information environnementale fait l’objet d’une directive le 7 juin 1990 (90/313/CEE) ; enfin, les deux mouvements sont combinés avec le premier texte qui prévoit le caractère obligatoire d’une information du public lorsque des niveaux de concentration sont atteints pour l’ozone (no92/72/CEE). En cas de dépassement de certains seuils, la directive stipule que les États doivent prendre les mesures nécessaires pour que le public soit informé ou alerté.

En France, le mode de gestion administrative des risques, fondé sur des seuils d’émission pour les substances classées dangereuses et sur des procédures d’alerte en cas de dépassement significatif, va être profondément révisé. En effet, le respect des normes, source par source, a pendant longtemps signifié une absence de risques, indépendamment de l’état global du milieu[27]. La spécificité de la France, comparativement à d’autres pays, est que pendant de nombreuses années elle ne disposait pas de valeurs limites ni de valeurs guides, quant à la concentration d’un polluant dans l’atmosphère, applicables à l’ensemble du territoire. La réglementation était basée sur des normes d’émission par zone et par type de source (des produits ou des procédés) et non sur des normes de qualité globale de l’air ambiant (immission) caractérisant l’état d’un milieu. D’où l’importance de la directive ozone (de 1992) avec ses trois catégories d’actions correspondant à différents niveaux de concentration du polluant dans l’atmosphère (quelles qu’en soient les sources).

Les changements interviennent en trois temps. Tout d’abord, un décret de 1991 introduit pour la première fois des niveaux de concentration dans l’air qui ne doivent pas être dépassés pour un certain nombre de polluants (dioxyde de soufre, particules en suspension, plomb, dioxyde d’azote) et il ouvre la possibilité (toute théorique) d’instituer des procédures d’alerte à la pollution. Ensuite, la loi Barnier de 1995 transpose la directive de 1990 et son premier article prévoit un « principe de participation, selon lequel chaque citoyen doit avoir accès aux informations relatives à l’environnement, y compris celles relatives aux substances et activités dangereuses » (en février 2005 ce principe acquiert une force constitutionnelle[28]). Ces productions et ces diffusions d’information sur l’état de l’environnement sont souvent présentées comme un moyen facilitant la prise de conscience par un large public de l’importance des questions écologiques[29]. Cet aspect éducatif est soutenu par un effet normatif dans la mesure où ces obligations d’informer incitent également les acteurs politiques et économiques à intégrer les enjeux environnementaux dans la prise de décision[30]. Enfin, la Loi sur l’air et l’utilisation rationnelle de l’énergie (LAURE) adoptée en 1996 transcrit la directive « ozone ». Elle introduit aussi de nouveaux instruments de suivi de l’état de la qualité de l’air et d’organisation des comportements de prévention : les plans régionaux de la qualité de l’air (PRQA)[31], les plans de protection de l’atmosphère (PPA)[32] et les plans de déplacements urbains (PDU)[33]. Seuls les PRQA constituent une innovation véritable, même si l’idée est déjà présente dans la directive européenne du 27 septembre 1996 (96/62/CEE) sur l’évaluation et la gestion de la qualité de l’air ambiant.

Sans attendre ces contraintes légales, les réseaux de surveillance de la pollution atmosphérique ont déjà engagé des actions destinées à livrer une information au public. Dès 1990 et 1992, les premiers indices de la qualité de l’air sont diffusés par les réseaux alsacien et parisien. Mais, de façon significative, l’« inter-réseaux », qui regroupe les associations locales de surveillance de la qualité de l’air, renforce sa coordination. Une étape majeure est franchie en 1995 avec la réalisation d’un indice de référence national de la qualité de l’air (indice ATMO), ce qui clôt les multiples controverses locales et assure la légitimité tant scientifique que technique du groupement[34]. Cette unification est bien sûr la résultante d’un lent processus d’agrégation d’intérêts en cours depuis le début des années 1980. Mais il a été grandement facilité par la montée en puissance des analyses en termes de santé publique de l’impact de la pollution atmosphérique.

Contrairement à d’autres pays, la dimension sanitaire était en France très minorée. Malgré quelques balbutiements dans la loi de 1961[35], il a fallu attendre les années 1990 pour que la question de l’évaluation de l’exposition des populations aux polluants donne lieu à des travaux par des épidémiologues. L’histoire de cette mobilisation est un objet de recherche en soi[36]. Rappelons seulement ici que les premiers travaux d’épidémiologie environnementale et de toxicologie datent des années 1980 ; ils portent sur le lien entre la pollution atmosphérique et les affections respiratoires chroniques (programme PAARC)[37]. Il faut attendre le programme ERPURS (Évaluation des risques de la pollution urbaine sur la santé) (1990-1994) pour que soit mise au centre de la réflexion l’existence d’effets sanitaires de la pollution atmosphérique et que commence à être débattue la question des niveaux d’exposition considérés comme potentiellement dangereux. Ce travail donne alors une visibilité à une littérature scientifique étatsunienne méconnue qui emploie de nouveaux modèles d’analyse statistique[38]. Dans un premier temps, une controverse s’élève chez les spécialistes de la santé publique quant à la valeur prédictive de ces méthodes, en particulier leur capacité à établir des relations causales entre l’exposition et les effets pathogènes[39]. Mais la question de l’impact sanitaire de la pollution atmosphérique urbaine (et de ses déplacements dans l’espace) sur la mortalité et la morbidité (respiratoire et cardiovasculaire) des populations est devenue un point de passage obligé dans la formulation du problème.

Une reconfiguration par les instruments

La fin des années 1990 atteste d’une véritable requalification du problème de la pollution atmosphérique : la problématique classique sur les risques industriels et la recherche de technologie propre a été reformulée en tenant compte de l’aval du problème ; l’impact de ce type de pollution sur la santé des citoyens. L’alliance des métrologues et des épidémiologistes s’édifie autour des réseaux de mesure. Elle favorise une intensification des réseaux de mesure (généralisés par la loi de 1996 à tout le territoire[40]) et surtout le perfectionnement des techniques d’analyse de la qualité de l’air. Ces résultats donnant une connaissance beaucoup plus fine du problème (ses composantes et transformations, ses liens avec l’activité industrielle et surtout, ce qui est nouveau, avec la circulation routière) sont conjugués aux résultats des travaux sur les impacts sanitaires pour reformuler la question de la pollution atmosphérique en tant qu’enjeu public. Différents indicateurs de la stabilisation de cette construction sanitaire peuvent être donnés. Tout d’abord, sur le plan institutionnel, une forte mobilisation s’observe à ce sujet, avec, au premier plan, la constitution en 2000 d’une fédération nationale des associations (ATMO) qui se substitue à l’« inter-réseaux » pour assurer la représentation de ces acteurs auprès des pouvoirs publics et des collectivités territoriales. Cette nouvelle institution renforce la capacité des associations locales à influer sur la définition de la pollution atmosphérique comme enjeu et sur le choix des mesures d’amélioration de la qualité de l’air[41]. Ce nouveau groupement réunit des ressources (scientifiques, techniques et sociopolitiques) suffisamment fortes pour émettre des avis et soutenir des propositions auprès d’instances nationales et internationales. Du côté étatique des changements notables sont opérés, la création de comités d’experts comme le Comité de prévention et précaution (1996), dont le premier dossier traité est celui de la pollution atmosphérique[42], puis celle du Conseil national de l’air (1998). À un niveau déconcentré, le Réseau national de santé publique (1992) intégré dans l’Institut de veille sanitaire (1998) participe de façon très active à la production de données sur l’impact de ce type de pollution sur les populations. Il élabore également des outils opérationnels de gestion de ce risque, tel le guide méthodologique sur la méthode d’évaluation d’impact sanitaire publié en juillet 1999, destiné à cadrer les études de suivi des plans introduits par la loi de 1996 (PRQA et PDU[43]).

Ensuite, les travaux de la nouvelle épidémiologie s’intensifient dans un cadre national (Programme de surveillance air et santé, PSAS, 1997-2002), puis européen (Air Pollution and Health, APHEA, 1993-1998 et Air Pollution and Health, European Information System, APHEIS, 1999-2004) ; ils montrent de plus en plus précisément les liens qui existent à court terme entre le niveau de pollution et l’état sanitaire global de la population (décès prématurés, visites médicales et hospitalisations d’urgence). Du côté de la fédération des réseaux d’observation, une démarche collective est en cours pour réviser l’indice national ATMO et prendre mieux en compte des composants jusque-là moins observés (particules liées à la combustion de fioul). La requalification de l’enjeu en termes de santé publique et plus largement d’impact sur les écosystèmes est ainsi bien attestée par cet ensemble d’éléments d’institutionnalisation.

Cette analyse des changements intervenus en trente-cinq ans dans la politique de lutte contre la pollution atmosphérique en France montre l’intérêt d’une approche qui, tout en se concentrant sur les instruments (réglementaires, techniques et scientifiques), reste ouverte à leurs effets sociaux et aux mobilisations d’acteurs que la définition et le contrôle de ces instruments suscitent. Une histoire qui resterait collée aux stratégies d’acteurs serait fortement biaisée en privilégiant soit l’action des environnementalistes (toujours engagés dans les réseaux de surveillance), soit celle des experts de santé publique (les promoteurs des nouvelles méthodes), ou encore le volontarisme politique (rôle de la ministre de l’Environnement Corinne Lepage, auteure de la loi de 1996[44]). Incontestablement, la politique publique a été profondément transformée, tant du point de vue de la catégorisation du problème public que de celui des acteurs en charge de sa gestion. Dans cette dynamique, successivement les instruments de mesure de la pollution atmosphérique, puis ceux d’analyse de ses impacts sanitaires ont tenu une place centrale. Ces instruments ont eu un rôle cognitif essentiel, d’une part, en objectivant le phénomène en tant que problème public sanitaire ; d’autre part, en fournissant une grille d’interprétation des causes du phénomène ; enfin, en orientant le choix des mesures de gestion. Mais, à l’évidence, les instruments n’agissent pas seuls ; ils sont socialement produits et activés. Ils évoluent en fonction des appropriations et des usages, mais par leurs propriétés ils donnent une matérialité particulière à l’action publique qui cadre les représentations et les comportements des acteurs. En cela ils sont à la fois des institutions et d’excellents traceurs des changements. Enfin, l’analyse du changement par les instruments fournit des éléments d’interprétation politique de ces changements en soulignant la place croissante de « la démocratie du public » qui a créé pour l’État de nouvelles obligations d’information des citoyens (mandatory disclosure)[45]. Ces actions de production et de diffusion continues de l’information ont une double fonction constitutive et instrumentale dans leur champ de compétence respectif. Elles agissent sur trois plans : la programmation et la construction des agendas nationaux, l’orientation des méthodes et des objectifs, et la sensibilisation à la prospective par la mise en valeur d’autres buts que ceux qui sont déjà routinisés[46].

Parties annexes

Note sur l'auteur

Pierre Lascoumes

Pierre Lascoumes est directeur de recherche au Centre national de la recherche scientifique (CNRS). Il travaille au Centre de recherches politiques de Sciences Po (CEVIPOF), à Paris. Son domaine de recherche principal est l’analyse des politiques publiques, en particulier les politiques environnementales et de gestion des risques, qu’il analyse sous l’angle du choix et des effets des instruments d’action publique. Il mène aussi des travaux sur les représentations politiques des atteintes à la probité publique.

Notes

-

[1]

Sur le bilan critique des publications internationales concernant l’épidémiologie et la pollution atmosphérique, voir Institut de veille sanitaire (INVS), 2004, « Mesures de réduction de la pollution atmosphérique : quelle efficacité sanitaire ? », ExtraPol, no 24, décembre.

-

[2]

Kenneth Hanf (dir.) 1998, Governance and Environment in Western Europe, London, Harlow Longman ; Joseph Szarka, 2002, The Shaping of Environmental Policy, New York, Bergham Books. En France une palette très large de techniques d’intervention publique originales ont été inventées afin d’organiser des régulations spécifiques entre l’État et les acteurs économiques : nomenclatures, classements et zonages, déclarations et autorisations, contractualisation, définition de bonnes pratiques, etc. ; et plus largement avec l’ensemble des citoyens concernés : débats publics, planification concertée, obligations d’information et de participation des populations, etc.

-

[3]

Neil Gunningham et Paul Grabosky, 1998, Smart Regulation, Designing Environmental Policy, Oxford, Oxford University Press.

-

[4]

Hans T. Bressers, 1995, « Instruments Institutions and the Strategy of Sustainable Development : the Experiences of Environmental Policy », dans Public Policy and Administrative Sciences in Netherlands, sous la dir. de Walter Kikert et Frans van Vught, Hamptead, Harvest Wheatcheaf, p. 165 et s.

-

[5]

Sur le développement de cette approche, voir Pierre Lascoumes et Patrick Le Galès, 2005, « L’action publique saisie par ses instruments », dans Gouverner par les instruments, sous la dir. de Pierre Lascoumes et Patrick Le Galès, Paris, Presses de Sciences Po ; et Pierre Lascoumes et Patrick Le Galès, 2007, « Understanding Public Policy through its Instruments », Governance, vol. 20, no 1, p. 1-22.

-

[6]

Christofer Hood, 1986, The Tools of Government, London, Charham House ; Staffan Linder et B. Guy Peters, 1990, « The Design of Instruments for Public Policy », dans Policy Theory and Policy Evaluation, sous la dir. de Stuart S. Nagel, Greenwood Press, p. 103-119 ; Michael Howlett, 1991, « Policy, Instruments, Policy Style and Policy Implementation », Policy Studies Journal, vol. 19, no 2, p. 1-21 ; et Michael Howlett et M. Ramesh, 1995, Studying Public Policy, Policy Cycle and Policy Subsystem, Oxford University Press.

-

[7]

Renate Mayntz, 1993, « Governing Failures and the Problem of Governability : Some Comments on a Theoretical Paradigm », dans Modern Governance, sous la dir. de Jan Kooiman, Sage publications, p. 9-20 ; et Marie Louise Bemelmans-Videc et al., 1998, Carrots, Sticks and Sermons. Policy Instruments and their Evaluation, New Brunswick, Transaction.

-

[8]

Karl E. Weick, 1979, « Organizations Design as Self-designing System », dans The Dynamics of Organization Theory, sous la dir. de John Veiga et John Yanousas, New York, New York–West, p. 208-216 ; et Michel Berry, Une technologie invisible ? L’impact des systèmes de gestion sur l’évolution des systèmes humains, Paris, École supérieure de gestion, École polytechnique.

-

[9]

« L’information statistique ne tombe pas du ciel comme un pur effet d’une “réalité antérieure” à elle. Bien au contraire, elle peut être vue comme le couronnement provisoire et fragile d’une série de conventions d’équivalence entre des êtres qu’une multitude de forces désordonnées cherche continuellement à différencier et à disjoindre » (Alain Desrosières, 1992, La politique des grands nombres, La Découverte, p. 397). Voir aussi les travaux du géographe Claude Raffestin sur les liens entre les formes de cartographie et les récits nationaux (1990, Pour une géographie du pouvoir, Litec.)

-

[10]

Lascoumes et Le Galès, Gouverner par les instruments, op. cit. L’ouvrage contient un ensemble d’études de cas menées dans cette perspective (politique de la ville, réforme des retraites, etc.).

-

[11]

Michel Callon, 1984, « Eléments pour une sociologie de la traduction », Année sociologique, vol. XI, p. 183-184.

-

[12]

Ibidem.

-

[13]

Franck Boutaric, 1998, « Les réseaux de surveillance de la pollution atmosphérique », dans Hanf, op. cit., p. 65-67.

-

[14]

Une autre typologie est aussi proposée par Hewlett et Ramesh (Studying Public Policy, Policy Cycle and Policy Subsystem, p. 148) et élaborée en fonction de la « State capacity » et de la « complexityof Actor Constellation ».

-

[15]

Bernard Manin, 1996, Principes du gouvernement représentatif, Paris, Flammarion. « Cette métaphore de la scène et du public exprime en effet simplement l’idée d’une extériorité et d’une indépendance relative entre le niveau où sont proposés les termes du choix et le niveau où le choix est tranché » (p. 290).

-

[16]

Idem, p. 294-297.

-

[17]

Eugene Barbach et Robert A Kagan, 1992, « Mandatory Disclosure », Going by the Book, the Problem of Regulatory Unreasonableness, Temple University Press, Philadelphia, p. 243-269.

-

[18]

Giandomenico Majone, 1997, « The New European Agencies : Regulation by Information », Journal of European Public Policy, vol. 4, no 2, p. 262-275.

-

[19]

Pierre Lascoumes, 1992, L’éco-pouvoir, environnements et politiques, Paris, La Découverte, p. 138 et s. Voir le chapitre V sur « la gestion technocratique des risques industriels ».

-

[20]

Pierre Lascoumes et Chloë Vlassopoulou Ch., 1998, Protéger l’air ou réguler les sources de pollution atmosphérique ?, Questions d’actualité, Documentation française, no 239, p. 31-40.

-

[21]

Peter Knoepfel et Corinne Larrue, 1985, « Distribution spatiale et mise en oeuvre d’une politique publique : le cas de la pollution atmosphérique », Politique et Management public, no 2, p. 43-69 ; et Chloë Vlassopoulos, 2005, « Car Pollution. Agenda Denial and Agenda Setting in Early 20th Century France and Greece », dans History and Sustainability, sous la dir. de Marco Armiero et al., Univercita degli studi di Firenze, Florence.

-

[22]

Directives 80/779/CEE (dioxyde de souffre et poussières), 82/884/CEE (plomb), 85/203/CEE (oxyde d’azote).

-

[23]

À Strasbourg, des stations de mesure de la pollution atmosphérique de fond combinées à des stations de mesure de proximité automobile sont mises en place et la liste des polluants suivis s’allonge. AIRPARIF entreprend un projet de modernisation de son réseau (1989-1993) qui atteste également d’une nouvelle stratégie de surveillance de la qualité de l’air. Pour ne citer qu’un exemple, le nombre de stations consacrées à l’acidité forte et au dioxyde d’azote passe respectivement de 155 à 12 et de 10 à 27. (Philippe Lameloise et al., 1991, « La modernisation du dispositif de surveillance de la qualité de l’air en Île-de-France 1989-1993 », Pollution Atmosphérique, juillet-septembre, p. 418-429.)

-

[24]

Termes employés dans le plan de communication de l’ASPA de 1989.

-

[25]

Franck Boutaric, 1997, « Émergence d’un enjeu politique à Paris », Pôle Sud, no 6, p. 26-46.

-

[26]

« Indice journalier de la qualité de l’air en agglomération parisienne », Pollution atmosphérique, avril-juin 1993, p. 46.

-

[27]

William Dab et Isabelle Roussel, 2001, L’air et la ville, Paris, Hachette littératures.

-

[28]

Art. 7 du texte constitutionnel : « Toute personne a le droit, dans les conditions et les limites définies par la loi, d’accéder aux informations relatives à l’environnement détenues par les autorités publiques et de participer à l’élaboration des décisions publiques ayant une incidence sur l’environnement. » Auparavant ce droit à l’information a connu une reconnaissance internationale avec la convention d’Aarhus, Danemark (1998).

-

[29]

L’article du texte constitutionnel est : « L’éducation et la formation à l’environnement doivent contribuer à l’exercice des droits et devoirs définis par la présente Charte. »

-

[30]

Pierre Lascoumes, 2001, « Les obligations d’informer et de débattre, une mise en public des données de l’action publique », dans Les effets d’information en politique, sous la dir. de Jacques Gerstlé, Paris, L’Harmattan.

-

[31]

Les PRQA sont un outil de diagnostic de l’état de la pollution atmosphérique, région par région sur l’ensemble du territoire, et un outil prospectif qui établit des objectifs de qualité pour chaque territoire.

-

[32]

Les PPA visent à mettre la concentration des polluants à l’intérieur des agglomérations de 100 000 habitants en conformité avec les valeurs limites autorisées. Ils prévoient des mesures de réduction des pollutions dans les cas où les valeurs limites sont dépassées.

-

[33]

Les DPU doivent assurer une « diminution du trafic automobile et le développement des transports collectifs et des moyens de déplacement économes et les moins polluants ».

-

[34]

Jerôme Garcia et Jacques Colosio, 2001, Les indices de la qualité de l’air, élaboration, usages et comparaison internationale, Paris, Les Presses de l’École des Mines.

-

[35]

La loi de 1961 définissait la pollution atmosphérique comme un problème de santé publique et « la coordination des mesures à prendre […] [était] confiée au ministère de la Santé ». Néanmoins, le texte ne comportait aucune référence sanitaire et le rôle de ce ministère est resté tout à fait théorique sur ce sujet.

-

[36]

Franck Boutaric et Pierre Lascoumes, à paraître, « Quand la santé publique redéfinit les enjeux de la pollution atmosphérique », Milieux de vie et santé, Congrès de La société d’écologie humaine, Marseille, Publisud.

-

[37]

Groupe coopératif PAARC, Pollution atmosphérique et affections respiratoires ou à répétition, 1982, Bulletin européen de physiologie respiratoire, no 18, p. 87-99.

-

[38]

Il s’agit d’études écologiques et temporelles. Leur principe est de comparer les risques quotidiens de décès ou d’hospitalisation dus aux taux de pollution journaliers. Contrairement à l’épidémiologie classique, l’unité d’observation n’est plus l’individu, mais la journée.

-

[39]

Une controverse publique éclate en 1996 à l’occasion de la reprise par les grands médias des résultats de l’étude du Réseau national de santé publique (RNSP) (menée dans le cadre du programme européen APHEA). Un éditorial de la revue Natures Sciences Sociétés (no 4, 1996), signé par des membres éminents du comité de rédaction (Marcel Jollivet, Jean Marie Legay, Gérard Mégie), met sévèrement en cause ce qu’ils considèrent comme « une formulation qui est de fait de la désinformation » et « le trop facile et dangereux recours au catastrophisme et à la dramatisation ».

-

[40]

Y compris les zones non urbanisées où s’observent nettement les transferts de polluants dus aux déplacements d’air, mais aussi des pollutions locales, jusque-là non repérées, liées à des produits phyto-sanitaires et à des pollens.

-

[41]

L’article 2 des statuts de la fédération ATMO précise de façon stratégique qu’elle a pour objet « d’étudier et de proposer des orientations communes aux différents réseaux dont l’étude sera demandée au conseil d’administration tels que : fiscalité, communication, personnel… ».

-

[42]

Comité de prévention et de précaution, 2000, Politique publique pollution atmosphérique et santé, pour une réduction des risques, avis du 23 juin 2000.

-

[43]

Un premier bilan effectué sur 21 PRQA a été réalisé par l’INVS en 2003. Il montre la bonne diffusion de l’approche en termes d’« Air-Santé » qui s’est traduite de façon assez homogène par la réalisation d’état des lieux satisfaisants et la définition d’objectifs de qualité (plus ou moins précis selon les régions). L’INVS publie aujourd’hui systématiquement des évaluations faites ville par ville, dont la plus récente est : « Évaluation de l’impact sanitaire de la pollution atmosphérique urbaine, agglomération de Bordeaux, impact à court et long terme », juin 2006.

-

[44]

Corinne Lepage, 2001, On ne peut rien faire Madame le Ministre, Paris, Albin Michel.

-

[45]

Barbach et Kagan, « Mandatory Disclosure », op. cit.

-

[46]

Majone, « The New European Agencies », op. cit.