Résumés

Résumé

Plusieurs recherches jugent que le contenu des plans d’intervention (PI) ou de transition (PT) en milieu scolaire ne satisfait pas le niveau d’exigence ou de qualité attendu. Dans ce contexte, cette recherche a pour objectif principal de proposer des instruments de mesure qui servent à analyser, à évaluer et à améliorer la qualité des PI/PT. Les résultats dressent un portrait de la qualité des PI/PT, exposent les différents moyens proposés par divers chercheurs pour les analyser, les évaluer et les améliorer, présentent les procédures utilisées par différents chercheurs pour les analyser et évaluer la qualité des PI/PT, et concluent en suggérant trois instruments de mesure utiles pour l’analyse, l’évaluation et l’amélioration de la qualité des PI/PT.

Mots-clés :

- Adaptation scolaire,

- Efficacité,

- Élèves handicapées ou en difficulté d’adaptation ou d’apprentissage (HDAA),

- Évaluation,

- Plan d’intervention,

- Qualité,

- Plan de transition

Abstract

Several studies find that the contents of Individualized Education Programs (IEPs) do not meet the required and expected level of quality or adequately address needs and concerns laid out by the Special Education Policy. The main objective of this research is to propose rating scales to analyze, evaluate and improve the quality of IEPs. The results provide an overview of the quality of IEPs, describe the various means proposed and used by various researchers to analyze, evaluate and improve IEPs, and conclude by proposing three rating scales useful for analyzing, evaluating and improving the quality of IEPs.

Keywords:

- Individualized Education Program (IEP),

- Special Education,

- Special needs

Corps de l’article

Introduction

Le plan d’intervention (PI) est un outil de planification et de concertation très répandu dans les écoles québécoises. Cependant, un rapport d’évaluation de l’application de la politique de l’adaptation scolaire (Gaudreau et al., 2008) conclut que le contenu d’une bonne proportion des PI ainsi que leur évaluation ne satisfont pas au niveau d’exigence ou de qualité auquel on pourrait s’attendre pour répondre aux préoccupations de la politique à propos du PI ou du plan de transition (PT). Or, l’efficacité des PI/PT devrait être un des principaux soucis puisque c’est l’outil prescrit par la loi sur l’instruction publique (art 96.14, 1988) et l’outil privilégié par le Ministère de l’Éducation du Québec, (MEQ, 1999) dans sa politique de l’adaptation scolaire pour répondre aux besoins des élèves handicapées ou en difficulté d’adaptation ou d’apprentissage (HDAA). Naturellement, étant favorisé comme dispositif et utilisé auprès de certains élèves potentiellement vulnérables, en particulier les élèves ayant une incapacité intellectuelle moyenne à sévère, la question de « Comment analyser, évaluer et améliorer la qualité des PI/PT ? » mérite d’être posée et répondue. Certes, si les PI/PT sont là pour aider les élèves, les parents et les intervenants à : a) identifier les besoins de l’élève en question; b) cibler des objectifs personnalisés; c) prévoir les moyens pour y arriver; d) guider les actions de chacun; e) faire le suivi de l’élève et des interventions; et, au besoin, f) préparer la transition vers un autre contexte ou milieu, il est évident que cette question est majeure, voire critique.

Toutefois, avant de répondre à cette question, il appert indispensable de revoir ce que les recherches disent à propos de la qualité des PI, ce qu’elles proposent d’utiliser et ce qu’elles emploient pour évaluer la qualité des PI. En second lieu, il s’avère nécessaire de présenter une analyse comparative des différents moyens employés et proposés afin de dégager les apports et les limites de ceux-ci. En conclusion, l’étude répond à cette question en suggérant trois instruments de mesure pour l’analyse, l’évaluation et l’amélioration de la qualité des PI. Enfin, une discussion précise l’utilité de ces instruments de mesure à l’égard des PI ou des plans de transition (PT) au secteur de l’éducation, de même pour ce qui est des plans individualisés interdisciplinaires (PII) au secteur de la santé et des services sociaux.

Méthode

Afin d’obtenir des éléments de réponses à la question « Comment analyser, évaluer et améliorer la qualité des PI/PT ? », une recherche documentaire, fondée sur une procédure de recension systématique des écrits, a été effectuée en premier. En deuxième, les instruments de mesure ont été révisés auprès de trois experts du Canada et des États-Unis.

Concernant la recherche documentaire, cinq banques de références bibliographiques informatisées ont été consultées : Dissertation et Thèse Pro Quest, Eric, Erudit, Francis Pro Quest, Psycinfo ainsi que des références tirées des bibliographies d’articles. Les descripteurs anglais étaient : IEP, quality IEP, IEP efficacy et IEP efficiency. Les descripteurs français étaient : plan d’intervention et qualité ou efficacité des plans d’intervention. La compilation des articles retenus a été réalisée selon un inventaire de trois grandes catégories et sous-catégories :

L’étude traite de la qualité des PI/PT : a) la qualité liée au placement de l’élève; b) la qualité liée aux objectifs du PI/PT; c) la qualité liée à la transition; d) la qualité liée aux tests utilisés; e) la qualité liée à la participation de l’élève ou des parents; et f) La qualité liée aux accommodations ou modifications

L’étude propose et décrit un ou plusieurs moyens d’analyser, d’évaluer ou d’améliorer la qualité des PI/PT : (a) cadre de référence; (b) cahier des charges fonctionnel; (c) formation; (d) instrument de mesure; et (e) programme

L’étude décrit la façon ou le moyen qui a été employé pour analyser, évaluer ou améliorer la qualité des PI/PT : (a) l’analyse de contenu; (b) la comparaison; et (c) la perception

Quant aux instruments de compilation des données, deux grilles de lecture ont été utilisées ; une grille de lecture a servi à indiquer le type d’écrits, le type de recherche et l’objet d’étude. La deuxième grille de lecture a été utilisée pour consigner les informations suivantes : la problématique, les questions et les hypothèses, les cadres de référence, les objectifs, la méthode, les résultats au terme du sujet à l’étude.

Résultats

Ce que les recherches disent à propos de la qualité des PI/PT

Au Québec, quelques études exposent la qualité des PI/PT. D’abord, Goupil et al. (2000) réalisent une analyse descriptive de 30 PI/PT d’élèves en classe spéciale présentant des incapacités intellectuelles moyennes à sévères. Ces chercheurs concluent que les objectifs des PI/PT sont trop nombreux, redondants et imprécis. Dans cette même lignée, Beaupré, Ouellet, Roy et Bédard (2002) recensent une centaine de recherches afin de mettre en évidence les problèmes soulevés et les solutions proposées. Leur synthèse met en relief les thèmes suivants à des fins d’amélioration : (1) la rédaction des objectifs; (2) l’évaluation des progrès de l’élève; (3) la participation de l’élève; (4) la participation des parents; (5) le travail d’équipe; (6) la rencontre du PI/PT; (7) le processus de rédaction du PI/PT; (8) le contenu du PI/PT; (9) la coordination du PI/PT; et (10) les conditions facilitantes.

D’autre part, Gaudreau et ses collaborateurs (2008) soulignent que les besoins prioritaires de l’élève ont tendance à être davantage et mieux décrits que les PI/PT d’autrefois. Les objectifs, les moyens et les ressources tendent à être plus nombreux et plus pertinents. Cependant, les difficultés, les forces, les capacités et les résultats attendus ont tendance à être peu ou non signalés. En somme, ces auteurs concluent que le contenu d’une bonne proportion des PI/PT ne satisfait pas à la qualité à laquelle on pourrait s’attendre pour répondre aux préoccupations de la politique de l’adaptation scolaire (MEQ, 1999).

Par ailleurs, l’étude de Poirier et Goupil (2011) qui porte sur l’analyse de 15 PI/PT d’élèves ayant un trouble envahissant, énonce que 47/53 objectifs semblent suffisamment précis pour suivre leur progression. Cependant deux plans comportent des critères d’évaluation pour juger le progrès. De plus, ces auteurs précisent que ces PI/PT présentent plus de besoins que d’objectifs et que la formulation des besoins et des objectifs pourrait être améliorée.

Finalement, la recherche de Myara (2012) met en relief les qualités et défauts des PI/PT dans le but d’énumérer plusieurs fonctions que le PI/PT doit remplir. La finalité de cette étude vise notamment à spécifier quels sont les fonctions ou rôles caractéristiques d’un PI/PT efficace. L’auteur présente certaines fonctions liées : (1) à la concertation ; (2) aux rencontres ou à la participation des différents utilisateurs du PI/PT; (3) à la communication; (4) à la collecte des données; (5) aux besoins de l’élève; (6) aux objectifs; (7) aux moyens ou stratégies; (8) au suivi; (9) au canevas de PI/PT; et (10) à la formation.

Au-delà du Québec, plusieurs études mentionnent que la qualité des objectifs est faible (Rakap, 2015; Ruble, McGrew, Dalrymple, Lee et Jung, 2010; Sanches-Ferreira, Lopes-dos-Santos, Santos et Silveira-Maia, 2013). D’autres études démontrent que la qualité des PI/PT s’améliore après avoir suivi une formation (Krishnakumar, Greeta et Palat, 2006; Pretti-Frontczac et Bricker, 2000). Selon, Hoehle (1993) les PI/PT générés à l’aide d’une technologie nommée IEP Advisor sont aussi bons sinon meilleurs que les PI/PT produits par des experts reconnus.

Les différents moyens ou instruments d’évaluation proposés

Dans les années 80, Maher et Barbarck (1980) veillent, d’abord, à informer et soutenir les différents utilisateurs d’un PI/PT dans l’analyse, l’évaluation et l’amélioration des PI/PT en produisant un cadre de référence. Selon ces auteurs, l’évaluation d’un PI/PT est un processus multidimensionnel, car elle doit fournir des informations sur divers aspects du PI/PT. Ce faisant, ils définissent un cadre de référence qui vise quatre volets : (1) l’évaluation du plan (le contenu consigné dans le canevas de PI/PT); (2) l’évaluation de la démarche (la mise en oeuvre du PI/PT); (3) l’évaluation du résultat (le suivi et le progrès de l’élève); et (4) l’évaluation du consommateur (la perception ainsi que la satisfaction des parents et de l’élève par rapport à l’utilité du PI/PT). Durant cette période, Morgan (1981) suggère quelques critères ou caractéristiques, dont la présence des trois éléments suivants : (1) les instruments et les moyens utilisés pour évaluer l’élève afin d’établir son niveau actuel de développement; (2) la spécificité des objectifs à court terme sur le plan de l’instruction; et (3) la mesure dans laquelle le PI/PT est utilisé par l’enseignant pour planifier quotidiennement son programme d’instruction.

Certes, la formation est un moyen suggéré par plusieurs chercheurs (McGlohon, 1983). À ce propos, Boavida, Aguiar et McWilliam (2013) proposent d’offrir une formation basée sur une approche nommée Routines-Based Early Intervention pour les élèves au préscolaire. Quant à Lowman (2016), le type de formation atelier et peer coaching (évaluations formatives entre pairs) semble être la formule gagnante. Dans ce même ordre d’idées, plusieurs études proposent une formation accompagnée d’un guide, d’un programme ou d’une trousse.

L’étude de Giangreco, Cloninger, Dennis et Edelman (1993) ainsi que celle de Giangreco, Dennis, Edelman et Clon (1994) recommandent un programme nommé Choosing Outcomes and Outcomes for Children (COACH). COACH est un procédé qui a pour but de soutenir les utilisateurs de PI/PT à planifier, notamment, le contenu de PI/PT d’élèves ayant des incapacités intellectuelles moyennes à sévères. COACH engage les utilisateurs de PI/PT à : a) tenir compte des finalités à poursuivre (l’avenir de l’élève); b) évaluer les habiletés fonctionnelles requises par le curriculum scolaire; c) hiérarchiser les habiletés fonctionnelles, d) tenir compte du programme ordinaire pour une inclusion potentielle; e) tenir compte des mesures d’adaptation et modifications; et f) prévoir les horaires d’inclusion en classe ordinaire. COACH a eu un impact positif sur le choix et la hiérarchisation des objectifs, sur la relation école-famille, sur la participation de l’élève et des parents. Cependant, selon Giangreco et ses collaborateurs (1993, 1994), il est limité à une clientèle très spécifique. Notari et Bricker (1990), Hamilton (1995), Pretti-Frontczac et Bricker (2000) suggèrent une formation qui comporte l’utilisation d’un instrument de mesure le Goal Functionality Scale III (décrit plus bas), basé sur le curriculum appelé Evaluation and Programming System : Asseessement Level 1 (EPS-1; dans l’étude de Notari et Bricker, 1990) pour les enfants âgés de 1 mois à 3 ans et Assessment Evaluation and Programming Systems (AEPS; Pretti-Frontzak et Bricker, 2000) pour les enfants âgés de 3 à 6 ans.

Hormis la formation, plusieurs chercheurs recommandent l’utilisation d’un ou de plusieurs instruments de mesure, de grilles, d’inventaires ou de questionnaires. Notari et Bricker (1990) fournissent et suggèrent d’utiliser un instrument de mesure nommé le Goal Functionality Scale III. Cet instrument de mesure d’objectifs vise les cinq critères suivants : 1) l’adaptabilité (l’objectif vise l’intégration dans le quotidien); 2) la fonctionnalité (l’objectif favorise l’autonomie); 3) la transférabilité (l’objectif s’applique dans plusieurs contextes ou vise des concepts généraux); 4) la mesurabilité (l’objectif est mesurable à des fins d’évaluation); et 5) la relation hiérarchique entre les objectifs (il existe un lien logique et cohérent entre les objectifs). La validité de cet instrument a été démontrée. Ainsi, sa valeur d’utilité a été manifestée dans son usage fréquent à travers les États-Unis.

Ruble et al. (2010) proposent le modèle appelé Collaborative Model for Promoting Competence and Success (COMPASS), pour les PI/PT d’élèves ayant un trouble du spectre de l’autisme. Le modèle COMPASS, qui est à la fois un cadre de référence et une démarche de consultation et de formation, impose de procéder à la collecte de données avant la première consultation. La première consultation COMPASS comprend une discussion de la trousse COMPASS (matériel, démarche et formation), l’élaboration du PI/PT, en particulier, la sélection et la formulation d’objectifs. Cette première consultation, termine avec la rédaction d’un plan d’enseignement COMPASS pour chacun des objectifs ciblés. La deuxième consultation COMPASS est marquée par l’utilisation fréquente de la notion de coaching. Les deux notions « consultation » et « coaching » sont employées, dans ce même programme, de manière interchangeable. En effet, selon ces auteurs, lorsque le coach et les intervenants sont partenaires et sont tous les deux engagés à poursuivre le même but (qui est de planifier), le coach prend le rôle d’un consultant. En revanche, lorsque le coach accompagne l’intervenant dans la mise en oeuvre d’un PI/PT, son rôle change; il devient un coach. Cela étant dit, cette deuxième consultation coaching COMPASS implique le soutien psychologique, la rétroaction, l’analyse et l’évaluation des habiletés de l’intervenant, l’adaptation, et l’accompagnement. Le modèle COMPASS a été développé et amélioré sur une durée de 20 ans de recherche et d’expérimentation pour améliorer les PI/PT, et les résultats escomptés des élèves ayant un trouble du spectre de l’autisme.

Rowland, Quinn et Steiner (2015) mettent à notre disposition un outil clinique nommé The Design to Learn IEP Development Guide, qui présente 28 questions dérivées des critères Specific Mesurable Atteignable Realistice Time sensitive (SMART) proposés par Wright et Wright (2006). Ce guide est composé de : a) 4 questions concernant la spécificité des objectifs; b) 4 questions sur la mesurabilité des objectifs; c) 3 questions au sujet des verbes d’action utilisés dans la formulation des objectifs; d) 4 questions à propos de l’élève comme acteur central de ses objectifs; e) 3 questions relatives à la fonctionnalité des objectifs; f) 3 questions sur l’efficacité des objectifs d’ordre scolaire; et finalement, g) 7 questions sur la qualité du PI/PT dans son ensemble. Ce guide pourrait être utile pour engager les acteurs concernés dans leur pratique réflexive. Toutefois, il faut tenir compte qu’il a été élaboré et mis à l’essai auprès d’une clientèle ayant des incapacités langagières significatives.

Ruble et al. (2010) recommandent un instrument d’évaluation qui a été fondé à partir des exigences juridiques de the Individuals Disabilities Education Act (IDEA) et des recommandations du National Research Council (2001). Cet instrument d’évaluation cible une clientèle spécifique, soit les élèves ayant un trouble du spectre de l’autisme. Il est composé d’un inventaire qui a pour but de renseigner sur le nombre d’objectifs à long terme, le nombre d’objectifs à court terme, le type de service spécialisé (orthophonie, ergothérapie et physiothérapie) offert à l’élève, le portrait de l’élève (notamment ce qui est d’ordre de la communication, d’ordre scolaire, d’ordre social, d’ordre intellectuel, d’ordre émotionnel, de la santé et de niveaux actuels de performance fonctionnelle et scolaire), des préoccupations parentales, des objectifs et des mesures d’adaptation. Selon cette étude, cet instrument est fidèle et valide, cependant une étude des propriétés psychométriques est nécessaire.

En dernier, Myara (2012) s’appuie sur l’analyse de la valeur pédagogique (AVP; voir Rocque, Langevin et Riopel, 1998) pour dire qu’un produit efficace ou de qualité est un produit qui remplit toutes ses fonctions afin de satisfaire les besoins des différents utilisateurs à moindre coût. Cet auteur présente un Cahier des Charges Fonctionnel (CdCF) pour la conception et l’évaluation des PI/PT. Le CdCf représente un tableau qui réunit toutes les fonctions qu’un PI/PT devrait remplir pour satisfaire les différents besoins des divers utilisateurs d’un PI/PT. Les fonctions sont catégorisées (classées selon la démarche d’un PI/PT), hiérarchisées (organisées par ordre d’importance) et valorisées (les types de coûts associés). Il met en évidence toutes les composantes d’un PI/PT. Selon cette perspective, le CdCF est un outil d’aide à la conception des PI/PT, car il permet aux utilisateurs de développer un PI/PT en trouvant des solutions pour chacune des fonctions. Il constitue également un instrument d’évaluation des PI/PT, car il permet aux utilisateurs de vérifier si un PI/PT remplit chacune des fonctions prescrites au CdCF. Il semble que cet instrument d’évaluation (le CdCF) ait été élaboré à partir d’une méthode systématique et rigoureuse faisant preuve de validité. Cependant, la formulation des fonctions et le nombre de fonctions (plus de 850 fonctions) rendent son utilisation laborieuse.

Les divers moyens employés par différents chercheurs pour analyser et évaluer la qualité des PI/PT

Les recherches concernées utilisent diverses façons d’analyser et d’évaluer la qualité des PI/PT; soit par les perceptions des parents, des enseignants et des élèves, soit par la comparaison à un autre PI/PT, soit par l’analyse de contenu accompagnée d’une grille, d’un inventaire, d’un questionnaire ou d’un instrument de mesure.

La perception. Le début des recherches sur les PI/PT est accentué par la perception des utilisateurs du PI/PT, en particulier, celle du parent et de l’enseignant (Smith, 1990). La perception, notamment des consommateurs (élève et parent) d’un PI/PT, est une façon d’informer les concepteurs et les utilisateurs (fournisseurs de service) d’un PI/PT au sujet de sa qualité.

La comparaison. Plusieurs chercheurs utilisent la comparaison pour analyser et évaluer la qualité des PI/PT. Toutefois, les éléments de comparaison varient d’un chercheur à un autre.

Comparer des PI/PT provenant de milieux différents. Smith (1990) et Broughton (1997) comparent des PI/PT entre eux, provenant de milieux différents et de deux États distincts. De plus, ils analysant les perceptions des intervenants et des parents face à ces canevas de PI/PT différents.

Comparer des PI/PT élaborés par des personnes à des PI/PT élaborés à l’aide d’un outil technologique. Hoehle (1993) fait usage aussi de comparaison. Cependant, ce chercheur compare des PI/PT élaborés à l’aide d’un système informatique expert nommé IEP Advisor aux PI/PT élaborés par le personnel local ayant les compétences pour élaborer un PI/PT de qualité. De plus, l’exercice de comparaison a été réalisé par un jury.

Comparer entre des PI/PT pré et post formation. Certaines recherches s’appuient sur la formation. Plusieurs auteurs observent l’effet d’une formation en comparant des PI/PT pré et post formation (Giangreco et ses collaborateurs, 1993, 1994; Hamilton, 1995; Notari et Bricker, 1990; Pretti-Frontczac et Bricker, 2000). Par ailleurs, Shriner et ses collaborateurs (2012), procèdent aussi de la même façon, mais la formation est offerte par le biais d’un outil d’aide technologique. De plus, leur démarche d’évaluation est accompagnée d’une grille d’analyse.

Comparer entre des PI/PT pré et post consultation. Finalement, Ruble et al. (2010) comparent des PI/PT pré et post consultation suite à l’utilisation du modèle COMPASS ci-haut mentionné accompagné d’une grille qui analyse le progrès de l’élève.

L’analyse de contenu. Au Québec, comme ailleurs, l’analyse de contenu avec l’aide de grilles, d’inventaires, de listes, d’instruments de mesure ou de questionnaires est couramment utilisée.

La grille d’analyse. Hunt, Goetz et Anderson (1986) élaborent et utilisent une grille pour analyser et évaluer des PI/PT d’élèves ayant une incapacité intellectuelle. Selon ces auteurs, cette grille s’appuie sur des pratiques exemplaires. L’intention de cette grille porte notamment sur l’objectif ; la pertinence, la cohérence (l’objectif correspond à l’âge chronologique de l’apprenant), la fonctionnalité (l’objectif vise la participation sociale) et la transférabilité (l’objectif peut être abordé dans plusieurs contextes).

Sigafoos, Kigner, Holt, Doss et Mustonen (1991) s’inspirent des travaux de Hunt et al. (1986), pour évaluer la qualité des PI/PT de jeunes adultes ayant des incapacités intellectuelles. Cependant, ces auteurs ajoutent quelques autres critères : à savoir si l’objectif est observable, s’il comporte une date d’échéance et si le plan précise les outils d’évaluation qui seront utilisés pour évaluer la progression de l’élève.

Poirier et Goupil (2011) élaborent une grille dont ils font usage. Cette grille regarde principalement : 1) si un des items consignés dans le PI/PT correspond à un but ou un objectif spécifique; 2) si l’objectif porte sur un contenu scolaire, sur la communication, sur le comportement, sur l’affectivité ou la motricité; et 3) si le PI/PT présente les intervenants appelés à mettre en oeuvre des moyens pour atteindre les objectifs.

Enfin, Stephenson et Carter (2015), intéressés par des élèves présentant des incapacités intellectuelles sévères, s’inspirent de différents auteurs (Baine, 2003; Boavida, Aguiar, McWilliam et Pimentel, 2010; Codding, Skowron et Pace, 2005; DePaepe, Reichle, Doss, Shriner et Cameron, 1994; Pretti-Frontczak et Bricker, 2000 ; Ruble et al., 2010; Sigafoos et al., 1993; Sigafoos et al., 1991) pour créer une grille qui cible l’objectif et les moyens.

Les inventaires ou les listes. Gaudreau et ses collaborateurs (2008) se servent d’une liste préétablie « d’angles » pour analyser la qualité du contenu. À vrai dire, ces chercheurs vérifient la présence ou l’absence d’une liste d’éléments (portrait de l’élève, objectifs, moyens, ressources matérielles, financières ou humaines, les modalités d’évaluation et les résultats escomptés) préétablie et attribuent un point selon une cote d’appréciation allant de 0 à 3 : 0 si l’item est absent, 1 si l’item est présent, mais vague, 2 si l’item est présent et accompagné de quelques détails et 3 si l’item est présent et accompagné de beaucoup de détails.

Les instruments de mesure. Quelques chercheurs priorisent l’utilisation d’un instrument de mesure. Spillane (1990) a recours au Nebraska IEP Evaluator composé de 19 questions à caractère légal afin de voir si le PI/PT est conforme aux normes. De plus, Spillane (1990) agrémente sa démarche d’évaluation en ajoutant les critères d’analyse suivants : le pourcentage de besoins d’apprentissage identifiés, les niveaux actuels de performance cités, le nombre de buts ou d’objectifs à long terme et à court terme, le nombre et la variation des moyens ainsi que la présence des services offerts. Plusieurs études ont d’ailleurs utilisé l’instrument de mesure appelé le Goal Functionality Scale II (Boavida et al., 2013; Boavida et al., 2010; Hamilton, 1995; Notari et Bricker, 1990; Pretti-Frontczac et Bricker, 2000; Rakap, 2015). Cet instrument cible : 1) l’adaptabilité (l’objectif vise l’intégration dans le quotidien); 2) la fonctionnalité (l’objectif favorise l’autonomie); 3) la transférabilité (l’objectif s’applique dans plusieurs contextes ou vise des concepts généraux); 4) la mesurabilité (l’objectif est mesurable à des fins d’évaluation); et 5) la relation hiérarchique entre les objectifs, soit : est-ce que l’objectif établit un lien logique et cohérent.

Les questionnaires. Eichler (1999) recourt à un questionnaire composé de 50 questions associées aux fonctions du PI/PT. Pour ce faire, cet auteur identifie, en premier, cinq actions ou activités reliées aux fonctions du PI/PT (fonctions identifiées par l’Office of Special Education of the United States); soit un total de 25 actions ou activités. À partir de ces 25 actions ou activités, Eichler élabore un questionnaire de 50 questions, dont chaque question met en évidence l’occurrence de l’action ou de l’activité ou l’absence de l’action ou de l’activité. Finalement, Eichler évalue dans quelle mesure les PI/PT remplissent les fonctions identifiées par l’Office.

Comparaison des différents moyens ou instruments d’évaluation utilisés

Cette analyse a permis d’identifier sept moyens ou instruments d’évaluation utilisés ou proposés pour analyser, évaluer ou améliorer la qualité d’un PI/PT :

L’analyse de contenu avec l’aide de grilles, d’inventaires ou de listes, d’instruments de mesure ou de questionnaires.

Le cadre de référence

Le cahier des charges fonctionnel

La comparaison de PI/PT provenant de milieux différents, de PI/PT élaborés par des personnes de différents milieux, de PI/PT élaborés à l’aide d’un outil technologique, de PI/PT pré et post formation et de PI/PT pré et post consultation.

La consultation accompagnée d’un modèle

La formation accompagnée de guide, de programme ou de trousse

La perception des utilisateurs de PI/PT

En ce qui concerne l’analyse de contenu, cette façon permet de systématiser la démarche d’un PI/PT, les composantes d’un PI/PT et le contenu consigné dans un PI/PT pour en faire une interprétation adéquate. L’analyse de contenu est reconnue pour retirer l’information recherchée de façon stable à partir des PI/PT. D’ailleurs certains instruments de mesure ou grilles ont été validés et couramment utilisés. Seulement, pour l’ensemble de ces études, il est impossible de savoir si les attributs, les caractéristiques ou les critères de ces grilles, de ces instruments de mesure, de ces inventaires ou listes sont suffisants, ni si toutes les propriétés essentielles d’un PI/PT de qualité ont été identifiées. De plus, pour plusieurs études, le processus suivi pour les identifier n’est pas décrit. Par ailleurs, la majorité de ces grilles ou instruments de mesure se limite aux objectifs. Or, un PI/PT est une démarche d’élaboration, de résultat de cette démarche (qui s’exprime sous forme de canevas de PI/PT, où est consigné le portrait de l’élève, ses besoins, objectifs, moyens, etc.), de mise en oeuvre et de révision d’un plan.

À propos d’un cahier des charges fonctionnel (CdCF), il y a quelques éléments à prendre en considération. En premier, il est possible de remarquer que le CdCF a un rôle prescriptif, car il prescrit toutes les fonctions qu’un PI/PT doit remplir pour satisfaire les besoins de ses utilisateurs potentiels, ce qui permet de concevoir ou élaborer un PI/PT. De plus, le CdCF exerce un rôle normatif, car il permet d’évaluer l’efficacité du PI/PT en vérifiant s’il remplit les fonctions prescrites au CdCF. En deuxième, le CdCF est élaboré au coeur d’une démarche d’analyse de la valeur pédagogique (AVP), ce qui permet de connaître le processus suivi pour les identifier. En ce sens, une étude a élaboré un CdCF qui décrit de manière détaillée les étapes poursuivies avant la conception du CdCF faisant preuve de validité (Myara, 2012). En troisième, le CdCF met en relief les multiples composantes du PI/PT, tel que ci-haut mentionné. En dépit de sa rigueur, sa validité et son importance, son coût de gestion et d’utilisation s’avère déraisonnable puisqu’il contient plus de 850 fonctions.

Au regard d’un cadre de référence, il va de soi qu’il sert à tracer certains paramètres et à définir certains critères nécessaires pour l’évaluation des PI/PT. Un cadre de référence est utile pour donner une direction, diriger les choix, orienter les méthodes et faciliter l’interprétation. Un seul cadre de référence pour l’évaluation de la qualité des PI/PT a été trouvé dans la littérature, celui proposé par Maher et Barbarck (1980). Il attire notre attention sur quatre aspects à évaluer : 1) le contenu consigné dans le canevas de PI/PT; 2) la mise en oeuvre du PI/PT; 3) les résultats escomptés du PI/PT, soit le progrès de l’élève; et 4) la satisfaction des parents et de l’élève. Manifestement, ces auteurs ont évoqué les différents visages et implications du PI/PT devant être considérés lors de l’évaluation de la qualité d’un PI/PT. Toutefois, Maher et Barbarck (1980) ne fournissent pas les critères d’évaluation. De plus, les résultats escomptés du PI/PT sont certainement le but principal des PI/PT, mais ils ne se rattachent pas qu’au contenu, ni qu’à sa mise en oeuvre. Les résultats escomptés du PI/PT relèvent aussi de « qui » et de « comment » la personne concernée a mis en pratique le PI/PT. Quant à la satisfaction des parents et de l’élève, cela relève généralement de l’interprétation que les parents ou l’élève en font.

Du côté de la comparaison, généralement entre deux produits présumés égaux, il est reconnu que la comparaison a souvent été une des manières d’évaluer la qualité ou l’efficacité d’un produit. Or, le nouveau produit (le produit de comparaison) validé n’a pas toujours été le produit optimal recherché.

Pour ce qui est de la consultation, plusieurs auteurs insistent sur son importance et ses retombées (Johnson, Pugach et Hammitte, 1988; Ruble et al., 2010). Comme le mentionnent Johnson et al. (1988), la consultation a été suggérée pour venir en aide à l’enseignant de la classe ordinaire ainsi que pour réduire le nombre d’élèves référés à des services spécialisés. Différents modèles de consultation sont présents dans la littérature, cependant un seul modèle faisant un lien explicite avec le PI/PT a été trouvé pour les PI/PT d’élèves ayant un trouble du spectre de l’autisme, soit le COMPASS (Ruble et al., 2010). Selon les auteurs, le modèle COMPASS est le seul modèle développé et amélioré sur une durée de 20 ans de recherche et d’expérimentation pour améliorer les PI/PT et les résultats escomptés des élèves ayant un trouble du spectre de l’autisme. COMPASS a été validé et a réussi à former des intervenants dans le but d’améliorer les performances de leurs élèves. Les limites de ce modèle portent notamment sur l’engagement des acteurs concernés et le temps à consentir pour se l’approprier et le mettre en pratique.

À l’égard de la formation, en éducation, la formation continue est un enjeu essentiel de la réussite des changements occasionnés par les différents besoins et contraintes des milieux scolaires. Les apports positifs de la formation en matière de PI/PT ont été confirmés dans plusieurs recherches (Boavida et al., 2013; Lowman, 2016; Pretti-Frontczac et Bricker, 2000; Stephenson et Carter, 2015). Toutefois, les intentions, les objectifs, le contenu et la durée varient d’une formation à une autre.

Quant aux perceptions, elles sont avantageuses pour fournir le niveau de satisfaction des utilisateurs notamment les consommateurs (les parents et l’élève) ou le destinataire (l’élève) des services du PI/PT. Nonobstant, elles dépendent de la manière dont chacun interprète ce qu’est un PI/PT efficace ou la façon dont chacun se donne implicitement des critères d’évaluation.

Discussion et conclusion

En 1999, le MEQ confirme dans la politique de l’adaptation scolaire que le PI/PT demeure l’outil privilégié pour répondre aux besoins des élèves handicapés ou en difficulté d’adaptation ou d’apprentissage. En outre, la politique insiste sur l’importance de la concertation, de l’évaluation des résultats des interventions suite au PI/PT, ainsi que sur l’efficacité et l’efficience des services. Toutefois, comme Myara (2012) le mentionne « elle reste cependant vague quant aux procédures à suivre pour arriver à concevoir un outil qui répond aux besoins des élèves HDAA et ne propose pas de moyens pour en évaluer l’efficacité et l’efficience. » (p. 7).

En fonction des résultats observés dans ces recherches, il est clair que la qualité des PI/PT doit être améliorée. Plusieurs chercheurs proposent d’utiliser différents moyens ou instruments pour analyser, évaluer et améliorer la qualité des PI/PT. Certains moyens ou instruments sont plus utiles ou plus efficaces que d’autres. Plusieurs instruments visent les objectifs du PI/PT. Quelques moyens explorent le contenu consigné dans un PI/PT. Mais, tel que Maher et Barbarck (1980) l’ont soulevé, l’évaluation d’un PI/PT ne se limite pas aux objectifs et intéresse plusieurs acteurs ayant des intérêts ou des intentions d’évaluation distinctes. En effet, une direction d’école pourrait vouloir évaluer la participation du parent ou de l’élève dans la démarche d’élaboration du PI/PT et la participation de l’enseignant de la classe ordinaire à la mise en oeuvre du PI/PT. En sus, aucune de ces recherches, à part celle de Myara (2012) qui définit le concept d’efficacité, ne détermine la notion de qualité. Selon les propositions de Myara (2012), il est possible de comprendre qu’il s’agit d’un procédé qui remplit ses fonctions ou ses rôles afin de satisfaire au mieux les besoins de ses utilisateurs, est un procédé de qualité. Après tout, Maher et Barbarck (1980) identifient deux aspects incontournables à évaluer dans un PI/PT : le contenu consigné dans le canevas de PI/PT et la mise en oeuvre du PI/PT. Les deux autres aspects suggérés (les résultats escomptés et la satisfaction des parents et de l’élève) par ces auteurs ne retiennent pas notre attention, malgré leur importance, puisqu’un procédé de qualité est un procédé qui remplit ses fonctions afin de satisfaire les besoins de ses utilisateurs et qu’il y a d’autres facteurs en jeu dans l’évaluation de ces deux aspects. En revanche, en s’appuyant sur l’étude de Myara (2012), trois autres aspects fondamentaux sont ajoutés : la démarche d’élaboration du PI/PT, la révision du PI/PT et la participation des acteurs principaux du PI/PT.

Enfin, il va sans dire que l’évaluation intégrale d’un PI/PT porte sur : la démarche d’élaboration, le canevas et son contenu, la mise en oeuvre, la révision ainsi que la participation des acteurs principaux. À la lumière de ce qui précède et en s’appuyant sur les travaux recensés, a priori ceux de Myara (2012) et de Maher et Barbarck (1980), trois instruments de mesure ont été élaborés et validés auprès de trois experts au Canada et aux États-Unis, accompagnés d’un tableau présentant les concepts clés qui sont à la base de tout PI ou PT :

Instrument de mesure d’objectifs consignés dans un PI/PT (IMO). L’IMO (voir Appendice B), sert à analyser et à évaluer la qualité des objectifs consignés dans un PI/PT. Il est fondé sur les quatre caractéristiques principales d’un objectif : pertinent, réaliste, observable et mesurable. Les indicateurs pour chacune des caractéristiques ont été générés à partir du Cahier des charges fonctionnel pour la conception et l’évaluation des PI/PT (Myara, 2012), des principes de qualité et de pertinence d’objectifs, ainsi que les règles de formulation d’objectifs (Myara, 2017). Chaque objectif est analysé indépendamment des autres en déterminant la présence ou l’absence d’un indicateur : 1 point est attribué lorsque l’indicateur est présent; 0 point est attribué lorsque l’indicateur est absent; n/a est consigné lorsque l’indicateur ne s’applique pas au plan; et n/o est consigné lorsque l’indicateur n’est pas observable.

Instrument de mesure d’informations consignées dans un PI/PT (IMI). L’IMI (voir Appendice C) a été élaboré afin d’analyser et d’évaluer la qualité d’un canevas de PI/PT et accompagne IMO. Il est fondé sur quatre composantes essentielles du PI/PT : le portrait de l’élève, les besoins de l’élève, les moyens proposés pour atteindre les objectifs et la révision du PI/PT. Les indicateurs pour chacune des composantes ont été générés à partir du cahier des charges fonctionnel pour la conception et l’évaluation des PI/PT (Myara, 2012). Chaque énoncé est analysé indépendamment des autres en déterminant la présence ou l’absence d’un indicateur : 1 point est attribué lorsque l’indicateur est présent ; 0 point est attribué lorsque l’indicateur est absent; n/a est consigné lorsque l’indicateur ne s’applique pas au plan; n/o est consigné lorsque l’indicateur n’est pas observable.

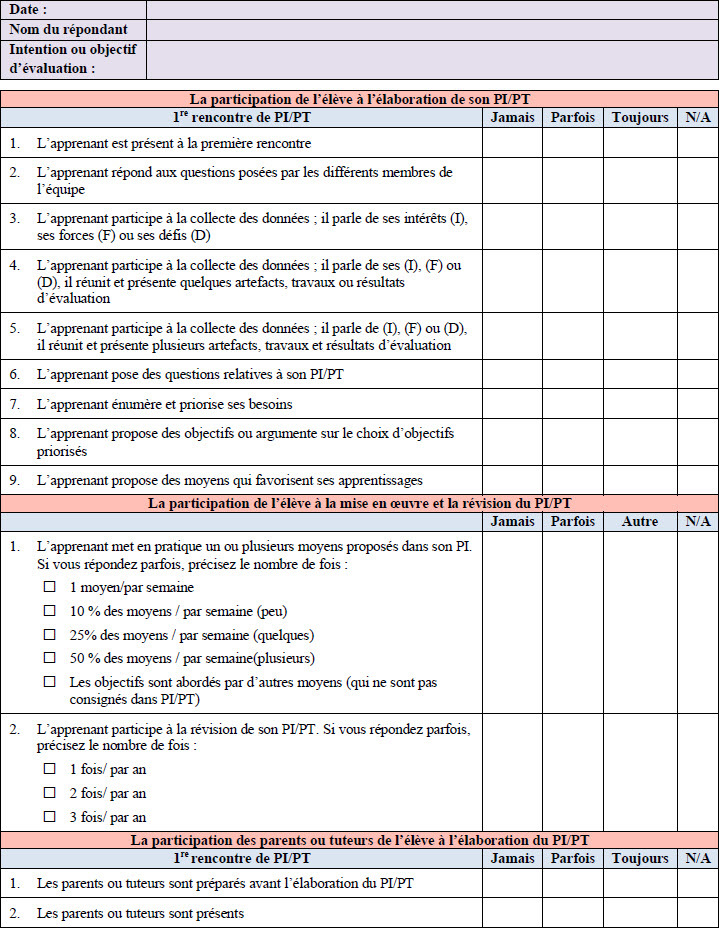

Instrument de mesure concernant la mise en oeuvre et la révision d’un PI/PT (IMM). L’IMM, (voir Appendice D) vise la mise en oeuvre du PI/PT, la révision du PI/PT et la participation de l’élève, des parents ou tuteurs de l’élève, ainsi que d’un ou de plusieurs intervenants (la dernière section associée à l’intervenant est reproductible). Chaque énoncé est analysé indépendamment des autres en déterminant la présence ou l’absence d’un indicateur : 2 points sont attribués lorsque l’indicateur est toujours présent, 1 point lorsque l’indicateur est parfois présent; 0 point est attribué lorsque l’indicateur est absent ou jamais présent; n/a est consigné lorsque l’indicateur ne s’applique pas au plan; et n/o est consigné lorsque l’indicateur n’est pas observable.

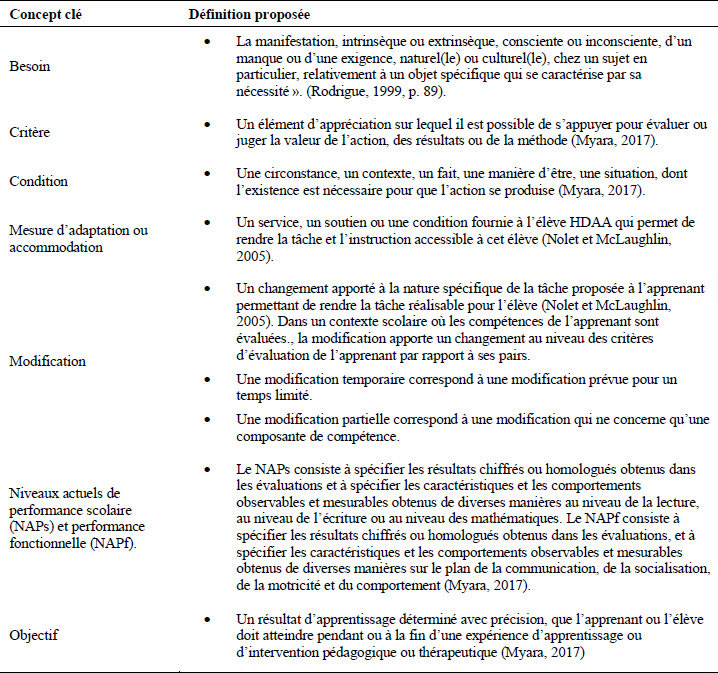

Le Tableau A1, présenté en Appendice A, propose une définition pour chacun des concepts. Il a été élaboré afin d’éviter toute confusion terminologique et conceptuelle qui caractérise les écrits ou les pratiques portant sur les PI ou PT.

En somme, la présente étude avait pour objet de répondre à la question « Comment analyser, évaluer et améliorer la qualité des PI/PT ? ». Plusieurs moyens ont été identifiés, à partir de la littérature, mais une analyse comparative a mis en lumière que certains moyens sont plus efficaces que d’autres quant à ce qu’ils ciblent et comment ils procèdent. Par ailleurs, cette recherche fait remarquer que l’analyse, l’évaluation et l’amélioration des PI/PT portent sur les cinq constituants suivants : (1) la démarche d’élaboration; (2) le canevas et son contenu; (3) la mise en oeuvre; (4) la révision; et (5) la participation des acteurs principaux du PI/PT. En outre, elle propose trois instruments de mesure qui pourraient être utiles aux chercheurs et aux professionnels enseignants ou non enseignants. Les chercheurs peuvent s’en servir pour : analyser et évaluer les PI ou les PT dans le secteur de l’éducation, ainsi que les plans individualisés interdisciplinaires (PII) dans le secteur de la santé et des services sociaux. Concernant les professionnels enseignants ou non enseignants, ils pourraient en faire usage en formation et y avoir recours pour baliser et guider la pratique quotidienne sur un ou plusieurs constituants des PI, PII ou PT.

Parties annexes

Annexes

Appendice A

Tableau A1

Définitions de concepts clés associés aux PI/PT

Appendice B. Instrument de mesure d’objectifs consignés dans un PI/PT

Appendice C. Instrument de Mesure d’informations consignées dans un PI/PT

Appendice D. Instrument de Mesure concernant la mise en oeuvre du PI/PT, la révision du PI/PT, et, la participation au PI/PT

Bibliographie

- Baine, D. (2003). Guide to best practices: Developing and evaluating special needs programs (3e éd.). Edmonton, AB: Vector International.

- Beaupré, P., Ouellet, G., Roy, S. et Bédard, A. (2002). Recension des écrits sur le plan d'intervention auprès des personnes handicapées ou en difficulté. Rapport de recherche sur les plans d'intervention auprès des élèves handicapés ou en difficulté. Québec, QC : Ministère de l'Éducation.

- Boavida, T., Aguiar, C. et McWilliam, R. A. (2013, Juillet). Increasing the quality of intervention goals and objectives: Outcomes of a training program. Communication présentée à l’International Society on Early Intervention Regional Conference. St Petersburg, Russie.

- Boavida, T., Aguiar, C., McWilliam, R. A. et Pimentel, J. S. (2010). Quality of individualized education program goals of preschoolers with disabilities. Infants & Young Children, 23(3), 233-243.

- Broughton, V. (1997). The individualized family service plan: Does the form make a difference to the process? (Mémoire de maîtrise inédit). Université de Cincinnati, OH.

- Codding, R. S., Skowron, J. et Pace, G. M. (2005). Making data-based decisions: Training teachers to use data to create instructional objectives. Behavioral Interventions, 20, 165-176.

- DePaepe, P., Reichle, J., Doss, S., Shriner, C. L. et Cameron, J. (1994). A preliminary evaluation of written individualized habilitation objectives and their correspondence with direct implementation. Journal of the Association for Persons with Severe Handicaps, 19, 94-104.

- Eichler, J. B. (1999). The individualized program requirement: Conceptualization versus reality. (Mémoire de maîtrise inédit). University of Kansas, Lawrence, KS.

- Hamilton, D. A. (1995). The utility of the assessment, evaluation, and programming system in the development of quality IEP goals and objectives for young children, birth to three, with visual impairments. Dissertation Abstracts International, 56(08), 2994A-3198A.

- Hoehle, R. L. (1993). The development of an expert system to evaluate the IEP components of student records (Thèse de doctorat inédite). Utah State University, Logan, UT.

- Hunt, P., Goetz, L. et Anderson, J. (1986). The quality of IEP objectives associated with placement on integrated versus segregated school sites. Journal of the Association for Persons with Severe Handicaps, 11(2), 125-130.

- Gaudreau, L., Legault, F., Brodeur, M., Hurteau, M., Dunberry, A., Séguin, S. P. et Legendre, R., (2008). Rapport d'évaluation de l'application de la. Politique de l'adaptation scolaire. Montréal, QC: Université du Québec à Montréal

- Giangreco M. F., Cloninger C. J., Dennis, R. E. et Edelman S. W. (1993). National expert validation of COACH: Congruence with exemplary practice and suggestions for improvement. The Association for Persons with Sever Handicaps, 18(2), 109-120.

- Giangreco, M. F., Dennis, R. E., Edelman, S. W. et Clon, C. J. (1994). Dressing your IEPs for the general education climate. Analysis of IEP goals and objectives for students with multiple Disabilities. Remedial and Special Education, 15(5), 288-296.

- Goupil, G., Tassé, M. J., Doré, C., Horth, R., Lévesque, J. Y. et Mainguy, E. (2000). Analyse descriptive des plans d’intervention personnalisés. Rapport de recherche inédit, Université du Québec à Montréal, QC.

- Johnson, L. J., Pugach, M. C. et Hammitte, D. J. (1988). Barriers to effective special education consultation. Remedial and Special Education, 9(6), 41-47.

- Krishnakumar, P., Greeta, M. G. et Palat, R. (2006). Effectiveness of individualized education program for slow learners. Indian Journal of Pediatrics, 73, 135-137.

- Lowman, J. J. (2016). A comparison of three professional development mechanisms for improving the quality of standards-based IEP objectives. Communication Disorder Quarterly, 37(4) 211-224

- Maher, C. A. et Barbarck, C. R. (1980). A framework for comprehensive evaluation of the individualized education program (IEP). Learning Disability Quarterly, 3(3), 49-55.

- McGlohon, D. D. (1983). Development of training program to improve the quality of IEPs (Thèse de doctorat inédite). Université d'État de l'Arizona, Trempe, AZ.

- Ministère de l’Éducation du Québec. (1999). Une école adaptée à tous ses élèves : Politique d’adaptation scolaire. Québec: Gouvernement du Québec.

- Morgan, D. (1981). Characteristics of a quality IEP. Education Unlimited, 3(3), 12-17.

- Myara, N. (2012). Cahier de charges fonctionnel pour la conception et l’évaluation des plans d’intervention (Thèse de doctorat inédite). Université de Montréal, QC.

- Myara, N. (2017). Le plan d’intervention : un processus et des ententes. Montréal, QC: Éditions JFD.

- National Research Council. (2001). Educating children with autism. Washington, DC: National Academy Press.

- Nolet, V. et McLaughlin, M. J. (2005). Accessing the general curriculum, including students with disabilities in standards-based reform. Thousand Oaks, CA: Corwin Press.

- Notari, A. R. et Bricker, D. D. (1990). The utility of a curriculum-based assessment instrument in the development of individualized education plans for infants and young children. Journal of Early Intervention, 14(2), 5-11.

- Poirier, N. et Goupil, G. (2011). Étude descriptive sur les plans d'intervention pour des élèves ayant un trouble envahissant du développement. McGill Journal of Education, 46(3), 459-472.

- Pretti-Frontczac, K. et Bricker, D. (2000). Enhancing the quality of individualized education plan (IEP) goals and objectives. Journal of Early Intervention, 23(2), 92-105.

- Rakap, S. (2015). Quality of individualized education programme goals and objectives for preschool children with disabilities. European Journal of Special Needs Education, 30(2), 173-186.

- Rocque, S., Langevin, J. et Riopel, D. (1998). L'analyse de la valeur pédagogique au Canada, méthodologie de développement de produits pédagogiques. La valeur des produits et services, 76, 6-11.

- Rodrigue, T. (1999). Incapacités intellectuelles et communication écrite : processus d’identification des besoins (Mémoire de mai^trise inédit). Université de Montréal, QC.

- Rowland, C. M., Quinn, E. D. et Steiner, S. A. M. (2015). Beyond legal: Crafting high-quality IEPs for children with complex communication needs. Communication Disorders Quarterly, 37(1), 53-62.

- Ruble, L., McGrew, A., Dalrymple, J., Lee, N. et Jung, A. (2010). Examining the quality of IEPs for young children with autism. Journal of Autism and Developmental Disorders, 40, 1459-1470.

- Sanches-Ferreira, P. M., Lopes-dos-Santos, S. A., Santos, M. et Silveira-Maia, M. (2013). How individualized are the individualized education programmes (IEPs): An analysis of the contents and quality of the IEPs goals. European Journal of Special Needs Education, 28, 507-520.

- Shriner, J. G., Carty, S. J., Rose, C. A., Shogren, K. A., Kim, M. et Trach, J. S. (2012). Effects of using a web-based individualized education program decision-making tutorial. The Journal of Special Education, 47(3), 175-185.

- Sigafoos, J., Elkins, J., Couzens, D., Gunn, S., Roberts, D. et Kerr, M. (1993). Analysis of IEP goals and classroom activities for children with multiple disabilities. European Journal of Special Needs Education, 8, 99-105

- Sigafoos, J., Kigner, J., Holt, K., Doss, S. et Mustonen, T. (1991). Improving the quality of written developmental policies for adults with intellectual disabilities. The BritishJournal of Mental Subnormality, 37(72), 35-46.

- Smith, S. W. (1990). Comparison of individualized education programs (IEPs) of students with behavioral disorders and learning disabilities. The Journal of Special Education, 24(1), 85-99.

- Spillane, M. M. (1990). IEP quality:Changes observed following a period of staff training and form revision (Mémoire de maîtrise inédit). Université du Nebraska à Omaha, NE.

- Stephenson, J. et Carter M. (2015). Improving education planning for students with severe disabilities: An evaluation of school-based professional learning. Australian Journal of Special Education, 39(1), 2-14.

Liste des tableaux

Tableau A1

Définitions de concepts clés associés aux PI/PT

10.7202/1009177ar

10.7202/1009177ar