Abstracts

Résumé

Cet article décrira l’évolution des responsabilités survenue à la Direction du traitement documentaire et métadonnées (DTDM) au cours des vingt dernières années. Il permettra de détailler les changements apportés aux pratiques de catalogage descriptif, à la gestion des autorités, au catalogage collaboratif ainsi que l’élargissement des responsabilités des catalogueurs qui incluent, entre autres, la promotion du libre accès et le soutien à la gestion des données de recherche.

Abstract

This article will describe the evolution of responsibilities at the Direction du traitement documentaire et métadonnées (DTDM) over the past twenty years. It will itemize the changes in descriptive cataloguing practices, authority management, collaborative cataloguing and the expansion of cataloguers’ responsibilities to include, among other things, promoting Open Access and supporting research data management.

Article body

Vers une nouvelle direction

La transition de la Direction du traitement documentaire et métadonnées (DTDM) vers des champs de responsabilités non traditionnellement dévolus aux catalogueurs comme le libre accès et la gestion des données de recherche prend sa source dans les années 1990 et début 2000, bien avant que ces sujets soient d’actualité. En effet, plusieurs textes publiés à cette époque, dont deux articles, Cataloging must Change ! (Gregor et Mandel, 1991) et Cataloging for Access (Mandel, 1991) ainsi que la Politique cadre pour le traitement de la documentation dans les bibliothèques universitaires québécoises publiée la première fois en 1997 (Groupe de travail sur le traitement de la documentation [GTTD], 2005) ont eu une influence tant sur les opérations de catalogage que sur la structure organisationnelle à l’Université de Montréal.

Dans l’article de Gregor et Mandel (1991), les autrices font valoir que l’arrivée des catalogues en ligne introduit un nouvel environnement et représente une occasion de faire du catalogage différemment. Elles notent des facteurs tels que la dépendance à l’égard du catalogage collaboratif, le changement dans la façon dont les utilisateurs cherchent dans le catalogue, et l’apparition de nouveaux formats dans les collections des bibliothèques comme des incitatifs à revoir les pratiques de catalogage. L’article de Mandel (1991), quant à lui, fait valoir que les catalogueurs doivent opérationnaliser la vision du « nouveau catalogue » et tirer parti du nouveau potentiel des OPACs. Le catalogage doit être fait en vue de favoriser l’accès plutôt que simplement viser l’identification. Elle y affirme que la quête de précision et de cohérence est inutile et que cette quête a créé une culture de catalogage qui utilise le jugement professionnel pour établir des règles plutôt que pour la résolution de problèmes. Un changement de paradigme sera nécessaire si l’on veut changer cette culture de catalogage. Cette idée que la quête de précision et de cohérence en catalogage est utopique a eu une influence marquante sur la vision du catalogage à la DTDM et par conséquent sur ses opérations. Le catalogage n’est pas une recette que l’on suit aveuglément, mais bien une démarche qui demande le jugement du catalogueur.

Ce sont ces mêmes constats sur l’évolution des besoins et des comportements de recherche documentaire des usagers et l’évolution rapide des moyens technologiques qui sont mis de l’avant dans le rapport préparé par le sous-groupe de travail de réflexion et d’orientations sur une politique du traitement de la documentation et dont les recommandations ont mené à l’élaboration de la Politique cadre sur le traitement de la documentation (Groupe de travail sur le traitement de la documentation [GTTD], 1997). Dans son rapport, le sous-groupe note que les membres de la communauté universitaire exigent maintenant un accès rapide à l’ensemble de l’information à l’échelle planétaire y compris la documentation électronique, et que le traitement, par ses pratiques et ses règles, s’apparente davantage à du contrôle bibliographique et n’est pas tourné vers la satisfaction des besoins en information des usagers. Les opérations de catalogage ne sont pas adaptées au nouveau catalogue qui devient un élément d’un système d’accès à l’information documentaire. Il devient donc nécessaire de redéfinir le modèle classique d’organisation de la documentation.

C’est donc dans ce contexte que la réflexion s’amorce en 2000 sur l’avenir de la Direction du catalogage. Dans un document de travail (Joanis, 2000), on note que l’appellation « Direction du catalogage » est désuète et n’induit pas le ou les rôles que l’on peut en attendre en période de développement, que le catalogage est une opération appartenant à la bibliothèque classique, laquelle est essentiellement basée sur l’imprimé et une collection locale. Il faut donc réinventer ses fonctions pour que la bibliothèque du début du xxie siècle soit basée sur l’accès et la fourniture de documents. On propose un mandat élargi pour cette direction renouvelée dont le développement d’une expertise en métadonnées et en structuration des données. Le nouveau nom doit refléter ce nouveau mandat élargi. C’est ainsi que la Direction du traitement et de l’accès aux documents (DTAD) est née.

Le 26 septembre 2001, le directeur général des bibliothèques UdeM de l’époque, M. Jean-Pierre Côté, annonce le rattachement du Prêt entre bibliothèques (PEB) à la direction du catalogage pour former la Direction du traitement et de l’accès aux documents (DTAD). Dans le communiqué envoyé au personnel à l’époque, il note que les deux unités que sont le catalogage et le PEB exploitent essentiellement les mêmes outils et que ces deux services sont complémentaires puisque le premier enrichit les bases de données bibliographiques collectives alors que le second utilise ces mêmes bases pour répondre aux besoins documentaires des usagers. La nouvelle direction vise à favoriser l’accès des usagers aux documents (Côté, 2001).

Révision des interventions de catalogage

Dans l’élaboration de la politique cadre de traitement, une revue de littérature a été menée en 1996 sur le comportement des usagers dans leur utilisation des catalogues. Elle a mis en lumière que les usagers utilisent très peu ou pas les éléments descriptifs autres que les sujets (48 %), le titre (28 %) ou l’auteur (22 %) (Boisvert et al., 2004, diapo. 10 ; GTTD, 1997, p.5). Au cours des travaux, certains éléments de la politique faisant largement consensus ont aussi été identifiés comme la limitation de la normalisation de titres de collection sauf pour certaines disciplines, limitation du contrôle d’autorité pour les collectivités, dérivation de notices des catalogues de bibliothèques nationales ou de bibliothèques universitaires québécoises sans personnalisation et le partage des responsabilités pour le traitement en original des publications officielles de langue française (GTTD, 2005).

Bien avant la publication de la Politique cadre, le Service de catalogage avait déjà entrepris de revoir ses interventions dans les notices. Une des premières procédures à cet effet date de 1994 et portait sur la mention d’université conférant le grade inscrite dans la zone de thèse (zone MARC 502) qui devait être validée grâce au fichier d’autorité. À partir de cette année-là, la forme du nom inscrite dans la zone de note n’est plus contrôlée et la forme apparaissant dans la thèse ou le mémoire est retranscrite telle quelle.

C’est à partir de 1997 qu’une série de procédures visant à réduire les interventions jugées inutiles sont rédigées, et ce, sur une période de dix ans. En redirigeant les interventions des catalogueurs sur des éléments de la description bibliographique plus utiles pour les usagers et leurs recherches dans le « nouveau catalogue » comme les dépouillements ou les résumés, on souhaite accélérer la visibilité des titres au catalogue, maximiser l’accès aux documents, réduire l’inventaire des documents en attente de traitement et mettre en oeuvre les éléments de la Politique cadre. Ainsi, au fil des ans, plusieurs positions des zones de contrôle des notices bibliographiques ne sont plus vérifiées ainsi que les zones de numéros de contrôle d’autres agences de catalogage ou des zones de codage, dont celui pour l’aire géographique.

À la même période, plusieurs niveaux de traitement locaux sont introduits en plus du niveau complet jusque-là appliqué à toute la documentation cataloguée à l’Université de Montréal afin de rendre compte de l’arrêt des vérifications systématiques de toutes les zones MARC des notices bibliographiques dérivées. En 1999, quatre niveaux locaux de traitement sont définis dont celui dit pour les « arrérages », pour la pré-édition et un autre qui permet de décentraliser en bibliothèque l’édition de notes dans les notices bibliographiques. En 2020, au moment du passage à WMS d’OCLC par l’ensemble des bibliothèques universitaires du Québec marquant la fin de l’utilisation de niveaux de traitement localement défini, le Service de catalogage avait créé huit niveaux de traitement.

Le Service de catalogage limite aussi fortement, comme le préconise la Politique cadre, le contrôle d’autorité des points d’accès. Dès 1997, les collectivités ne sont plus vérifiées à moins qu’il s’agisse d’organismes canadiens ou internationaux pour lesquels une notice d’autorité devra être créée si elle n’existe pas au fichier d’autorité local. Jusqu’en 2008, d’autres limites au contrôle d’autorité sont introduites et les cas pour lesquels un contrôle doit être exercé sont définis, par exemple si la vedette doit être utilisée dans un catalogue francophone ou encore si la forme du nom mis en vedette est différente de celui utilisé dans le document catalogué. Enfin, le contrôle d’autorité des collections est abandonné en 2012, sauf pour quelques exceptions, afin de s’arrimer à la pratique de la Library of Congress (Library of Congress, 2006).

Cette tendance à réduire les interventions dites « inutiles » se poursuit encore aujourd’hui dans WMS. En effet, les membres du Groupe de travail sur le traitement des ressources documentaires (GTTRD) (Partenariat des bibliothèques universitaires du Québec, s.d.) ont développé un tableau des interventions autorisées par les catalogueurs des universités québécoises sur les notices AFNOR présentes dans WorldCat afin de limiter les énergies déployées pour rendre ces notices conforment à la norme RDA.

Outre les limitations des interventions des catalogueurs dans les notices bibliographiques, deux autres initiatives sont mises en place pour accélérer le traitement de la documentation et favoriser la recherche par les usagers. La première touche la chaîne de traitement alors que la deuxième automatise la traduction des Library of Congress Subject Headings (LCSH) en vedettes-matière du Répertoire de vedettes-matière de l’Université Laval (RVM) dans les notices bibliographiques dérivées.

La chaîne de travail pour la commande de la documentation est décentralisée depuis 1999 aux bibliothèques UdeM. Cette décentralisation permet, à l’époque, au personnel des bibliothèques de dériver une notice bibliographique correspondante au titre à acheter, notice qui sera versée au catalogue une fois le processus d’achat enclenché par le Service des acquisitions. Ainsi, les titres en commande et les informations bibliographiques de leurs notices associées apparaissent aux usagers. Afin d’accélérer le catalogage du document une fois celui-ci reçu au Service de catalogage, le processus de pré-édition est mis en place entre 1999 et 2003. Il consistait à faire, dans la mesure du possible, l’édition de la notice avant la réception du document. Le document ayant fait l’objet d’une pré-édition, une fois reçu, était remis aux catalogueurs pour faire la validation finale et les ajustements, si nécessaire. Cette pratique a été abandonnée en raison de l’alimentation irrégulière en notices à traiter et du manque de connaissances en catalogage des équipes responsables de dériver les notices en bibliothèque. Ces deux facteurs faisaient en sorte que des quantités massives de documents à cataloguer arrivaient à certaines périodes de l’année, perturbant toute la chaîne de traitement, et que des notices dérivées ne provenant pas de sources autorisées, demandaient d’énormes ajustements une fois les documents reçus, occasionnant du travail en double plutôt que l’économie de temps escomptée.

Connu à l’interne sous le nom de TradRVM et développé pour le système GEAC utilisé jusqu’en 2012, puis dans le système Aleph d’Ex Libris jusqu’en 2020, cette fonctionnalité permettait d’ajouter automatiquement dans la notice, au moment de la dérivation dans le catalogue local, la forme française des vedettes-matière LCSH présentent dans la notice bibliographique dérivée. Les notices d’autorité du Répertoire de vedettes-matière de l’Université Laval (RVM), dans lesquelles les vedettes-matière LCSH sont inscrites dans les zones 7XX (zones d’équivalence d’autres thésaurus), étaient utilisées pour récupérer les vedettes en français équivalentes codées en 1XX (zones vedettes autorisées) et les insérer dans la notice bibliographique. Les catalogueurs, au moment du catalogage du document, n’avaient qu’à finaliser la traduction des subdivisions non traduites, le cas échéant. En plus de réduire le temps consacré à la traduction, il devenait possible pour les usagers d’obtenir des documents en traitement dans leurs résultats de recherche sujet, et de demander un traitement accéléré de ces documents. Une fonctionnalité similaire a également été développée dans le service Gestion des notices WorldShare d’OCLC utilisé par les bibliothèques universitaires du Québec pour le catalogage collaboratif (OCLC, 2021).

Arrivée des ressources électroniques

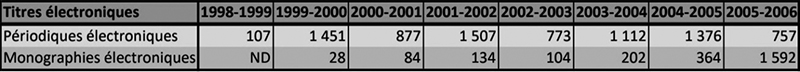

En 1999, une bibliothécaire est affectée à mi-temps pour le traitement des ressources électroniques en plus d’une technicienne à temps plein puisque ces ressources commencent à être acquises en plus grand nombre. En effet, pratiquement inexistantes en 1998-1999, le nombre de ressources électroniques acquises et traitées explose au début des années 2000. Dès 1999, le nombre de périodiques électroniques connaît une hausse fulgurante alors que les monographies prennent le dessus en 2005-2006 (voir tableau 1). Cette arrivée massive de périodiques électroniques puis de monographies électroniques s’explique par l’acquisition de nombreuses collections de ressources électroniques en consortium par les bibliothèques universitaires membres de la CREPUQ (Direction des bibliothèques, 2001, p. 12) grâce à la mise en place du Projet canadien de licences de site nationales (PCLSN), ancêtre du RCDR. Ce projet lancé en 1999 avec l’appui de 64 universités canadiennes avait pour but de soutenir la capacité de recherche et d’innovation des universités du pays en obtenant les licences des versions électroniques de publications savantes à l’échelle nationale (RCDR, s. d.).

Tableau 1

Évolution du nombre de titres de ressources électroniques cataloguées par année

Pour faire face à l’arrivée massive des périodiques électroniques et rendre ces titres accessibles rapidement aux usagers, le Service de catalogage adhère au projet CORC (the Cooperative Online Resource Catalog) d’OCLC (Hickey, 2001) en août 1999, au moment même où l’Université de Montréal devient membre d’OCLC. Une bibliothécaire et une technicienne sont dédiées au projet, à temps partiel.

L’objectif principal de la participation du Service de catalogage au projet CORC était de réduire les efforts de catalogage des périodiques électroniques en utilisant les notices CORC pour créer de nouvelles notices en français et ensuite, verser ces notices dans notre système local. Un des avantages du service était la vérification de l’URL et le contrôle régulier des hyperliens. Il était aussi possible de cataloguer en plusieurs formats. Par contre, l’expérience a démontré les limites suivantes : signes diacritiques problématiques, lourdeur du module de catalogage, lenteurs du système. Le projet est abandonné en 2000, à la suite du constat qu’il était plus facile et efficace de cataloguer dans le système local que de le faire en direct dans celui de CORC et que les outils proposés ne permettaient pas, et de loin, d’atteindre l’objectif d’accélérer le traitement (Latour et Vaillancourt, 2000).

Comme mentionné précédemment, la Politique cadre développée en 1997 (GTTD, 2005) offrant déjà un cadre de normalisation du traitement de la documentation dans les bibliothèques universitaires du Québec, c’est donc naturellement, pour traiter cette masse de ressources électroniques, que le Groupe de travail sur le traitement documentaire (GTTD) se dote, par extension à la Politique cadre, d’une série de politiques communes de traitement des ressources électroniques. La Politique commune pour le traitement des périodiques électroniques accessibles en ligne dans les bibliothèques universitaires du Québec est développée en 1999 (GTTD, 2007b) suivis par les lignes directrices pour le traitement des périodiques électroniques qui viennent encadrer le partage des responsabilités pour leur traitement (GTTD, 2000a). Cette politique et les lignes directrices permettent le lancement en 2000 du Projet TRAP, le programme de traitement partagé des ressources électroniques (Boisvert et al., 2004). Suivront les politiques communes pour le traitement des ressources Internet en 2000 (GTTD, 2000b), des monographies électroniques en 2004 (GTTD, 2004) et enfin celle sur les ressources intégratrices en 2007 (GTTD, 2007a).

Le projet TRAP, qui permet le traitement documentaire des ressources électroniques en coopération en fonction de normes communes et partagées par l’ensemble des bibliothèques universitaires membres de la CREPUQ, vise deux objectifs : 1. Donner un accès rapide aux collections de documents électroniques achetées en consortium ; 2. Partager la responsabilité du traitement entre les bibliothèques universitaires participantes (Boisvert et al., 2004). Pour rendre efficace et bénéfique pour tous le partage de la tâche du traitement des périodiques électroniques des conditions gagnantes préalables sont établies, dont l’application d’une politique commune de traitement des périodiques électroniques accessibles à distance et la mise en place de moyens techniques pour faciliter le partage des notices bibliographiques entre les différentes bibliothèques universitaires québécoises (GTTD, 2000a). Des modalités pour le partage des tâches et des responsabilités des établissements sont également définies (GTTD, 2003, 2009). La qualité du projet TRAP sera récompensée à plusieurs reprises (CREPUQ, 2006).

C’est justement la mise en place de moyens techniques pour le partage des notices bibliographiques dans le cadre du Projet TRAP qui permet au Service de catalogage de faire les premiers versements en lot de fichiers de ressources électroniques en provenance d’autres institutions. Cela marque un tournant dans le traitement au Service de catalogage. D’ailleurs, dans son rapport d’activités 2000-2001 (Service de catalogage, 2001), le Service de catalogage note que cette nouvelle façon de faire a permis de rendre accessible, très rapidement, l’information à l’usager, toutefois, puisque cette façon de procéder s’effectuera de plus en plus souvent, il faudra développer de nouvelles façons de faire pour être capable de garder la cohérence et la qualité de la base de données, c’est un des défis des prochaines années. Vingt ans plus tard, le défi est toujours le même !

La participation au projet s’essouffle avec la baisse marquée d’achats des mêmes ensembles de périodiques électroniques dans les bibliothèques universitaires. De plus, les fournisseurs livrent souvent les notices bibliographiques des titres lors de l’achat ou de l’abonnement à leurs ensembles de périodiques électroniques et les bibliothèques choisissent, de plus en plus, d’activer les titres dans les résolveurs de liens sans verser de notices dans leur catalogue local. Pour ces raisons, le projet TRAP est officiellement abandonné en 2012.

Deux autres projets majeurs marquent la gestion des ressources électroniques au Service de catalogage. En 2003, le lancement de l’Assistant SFX (résolveur de liens), produit d’Ex Libris, qui permet de passer directement d’une base de données à la version électronique de l’article repéré dans cette base (Paré, 2005) et le lancement du Chantier Bib2, en 2007, par le directeur général de l’époque (Direction des bibliothèques, 2007, p.4) dont l’objectif est d’améliorer les services offerts à nos usagers par des outils et ressources électroniques.

Dans le cadre du Chantier Bib2, le Service de catalogage revoit en profondeur son traitement des ressources électroniques. Les notices sont simplifiées et les modifications réduites avec l’abandon de plusieurs zones de notes ainsi que l’adoption des données plus stables des couvertures et de l’OpenURL en provenance du résolveur de liens. Ces changements évitent de constamment mettre à jour les notices de ces ressources, dégageant du temps de catalogueurs pour le traitement de nouveaux titres, accélérant d’autant leur disponibilité aux usagers. C’est aussi à ce moment que le logiciel d’édition de notices MARC ouvert, MarcEdit, est utilisé systématique dans la chaîne de traitement des ressources électroniques pour modifier en lot des fichiers de notices. Ces changements amènent une révision en profondeur de la chaîne de traitement des ressources électroniques au sein de la Direction des bibliothèques avec, en 2012, la prise en charge de l’activation des cibles dans SFX par les techniciennes de l’équipe des ressources électroniques du Service de catalogage. Ce changement implique également que l’équipe travaille exclusivement dans SFX pour le traitement régulier des périodiques électroniques et sans le cadre des normes de catalogage connues, jusque-là utilisées. C’est une première expérience de traitement hors module de catalogage et d’utilisation de fichiers KBART (Knowledge Bases and Related Tools) qui est une pratique recommandée par NISO pour gérer les métadonnées de fonds dans les bases de connaissances (NISO, s. d.). La maîtrise des fichiers KBART s’avérera essentielle pour la gestion des programmes d’achat initié par l’usager (EBA/PDA) qui seront mis en place deux ans plus tard.

Depuis cette prise en charge des activations, le Service de catalogage assumait à la fois l’activation des titres de périodiques dans SFX et le traitement complet de ceux-ci dans le catalogue. Avec l’accélération des changements amenés par la déconstruction des grands ensembles de périodiques électroniques (Direction des bibliothèques, 2014), l’équipe des ressources électroniques du Service de catalogage ne pouvait plus maintenir deux chaînes de traitement en parallèle et le catalogage des périodiques électroniques dans le catalogue Atrium cesse en 2016.

En 2014-2015 est lancé le premier programme d’achat initié par l’usager (PDA) institutionnel à titre de projet pilote pour une période de cinq mois. Les objectifs du projet pilote sont d’enrichir la collection de nouvelles monographies, expérimenter un mécanisme de développement de collections reposant exclusivement sur des achats « juste à temps », plutôt que sur une approche « juste au cas » et réduire les délais en inversant la chaîne de travail (Direction des collections, 2015).

Ce projet est révolutionnaire ! En effet, les notices des titres du fournisseur correspondant au périmètre établi pour le projet pilote sont versées en lot dans le catalogue telles quelles sans aucun traitement et sans être identifiées comme des notices PDA. Le traitement intervient à la fin du processus, au moment où l’achat du titre est déclenché par un usager. Les titres achetés sont alors catalogués. À la suite du bilan du projet pilote, la recommandation est faite de pérenniser le programme. Cela donnera lieu à plus d’une dizaine de programmes du genre, jusqu’à maintenant, dont un consortial en 2015 (Direction des bibliothèques, 2015).

Dépôt institutionnel et libre accès, point tournant décisif

Le Conseil de la Faculté des études supérieures et postdoctorales (CONFESP) adoptait en mai 2008 (Université de Montréal, 2008) le rapport déposé par le Comité sur les thèses électroniques du CONFESP qui propose de remplacer le dépôt final en mode papier par l’étudiant de sa thèse ou de son mémoire par un dépôt électronique obligatoire dans le dépôt institutionnel Papyrus (Comité sur les thèses électroniques, 2008). Après une période pilote en 2008-2009, cette transformation de processus s’étend à l’ensemble de l’université et oblige les étudiants à déposer leur thèse ou mémoire à partir de l’automne 2009 en mode électronique (Direction des bibliothèques, 2010, p. 5).

Le traitement des thèses et mémoires UdeM et leur envoi auprès des partenaires externes (Archives, Bibliothèque et Archives Canada, ProQuest) relevaient de la DTAD avant l’introduction du dépôt électronique. Avec l’implantation du dépôt électronique obligatoire, la chaîne de travail doit complètement être revue. Il n’y a plus d’envois massifs de thèses à gérer puisque les métadonnées sont maintenant moissonnées par les partenaires externes. De plus, le modèle de dépôt est décentralisé et c’est l’étudiant qui dépose un fichier PDF de sa thèse ou son mémoire et saisit les métadonnées (auteur, titre, résumé, etc.) qui seront visibles dans le dépôt et non plus l’équipe technique de la DTAD. Par contre, cette équipe aura désormais la responsabilité de valider, directement dans l’interface Papyrus, les soumissions pour corriger, par exemple, les erreurs de saisie et de métadonnées. C’est la deuxième équipe, après celle des ressources électroniques, à travailler dans un système autre que le module de catalogage et selon des règles autres que les RCAA2.

En vue du déploiement du dépôt obligatoire des thèses sous forme électronique, l’équipe de la DTAD a aussi travaillé avec la Direction du soutien à la réussite, à la recherche et à l’enseignement, responsable du projet, sur les métadonnées des notices de Papyrus afin qu’elles se conforment au format de métadonnées ETD-MS, norme de métadonnées pour les thèses et mémoires exigée par Thèses Canada pour être moissonné dans leur dépôt. Un travail a aussi été effectué sur les métadonnées devant être transférées du dépôt Papyrus au catalogue Atrium afin que ces titres apparaissent aux usagers. En parallèle, des guides et procédures ont été développés pour former le personnel technique de la DTAD affecté au traitement et à la validation des dépôts de thèses dans Papyrus.

En 2018, afin d’harmoniser l’offre de service de dépôt d’articles en libre accès dans Papyrus et simplifier le processus pour les déposants, l’équipe du traitement Papyrus récupère la validation, la correction et la bonification des métadonnées pour l’ensemble des collections du dépôt, vérifie les droits pour les articles déposés et agit comme première ligne pour les demandes d’information concernant le dépôt (Direction des bibliothèques, 2018) (voir figure 1).

Figure 1

Bordereau de traitement dans Papyrus pour un chapitre de livre

L’offre de service harmonisée s’accompagne de la révision et de l’harmonisation des métadonnées Papyrus. L’expérience de catalogueuse de la bibliothécaire métadonnées attitrée au projet lui a permis de s’appuyer sur un cadre normatif solide, qui s’est avéré un outil précieux pour l’acquisition d’une plus grande agilité avec Dublin Core. La compréhension de cette norme était nécessaire pour le projet puisque les éléments Dublin Core et leurs raffinements respectifs sont à la base du schéma de métadonnées de la plateforme DSpace qui sous-tend Papyrus. Dublin Core est un ensemble de recommandations, maintenu et développé par le Dublin Core Metadata Initiative (DCMI), qui s’applique pour faire la description bibliographique minimale compatible avec OAI-PMH, un protocole largement utilisé pour exposer les métadonnées à la récupération dans d’autres systèmes (Dublin Core Metadata Initiative, 2020).

Le travail a d’abord consisté à identifier les métadonnées nécessaires pour aider les utilisateurs à accéder, comprendre et interagir avec la production intellectuelle de la communauté scientifique de l’Université de Montréal, indépendamment de tout modèle existant. Dans un second temps, les différents schémas déjà établis ont été étudiés. La résultante est un amalgame de trois éléments : Dublin Core (avec intégration de nouvelles propriétés propres à Qualified Dublin Core), Rioxx et OpenAIRE. Tous les modèles retenus ont pour but de promouvoir le libre accès autour d’une infrastructure numérique avec un impératif d’interopérabilité et de compatibilité avec le protocole OAI-PMH.

Bien que largement reconnus, ces schémas de métadonnées proposent une liste des métadonnées à intégrer sans pourtant offrir des indications claires sur la manière d’enregistrer l’information (Baker, 2000). Après avoir identifié les métadonnées essentielles et établie un modèle de description cohérent, des instructions de saisie « locales » pour le traitement des documents publiés dans Papyrus ont été rédigées pour soutenir l’équipe technique. Leur fondement intellectuel s’inspire librement de la norme RDA, mais l’objectif poursuivi dans cette démarche demeure fort pragmatique ; maintenir la conformité avec les outils de moissonnage et accroître les chances d’exploration de la recherche de notre communauté, tout cela de façon ouverte.

Complexification des tâches

Au tournant des années 2000, le Service de catalogage pouvait compter sur une équipe de plus d’une dizaine de commis. En effet, à cette époque, une moyenne de plus de 25 000 monographies imprimées est traitée chaque année, ce qui demande beaucoup de manipulations de la part des commis comme le tri, le transport, le rangement de ces documents en rayon et la préparation matérielle. Les commis sont aussi responsables de dériver dans le catalogue local les notices bibliographiques pour les dons et les documents originaux. Ils effectuaient une recherche dans les bases de données catalographiques par le protocole Z39.50 pour associer des notices aux documents et ainsi permettent l’organisation de la documentation dans le Service de manière naturelle, c’est-à-dire selon la classification LC. Leur travail permet aussi de rendre visibles aux usagers les titres en traitement dans le catalogue Atrium.

Plus la décennie avançait et plus les montants alloués aux acquisitions « traditionnelles » migrent vers les ressources électroniques diminuant d’autant le nombre de monographies imprimées achetées. Combiné avec le traitement qui s’effectue maintenant dans des systèmes autres que le catalogue selon des schémas de métadonnées différents que le MARC21 et les versements en lot de notices, les tâches normalement dévolues aux commis comme la recherche à la pièce, le rangement et la préparation matérielle sont à la baisse. Les tâches se complexifient et cela a eu pour effet de diminuer l’équipe de commis tout doucement (voir figure 2).

Figure 2

Évolution d’achats de monographies imprimées vs nombre de commis sur 20 ans

Les changements technologiques ont aussi contribué à cette baisse. Le changement de SIGB en 2012 pour Aleph d’Ex-libris a modifié quelque peu les tâches des commis. Certaines corrections dans les bases de données collectives (WorldCat, AG-Canada) ont été automatisées, diminuant les opérations cléricales et par le fait même, le temps de commis qui y était consacré. Les corrections sont maintenant effectuées en lot, ce qui nécessite les connaissances d’une technicienne en documentation.

En 2019, après 8 ans d’utilisation d’Aleph, l’équipe de commis était seulement composée de quatre personnes. L’arrivée de la Plateforme partagée de services (PPS) en 2020 annonce encore une réduction des tâches et responsabilités des commis puisqu’elle modifie considérablement leur chaîne de travail. En effet, pour gagner en temps et en efficacité, les codes-barres sont dorénavant apposés au Service des acquisitions plutôt qu’au Service de catalogage. Les commis qui devaient avant l’implantation de la PPS rechercher chaque titre au catalogue lors de l’arrivée des documents dans le service pour ajouter un code-barres aux exemplaires en profitaient pour récupérer l’indice de classification servant au rangement. La recherche dans le catalogue pour ajouter les codes-barres ne s’avérant plus nécessaire, les documents arrivant maintenant avec un code-barres dans le service, la tâche a été abandonnée et l’organisation de la documentation en traitement sur les rayons, repensée plutôt que de maintenir une recherche uniquement pour récupérer l’indice de classification. Un classement par bibliothèque, jugé plus efficace et demandant moins d’opérations, a été retenu. La complexité du système, l’étendue de la base de données et les jeux de permissions restrictifs de WMS ont mis en évidence la nécessité d’avoir des connaissances en traitement documentaire pour pouvoir y naviguer. Ces tâches complexifiées sont maintenant de la responsabilité des techniciennes.

WMS, véritable catalogage collaboratif

En octobre 2019, le Bureau de coopération interuniversitaire (BCI) annonce la création d’un partenariat des bibliothèques universitaires québécoises (Partenariat des bibliothèques universitaires du Québec, 2019) ce qui signifie que toutes les bibliothèques universitaires québécoises, francophones et anglophones, utiliseront la même plateforme partagée de services (PPS), WorldShare Management Services d’OCLC.

Le déploiement de la PPS a lieu au printemps 2020 dans l’ensemble des universités du Québec. Afin de faire cette transition en douceur, la DTDM a préparé la migration de système sur plusieurs mois. Une professionnelle a été engagée au début de 2018 pour faire l’analyse des chaînes de travail existantes, étudier le fonctionnement du nouveau système et adapter les tâches et processus en conséquence.

Elle a de plus piloté un colossal chantier de corrections des métadonnées dans le catalogue pour que la migration se fasse sans trop de pertes d’information ni de heurts. Cette étape avait été jugée nécessaire parce que les données provenant des migrations précédentes étaient de qualité inégale et que les nombreux niveaux de traitement locaux combinés à l’abandon du codage de zones fixes avaient laissé des traces dans le catalogue. De plus, l’Université de Montréal étant une des premières universités francophones à avoir adopté les RDA en juillet 2013, des milliers de notices ne se conformaient plus aux nouvelles règles et reflétaient des pratiques passées. Plusieurs mois de réflexion et de modifications ont été nécessaires pour mettre toutes ces notices à niveau et éviter ainsi les inconvénients de la migration précipitée précédente. En effet, à l’époque du passage au système Aleph, les données avaient été migrées telles quelles, et les processus de l’ancien système reproduits dans le nouvel environnement sans modifications étant donné l’urgence du changement. Le passage rapide au nouveau système a provoqué une baisse marquée de productivité pendant plusieurs mois, ce qui a créé beaucoup de frustrations dans l’équipe de catalogueurs. Les tâches se sont alourdies sans bénéfices tangibles pour l’équipe. Forts de cette expérience, beaucoup d’efforts et de réflexions ont été mis dans la révision des chaînes de travail à la DTDM pour les adapter au nouvel outil WMS, avec ses forces et ses limites.

Le plus grand défi du déploiement de la PPS pour les catalogueurs, le catalogage collaboratif ! Depuis toujours, ou presque, le catalogage collaboratif se pratiquait par la dérivation de notices de partenaires du BCI ou autres établissements reconnus dans le catalogue local grâce au protocole Z39.50 avec, théoriquement, le moins de personnalisation possible comme le préconisait la Politique-cadre (GTTD, 2005). Dans les faits, la majorité des établissements adaptait les notices dérivées selon ses procédures et pratiques locales. Avec la PPS et les notices WorldCat, les interventions autorisées dans les notices se font selon des principes dictés par OCLC (OCLC, 2020) et adaptés par le BCI pour convenir au contexte francophone (Partenariat des bibliothèques universitaires du Québec, s. d.).

Au départ, puisque le travail s’effectue directement dans WorldCat, les catalogueurs de la DTDM ont été déstabilisés devant le grand choix de notices et par tant de différences dans la qualité et l’exhaustivité des métadonnées de celles-ci. Changement de paradigme majeur pour les catalogueurs, les notices qu’ils créent, qu’ils modifient ou auxquelles ils s’accrochent, ne sont pas « les leurs », mais bien des notices pour tous. En effet, tous les membres d’OCLC ayant un abonnement de catalogage peuvent modifier les notices selon leur jugement sans demander la permission. Ils ont dû s’adapter à ce changement, faire un lâcher-prise, et faire confiance au jugement des catalogueurs des autres établissements du partenariat (PBUQ). La plupart des catalogueurs de la DTDM y sont parvenus en trouvant des avantages à ce travail collaboratif, mais aussi grâce aux travaux préparatoires en vue du passage à la PPS (corrections de notices et changement de la chaîne de travail), à la tradition bien implantée depuis vingt ans, des interventions inutiles, et surtout, à la vision du catalogage à la DTDM qui fait place au jugement du catalogueur. Par contre, la migration vers WMS combinée à la pandémie a précipité la retraite de quatre techniciens en documentation d’expérience au début de l’été 2020. La perte de contrôle de leur « travail » et le travail à distance ont été les raisons invoquées pour leur départ.

Le plus difficile reste cependant à faire, car il faut maintenant arrimer les pratiques de catalogage entre les institutions francophones du partenariat, de tailles et de vocations diverses. Les équipes de traitement sont également de tailles variées. Plusieurs établissements du PBUQ ont de petites équipes qui effectuent plusieurs tâches autres que le catalogage. Ces équipes ont besoin de l’aide et du soutien des plus grandes institutions dans l’établissement des orientations de traitement et la formation, au besoin. Ce travail d’arrimage de longue haleine ne fait que commencer, et les discussions sur le traitement collaboratif quelques fois ardues font place tout doucement à une véritable collaboration comme pour les interventions sur les notices AFNOR (voir tableau 2). Deux ans après le lancement de la PPS, il reste encore beaucoup de travail à faire pour que les pratiques de catalogage locales fortement ancrées dans les habitudes des catalogueurs deviennent réellement collaboratives. Il faudra probablement attendre la prochaine génération de catalogueurs totalement WMS !

Une démarche UdeM pour les autorités

Avant le passage au système Aleph d’Ex Libris en 2012, tous les points d’accès autorisés, les vedettes-matière et les collections saisies dans les notices bibliographiques généraient automatiquement une notice d’autorité squelettique dans la base d’autorité. Les catalogueurs n’avaient que des interventions minimales à effectuer pour compléter ces notices squelettiques, par exemple, en ajoutant la source de l’information et des renvois au besoin. Cette fonctionnalité a été perdue au changement de système et la charge de travail liée à la gestion des vedettes-matière et des autorités a augmenté considérablement à partir de ce moment, créant d’énormes frustrations parmi les catalogueurs.

Afin de réévaluer la gestion des autorités, un groupe de travail est formé avec le mandat d’examiner les pratiques du Service de catalogage dans la création de notices d’autorité et d’établir une démarche cohérente et systématique qui tient compte des besoins des usagers, et qui évite les interventions à la pièce. Après une revue de littérature sur les diverses pratiques nord-américaines et les exigences du programme NACO – Name Authority Cooperative Program, il s’avère qu’il n’y a aucune règle qui oblige la création de notices d’autorité pour tous les points d’accès. Le groupe arrive aussi rapidement à la conclusion qu’une grande majorité des autorités créées pour les vedettes-matière n’auraient pas dû l’être. En effet, les vedettes-matière construites ne nécessitent pas de notice d’autorité. C’est ainsi que la démarche UdeM pour la gestion des autorités s’est développée ; après avoir transcrit et formulé les points d’accès autorisés, la forme doit être vérifiée dans le fichier d’autorité. Si la forme cherchée n’est pas présente dans le fichier d’autorité et que cette forme ne présente pas de conflit, il n’y a pas création d’une notice d’autorité. Une vérification de la forme du point d’accès est aussi effectuée dans le catalogue afin d’intercepter les variations. Cette démarche devient un précurseur des règles de contribution du futur PFAN qui stipulent que les bibliothèques participantes n’ont pas l’obligation d’établir une notice d’autorité pour chaque point d’accès inclus dans une notice bibliographique (PFAN – Règles de contribution, 2021).

Transition vers les métadonnées

En 2012, le PEB est rattaché à la direction de la Bibliothèque de droit et la DTAD change à nouveau de nom pour la Direction du traitement documentaire et métadonnées (DTDM). Ce changement découle du travail effectué par l’équipe de direction des bibliothèques afin de mieux définir les zones de responsabilités de chacune de ses directions pour optimiser le processus décisionnel. Cette révision est plus qu’un changement de nom, elle confirme que la DTDM, en collaboration avec d’autres directions et unités, gère le service de dépôt et de diffusion des thèses et des mémoires électroniques, coordonne le service de dépôt de documents dans la plateforme institutionnelle Papyrus et assure le traitement complet des collections d’objets numériques dans la plateforme Calypso. De plus, la DTDM est responsable de conseiller ou accompagner les facultés, les départements, les chercheurs, de même que les bibliothèques en matière de création et de gestion de métadonnées.

Afin d’assumer ses responsabilités, un poste de bibliothécaire métadonnées à mi-temps est offert à l’équipe de bibliothécaires de la DTDM en 2016. Les nouvelles responsabilités comprennent, entre autres, l’exploration et l’expérimentation de divers schémas de métadonnées non MARC comme DublinCore, TEI, EAD, etc. ainsi que la recommandation de schémas de métadonnées utilisés les plus appropriés pour la description de données de recherche. Une bibliothécaire relève le défi et son portefeuille est remanié afin de lui permettre d’accomplir ses nouvelles tâches. Elle explique ainsi les motivations qui l’ont poussée à relever ce nouveau défi.

Les normes de catalogage descriptif évoluent depuis des siècles et, au fil du temps, guident nos pratiques en prescrivant un ensemble cohérent d’éléments fondamentaux à saisir et en fournissant des instructions sur la manière de formuler les points d’accès aux ressources documentaires. Étant donné la complexité des instructions RDA et, surtout, du modèle conceptuel Library Reference Model (LRM) qui la soutient, l’initiation à notre métier est complexe et parfois ardue. Mais, en revanche, en accomplissant nos premiers pas de catalogueuse, nous pouvons nous appuyer sur un cadre solide et centré sur les besoins des utilisateurs. Ce cadre normatif est un outil qui peut nous guider aussi sur des territoires moins défrichés

Bascik, 2022

À ce premier poste en métadonnées, s’ajoute la redéfinition d’un poste de bibliothécaire catalogueur, laissé vacant par le départ à la retraite de la titulaire, en un poste de bibliothécaire au traitement des ressources numériques. Les nouvelles responsabilités incluent le traitement en lot de notices MARC et autres formats, la conversion et la normalisation de notices structurées selon différents schémas de métadonnées à l’aide d’outils comme MarcEdit, OpenRefine, UseMARCON etc. ainsi que la supervision des équipes de traitement de la DTDM dans Papyrus, le dépôt institutionnel et Calypso, les collections d’objets numériques de l’Université de Montréal.

Forte de l’expérience acquise dans le traitement de la communication savante plus traditionnelle dans Papyrus, la DTDM se tourne vers un nouveau type d’objets numériques : les données de recherche. La Direction des bibliothèques forme en 2019 un groupe de travail sur la gestion des données de recherche dont le mandat est, entre autres, d’appuyer la mise en oeuvre des recommandations qu’il avait déposées plus tôt la même année (Groupe de travail sur la gestion des données de recherche, 2019). Ce rapport recommande notamment que la DTDM explore la mise en place de services de gestions des données de recherche comme la normalisation et la vérification de conformité des métadonnées et l’accompagnement des chercheurs dans les meilleures pratiques en gestion des métadonnées.

En avril 2022, guidée par les principes du catalogage descriptif, la DTDM lance une nouvelle offre de service pour le rehaussement des métadonnées descriptives dans l’espace Dataverse UdeM (Direction des bibliothèques, 2019) et la normalisation des données de recherche de la communauté de l’Université de Montréal. Cette offre de service s’appuie sur un projet pilote, réalisé de concert avec la Direction du soutien à la réussite, à la recherche et à l’enseignement, et qui a révélé le besoin de service de bonification des métadonnées, mais aussi d’un service-conseil à l’organisation des fichiers et à la production de la documentation des données. Le processus de rehaussement des métadonnées Dataverse mis en place comprend la normalisation et l’enrichissement par l’usage des identifiants pérennes, ainsi que le référencement des publications connexes afin d’optimiser la découvrabilité et d’accroître le potentiel de réutilisation des données. Quant au service-conseil, il comprend l’accompagnement personnalisé des chercheurs et vise à formuler des recommandations générales sur les bonnes pratiques associées et la curation des données afin de favoriser leur compréhension, leur reproductibilité et leur réutilisation. L’équipe d’un chercheur ayant bénéficié de ce nouveau service livre ce témoignage.

La diffusion des données de recherche est un élément essentiel à la transmission de connaissance dans le milieu académique. L’équipe de Traitement documentaire et métadonnée de l’Université de Montréal ont été d’une grande aide pour notre équipe de recherche. En effet, Teresa Bascik et Ève Paquette-Bigras, nous ont parfaitement encadrés dans les multiples démarches nécessaires à la diffusion des données. Leurs expertises nous ont notamment permis d’adhérer aux normes quant à l’anonymisation de nos données. En plus d’une efficacité inespérée, l’équipe nous a accueillis avec une courtoisie qui a rendu le processus des plus agréable. C’est avec certitude que mon équipe de recherche et moi allons réutiliser ce service lors de nos prochaines recherches

Équipe de M. Lacourse

Ce nouveau service, qui vient appuyer le travail de première ligne effectué par les bibliothécaires disciplinaires, a été fort bien reçu par ceux-ci.

En collaborant avec Teresa Bascik et Rafael Rangel Braga de la Direction du traitement documentaire et métadonnées, j’ai rapidement constaté à quel point leur expertise s’avère complémentaire à celles des bibliothécaires disciplinaires. Leur fine connaissance des ontologies et des banques de terminologie disponibles leur sera très utile pour assister les chercheurs de diverses façons, entres autres lors de la rédaction du plan de gestion des données, ou dans l’organisation des données, des dossiers et des fichiers de données. Leur expertise leur permettra de conseiller adéquatement les chercheurs en leur suggérant les ressources les plus appropriées pour décrire les données de recherche dans leur domaine, en fonction du niveau de précision ou de granularité requis

Patrice Dupont, bibliothécaire disciplinaire, Pharmacie et pharmacologie et pour Optométrie, ophtalmologie et sciences de la vision

L’expérience acquise dans l’élaboration de cette offre de service a aussi permis à la DTDM de s’engager dans la communauté de pratique canadienne en curation de données et de participer au Groupe de travail sur les métadonnées Dataverse Nord, soutenu par l’Alliance de recherche numérique du Canada. Les travaux de ce groupe ont mené à la publication du Guide des pratiques exemplaires sur les métadonnées Dataverse Nord (Groupe de travail sur les métadonnées Dataverse Nord, 2021).

C’est également à la suite de l’expérience acquise dans le traitement des documents du dépôt institutionnel Papyrus qu’en 2018 la DTDM amorce un autre chantier d’envergure ; le développement d’une base de données interopérable et spécifiquement adaptée à la description et à l’exploitation des marques de provenances, issues de nos collections patrimoniales. Le schéma de métadonnées a été élaboré pour saisir la richesse des données de provenance, reconstruire la circulation de notre patrimoine documentaire entre leurs possesseurs à une époque et dans un lieu donné et, ultimement, reconstruire l’histoire contextuelle à travers cet itinéraire géographique et intellectuel. Les processus de saisie et de normalisation des données de provenance ont été entièrement élaborés par la DTDM pour le logiciel ContentDM, outil utilisé pour la diffusion des objets numériques à la Direction des bibliothèques, Calypso. Les métadonnées pourront éventuellement permettre de diffuser les marques de provenances en données liées.

Le logiciel ContentDM, outil entièrement basé sur le schéma Qualified Dublin Core, a également été utilisé dans le cadre d’un projet pilote de dépôt et diffusion de Ressources éducatives libres (REL) à l’Université de Montréal. Ce projet s’inscrit dans l’initiative de la fabriqueREL visant la promotion des ressources éducatives libres et la démocratisation des savoirs (fabriqueREL, s. d.). La DTDM participe aux travaux du groupe de travail composé des bibliothécaires et des conseillères pédagogiques des universités dont les membres ont conçu un schéma de métadonnées exclusivement destiné aux REL et adapté à la réalité québécoise (Bourque et al., 2021) (voir figure 3).

Figure 3

Ressource éducative libre diffusée dans Calypso, collections d’objets numériques

Toujours en évolution

Ces derniers projets de structuration de description de diverses ressources auxquels la DTDM a participé confirment que la direction s’est résolument engagée dans la concrétisation des responsabilités confiées par la Direction des bibliothèques en 2012. Ils sont l’aboutissement du travail effectué depuis près de 20 ans et attestent de la transition amorcée par la Direction du traitement documentaire et métadonnées, d’un catalogage exclusivement dit « classique » et centré sur le format MARC21 vers un traitement documentaire plus large faisant appel à d’autres schémas de métadonnées.

Les prochaines années verront cette transition s’accélérer. En effet, l’implication de la DTDM dans la gestion des données de recherche se poursuit avec la participation de ses bibliothécaires à des ateliers de formation de chercheurs en collaboration avec les bibliothécaires disciplinaires. Le contrôle d’autorité et l’utilisation d’identifiants pérennes, adoptés depuis des décennies par les catalogueurs, seront au coeur du projet pilote Wikidata pour les entités d’auteurs mené en collaboration avec Bibliothèque et Archives Canada. Enfin, la participation à des projets d’équité, diversité et d’inclusion dans le traitement comme la révision et la traduction de vocabulaires plus respectueux de toutes les communautés, ou encore, la définition de bonnes pratiques pour la description des documents accessibles, sont autant de projets de traitement faisant appel à l’expertise de la DTDM.

Le traitement documentaire d’aujourd’hui s’appuie sur l’expertise des catalogueurs, spécialistes des métadonnées, pour structurer et normaliser les descriptions de ressources, fournir des métadonnées de qualité permettant d’offrir des services hors du cadre traditionnel des systèmes de bibliothèque, en collaboration avec des partenaires institutionnels, externes, et la communauté en général.

Appendices

Notes biographiques

Teresa BASCIK est bibliothécaire responsable de la normalisation à la Direction du traitement documentaire et métadonnées de l’Université de Montréal. Tout en soutenant le traitement documentaire traditionnel, elle s’intéresse aux métadonnées des ressources diffusées à travers différentes plateformes numériques de la Direction des bibliothèques de l’Université de Montréal. Elle s’intéresse aux normes émergentes favorisant l’accessibilité, la découverte et la réutilisation des données de recherche et est membre Groupe sur les métadonnées Dataverse de l’Alliance de recherche numérique du Canada.

Julie CARDINAL est directrice du traitement documentaire et métadonnées à la Direction des bibliothèques de l’Université de Montréal depuis 2010. Elle participe activement depuis plusieurs années à des initiatives portant sur l’utilisation de données structurées, dont les plus récentes sont la création du Programme francophone des autorités de noms (PFAN), le nouveau modèle de gouvernance pour un Répertoire de vedettes-matière (RVM) ouvert et gratuit et l’implantation de la Plateforme partagée de services dans l’ensemble des bibliothèques universitaires québécoises en 2020. Elle oeuvre aussi au sein de comités nationaux portant sur les identifiants pérennes et sur les données d’accessibilité.

Bibliothécaire depuis presque vingt ans au sein de la Direction des bibliothèques de l’Université de Montréal, Alexandra HOUDE a toujours travaillé derrière la scène aux services internes. Elle a commencé sa carrière à la gestion des ressources électroniques, ensuite aux acquisitions des périodiques pour se diriger vers le catalogage pendant presque une décennie. Elle a occupé des mandats dans des comités et des organisations pancanadiennes (RCDR) pour diversifier son expérience et ses connaissances. Elle est cheffe à la Direction du traitement documentaire et métadonnées depuis février 2019.

Bibliographie

- Baker, T. (2000). A Grammar of Dublin Core. D-Lib Magazine, 6(10). http://www.dlib.org/dlib/october00/baker/10baker.html

- Boisvert. C., Buono, R., May, L., Plourde, M. (2004, 25 octobre). Le PROJET TRAP : une expérience de coopération traitement partagé entre les bibliothèques universitaires québécoises [présentation PowerPoint]. 31e Congrès de l’ASTED, Québec. https://fr.slideserve.com/yovela/le-projet-trap

- Bourque, M., Bascik, T., Dubé, M. et al. (2021). Guide des métadonnées REL : Recommandations du groupe de travail sur les métadonnées de la fabriqueREL. http://hdl.handle.net/11143/18903

- Comité sur les thèses électroniques. (2008). Rapport du Comité sur les thèses électroniques. Conseil de la Faculté des études supérieures et postdoctorales (CONFESP), Université de Montréal. https://esp.umontreal.ca/fileadmin/esp/documents/Faculte/Publications/1rapport-theses-electroniques-FESP-2008-2.pdf

- Côté, J.-P. (2001, 26 septembre). Communiqué de M. Jean-Pierre Côté [document inédit]. Direction des bibliothèques, Université de Montréal

- CREPUQ. (2006). Partager une vision commune. Rapport biennal 2003-2004 et 2004-2005. https://collections.banq.qc.ca/ark:/52327/1865098

- Direction des bibliothèques. (2015, 4 décembre). Une bibliothèque virtuelle partagée pour les universités québécoises [communiqué]. https://bib.umontreal.ca/communications/nouvelles/nouvelle/une-bibliotheque-virtuelle-partagee-pour-les-universites-quebecoises

- Direction des bibliothèques. (2019, 5 septembre). Dataverse UdeM : partager vos données de recherche, c’est facile ! [communiqué]. https://bib.umontreal.ca/communications/nouvelles/nouvelle/dataverse-udem-partager-vos-donnees-de-recherche-cest-facile

- Direction des bibliothèques. (2018, 19 septembre). Diffusez vos travaux et publications dans Papyrus en quelques clics ! [communiqué]. https://bib.umontreal.ca/communications/nouvelles/nouvelle/20180919-ta-travaux-publications-papyrus

- Direction des bibliothèques. (2014). Nouvelle ère pour les collections, Consultation 2014. Université de Montréal. https://bib.umontreal.ca/communications/grands-dossiers/collections-nouvelle-ere/consultation-2014

- Direction des bibliothèques. (2001). Rapport annuel 2000-2001. Université de Montréal. https://bib.umontreal.ca/public/bib/communications/rapport-annuel-2000-2001.pdf

- Direction des bibliothèques. (2002). Rapport annuel 2001-2002. Université de Montréal. https://bib.umontreal.ca/public/bib/communications/rapport-annuel-2001-2002.pdf

- Direction des bibliothèques. (2007). Rapport annuel 2006-2007. Université de Montréal. https://bib.umontreal.ca/public/bib/communications/rapport-annuel-2006-2007.pdf

- Direction des bibliothèques. (2010). Rapport annuel 2009-2010. Université de Montréal. https://bib.umontreal.ca/public/bib/communications/rapport-annuel-2009-2010.pdf

- Direction des collections. (2015). Bilan du projet pilote d’achat initié par l’usager (PDA) [document inédit]. Direction des bibliothèques, Université de Montréal

- Dublin Core Metadata Initiative (DCMI) (2020, 20 janvier). DCMI Metadata Terms. Dublin Core Metadata Innovation. http://dublincore.org/documents/dcmi-terms/fabriqueREL. (s. d.). Les ressources éducatives libres (REL).https://fabriquerel.org/

- Gregor, D. et Mandel, C. (1991). Cataloging must Change ! Library Journal, 116(6), 42-47. https://search.ebscohost.com/login.aspx?direct=true&db=buh&AN=107508031&lang=fr&site=ehost-live

- Groupe de travail sur la gestion des données de recherche (2019, 28 mai). Rapport et recommandations du Groupe de travail sur la gestion des données de recherche [document inédit]. Direction des bibliothèques, Université de Montréal

- Groupe de travail sur le traitement de la documentation. (2009). Liste de produits faisant l’objet d’ententes de traitement partagé. CREPUQ. https://collections.banq.qc.ca/ark:/52327/1871684

- Groupe de travail sur le traitement de la documentation. (2005, décembre). Politique cadre pour le traitement de la documentation dans les bibliothèques universitaires québécoises. CREPUQ. https://collections.banq.qc.ca/ark:/52327/1867255

- Groupe de travail sur le traitement de la documentation. (2004). Politique commune pour le traitement des monographies électroniques accessibles en ligne dans les bibliothèques universitaires du Québec. CREPUQ. https://collections.banq.qc.ca/ark:/52327/1867277

- Groupe de travail sur le traitement de la documentation. (2007b, 10 octobre). Politique commune pour le traitement des périodiques électroniques accessibles en ligne dans les bibliothèques universitaires du Québec. CREPUQ. https://collections.banq.qc.ca/ark:/52327/1870307

- Groupe de travail sur le traitement de la documentation. (2007a, 15 mars). Politique commune pour le traitement des ressources intégratrices électroniques accessibles en ligne dans les bibliothèques universitaires du Québec. CREPUQ. https://collections.banq.qc.ca/ark:/52327/1867257

- Groupe de travail sur le traitement de la documentation. (2000b, 24 mars). Politique commune pour le traitement des ressources Internet dans les bibliothèques universitaires du Québec. CREPUQ. https://collections.banq.qc.ca/ark:/52327/1867550

- Groupe de travail sur le traitement de la documentation. (2003). Programme de partage de la responsabilité du traitement de la documentation électronique (Projet TRAP) : ententes et modalités du partage de la responsabilité du traitement et du suivi des mises à jour des collections électroniques acquises en commun. CREPUQ. https://collections.banq.qc.ca/ark:/52327/1867537

- Groupe de travail sur le traitement de la documentation. (2000a, 3 février). Traitement des périodiques électroniques : lignes directrices pour le partage des responsabilités de traitement des périodiques électroniques entre les bibliothèques universitaires québécoises. CREPUQ. https://collections.banq.qc.ca/ark:/52327/1867639

- Groupe de travail sur le traitement de la documentation. (1997). Vers une politique cadre pour le traitement de la documentation dans les bibliothèques universitaires du Québec. CREPUQ. https://collections.banq.qc.ca/ark:/52327/1867626

- Groupe de travail sur les métadonnées Dataverse Nord. (2021). Guide des pratiques exemplaires sur les métadonnées de Dataverse Nord. https://doi.org/10.5281/zenodo.5576431

- Hickey, T.B. (2001). Collaboration in CORC. Journal of Internet Cataloging, 4(1-2), 5-16. doi.org/10.1300/J141v04n01_02

- Joanis, M. (2000, octobre). Pour une nouvelle Direction du catalogage [document inédit]. Direction des bibliothèques, Université de Montréal

- Latour, P et Vaillancourt, J. (2000, mai). Rapport sur la participation au projet CORC [document inédit]. Service de catalogage, Université de Montréal

- Library of Congress. (2006). Series at the Library of Congress : June 1, 2006. https://www.loc.gov/catdir/cpso/series.html

- Mandel, C. (1991). Cataloging for Access. The Reference Librarian, 15(34), 61-68. doi.org/10.1300/J120v15n34_08

- OCLC. (2020, 22 juillet). Formats et normes bibliographiques.https://help-fr.oclc.org/Librarian_Toolbox/Bibliographic_formats_and_standards?sl=fr

- OCLC. (2021, 8 octobre). Ajouter des vedettes-matière équivalentes. Contrôle des vedettes. https://help-fr.oclc.org/Metadata_Services/WorldShare_Record_Manager/Bibliographic_records/MARC_21_view/Control_headings?sl=fr#Add_equivalent_subject_headings

- Paré, F.X. (2005). SFX à l’Université de Montréal [présentation PowerPoint]. Corporation des bibliothécaires professionnels du Québec. https://papyrus.bib.umontreal.ca/xmlui/handle/1866/27

- Partenariat des bibliothèques universitaires du Québec. (2019, 11 octobre). Le Bureau de coopération interuniversitaire annonce la création d’un partenariat des bibliothèques universitaires québécoises [communiqué]. https://www.bci-qc.ca/wp-content/uploads/2019/10/2019-10-11-Communique-Lancement-partenariat-biblio-univ-Qc.pdf

- Partenariat des bibliothèques universitaires du Québec (PBUQ). (s. d.). Groupes de travail PPS, Groupe de travail sur le traitement des ressources documentaires (GTTRD). BCI. https://biblios-uni-qc.org/instances/comites-et-groupes-de-travail-de-la-pps-2/groupes-de-travail-pps/#1622839710137-aeee3f36-4d8e

- PFAN – Règles de contribution. (2021, 20 avril). Dans PFAN – Programme francophone des autorités de noms. https://wiki.gccollab.ca/PFAN_-_R%C3%A8gles_de_contribution

- Réseau canadien de documentation pour la recherche. (s. .d.). Historique du RCDR. https://www.crkn-rcdr.ca/fr/historique-du-rcdr

- Service de catalogage. (2001). Rapport d’activités 2000-2001 [document inédit]. Direction des bibliothèques, Université de Montréal.

- Université de Montréal. (2008, 10 juin). Commission des études. Procès-verbal de la 1014e séance. https://secretariatgeneral.umontreal.ca/public/secretariatgeneral/documents/proces_verbaux/commission_etudes/2007/CDE1014_10-06-08_000_01.pdf

List of figures

Figure 1

Bordereau de traitement dans Papyrus pour un chapitre de livre

Figure 2

Évolution d’achats de monographies imprimées vs nombre de commis sur 20 ans

Figure 3

Ressource éducative libre diffusée dans Calypso, collections d’objets numériques

List of tables

Tableau 1

Évolution du nombre de titres de ressources électroniques cataloguées par année