Abstracts

Résumé

Lorsque des économies d’échelle et de gamme sont simultanément présentes, le regroupement des établissements tend à réduire les coûts. Puisque de nombreuses études empiriques ont déjà établi que les coûts des banques tendent à devenir proportionnels au-delà d’une certaine taille, il y aurait une limite à ces économies d’échelle et de gamme dans l’industrie bancaire. Nous étudions si l’important processus de fusions des caisses Desjardins et des caisses acadiennes entrepris en 1998 les a poussées au-delà de leur seuil minimal d’efficacité. Une analyse initiale à l’aide du lissage exponentiel montre que le coût moyen d’opération cesse de diminuer lorsque l’actif d’une caisse atteint 250 millions de dollars. Nous effectuons cependant une analyse plus formelle à l’aide de la méthode du Data envelopment analysis (DEA) et utilisons un résultat de Fortin et Leclerc (2006) pour décomposer les économies de gamme en efficacité d’échelle et en une mesure de convexité de la fonction de production. En combinant cette décomposition avec les méthodes maintenant bien connues pour calculer l’efficacité d’échelle avec le DEA, nous montrons que la plupart des fusions ont amené la caisse fusionnée à une taille telle qu’elle se situe en situation de rendement d’échelle décroissant. La recherche de la taille optimale ne semble donc pas être la première préoccupation dans la décision de fusion.

Abstract

When both economies of scale and scope are simultaneously observed, merger tends to reduce costs. Numerous empirical studies have already established that beyond a certain size, banks’ costs tend to become proportional, thus establishing a limit to economies of scale and scope. We verify if the important merger process of Desjardins and Acadian credit unions started in 1998 pushed them beyond the more efficient scale size. An initial analysis, using exponential smoothing, show that the average operating cost stops decreasing when the asset reaches 250 million Canadian dollars. A more formal analysis, using a Data envelopment analysis model is applied to the data set. Our empirical approach applies the method proposed by Fortin & Leclerc (2006) to decompose economies of scope into scale efficiency and a measure of the convexity of the production function. The search for optimal size does not seem to be the first concern in the decision to merge.

Article body

Introduction

Peu de recherches ont été menées sur le thème des économies d’échelle et de gamme dans les institutions bancaires canadiennes. La structure de l’industrie, caractérisée par la dominance des six plus importantes banques et un petit nombre d’entreprises, explique cette situation. Deux stratégies ont été utilisées pour contourner le problème de la petite taille de l’échantillon. La première, utilisée par McIntosh (2002) et Allen et Liu (2005), consiste à travailler avec des séries chronologiques sur les grandes banques à charte canadiennes. L’autre stratégie exploite les données des coopératives de services financiers, les caisses populaires et les credit unions, qui sont nettement plus nombreuses. Protégées par leur structure de propriété, ces coopératives ont en effet résisté à la vague de prises de contrôle qui a permis aux banques à charte d’absorber une bonne partie des autres institutions financières. On peut donner en exemple de cette approche les travaux de Murray et White (1983) sur les credit unions de la Colombie-Britannique et ceux, plus récents, de Fortin, Leclerc et Thivierge (1999, 2000) portant sur les données de 1995 de plus de 1200 caisses populaires acadiennes et québécoises. Dans les deux cas, les auteurs concluent en la présence d’importantes économies de gamme (liées à la diversification des produits) et d’échelle (tirées de la taille) dans ces coopératives financières canadiennes. Notamment, on remarquait que même les plus grosses caisses de l’époque, dont l’actif avoisinait 250 M$, pourraient réduire leurs coûts moyens en fusionnant.

Puisque la présence simultanée des économies d’échelle et de gamme favorise la concentration (Murray et White, 1983 : 890-891), le programme de consolidation des caisses populaires entrepris par Desjardins et la Fédération des caisses populaires acadiennes en 1998 pourrait s’expliquer par la structure de coût. Le réseau des Caisses Desjardins et des caisses acadiennes a d’ailleurs vu un grand nombre de fusions en quelques années de telle sorte que de 1998 à la fin de 2006, le nombre de caisses est passé de 1282 à 547. Ce nombre correspond à peu de choses près à l’objectif initialement annoncé par la haute direction de ces deux fédérations de coopératives de services financiers. Combinées avec la croissance de l’actif total, les fusions ont eu un impact majeur sur la taille moyenne de ces institutions. Ainsi, pendant cette période de 8 ans, l’actif moyen des caisses populaires est passé de 43,4 à 162 M$ tandis que l’actif de la plus grosse caisse atteignait 1,4 G$.

Dans une excellente recension des études empiriques, Amel, Barnes, Panetta et Salleo (2004) concluent qu’au-delà d’un certain seuil, les coûts des banques tendent à devenir proportionnels. En raison de la forte progression de l’actif moyen des caisses depuis 1998, il est possible que les caisses aient atteint une taille telle que poursuivre plus avant le processus de fusions ne permettra pas de réductions de coûts additionnelles. C’est à cette question que nous tentons d’apporter une réponse. Ce genre de résultats peut également contribuer aux discussions sur le dossier des fusions des institutions bancaires. Bien entendu, les résultats obtenus au niveau des succursales n’indiqueront pas si la fusion de deux banques canadiennes de grande taille réduira leurs coûts moyens. Ils fourniront cependant des indications sur les économies possibles de coûts si la banque fusionnée procède à une rationalisation de son réseau de succursales.

Par ailleurs, Amel, Barnes, Panetta et Salleo (2004) concluent aussi que «... more detailed data at the firm level are needed to measure accurately scale and scope economies... » (p. 2514). Dans cette recherche, nous voulons justement exploiter des données sur un plus grand nombre de produits, en particulier les produits transactionnels, pour vérifier l’impact de différentes définitions de la production bancaire sur le résultat des tests concernant la présence d’économies d’échelle et de gamme dans l’industrie bancaire canadienne.

Dans la première section de ce texte, nous présentons la relation entre la taille des caisses populaires et leurs coûts d’opération. La section suivante est consacrée aux techniques de mesure des économies d’échelle et de gamme dans une approche non paramétrique. En troisième lieu, nous présentons la banque de données, les résultats et leur analyse.

1. Relation entre les coûts d’opération et la taille

Le réseau des caisses populaires acadiennes et québécoises regroupe des coopératives de services financiers de taille très variable. En 2006, la plus petite caisse avait un actif de 4 M$ alors que celui de la plus grande était de 1,4 G$. Le processus de rationalisation se poursuit toujours puisque, durant la période 2004-2006, 50 fusions impliquant 113 caisses locales ont été négociées. (Voir tableau 1.) De ce nombre, une forte majorité (78 p. cent) impliquait seulement deux coopératives.

Tableau 1

Profil des fusions de caisses, 2004-2006

Cette grande hétérogénéité de taille se répercute sur le coût d’opération moyen de l’organisation, soit les sommes consacrées au personnel et au capital physique, c.-à-d. aux immeubles et aux équipements. Afin d’illustrer l’important impact de la taille des caisses sur leurs coûts d’opération, le graphique 1 présente la relation entre les dépenses d’opération par dollar d’actif et l’actif total. Afin d’amoindrir l’effet de la variabilité individuelle des coûts, ou en d’autres mots pour atténuer le bruit, nous avons lissé le coût d’opération moyen à l’aide du lissage exponentiel simple calculé sur le coût d’opération par dollar d’actif trié selon l’ordre croissant de l’actif. Pour éviter le déphasage de la série lissée, nous avons calculé la moyenne des résultats obtenus en appliquant deux fois de manière symétrique le lissage exponentiel[1].

Graphique 1

Dépenses d’opération lissées par dollar d’actif

La série lissée montre que la dépense d’opération par dollar d’actif a une forme en U typique des situations où les économies d’échelle s’épuisent. Cette dépense se situe à 0,027 $ par dollar d’actif pour les très petites caisses mais diminue ensuite de façon monotone jusqu’à 0,0202 $ pour les caisses d’environ 400 M$ avant de remonter par la suite légèrement jusqu’à atteindre une dépense à 0,0206 $ par dollar d’actif pour les plus grandes caisses. Cette analyse visuelle suggère que la taille minimale d’efficacité des caisses locales se situe à environ 400 M$ et qu’une limite aux économies d’échelle serait présente.

Dans la section suivante nous voyons comment l’approche non paramétrique du Data envelopment analysis (DEA) permet de vérifier cette conclusion provisoire.

2. Efficacité d’échelle et de gamme dans une approche non paramétrique

La majorité des études sur la performance des institutions financières est basée sur le DEA, outil de programmation linéaire initialement proposé par Charnes, Cooper et Rhodes (1978). Le DEA consiste à résoudre un problème de programmation linéaire sous deux hypothèses, celles de convexité de l’ensemble de production et celle de la libre disposition des facteurs. La première impose que les segments de droite entre des points de l’ensemble soient inclus dans l’ensemble tandis que la seconde est une hypothèse d’absence de nuisance des facteurs de production. On trouve la frontière de cet ensemble en reliant par des segments de droite les unités les plus performantes, soit celles utilisant le moins de ressources pour produire ou encore qui produisent le plus avec les ressources disponibles. La seconde permet de fermer la frontière pour les observations extrêmes[2]. Cette méthode non paramétrique compare chaque entreprise à celles sur la frontière d’efficacité et mesure soit l’excès relatif de coût (approche intrant) ou la perte relative de production (approche production). Le DEA attribue à chaque entreprise un score d’efficacité égal à 1 si elle est efficace (sur la frontière) ou inférieur à 1 si elle est inefficace.

L’exemple du graphique 2 illustre comment on attribue ces scores d’efficacité aux entreprises. Considérons cinq entreprises produisant un output y en utilisant un input x selon les couples indiqués aux points A, B, C, D et E. Si on suppose une technologie à rendement d’échelle variable (REV), la convexité permet de relier les points A, B, D et E par des segments tandis que la libre disposition permet de fermer la frontière par un segment vertical sous A et horizontal à droite de E. Si par contre la technologie est à rendement d’échelle constant (REC), la frontière correspond au rayon passant par le point B, celui où la productivité telle que mesurée par le ratio y/x est la plus élevée et où, par conséquent, la taille optimale d’opération est atteinte.

Graphique 2

Efficacité technique et efficacité d’échelle

Supposons qu’on veuille établir l’efficacité de l’entreprise produisant au point C. L’efficacité étant l’utilisation minimale de l’intrant sur la frontière par rapport à son utilisation actuelle, elle correspond au ratio FC'/FC sous REC. Par contre, sous REV l’efficacité technique est plutôt égale à FC"/FC. La différence entre les deux scores d’efficacité s’explique par le fait qu’au point C, l’échelle de production est trop faible pour permettre de maximiser la productivité. On dira de l’unité C qu’elle peut atteindre le point C" sans changer sa taille, ce qui correspond à son efficacité technique pure. Le gain de productivité rendu possible en augmentant l’échelle de production, qu’on appelle l’efficacité d’échelle (SE pour scale efficiency), est pour sa part égal à FC'/FC", puisqu’il faudrait réduire l’utilisation des ressources jusqu’à C’ pour atteindre une productivité moyenne identique à celle observée au point B. L’entreprise qui produit au point C aurait donc avantage à augmenter sa taille car sa plus grande efficacité d’échelle améliorerait sa performance. Notons par ailleurs que le point C est aussi caractérisé par un rendement d’échelle croissant car la productivité marginale est plus forte que la productivité moyenne. Il peut toutefois arriver qu’une entreprise manifeste de l’inefficacité d’échelle alors qu’elle est en situation de rendement d’échelle décroissant. Sur la même figure, ce serait le cas des entreprises produisant aux points D et E qui, ayant dépassé la taille où la productivité est maximale, augmenteraient leur productivité moyenne en réduisant leur production. On peut consulter Cooper, Seiford et Tone (2007 : 131-162) pour une présentation détaillée de ces concepts.

Mathématiquement, on trouve ces scores dans une approche orientée vers les intrants, c.-à-d. visant la minimisation des inputs étant donné un certain niveau de production, en résolvant le problème suivant de programmation linéaire :

où X et Y sont les matrices des ressources et des produits respectivement, v un vecteur e × 1 de constantes dont chaque élément correspond au poids des différentes unités dans l’établissement de la cible d’efficacité, la colonne i étant l’observation pour la ie unité et e est un vecteur de un. La contrainte e = v = 1 implique alors la convexité tandis que le coefficient θ représente l’efficacité radiale de l’unité i. C’est le rapport entre la quantité de ressources qu’utiliserait l’unité i si elle réduisait proportionnellement l’utilisation de ses ressources pour atteindre la frontière et la quantité de ressources qu’elle utilise réellement. Ainsi, toutes les unités pour lesquelles θ est unitaire sont sur la frontière. Si on contraint ∑vi = 1, où vi est une constante non négative, alors on solutionne le problème du DEA en imposant que le rendement d’échelle est constant. En ajoutant puis retirant cette restriction, on estime le DEA selon des hypothèses de REC et de REV. C’est en comparant les scores d’efficacité ainsi obtenus qu’on peut établir si l’inefficacité technique découle d’une taille inadéquate de l’institution financière ou d’une utilisation exagérée de ressources étant donné sa taille.

Notons par ailleurs que la littérature utilise surtout l’orientation vers les intrants pour mesurer l’efficacité mais que celle-ci peut aussi se mesurer en adoptant une orientation vers l’output. L’efficacité d’une firme serait alors mesurée par le rapport entre la production qu’elle fait actuellement et celle qu’elle pourrait faire si elle produisait efficacement. Sur le graphique 2, l’efficacité de C s’obtiendrait alors en divisant la longueur du segment vertical reliant l’axe horizontal au point C et la longueur du segment vertical qui, partant de l’axe horizontal et passant par le point C, va joindre la frontière. Sous REC les scores obtenus sont les mêmes quelle que soit l’orientation. Sous REV par contre, le score varie selon qu’on adopte une orientation output ou une orientation intrant.

En plus de s’intéresser aux économies d’échelle, la théorie de la production s’est aussi penchée sur la notion d’économies de gamme. Ce concept s’intéresse aux réductions de coûts rendues possibles par la production simultanée de plusieurs produits par une même caisse populaire[3]. Les économies de gamme permettent ainsi de mesurer s’il est moins coûteux que chaque caisse diversifie sa production dans la totalité des produits en comparaison à une spécialisation de chacune dans la production d’un seul produit. Elles mesurent l’écart de coût entre la production disjointe d’une certaine quantité d’un certain nombre de produits et la production jointe de ce même panier de produits.

Nous avons montré dans Fortin et Leclerc (2006) que les économies de gamme globales sont décomposables en deux parties, soit, d’une part, une mesure de convexité de la fonction de production à un niveau donné d’utilisation des intrants et, d’autre part, en économies d’échelle. Nous avons également montré comment effectuer cette décomposition dans une approche DEA. Nous utilisons cette approche pour mesurer l’importance des économies de gamme dans les caisses. Afin de comprendre la manière dont les calculs sont effectués, nous reprenons ici les principaux éléments de la présentation qui se fait dans un modèle orienté vers la production.

Considérons une caisse qui utilise un vecteur de ressources x dont le coût est w'x, où w’ est le vecteur de prix des ressources. Cette caisse peut produire de manière disjointe les biens 1 et 2 aux niveaux respectifs z1 et z2 ou encore effectuer une production jointe efficiente de ces mêmes biens notée (y1, y2). On a donc C(z1) = C(z2) = C(y1, y2) = w’x. Définissons des fractions, λ1 et λ2 telles que λ1 et λ2 = 1 et 0 ≤ λ1 ≤ 1, permettant d’écrire tout point sur la combinaison linéaire convexe des productions disjointes sous la forme (λ1z1, λ2z2). Une constante positive τ permet alors d’exprimer la production efficiente jointe comme une simple expansion proportionnelle de la combinaison linéaire convexe, c’est-à-dire (λ1z1, λ2z2) = τ(y1, y2). La valeur de τ indique comment la production moyenne des firmes spécialisées se compare à celle des firmes diversifiées. Évidemment, si la production efficiente est plus grande que la combinaison linéaire convexe, τ < 1 et la production jointe est moins coûteuse que la production disjointe. Nous appelons τ une mesure radiale des économies de gamme globales. Bien entendu, il n’y aura ni économies ni déséconomies de gamme si C(λ1z1, λ2z2) = w’x donc si τ = 1. Nous allons maintenant voir comment mesurer τ à partir de l’efficacité d’échelle et de l’efficacité technique.

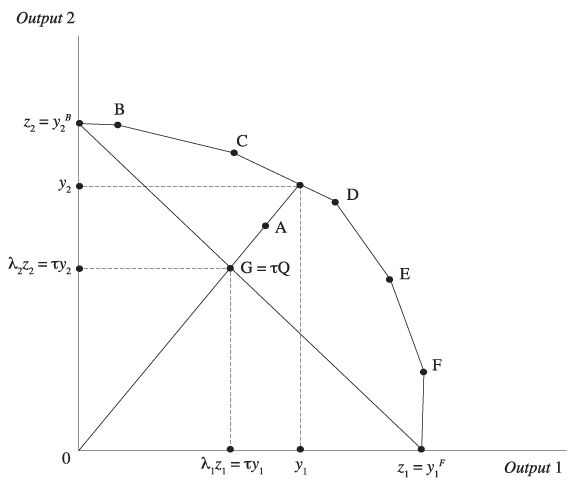

Le graphique 3 illustre le cas de firmes identifiées par A, B, C, D, E et F produisant les biens y1 et y2 dans des proportions différentes en utilisant la même quantité d’un seul facteur de production x. En supposant un ensemble convexe, la frontière DEA est formée des segments de droites joignant la combinaison de production des cinq firmes efficientes B, C, D, E et F. En appliquant l’hypothèse de libre disposition aux deux combinaisons efficientes les plus près des axes, on complète la frontière[4]. La proportion la plus élevée du bien 1 est produite par la firme F, yF1, alors que la firme B produit la proportion la plus élevée du bien 2, yB2. Ainsi, la frontière coupe l’axe des biens 1 et 2 aux points z1 = yF1 et z2 = yB2 qui illustrent la production maximale des biens 1 et 2 lorsque toutes les ressources sont dédiées à un seul bien. La combinaison A est située sous la frontière et correspond donc à une production inefficiente. Puisqu’un accroissement proportionnel de tous les produits est possible pour la firme A, elle peut atteindre un niveau de production (y1, y2) au point Q sur la frontière et son score d’efficience radiale correspond au ratio OA/OQ.

Graphique 3

Mesure des économies de gamme

On peut alors déduire les économies de gamme dont bénéficie une firme diversifiée en comparant un accroissement proportionnel des outputs à une combinaison linéaire convexe de la production des firmes spécialisées. D’un point de vue géométrique, cette combinaison linéaire convexe, le point G dans le graphique 3, se trouve à l’intersection du segment reliant les points (z1, 0) et (0, z2) avec le rayon passant par le point Q. On peut trouver les coordonnées de Q en solutionnant l’ensemble d’équations donné par (λ1z1, λ2z2) = τ(y1, y2), c.-à-d. τy1 = λ1z1 et τy2 = λ2z2 sous la contrainte que λ1 + λ2 = 1. Puisque notre objectif est de mesurer les économies de gamme, nous voulons solutionner cet ensemble d’équations uniquement pour la valeur de τ. Si nous isolons λ1 et λ2 dans chaque équation, de telle sorte que λ1 = τy1/z1 et λ2 = τy2/z2, et que nous additionnons ces deux égalités nous obtenons λ1 + λ2 = τy1/z1 + τy2/z2. Mais puisque λ1 + λ2 = 1, cette égalité devient 1 = τy1/z1 + τy2/z2. En isolant τ, nous obtenons :

Dans le graphique 3, τ est le ratio OG/OQ, d’où le nom économies de gamme radiales. Cette méthode peut être généralisée au cas de m-produits et de rendement d’échelle variable. Le passage au cas d’un rendement d’échelle variable pose cependant un défi particulier. En effet, en rendement d’échelle constant, l’écart dans la quantité d’inputs utilisée par les firmes spécialisées ne modifie pas leur performance. Ce n’est plus le cas avec un rendement d’échelle variable puisque la taille de la firme devient alors une source de différence dans les coûts. Pour les firmes ayant un rendement d’échelle croissant ou décroissant, il faut ajuster la quantité d’inputs et d’outputs pour annuler l’effet de la taille, c.-à-d. les rendre efficientes dans la taille. La stratégie consiste à opérer une transformation de productivité qui annule l’inefficience d’échelle de telle sorte que la nouvelle relation entre les inputs et les outputs est invariante dans la taille. On aura alors :

Une fois cette transformation de productivité effectuée, la mesure des économies de gamme n’est cependant plus directement compatible avec celle de Panzar et Willig (1981). En effet, les firmes spécialisées utilisées dans notre approche opèrent à un niveau de production différent de celui utilisé dans leur définition ce qui peut modifier leur efficience d’échelle. En l’absence d’information sur des firmes spécialisées produisant à l’échelle requise dans la définition de Panzar et Willig, nous ne pouvons pas mesurer leur efficience d’échelle et apporter les ajustements appropriés. Le type de production diversifiée envisagée par Panzar et Willig, et de façon plus générale dans toutes les mesures de sous-additivité de coût, implique un changement dans le niveau d’utilisation des inputs et, ainsi, une possible variation dans l’efficience d’échelle lorsque le modèle DEA a une orientation produits. En d’autres mots, les mesures habituelles de déséconomies d’échelle sont affectées par un possible écart entre l’efficience d’échelle des plus grandes firmes diversifiées et celle des firmes spécialisées. Puisque l’efficience d’échelle peut facilement être mesurée avec le DEA, il est souhaitable de démêler les baisses de coût attribuables à un ajustement du nombre de produits et celles causées par un accroissement des inputs. C’est ce que fait la méthode proposée par Fortin et Leclerc (2006) que nous appliquons ici.

3. Modèle et données

Une institution financière utilise du capital physique constitué de ses locaux et équipements et le travail effectué par ses employés pour offrir des services financiers. La littérature attribue aux dépôts un rôle ambigu dans la production bancaire. Tandis que l’approche d’intermédiation les considère comme un facteur de production additionnel qui est nécessaire au financement des activités de crédit, l’approche production traite plutôt les dépôts comme un produit bancaire, laissant comme seuls facteurs le travail et le capital physique. La difficulté à préciser le rôle des dépôts est problématique car Berger et Mester (1997) ont montré que l’approche intermédiation produit des scores d’efficacité très différents, et en général plus faibles, que ceux obtenus avec l’approche production.

Comme le font remarquer Berger et Mester (1997), l’approche production ne considère que les coûts d’opération tandis que l’approche d’intermédiation, en ajoutant le coût de financement, s’intéresse au coût total. Ils proposent de privilégier un modèle plutôt qu’un autre selon le contexte. L’approche d’intermédiation serait préférable pour analyser la performance globale d’une banque tandis que l’approche production serait souhaitable pour étudier la performance au niveau des succursales. À ce niveau en effet, le gestionnaire a souvent moins de latitude pour choisir ses modes de financement.

Cependant, des critiques plus récentes de l’approche d’intermédiation se sont fait jour. Les auteurs utilisent généralement un nombre restreint de facteurs et de produits apparaissant au bilan pour définir la production et les facteurs de production. Or, selon Becher, Deltas et Pinteris (2006) cette sélection incomplète fait en sorte que les écarts de coûts et de production peuvent découler aussi bien des différences de composition des activités telles que reflétées dans le bilan que des écarts réels de coût résultant d’une gestion inadéquate des banques. Si on considère que les dépôts sont un facteur de production, comme le fait l’approche intermédiation, une banque dont le financement se fait davantage par emprunts semblera utiliser moins de ressources et paraîtra de ce fait plus performante. L’approche d’intermédiation a été également mise en doute dans son application dans les analyses de croissance de la productivité bancaire par Lozano-Vivas et Humphrey (2002). Ceux-ci soutiennent que pour éviter qu’un changement dans la composition du bilan ne modifie la croissance mesurée de la productivité bancaire, tous les éléments apparaissant au bilan doivent être inclus dans la liste des facteurs et produits. Toutefois, Fortin et Leclerc (2007) ont montré que cette solution ne résout par les problèmes de l’approche d’intermédiation pour établir l’efficacité des banques car si tous les éléments du bilan sont intégrés au problème, chaque banque sera nécessairement considérée efficace.

Afin de contourner l’ambigüité du rôle des dépôts, nous avons utilisé un modèle bancaire s’inspirant de la proposition de Fixler et Zieschang (1999) visant à réconcilier l’approche production et l’approche d’intermédiation et qui se base sur la valeur ajoutée par l’intermédiation financière. Cette réconciliation nous fait d’abord passer des comptes du bilan à ceux de l’état des revenus et dépenses. Elle nous amène ensuite à éliminer les fonds utilisés pour le financement des prêts et des placements (dépôts, emprunts et capitaux propres) en évaluant le revenu tiré des activités d’intermédiation en revenu net d’intérêts. Il s’agit alors de mesurer le coût moyen des fonds et de le soustraire du rendement sur les prêts et les placements. Pour éviter de créer un biais en faveur des entreprises mieux capitalisées, il faut appliquer un prix fictif aux capitaux propres. Nous utilisons ici le prix moyen pondéré des emprunts. En 2006 par exemple, le coût moyen de fonds des caisses populaires acadiennes et québécoises était en moyenne égal à 2,6 %. Les relations avec les épargnants sont alors mesurées de deux façons : par l’entremise des activités transactionnelles et par l’inclusion des activités de conseils financiers.

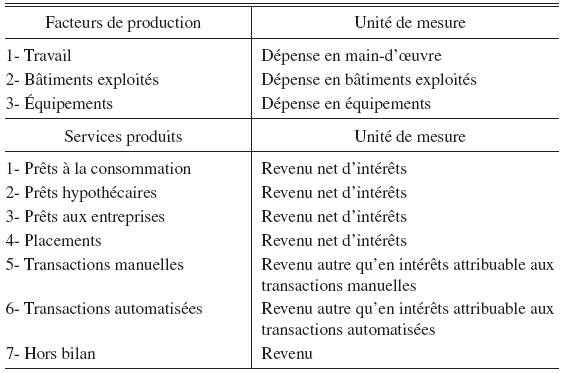

L’institution financière est présentée comme une entreprise qui utilise trois types de facteurs, soit le travail, les locaux et l’équipement, pour produire trois types de services, soit les produits d’intermédiation (prêts et placements), des transactions (manuelles et automatisées) et, finalement, des services conseils[5]. Le tableau 2 présente la liste des variables sans tenir compte des éléments spécifiques à une coopérative et la méthode de mesure. Quelques précisions doivent être fournies pour certaines variables.

Tableau 2

Liste de facteurs et produits

La dépense en main-d’oeuvre comprend les dépenses salariales, les bonis et les avantages sociaux. La décision de diviser en deux variables le capital physique doit être justifiée. Selon nous, en traitant globalement le capital physique, on oublie la relation complexe qui existe entre ces deux types de capital physique. Par exemple, l’entreprise bancaire investit dans les équipements informatiques pour diminuer l’espace consacré à la production des services. Si l’informatisation permet de diminuer la taille des locaux et qu’on traite ces deux variables conjointement, on risque de mal capter la contribution du développement technologique. Le problème est d’autant compliqué que les règles de dépréciation sont différentes pour les locaux et les équipements. Un traitement désagrégé est donc préférable.

La mesure de la dépense pour les bâtiments exploités mérite qu’on s’y arrête pour deux raisons. Premièrement, certaines caisses peuvent ne pas utiliser une partie des locaux possédés pour la production. Deuxièmement, il faut tenir compte de l’aspect location dans l’évaluation du coût des locaux exploités par les caisses. Par exemple, une caisse qui est propriétaire d’un immeuble peut louer une partie des locaux qu’elle n’exploite pas. À l’inverse, il arrive également qu’une caisse loue une partie ou la totalité des locaux qu’elle utilise. Donc, deux ajustements sont nécessaires afin d’évaluer correctement la dépense en bâtiments exploités. Il faut soustraire la dépense en capital immobilier possédé qui n’est pas affecté à l’exploitation et ajouter la dépense pour le stock de capital affecté à l’exploitation qui est loué. Cette façon de procéder pour effectuer ces ajustements est identique à celle employée par Fortin, Leclerc et Thivierge (1999).

Du côté des revenus, une attention particulière doit être accordée au revenu d’intérêts sur les prêts. Le risque de crédit contraint les institutions financières à dépenser pour tenter de recouvrer certains paiements en retard et à radier certains prêts. Lorsqu’on calcule le revenu brut d’intérêts sur les prêts, il faut donc soustraire du revenu d’intérêts les frais de recouvrement et les pertes sur prêts. Cette opération est effectuée pour les trois types de prêts. Rappelons que pour les quatre produits générant des revenus d’intérêts, les trois types de prêts et les placements, nous utilisons les revenus nets d’intérêts c’est-à-dire les revenus d’intérêts dont on a soustrait le coût moyen des fonds.

Pour estimer les revenus associés aux transactions, nous adoptons la démarche suivante. Le système comptable nous donne d’abord le revenu total tiré des transactions. Nous devons ensuite séparer ce revenu en deux catégories : la partie associée aux transactions automatisées et celle attribuable aux transactions manuelles. Les transactions automatisées incluent les paiements par chèques, les dépôts et retraits automatisés, les virements et retraits au guichet automatique, les dépôts salaire, les paiements avec carte de débit, les paiements de factures et les virements AccèsD[6], et le nombre de transactions avec frais fixe d’utilisation. Les transactions manuelles comprennent pour leur part les dépôts et retraits au comptoir, les dépôts au guichet automatique, les paiements de factures au guichet automatique, les paiements de factures AccèsD avec intervention du personnel et les traitements de dossiers (ouverture de compte, renégociation d’hypothèques...). En multipliant le prix de ces transactions par les nombres effectués, nous obtenons le revenu total que la caisse aurait dû tirer de la vente de ces produits. En raison de l’existence de forfaits, ce revenu potentiel est supérieur au revenu réellement touché. Nous devons ajuster le revenu potentiel pour qu’il soit égal au revenu touché, ajustement que nous effectuons par une méthode simple. Une correction à la baisse du revenu potentiel est effectuée en attribuant à chaque produit transactionnel la même proportion du revenu réel que sa part du revenu potentiel. Il suffit alors d’additionner les revenus des différentes composantes des transactions automatisées et manuelles pour obtenir le revenu total tiré de chaque catégorie de transactions.

Finalement, le revenu généré par la composante hors bilan des activités de la caisse correspond au revenu en provenance des sociétés composant le bloc corporatif de Desjardins. Ces sociétés vendent des services de courtage, de gestion du patrimoine et d’assurances.

La banque de données regroupe les caisses populaires acadiennes et québécoises et porte sur la période 2004-2006. Suite aux fusions, le nombre de caisses populaires est passé de 581 en 2004 à 547 en 2006. En travaillant avec des données sur plusieurs années, nous pourrons analyser l’impact de ces fusions sur la situation des entreprises du côté du rendement d’échelle. Trois situations sont possibles : rendement d’échelle croissant (production augmente plus rapidement que la taille), rendement d’échelle constant (production augmente au même rythme que la taille) et rendement d’échelle décroissant (production augmente moins rapidement que la taille).

4. Résultats et analyse

Rappelons que les résultats présentés dans cette section ont été obtenus dans le cadre d’une approche orientée vers les intrants[7]. Regardons en premier lieu les scores d’efficacité et leur décomposition. Le tableau 3 présente les résultats pour trois concepts d’efficience : technique, technique pure et échelle.

Tableau 3

Décomposition des scores d’efficience

On observe d’abord que le score d’efficience technique et ses deux composantes augmentent dans le temps suite aux regroupements des caisses locales[8]. On peut comparer les résultats entre les caisses ayant pris part à une fusion et les autres. Par exemple, si on regarde le cas de l’efficience technique pure pour 2005, on obtient que la croissance du score moyen d’efficience est de 3,5 p. cent pour les caisses n’ayant pas été impliquées dans une fusion et de 10,3 p. cent pour celles ayant été impliquées dans une fusion durant cette année. Ce résultat confirme celui obtenu par Leclerc et Fortin (2004) dans leur analyse de l’impact des fusions sur l’évolution de l’efficience économique des caisses populaires québécoises.

Pour atteindre l’efficience globale en 2006, les caisses devraient augmenter leur score moyen d’efficacité de 21,6 p. cent. Du côté de l’efficience d’échelle, la hausse du score moyen devrait être de 5,4 p. cent. Ainsi, environ le quart de l’inefficience globale s’explique par l’inefficience d’échelle et le reste par l’inefficience technique pure. On peut regarder l’impact des fusions dans cette perspective en comparant, pour les caisses impliquées dans une fusion, le pourcentage des caisses efficientes avant la fusion à celui après la fusion. Nous savons déjà que 113 caisses ont pris part à un processus de fusion durant la période à l’étude. De ce groupe, 28,7 p. cent étaient efficientes avant la fusion. Ce pourcentage augmente à 47,1 après la fusion.

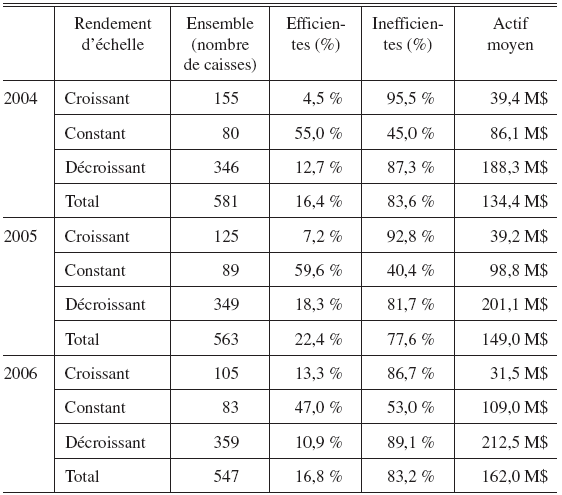

Le tableau 4 répartit les caisses selon le rendement d’échelle et leur score d’efficience. On peut constater, comme il fallait s’y attendre, qu’un très faible nombre de caisses en situation de rendement d’échelle croissant sont considérées efficientes. Le pourcentage de caisses efficientes dans ce groupe varie entre 4,5 en 2004 à 13,3 en 2006. Les fusions entre caisses populaires impliquent souvent des petites caisses ce qui fait diminuer le nombre de caisses en rendement d’échelle croissant (de 155 en 2004 à 105 en 2006) et la taille moyenne des caisses dans cette situation (de 39,4 M$ en 2004 à 31,5 M$ en 2006). À l’autre extrême, le nombre de caisses en rendement d’échelle décroissant augmente de 346 en 2004 à 359 en 2006 et la taille moyenne de ces caisses croît de 188,3 M$ en 2004 à 212,5 M$ en 2006.

Tableau 4

Rendement d’échelle

Il faut pousser un peu plus loin l’analyse des fusions et voir la relation entre la situation des caisses avant la fusion sur le plan du rendement d’échelle et la situation après la fusion. Le tableau 5 présente les résultats à ce sujet. La première colonne identifie les différentes combinaisons de rendements d’échelle des caisses ayant pris part à une fusion durant les années 2004 à 2006. Il s’agit de la situation durant l’année précédant la fusion. Ainsi, l’année 2003 est le point de référence pour les caisses s’étant fusionnées en 2004. Nous avons des cas dans six des sept combinaisons possibles. La seule combinaison pour laquelle nous n’avons pas d’exemple est celle qui aurait impliqué au moins une caisse de chacune des trois situations possibles de rendements d’échelle, c.-à-d. le cas A + B + C selon la légende du tableau 5. La seconde colonne présente le nombre de fusions impliquant des caisses des différentes combinaisons d’économies d’échelle. Les troisième et cinquième colonnes montrent la situation des nouvelles caisses résultant des regroupements au niveau du rendement d’échelle. Sur le plan descriptif, on constate d’abord que la grande majorité des fusions implique des caisses en rendement d’échelle décroissant. En effet, c’est le cas de 43 des 50 fusions réalisées de 2004 à 2006, c.-à-d. 86 p. cent. Pour ces 43 cas, la nouvelle caisse se retrouve en situation de rendement d’échelle croissant 42 fois sur 43. Pour les sept autres fusions, la nouvelle caisse se retrouve dans la même situation cinq fois sur sept. Ainsi, dans 47 cas sur 50 (94 p. cent), le niveau d’activités de la nouvelle caisse dépasse l’échelle de production la plus productive.

Tableau 5

Fusions et rendement d’échelle, 2004-2006

A : Rendement d’échelle croissant

B : Rendement d’échelle constant

C : Rendement d’échelle décroissant

Ce résultat indique que la recherche de l’échelle de production la plus productive ne semble pas être un guide orientant les décisions des dirigeants des caisses populaires acadiennes et québécoises lorsque vient le temps de planifier un projet de regroupement. Cela s’explique probablement par la nature de ces coopératives de services financiers. Le modèle Desjardins de caisses populaires était construit sur la paroisse religieuse et son marché correspond donc à un territoire spécifique. Les fusions vont donc souvent impliquer des caisses opérant sur des marchés adjacents, peu importe le rendement d’échelle de l’organisation.

Quant aux économies de gamme, elles demeurent importantes. Par exemple en 2006, elles représentaient en moyenne 31,4 p. cent (écart-type : 0,0362). Au Canada, les entreprises bancaires diversifiées ont donc un avantage de coût important sur les entreprises spécialisées. Ce résultat explique en partie les tendances à la concentration dans l’industrie des services financiers. Actuellement, ces tendances se poursuivent dans les domaines de la gestion du patrimoine et des assurances générales.

Conclusion

Les résultats de cette recherche montrent que des déséconomies d’échelle importantes sont présentes dans le réseau des caisses populaires acadiennes et québécoises. Elles expliquent environ 25 p. cent du surcoût observé dans ces coopératives de services financiers. Sur la base de ces résultats, nous pouvons donc conclure que le programme de fusions des petites caisses populaires devrait se poursuivre. Puisque notre banque de données est constituée d’organisations en concurrence directe avec les succursales de banques à charte, nos résultats donnent une indication du nombre de fermetures de succursales que pourrait provoquer la fusion des grandes banques à charte canadiennes.

Les résultats montrent aussi que plusieurs fusions donnent naissance à des coopératives qui ont dépassé le niveau optimal d’activités. Il semble donc que le choix des caisses à regrouper ne tient pas suffisamment compte des limites de cette approche. Cette situation est probablement due au fait que les regroupements se font entre caisses opérant sur des marchés géographiquement adjacents. La nature coopérative de l’organisation amène les dirigeants à tenir compte d’autres aspects de sa performance (par exemple, la participation des membres aux activités de la caisse) lorsque vient le temps d’identifier les partenaires potentiels dans un projet de regroupement.

Nous avons vu aussi que la production jointe diminue sensiblement le coût d’opération. On parle d’une économie dépassant 30 p. cent. Une réduction de coût de cette envergure jette un regard nouveau sur les tendances à la concentration observées dans les industries financières canadiennes.

Cette recherche s’inscrit dans le cadre d’un projet plus large sur la comparaison des méthodes d’estimation des économies d’échelle et de gamme dans les institutions bancaires. La richesse de la banque de données sur les caisses populaires nous permet de tester les écarts dans les résultats obtenus dans le cadre des approches paramétrique et non paramétrique. Dans la prochaine étape, nos efforts se tourneront vers le premier type de modèles.

Appendices

Remerciements

Nous remercions Michel Goulet et Jean Ricard de la Fédération des caisses Desjardins du Québec ainsi que Stéphane Cormier de la Fédération des caisses populaires acadiennes pour les données nécessaires à cette étude ainsi que les discussions permettant de bien les interpréter. Cette recherche a bénéficié du support financier du Programme national de recherche sur les institutions financières de la Schulich School of Business, York University.

Notes

-

[1]

Le lissage exponentiel calcule une série lissée m à partir d’une série brute x par la formule mt = axt + (1 – a)mt–1, où a est le paramètre de lissage. Il est facile de montrer que le lissage exponentiel équivaut à une moyenne mobile non centrée à poids décroissant des observations précédentes et de l’observation courante. On peut aussi montrer qu’une moyenne mobile non centrée déphase la série lissée par rapport à la série brute, déphasage qu’on ne peut éviter qu’en calculant une moyenne mobile centrée. Pour obtenir ce centrage de la moyenne mobile nous avons appliqué le lissage exponentiel une seconde fois mais avec l’observation lissée postérieure entrant dans le calcul de la moyenne mobile plutôt que sa valeur antérieure. Algébriquement la seconde série lissée est calculée par la formule axt + (1 – a)mt +1. La série lissée finale présentée dans le graphique 1 est la moyenne des deux séries obtenues par lissage exponentiel, après que les caisses aient été classées en fonction de la valeur de leur actif. Nous avons choisi une valeur de a de 0,02 car il était nécessaire d’atténuer fortement la très grande variabilité individuelle.

-

[2]

Formellement, la convexité signifie que si deux points y1 et y2 appartiennent tous deux à l’ensemble des possibilités de production Y, alors ay1 + (1 – a)y2 ∈ Y, ∀a ∈ [0,1]. La libre disposition signifie pour sa part que si x ∈ V(y), alors x + ε ∈ V(y), ∀ε > 0.

-

[3]

Lorsque défini ainsi, il correspond aux économies de gamme globales (ÉGG) mesurées dans une approche paramétrique (Fortin, Leclerc et Thivierge, 1999 et 2000).

-

[4]

Évidemment, il y a un « manque » de production (output slack) aux points (z1,0) et (0, z2). En considérant ces deux combinaisons comme les paires spécialisées efficaces, on sous-estime la production spécialisée optimale et on surestime par conséquent les économies de gamme. Cependant, en l’absence d’information sur les firmes plus spécialisées que B et F, il est impossible d’inférer la position réelle des firmes complètement spécialisées.

-

[5]

Leclerc et Fortin (2007) ont testé, en appliquant une approche bootstrap, si l’ajout des placements, des deux types de transactions et du hors bilan modifiait de façon significative le score d’efficacité. Dans tous les cas, la contribution était statistiquement significative.

-

[6]

AccèsD est un nom de produit de Desjardins. Ce service permet aux membres d’effectuer des transactions à distance à partir d’un ordinateur ou d’un téléphone à boutons poussoirs.

-

[7]

Les modèles ont été estimés à l’aide du logiciel DEA-Solver-Pro 6.0 de Saitech Inc.

-

[8]

Le gain d’efficacité observé durant la période pourrait, en partie, être attribuable à une diminution du nombre de degrés de liberté. D’une année à l’autre le nombre de caisses diminue ce qui implique une baisse du nombre de degrés de liberté. Ce problème est souligné dans Cooper, Seiford et Tone (2007 : 283-284). Il faut aussi comprendre que la frontière se déplace d’une année à l’autre suite aux changements, entre autres, dans les pratiques de gestion.

Bibliographie

- Allen, J. et Y. Liu (2005), « Efficiency and Economies of Scale of Large Canadian Banks », Bank of Canada Working Paper 2005-13.

- Amel, D., C. Barnes, F. Panetta et C. Salleo (2004), « Consolidation and Efficiency in the Financial Sector: A Review of the International Evidence », Journal of Banking and Finance, 28 : 2493-2519.

- Becher, D. A., G. Deltas et G. Pinteris (2006), « Reconsidering the Degree of Inefficiency of Financial Institutions », Annual Conference on Bank Structure and Competition, Chicago, Il.

- Berger, A. N. et L. J. Mester (1997), « Inside the Black Box: What Explains Differences in the Efficiencies of Financial Institutions? », Journal of Banking and Finance, 21 : 895-947.

- Charnes, A, W. W. Cooper et E. Rhodes (1978), « Measuring the Efficiency of Decision Making Units », European Journal of Operational Research, 2 : 429-444.

- Cooper, W. W., L. M. Seiford et K. Tone (2007), Data Envelopment Analysis: A Comprehensive Text with Models, Applications, References and DEA-Solver Software. 2e édition, New York : Springer.

- Fixler, Denis et K. Zieschang (1999), « The Productivity of the Banking Sector: Integrating Financial and Production Approaches of Measuring Financial Service Output », Canadian Journal of Economics, 32(2) : 23.

- Fortin, M. et A. Leclerc (2006), « An Output Oriented Non Parametric Measure of Economies of Scope », Sherbrooke : Université de Sherbrooke, Groupe de Recherche en Économie et Développement International, 06-22, 22 pages.

- Fortin, M. et A. Leclerc (2007), « Should we Abandon the Intermediation Approach for Analyzing Banking Performance? », Sherbrooke : Université de Sherbrooke, Groupe de Recherche en Économie et Développement International, 07-01, 19 pages.

- Fortin, M., A. Leclerc et C. Thivierge (2000), « Économies d’échelle et de gamme dans les Caisses Desjardins », L’Actualité économique, Revue d’analyse économique, 76(3) : 393-421.

- Fortin, M., A. Leclerc et C. Thivierge (1999), « Estimation des économies d’échelle et de gamme dans de petites coopératives de services financiers: le cas des caisses populaires acadiennes », Annals of Public and Cooperative Economics, 70(3) : 447-75.

- Humphrey, D. B. et B. Vale (2004), « Scale Economies, Bank Mergers, and Electronic Payments: A Spline Function Approach », Journal of Banking and Finance, 28 : 1671-1696.

- Kraft, E., R. Hofler et J. Payne (2002), « Privatization, Foreign Bank Entry and Bank Efficiency in Croatia: A Fourrier-Flexible Function Stochastic Cost Frontier Analysis », Croatian National Bank Working Papers W-9.

- Leclerc, A. et M. Fortin (2004), « Banking Production Measurement, Rationalization and Efficiency of the Caisses populaires Desjardins », dans C. Waddell (dir.) Financial Services and Public Policy, Montréal et Kingston : John Deutsch Institute of the Study of Economic Policy et McGill-Quenn’s University Press, p. 251-288.

- Leclerc, A. et M. Fortin (2003), « Production et rationalisation des intermédiaires financiers : leçons à tirer de l’expérience des caisses populaires acadiennes », Annals of Public and Cooperative Economics, 74(3) : 397-432.

- Lozano-Vivas, A. et D. B. Humphrey (2002), « Bias in Malmquist Index and Cost Function Productivity Measurement in Banking », International Journal of Production Economics, 76(2) : 177-188.

- McIntosh, J. (2002), « A Welfare Analysis of Canadian Chartered Bank Mergers », Canadian Journal of Economics, 35(3) : 457-475.

- Mitchell, K. et N. Onvural (1996), « Economies of Scale and Scope at Large Commercial Banks : Evidence from the Fourier Flexible Functional Form », Journal of Money, Credit, and Banking, 28(2) : 178-99.

- Murray, J. D. et R.W. White (1983), « Economies of Scale and Economies of Scope in Multiproduct Financial Institutions: A Study of British Columbia Credit unions », Journal of Finance, 38(3) : 887-902.

- Panzar, J. C. et R. D. Willig (1981), « Economies of Scope », The American Economic Review, 71(2) : 268-272.

List of figures

Graphique 1

Dépenses d’opération lissées par dollar d’actif

Graphique 2

Efficacité technique et efficacité d’échelle

Graphique 3

Mesure des économies de gamme

List of tables

Tableau 1

Profil des fusions de caisses, 2004-2006

Tableau 2

Liste de facteurs et produits

Tableau 3

Décomposition des scores d’efficience

Tableau 4

Rendement d’échelle

Tableau 5

Fusions et rendement d’échelle, 2004-2006