Article body

Introduction

L’objet principal de cet article est d’offrir une approche du problème de la sélection du mécanisme de vote au sein du conseil des représentants d’une union fédérale. Nous postulons sans expliquer pourquoi (dans cet article) que plusieurs entités autonomes (des pays, des régions, des communes,...) renoncent (on parle alors pudiquement de transferts de compétences) à exercer unilatéralement leur autorité sur tout ou partie des questions de politique économique, sociétale, militaire, diplomatique qui étaient ou qui pourraient relever de leur souveraineté exclusive. Cet article n’est donc pas un article sur le fédéralisme et par conséquent le lecteur ne doit pas s’attendre à y trouver une analyse des gains et bénéfices d’une union fédérale. Nous supposons que l’union fédérale et les questions relevant de ses compétences sont données au départ. De plus, nous supposerons qu’à chaque fois qu’un problème de choix se présente, il se présente de façon binaire, c’est-à-dire que les représentants en charge de prendre la décision n’ont que deux choix possibles : voter pour ou voter contre la proposition formulée. Dans la réalité, l’univers des choix est plus complexe et peut d’ailleurs faire l’objet lui-même de calculs stratégiques[1]. Le modèle que nous avons en tête est donc un modèle très simplifié qui accentue l’affrontement entre deux camps sur chaque question débattue à l’échelon fédéral[2]. En sus de ces simplifications, nous allons nous limiter au cas d’un modèle de décision collective où chaque entité (même si cette entité est elle-même le théâtre de conflits sur les préférences) est représentée par un unique membre dont la préférence reflètera les opinions de son entité (parfois de manière imparfaite ou même biaisée). Pratiquement, il s’agit d’étudier un modèle de « Conseil des ministres » et non un modèle de parlement dont les membres auraient été élus à la proportionnelle et représenteraient donc la diversité des préférences de leur entité d’appartenance[3]. Dans le cas du conseil des ministres, le principe the winner takes all s’applique sans nuances : chaque représentant s’aligne sur la position « dominante » chez ses concitoyens.

Ayant précisé ces limites et réserves, nous pouvons formuler la question fondamentale qui sera au coeur de cet article : étant donné un ensemble d’entités dont certaines décisions, postulées dichotomiques, sont prises par un conseil fédéral où chaque entité est représentée par un unique représentant, quel est le mécanisme de vote le meilleur au regard d’un objectif qui reste à définir ? Il s’agit donc d’une certaine manière d’un problème de mechanism design ou de théorie du choix social dont le champ d’application est circonscrit mais qui couvre un grand nombre de situations réelles. Les auteurs de cet article pensent tout d’abord[4] au conseil de l’Union européeenne, dit Conseil des ministres, qui est une institution (comptant 28 représentants en 2016, et bientôt 27 du fait du retrait annoncé de la Grande Bretagne de l’Union européenne) jouant un rôle de tout premier plan dans la prise de décision des questions européennes. Bien sûr, on ne saurait trop insister sur le fait que le Conseil de l’Union européene ne prend pas seul les décisions[5]. Son pouvoir est contrebalancé par celui du Parlement européen, de la Commission européenne et du Conseil européen. Avant le traité de Lisbonne, le mécanisme de vote était essentiellement un mécanisme majoritaire pondéré avec majorité qualifiée de 260 sur un poids total de 352 (environ 74 %). Les poids de la France et de l’Allemagne y étaient de 29 alors que les poids de la Pologne et de l’Espagne étaient de 27, etc. et celui de Malte de 3. Le traité de Lisbonne a supprimé la pondération arbitraire des voix et instauré un système à double majorité pour l’adoption des décisions. La majorité qualifiée est atteinte si elle regroupe au moins 55 % des États membres représentant au moins 65 % de la population de l’Union européenne. Lorsque le Conseil ne statue pas sur une proposition de la Commission, la majorité qualifiée doit alors atteindre au moins 72 % des États membres représentant au moins 65 % de la population. Un tel système attribue donc une voix à chaque État membre tout en tenant compte de son poids démographique[6]. Ce nouveau système de vote à la majorité qualifiée est applicable depuis le 1er novembre 2014 (mais avec une possibilité d’utilisation du système de vote défini par le traité de Nice au cas par cas jusqu’au 31 mars 2017). Au nom de quelle logique ces poids ont-ils été proposés ? Ce nouveau traité est le nième épisode d’une longue histoire d’âpres discussions et controverses souvent concomitantes aux opérations d’élargissement. Une pétition initiée par des chercheurs a même circulé pour réclamer au nom de la science une représentation des États basée sur la racine carrée de leur population (et non directement sur leur population)[7]. Aujourd’hui mais moins qu’hier le système est complexe car il fait intervenir plusieurs mécanismes de vote qu’une proposition doit passer avec succès pour pouvoir être adoptée : superposer des critères faisant intervenir la population des pays ou leur nombre et des quotas associés rend ainsi plus difficile l’adoption d’une mesure.

À des nuances institutionnelles près, la question ci-dessus se pose dans bien d’autres contextes. Par exemple, elle se pose en France au niveau des structures intercommunales : les communes représentées au sein d’une structure intercommunale n’ont pas toutes le même nombre de délégués et, si tant est que ces délégués votent en bloc par commune, le même poids (voir par exemple Bisson, Bonnet, Lepelley, 2004). Elle se pose aussi indiscutablement au sein des grandes organisations internationales qui prennent des décisions concernant tous les pays membres, comme par exemple le FMI (voir Leech, 2002b). D’une certaine manière, le problème couvert dans cet article est également formellement équivalent à celui d’un pays doté d’un régime présidentiel dominé par deux partis politiques principaux et qui aurait hérité de son histoire une structure fédérale (découpage du pays en États) obligeant l’élection du président à être indirecte et du type « le gagnant d’un État récupère tous les grands électeurs de l’État ». On aura reconnu dans cette description le contexte du collège électoral américain et les modalités d’élection de son président. Même si on maintient le système en l’état, on est en droit de se demander en vertu de quels principes la Californie dispose de 55 grands électeurs alors que le Texas n’en compte que 38 ! On voit donc apparaître au travers de tous ces exemples un dénominateur commun qui prend appui sur la nature de second rang du problème posé : étant donné des frontières naturelles entre entités/districts/États/communes et l’impossibilité conséquente d’organiser un mécanisme de vote direct, quelle est la meilleure façon d’organiser un mécanisme de vote indirect ? Et plus précisement, dans un système de type « conseil des ministres », quel poids doit-on donner à chaque représentant et quel quota doit-on utiliser sachant que le comportement du représentant en réaction aux préférences des membres de son entité est une donnée hors du champ de l’optimisation ? Nous insistons sur le fait qu’au moment où la conception du mécanisme le plus approprié est formulée, l’incertitude concernant les préférences des citoyens des entités n’a pas été levée. Nous ne sommes donc pas à un stade ex post mais à un stade ex ante c’est-à-dire constitutionnel (Rae, 1969; Curtis, 1972; Schofield, 1972) où l’on cherche à mettre en place des règles durables car elles seront utilisées de façon répétée.

Le mot « meilleur » n’est bien sûr pas dépourvu d’ambiguïté. Dans le contexte politique de la dernière illustration, on songe immédiatement à un principe égalitariste (one man, one vote). La voix d’un électeur du Texas doit avoir le même poids que celle d’un électeur de Californie. Similairement, dans le contexte de l’Union européenne, on peut légitimement souhaiter que la voix d’un citoyen polonais compte de la même façon que celle d’un citoyen portugais. Il conviendrait ainsi de faire en sorte que le « pouvoir » d’un électeur (qui reste à ce stade un concept à définir) soit le même quel que soit l’État où il réside. Il reste cependant que dans d’autres contextes, on pourra juger opportun de remplacer cet objectif égalitariste par un objectif utilitariste où les enjeux (stakes) des différents électeurs sont pris en considération[8]. Nous retrouvons de fait, pour juger des qualités d’un mécanisme de vote indirect, un critère très commun en économie publique, à savoir la maximisation de la somme des utilités. On verra alors que la principale implication du critère utilitariste est une version du principe majoritaire où les différentes entités ont des poids différents : le vote majoritaire pondéré. Au nombre des éléments à prendre en compte dans la détermination de la pondération figure naturellement la taille des populations des entités. Une entité plus peuplée devrait jouir d’un poids plus grand mais comment cette prise en compte de la démographie se décline-t-elle dans le détail ? L’idée la plus courante est l’idée de proportionnalité : représenter chaque entité à la hauteur de sa population. La proportionnalité est une idée simple et profonde qui a des racines philosophiques anciennes et nous verrons dans cet article que l’approche développée ici confirme cette intuition de bon sens dans de nombreux cas; en particulier lorsque les préférences des citoyens d’une même entité sont parfaitement corrélées, le vecteur des poids optimaux du point de vue de l’utilitarisme est le vecteur des populations. Naturellement, si les variables poids sont soumises à des contraintes d’intégralité (comme dans le collège électoral américain), il faut arrondir ceux-ci; il y a alors de nombreuses façons de décliner le principe de proportionnalité qui sont loin d’avoir les mêmes propriétés axiomatiques (voir Balinski et Young, 1982; Pukelsheim, 2014). Dans le présent travail, nous nous affranchirons des contraintes entières.

Par ailleurs, il est important de noter que l’objectif utilitariste ne débouche pas nécessairement sur une version aussi simple de la proportionnalité. Il pourra aussi déboucher sur une version dégressive de la proportionnalité lorsque le poids relatif du représentant d’un pays rapporté à sa population décroît en fonction de sa population. Par exemple, nous verrons que dans l’hypothèse extrême où tous les pays sont parfaitement clivés, les poids optimaux dans le cas utilitariste/linéaire évoluent comme la racine carrée de la population. Nous rencontrerons plusieurs autres scénarios qui vont dans cette direction. Notons enfin que dans l’examen d’un problème proche, celui de la détermination du nombre de représentants de chaque pays dans le Parlement européen, le principe de proportionnalité dégressive a fait l’objet d’une étude sous l’autorité d’un panel d’experts qui a débouché sur une règle de proportionnalité dégressive qui se présente comme une solution affine (un poids minimal et une augmentation incrémentale proportionnelle à la population ensuite) appelée « compromis de Cambridge » (Laslier, 2012).

L’article est organisé comme suit. Après avoir présenté formellement le problème de décision collective étudié, la seconde section expose notre scénario canonique, celui de la solution au problème de vote indirect optimal dans le cas où l’objectif est la maximisation de la somme des utilités espérées. Cette solution, dont la version générale est due à Barberà et Jackson (2006), est décrite et comparée à plusieurs autres contributions importantes de même nature. Une discussion de certains aspects de la solution de Barberà et Jackson prolongera son exposé dans la section 2. La section 3 est consacrée à l’examen du problème lorsque nous envisageons d’autres critères que la maximisation de l’utilité pour juger de la pertinence d’une règle de vote indirecte. Dans la section 4, la nature même du modèle canonique est changée : nous présenterons plusieurs contributions pour lesquelles nous abandonnons l’hypothèse de choix dichotomique entre deux options pour des ensembles de décision plus riches.

1. Le mécanisme optimal dans le cas de l’utilitarisme

1.1 Le contexte : électorat aléatoire et mécanisme de vote

Nous souhaitons décrire ici formellement la situation d’une communauté d’entités/districts qui a renoncé à exercer sa souveraineté sur un ensemble de questions. Ces entités peuvent être des pays comme dans le cas de l’Union européenne, ou des États comme dans le cas des États-Unis d’Amérique ou encore des municipalités comme dans le cas des communautés de communes et d’agglomérations françaises. Chaque entité composant cette fédération est peuplée par des individus/citoyens et nous considérons dans cette section comme dans la suivante qu’ultimement, seul le bien-être des citoyens résidant dans ces entités est pris en compte dans l’évaluation de la décision collective. Formellement, la population totale de la « fédération » notée N = {1,2,…,n} est partitionnée en Kdistricts Nk ,k = 1,…,K[9]. Nous noterons nk le nombre de citoyens habitant le district k; on supposera que nk est impair. Ces K districts sont supposés décrire des frontières naturelles et/ou anciennes et nous insistons sur le fait que le redécoupage de ceux-ci n’est pas une variable d’optimisation : la carte des districts est donc exogène.

Nous supposons que les décisions qui s’appliquent à l’échelon fédéral sont prises par un comité composé d’un représentant de chaque district : le comité comprend donc K membres. Nous supposerons par ailleurs que la décision est de nature binaire : pour (codée 1) ou contre (codée 0) une proposition qui est faite pour remplacer le statu quo (et qui, le cas échéant, a été préparée à l’avance en commission). Au sein du comité, les membres devront voter par oui ou par non à la proposition soumise[10]. Nous supposerons que l’abstention n’est pas possible/permise. La décision au sein du conseil est alors décrite par un mécanisme de vote C. Précisément, C est une fonction de {0,1}K dans {0,1}, où C prend la valeur 1 si la proposition est retenue et 0 sinon. Dans le cas où C est monotone, la notion de mécanisme de vote est une notion combinatoire (appelée parfois fonction booléenne) qu’il est commode de décrire de façon équivalente à l’aide de la notion de jeu simple (Shapley,1962; Taylor et Zwicker, 1999), notion importante en théorie des jeux coopératifs et à laquelle est consacré l’appendice.

Outre la carte des districts et les caractéristiques démographiques de ceux-ci, l’input de base est constitué par l’utilité que les différents citoyens retirent de la proposition si elle est retenue ou rejetée. L’espace des états possibles est l’ensemble des profils d’utilités. En normalisant à 0 l’utilité de chaque citoyen dans le cas d’un rejet de la proposition, un état possible est donc un vecteur U = (U1,U2,…,Un) ∈ Rn : le type du citoyen i est un nombre réel Ui décrivant son utilité nette pour l’alternative 1. Une valeur Ui > 0 (respectivement < 0) indique que l’individu i préfère l’option 1 au statu quo 0 (respectivement 0 à 1). Un modèle aléatoire est décrit par une loi de probabilité jointe λ sur l’ensemble des états possibles Rn. Nous noterons Prλ(A) la probabilité de l’événement A ⊆ Rn. On notera λk la marginale du district k et λi la marginale du citoyen i. Le modèle aléatoire λ est dit neutre si pour tout k = 1,…,K et tout ensemble mesurable ![]() ,

, ![]() . Le modèle aléatoire λ est symétrique si pour tout k = 1,…,K et tout ensemble mesurable

. Le modèle aléatoire λ est symétrique si pour tout k = 1,…,K et tout ensemble mesurable ![]() et toute permutation σ de Nk,

et toute permutation σ de Nk, ![]() où

où ![]() tel que u = σ(υ)}. On remarque que si λ est symétrique, alors pour tout k = 1,…,K : E(Uj |Uj ≥ 0) = E(Ui|Ui ≥ 0) et E(Uj|Uj ≤ 0) = E(Ui|Ui ≤ 0) pour tout i, j ∈ Nk. Dans cet article, nous supposerons que les préférences des citoyens sont indépendantes entre districts.

tel que u = σ(υ)}. On remarque que si λ est symétrique, alors pour tout k = 1,…,K : E(Uj |Uj ≥ 0) = E(Ui|Ui ≥ 0) et E(Uj|Uj ≤ 0) = E(Ui|Ui ≤ 0) pour tout i, j ∈ Nk. Dans cet article, nous supposerons que les préférences des citoyens sont indépendantes entre districts.

Le mécanisme de décision comporte donc deux étages (two tier mechanism). Une première fonction décrit comment les préférences des citoyens des différentes entités influencent l’opinion de leurs représentants (notons ici qu’un représentant est décrit par une opinion et non par une utilité). Formellement, ceci est décrit par une fonction m : Rn →{0,1}k; mk (U) = 1 signife que dans le cas du vecteur U, le représentant de l’entité k est en faveur de 1. Nous supposerons que mk ne dépend que du sous-vecteur ![]() . Si le représentant suit l’opinion majoritaire dans son district,

. Si le représentant suit l’opinion majoritaire dans son district, ![]() (on peut alors parler de représentant de type majoritaire). Si en revanche le représentant base son vote sur le critère utilitariste restreint à son district,

(on peut alors parler de représentant de type majoritaire). Si en revanche le représentant base son vote sur le critère utilitariste restreint à son district, ![]() (on peut alors parler de représentant de type utilitariste)[11]. La seconde fonction, notée C ci-dessus, décrit comment les votes des représentants (m1(U),…, mK (U)) = m(U) sont transformés en une décision collective.

(on peut alors parler de représentant de type utilitariste)[11]. La seconde fonction, notée C ci-dessus, décrit comment les votes des représentants (m1(U),…, mK (U)) = m(U) sont transformés en une décision collective.

1.2 Le théorème de Barberà et Jackson

Nous allons nous concentrer ici sur un critère d’optimisation particulier, à savoir la maximisation de la somme des utilités espérées. Faute d’espace, nous n’allons pas à ce stade offrir une défense axiomatique de ce critère de choix social[12].

Ex ante, c’est-à-dire avant de découvrir sa propre (dés)utilité pour l’adoption de la proposition, chaque citoyen i évalue son utilité espérée Wi(C,λ) pour le mécanisme C. Avec les notations ci-dessus :

Le bien-être utilitariste est donc égal à :

Le choix optimal ex post est 1 (respectivement 0) lorsque ![]() (respectivement < 0). Ce choix optimal ne sera pas en général réalisé par le mécanisme considéré. Non seulement toute ou partie de l’information sur l’intensité des préférences disparaît mais la délégation finale de la décision à des représentants ouvre la porte à une différence entre le choix des représentants et le choix à l’échelle de la population toute entière. Nous recherchons ici le (les) mécanisme(s) de vote C maximisant l’espérance totale d’utilité, qui s’écrit :

(respectivement < 0). Ce choix optimal ne sera pas en général réalisé par le mécanisme considéré. Non seulement toute ou partie de l’information sur l’intensité des préférences disparaît mais la délégation finale de la décision à des représentants ouvre la porte à une différence entre le choix des représentants et le choix à l’échelle de la population toute entière. Nous recherchons ici le (les) mécanisme(s) de vote C maximisant l’espérance totale d’utilité, qui s’écrit : ![]() .

.

Par définition :

Puisque, par hypothèse, les utilités sont indépendantes entre districts, l’utilité totale espérée s’écrit plus simplement comme suit :

On déduit de cette expression que si l’on peut trouver un mécanisme C maximisant ![]() , pour toute réalisation possible r = (r1,…, rk) ∈ {0,1}K, ce mécanisme C maximisera, a fortiori, la somme pondérée de ces expressions. On remarque immédiatement que ce mécanisme existe et vérifie :

, pour toute réalisation possible r = (r1,…, rk) ∈ {0,1}K, ce mécanisme C maximisera, a fortiori, la somme pondérée de ces expressions. On remarque immédiatement que ce mécanisme existe et vérifie :

Définissons pour chaque district k les poids suivants :

Avec ces notations, les formules (1) ci-dessus s’écrivent :

ou encore :

où ![]() pour tout k = 1,…, K. Dans le cas particulier où

pour tout k = 1,…, K. Dans le cas particulier où ![]() , les choix 0 et 1 définissent le même niveau d’utilité totale espérée. Rappelons également que bien que le mécanisme soit décrit par un vecteur de poids et un quota, ce qui importe avant tout est l’inventaire des coalitions décisives[13]. On peut donc énoncer le théorème suivant :

, les choix 0 et 1 définissent le même niveau d’utilité totale espérée. Rappelons également que bien que le mécanisme soit décrit par un vecteur de poids et un quota, ce qui importe avant tout est l’inventaire des coalitions décisives[13]. On peut donc énoncer le théorème suivant :

Théorème(Barberà et Jackson, 2006)

Si les utilités sont indépendantes entre districts, les mécanismes C qui maximisent l’utilité totale espérée sont représentés par :

Il convient maintenant de comprendre plus en profondeur à quoi ressemble ce mécanisme optimal et le rôle des différentes hypothèses qui ont permis de dériver ce résultat. Ce qui est très surprenant est que le mécanisme optimal est toujours un jeu majoritaire pondéré alors que la classe des jeux simples concevables est beaucoup plus grande, comme l’illustrent les énumérations reportées dans l’appendice.

Nous dirons que le district k est biaisé avec un biais γk > 0 si :

Le biais d’un district définit la différence entre l’utilité totale espérée du district lorsque son représentant vote 1 et l’utilité totale espérée du district lorsque son représentant vote 0. Dans ce cas le mécanisme optimal est décrit par les poids ![]() pour k = 1,…, K et le quota

pour k = 1,…, K et le quota ![]() .

.

On note que dans le cas où le biais est le même dans tous les districts, noté γ, alors le mécanisme de vote s’écrit simplement :

Le vote « pour » de chaque membre k du comité est affecté d’un poids ![]() qui sera noté (sauf mention contraire) wk dans la suite de cet exposé. Le vote pour la proposition l’emporte si la fraction des poids des supporters dépasse un seuil qui dépend du biais. On remarque au passage que si les districts ne sont pas biaisés, c’est-à-dire si γ = 1, alors le seuil correspond au seuil majoritaire ordinaire de 50 %. Dans la suite, nous nous référerons au vecteur comme étant le vecteur de poids de Barbera Jackson.

qui sera noté (sauf mention contraire) wk dans la suite de cet exposé. Le vote pour la proposition l’emporte si la fraction des poids des supporters dépasse un seuil qui dépend du biais. On remarque au passage que si les districts ne sont pas biaisés, c’est-à-dire si γ = 1, alors le seuil correspond au seuil majoritaire ordinaire de 50 %. Dans la suite, nous nous référerons au vecteur comme étant le vecteur de poids de Barbera Jackson.

On notera que le biais peut avoir deux sources différentes. La distribution de probabilité peut elle-même exprimer un biais en faveur de l’une ou l’autre des options (alors que le représentant n’est pas biaisé en faveur d’une option). Par exemple, si le représentant n’est pas biaisé mais si pour tout i, Ui prend les valeurs -γ < -1 et 1 avec la probabilité ![]() , un vote en faveur de la réforme révèle un gain plus faible que la perte attachée à un vote contre la réforme. Il n’est donc pas surprenant en pareil cas de voir le quota être élevé au seuil de

, un vote en faveur de la réforme révèle un gain plus faible que la perte attachée à un vote contre la réforme. Il n’est donc pas surprenant en pareil cas de voir le quota être élevé au seuil de ![]() : pour défaire le statu quo, il faut une majorité qualifiée de taille suffisante. Mais le biais peut résulter du comportement du représentant. Ce sera le cas par exemple si le représentant du district k vote pour la proposition uniquement si tous les citoyens du district k votent de la sorte.

: pour défaire le statu quo, il faut une majorité qualifiée de taille suffisante. Mais le biais peut résulter du comportement du représentant. Ce sera le cas par exemple si le représentant du district k vote pour la proposition uniquement si tous les citoyens du district k votent de la sorte.

Notons enfin que dans le cas où les représentants sont de type majoritaire, les poids de Barberà-Jackson peuvent être négatifs : le mécanisme optimal n’est pas nécessairement monotone si l’espérance de la somme des utilités dans un district est du signe contraire de la décision de son représentant (majoritaire). Par exemple, dans le cas où le district k est tel que nk = 3 et λ est équiprobable sur les vecteurs (1, 1, -3) et (-1, -1, 3) et leurs permutés, on obtient ![]() . Cette situation pathologique intervient exlusivement dans des cas de modèles aléatoires un peu artificiels comme celui présenté ci-dessus[14]. Dans la suite de cet article nous supposerons que les poids de Barbera-Jackson sont positifs.

. Cette situation pathologique intervient exlusivement dans des cas de modèles aléatoires un peu artificiels comme celui présenté ci-dessus[14]. Dans la suite de cet article nous supposerons que les poids de Barbera-Jackson sont positifs.

Nous supposerons aussi que pour tout j ∈ N, λj n’a pas de masse en 0. Par ailleurs, nous allons laisser de côté la question du biais et supposer, sauf mention contraire, que les représentants des districts sont des représentants de type majoritaire. Précisément, pour ce faire, nous supposerons que le modèle aléatoire λ est neutre[15].

On vérifiera en effet que dans ce cas : ![]() ,

,

![]() pour tout i ∈ Nk et

pour tout i ∈ Nk et ![]() pour tout k = 1,…, K. Par ailleurs, une attention particulière sera accordée à plusieurs cas particuliers importants. Au nombre de ceux-ci, figure le cas binaire qui correspond au cas où pour tout i ∈ N, Ui prend deux valeurs symétriques par rapport à 0 (disons 1 et -1)[16]. Dans ce cas, le mécanisme qui maximise l’utilité totale ex post est le mécanisme majoritaire ordinaire (à un seul étage) : l’espérance de l’utilité totale du mécanisme ex post optimal est donc l’espérance de la taille du groupe majoritaire. En revanche, le mécanisme optimal dans le cas où il y a deux étages et où le représentant suit sa majorité peut produire des décisions collectives très différentes du mécanisme majoritaire, même dans le cas où les districts sont équipeuplés et identiques du point de vue de la loi λ.

pour tout k = 1,…, K. Par ailleurs, une attention particulière sera accordée à plusieurs cas particuliers importants. Au nombre de ceux-ci, figure le cas binaire qui correspond au cas où pour tout i ∈ N, Ui prend deux valeurs symétriques par rapport à 0 (disons 1 et -1)[16]. Dans ce cas, le mécanisme qui maximise l’utilité totale ex post est le mécanisme majoritaire ordinaire (à un seul étage) : l’espérance de l’utilité totale du mécanisme ex post optimal est donc l’espérance de la taille du groupe majoritaire. En revanche, le mécanisme optimal dans le cas où il y a deux étages et où le représentant suit sa majorité peut produire des décisions collectives très différentes du mécanisme majoritaire, même dans le cas où les districts sont équipeuplés et identiques du point de vue de la loi λ.

1.3 Comparaison des mécanismes à l’aide des poids de Barberà-Jackson dans le cas neutre

L’utilité totale W(C; λ) évaluée à l’échelle de la fédération est égale à :

Puisque λ est neutre :

on en déduit :

Or,

Nous déduisons également de la neutralité de λ que le second terme du membre droit de cette égalité vaut ![]() . Le premier terme est égal à la probabilité de succès. Puisque

. Le premier terme est égal à la probabilité de succès. Puisque ![]() pour tout k = 1,…, K et que les votes des différents représentants sont indépendants, on déduit de la formule de Penrose[17] (Dubey et Shapley, 1979; Felsenthal et Machover, 1998 : théorème 3.2.16; Laruelle et Valenciano, 2008c : section 3.6) :

pour tout k = 1,…, K et que les votes des différents représentants sont indépendants, on déduit de la formule de Penrose[17] (Dubey et Shapley, 1979; Felsenthal et Machover, 1998 : théorème 3.2.16; Laruelle et Valenciano, 2008c : section 3.6) :

où Bk (C) désigne l’indice de pouvoir de Banzhaf[18] du représentant du district k dans le mécanisme C. En combinant ces expressions, on déduit que :

L’intérêt de cette formule que l’on trouve dans Beisbart et Bovens (2007) est de mettre en évidence le rôle du vecteur des poids de Barberà-Jackson w(λ) = (w1(λ), w2(λ),…,wK(λ)) dans le calcul de l’utilité totale espérée d’un mécanisme Cquelconque au travers du vecteur des indices de Banzhaf des représentants du conseil. Nous savons d’après Barberà et Jackson que cette expression est maximale lorsque C est le jeu majoritaire pondéré avec un seuil de 50 % et le vecteur de poids w. Beisbart et Bovens offrent une preuve alternative du théorème de Barberà et Jackson exploitant cette formule. Mais l’intérêt principal de la relation (3) est de permettre un classement complet de tous les mécanismes et non uniquement de déterminer le meilleur d’entre eux. À l’aide de cette formule, on peut comparer l’utilité totale espérée des différents mécanismes de vote. Cette analyse est le sujet d’une série d’articles importants de Beisbart, Bovens et Hartmann (2005) et Beisbart et Bovens (2007) sur le Conseil des ministres de l’Europe. Signalons que leur analyse est réalisée dans le cas où les représentants sont des représentants utilitaristes mais la formule ci-dessus n’exploite pas cette hypothèse.

Notons finalement que l’on peut, alternativement, présenter la grandeur caractérisant la qualité/performance d’un mécanisme sous la forme d’un « manque à gagner ». Comme nous l’avons déjà signalé, l’idéal utilitaire serait de maximiser ![]() . Dans ce cas, comme

. Dans ce cas, comme ![]() , l’utilité totale espérée maximale est égale à :

, l’utilité totale espérée maximale est égale à :

On peut donc alternativement résumer le coût social du mécanisme C comme étant égal à :

Ce coefficient correspond à ce que Weber (1978, 1995) définit comme étant l’effectivité[19] du mécanisme de vote C. Nous verrons plus loin une autre normalisation utile.

2. De quoi dépendent les poids de Barberà-Jackson[20] ?

Comme nous venons de le voir, les poids de Barberà-Jackson jouent un rôle de premier plan dans l’analyse comparative des mécanismes de vote au sein du conseil fédéral. L’objet principal de cette section est d’identifier les éléments (tels que décrits par la loi λ) qui poussent à donner plus de poids au vote du représentant d’un district. On anticipe qu’un district plus peuplé recevra un poids au moins aussi important qu’un district moins peuplé mais quelle est la nature exacte de cette relation ? L’intuition suggère par ailleurs que le représentant d’un district consensuel recevra plus de poids que celui d’un district clivé. Nous allons maintenant examiner et quantifier ces idées au travers du calcul formel. Après un exercice de détermination empirique des poids dû à Barberà et Jackson, nous considèrerons une famille large de lois de tirage, qui satisfont à la condition d’échangeabilité; comme cas particulier, nous retrouverons deux des distributions les plus célèbres en théorie des choix collectifs, les modèles de culture impartiale (IC, pour Impartial Culture) et de culture impartiale anonyme (IAC, pour Impartial Anonymous Culture). Nous continuerons en étudiant des scénarios dans lesquels chaque district est composé de blocs homogènes de votants. Enfin, nous terminerons par un modèle original où chaque citoyen tire son utilité selon une même loi gaussienne, avec des représentants de type utilitariste.

2.1 Poids et marge de victoire électorale

Nous allons ici donner quelques réponses à la question du calcul des poids dans un modèle λ où l’information cardinale est séparée de l’information ordinale. Cette notion est introduite dans Le Breton et Van der Straeten (2015b). Précisément, nous supposerons que dans chaque district k, un vecteur ![]() est tiré selon une certaine loi de probabilité neutre.

est tiré selon une certaine loi de probabilité neutre.

Indépendamment de Xk, on tire au hasard un vecteur ![]() dans

dans ![]() . On supposera que les nk coordonnées sont indépendantes et identiquement distribuées avec un moment d’ordre 1 fini noté ξk. Pour tout i = 1,…, nk, l’utilité du citoyen i pour l’option 1 est définie par la variable aléatoire :

. On supposera que les nk coordonnées sont indépendantes et identiquement distribuées avec un moment d’ordre 1 fini noté ξk. Pour tout i = 1,…, nk, l’utilité du citoyen i pour l’option 1 est définie par la variable aléatoire :

Dans le cas du modèle aléatoire neutre λ ainsi défini, la corrélation entre les citoyens est exclusivement ordinale, au sens où Xi > 0 informe sur le signe de Ui mais non sur sa valeur. Soit Sk l’ensemble des citoyens de Nk votant pour 1 (les autres votant pour 0). Des hypothèses ci-dessus, on déduit :

(les électeurs dans Sk votent 1 et les autres votent 0) × (2|Sk|– nk).

(les électeurs dans Sk votent 1 et les autres votent 0) × (2|Sk|– nk).

Si l’on définit ![]() ,

,

on remarque que : ![]()

où ![]() est la marge de victoire espérée dans le district k. En résumé, à la constante ξk multiplicative près, le poids de Barberà-Jackson du district k est entièrement déterminé par la marge espérée dans le district. Dans la suite de cette section, nous supposerons que ξk = 1 pour tout k = 1,…, K.

est la marge de victoire espérée dans le district k. En résumé, à la constante ξk multiplicative près, le poids de Barberà-Jackson du district k est entièrement déterminé par la marge espérée dans le district. Dans la suite de cette section, nous supposerons que ξk = 1 pour tout k = 1,…, K.

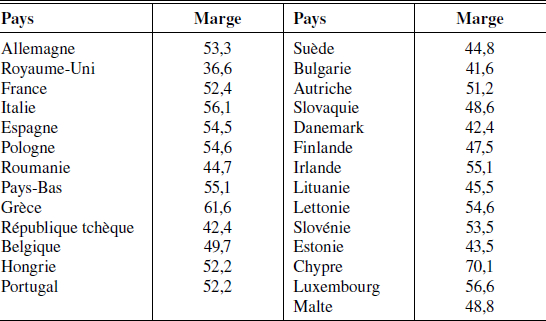

L’enquête Eurobarometer est une enquête d’opinion qui pose règulièrement les mêmes questions aux citoyens de tous les pays de l’Union européenne. Dans une version document de travail de leur article, Barberà et Jackson (2004) exploitent les réponses à 11 questions dichotomiques[21] extraites de l’enquête datée de décembre 2003 pour obtenir une moyenne empirique de la marge relative de victoire (définie ici comme la valeur moyenne de l’écart absolu entre les opinions favorables et les opinions défavorables ). Ces valeurs d’écart moyen sont reportées dans le tableau 1. La valeur 70,1 pour Chypre indique qu’en moyenne, les citoyens de ce pays ont répondu de manière très consensuelle aux 11 questions posées. À l’inverse, au Royaune-Uni, les écarts sont plus faibles en moyenne (36,6).

Tableau 1

Marges de victoire estimées (UE 27)

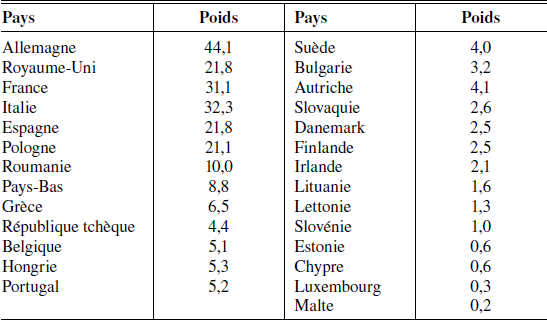

Ainsi, ils obtiennent un proxy sur la manière dont les citoyens européens voteraient sur des questions d’intérêt général qui leur seraient soumises et sur la valeur des poids wk : ils sont obtenus en multipliant la taille de la population par la marge de victoire, et présentés dans le tableau 2. Ainsi, le poids de l’Allemagne 44,1 résulte du produit de sa population (82,3 millions d’habitants) par sa marge. La plupart des pays sont fortement consensuels : Chypre détient le record mais le Royaume-Uni est le plus clivé. À ce jeu, il est le grand perdant. Puisque sa population est en moyenne plus divisée que celle des autres pays sur les questions posées, son poids est nettement inférieur à sa population (59,5 millions × 0,366 = 21,8). Comme le font remarquer Barberà et Jackson, une régression linéaire de la marge sur la population fait apparaître un coefficient de -0,007. Autant dire qu’ici (le Royaume-Uni mis à part) les poids de Barberà-Jackson sont quasi proportionnels aux populations.

Tableau 2

Poids calculés (UE 27)

2.2 Échangeabilité

Pour aller plus loin dans cette direction, il nous faut comprendre les déterminants fondamentaux de la marge de victoire électorale. Nous allons nous limiter ici au cas d’un seul modèle, appelé modèle d’échangeabilité forte par Le Breton et Van der Straeten (2015a,b). L’échangeabilité décrit la situation où la probabilité des différentes situations ne dépend que du nombre d’opinions dans chaque camp et non des noms de ceux qui les expriment.

Formellement, nous dirons que la loi de tirage λk satisfait à une propriété d’échangeabilité forte[22] s’il existe une loi de probabilité Gk sur [0,1] telle que :

où ![]() est le nombre de vote 1 pour toute suite

est le nombre de vote 1 pour toute suite ![]() de -1 et de 1.

de -1 et de 1.

Pour préserver les hypothèses faites jusqu’à présent, nous allons supposer que Gk est symétrique par rapport à ![]() , ce qui implique que son espérance vaut

, ce qui implique que son espérance vaut ![]() . Dans ce cas on obtient :

. Dans ce cas on obtient :

Ce modèle couvre de nombreuses situations différentes. Par exemple, ![]() [23] représente le cas de la corrélation parfaite. À l’opposé,

[23] représente le cas de la corrélation parfaite. À l’opposé, ![]() représente le cas où les préférences des citoyens du district k sont indépendantes entre elles. Dans ce cas binaire, il correspond au modèle IC qui est l’un des modèles probabilistes de référence en théorie du choix social. On peut bien entendu envisager d’autres lois. Un autre exemple très populaire en théorie du choix social est le modèle IAC[24] qui correspond au cas où Gk est la loi uniforme. De ce point de vue, on peut regarder le modèle d’échangeabilité forte comme une version généralisée du modèle IAC[25].

représente le cas où les préférences des citoyens du district k sont indépendantes entre elles. Dans ce cas binaire, il correspond au modèle IC qui est l’un des modèles probabilistes de référence en théorie du choix social. On peut bien entendu envisager d’autres lois. Un autre exemple très populaire en théorie du choix social est le modèle IAC[24] qui correspond au cas où Gk est la loi uniforme. De ce point de vue, on peut regarder le modèle d’échangeabilité forte comme une version généralisée du modèle IAC[25].

Le poids de Barberà-Jackson wk (λ) du district k vaut donc ici :

Dans le cas où ![]() , on obtient :

, on obtient :

En utilisant le fait que :

on en déduit que la marge de victoire espérée de l’alternative 1 lorsqu’elle est majoritaire vaut :

Quand la population du district est grande, on peut utiliser la formule de Stirling pour obtenir

et donc un poids de Barberà-Jackson asymptotiquement égal à :

Cette formule de la racine carrée a fait couler beaucoup d’encre et a donné lieu à une vaste littérature que nous n’allons pas exhaustivement répertorier ici[26]. Notons qu’elle implique une proportionnalité dégressive : le poids d’un citoyen d’un pays peuplé est inférieur à celui d’un pays moins peuplé. Mais pour ce faire, elle suppose que les opinions des citoyens de chaque pays sont complètement indépendantes et n’exhibent donc (dans le cas d’échangeabilité retenu ici) aucune forme de corrélation. Il s’agit d’un cas très spécial et non générique et l’introduction d’une corrélation nous écarte de cette conclusion.

Considérons maintenant le cas examiné dans Le Breton et Van der Straeten où Gk (parfois simplement notée G dans la suite de cette section) est décrite par une densité bêta concave et symétrique g, c’est-à-dire :

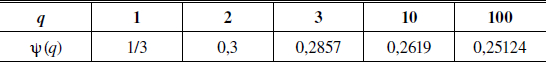

Le cas où q = 1 correspond au cas où G est la distribution uniforme sur [0,1] c’est-à-dire le modèle IAC déjà évoqué. La version généralisée considérée ici a été introduite par Berg (1990) qui appelle ![]() le paramètre de cohérence du groupe ou homogénéité. On voit que la corrélation des membres du distict k, noté ψ (q), est en effet liée à la valeur de q comme indiqué ci-dessous :

le paramètre de cohérence du groupe ou homogénéité. On voit que la corrélation des membres du distict k, noté ψ (q), est en effet liée à la valeur de q comme indiqué ci-dessous :

Voici quelques valeurs de cette fonction :

Tableau 3

Corrélation entre les votes

La fonction ψ tend vers ![]() (le cas indépendant) lorsque q tend vers +∞, c’est-à-dire quand la cohésion du groupe tend vers 0.

(le cas indépendant) lorsque q tend vers +∞, c’est-à-dire quand la cohésion du groupe tend vers 0.

En utilisant la formule classique,

![]() pour tout entier m et tout entier l

pour tout entier m et tout entier l

on obtient une expression explicite du poids de Barberà-Jackson du district k :

Lorsque qk = 1, on obtient après simplifications :

alors qu’avec qk = 2, on obtient :

Dans les deux cas, on constate que le ratio  tend vers une constante. De manière genérale, en conjecturant[27] que

tend vers une constante. De manière genérale, en conjecturant[27] que ![]() se comporte asymptotiquement comme

se comporte asymptotiquement comme ![]() lorsque

lorsque ![]() , on obtient, dans le cas d’une loi bêta :

, on obtient, dans le cas d’une loi bêta :

et donc

Par conséquent, le poids du vote du représentant du district k est une fonction linéaire de la population du district et si le paramètre qk est le même pour tout district, on retrouve des poids directement proportionnels à la population. On remarque en outre que le coefficient de proportionnalité ![]() du district k décroît avec qk : plus les préférences sont corrélées, plus les poids de Barberà-Jackson sont élevés. Le tableau ci-dessous présente quelques valeurs de ϕ(q).

du district k décroît avec qk : plus les préférences sont corrélées, plus les poids de Barberà-Jackson sont élevés. Le tableau ci-dessous présente quelques valeurs de ϕ(q).

Tableau 4

Coefficient de proportionnalité

La formule montre aussi que lorsque q tend vers l'infini, alors

Ainsi, quand q tend vers +∞, le coefficient de proportionnalité tend vers 0 comme l’inverse de la racine carrée du coefficient d’homogénéité. Sous réserve que certaines conjectures soient confirmées, les développements ci-dessus suggèrent l’extrême fragilité de la formule de la racine carrée et offrent un regard sur les déterminants du coefficient de proportionnalité.

2.3 Le cas des États composés de blocs

Ces calculs et les conclusions qui leur sont attachées ont été conduits sous l’hypothèse que λ satisfait à la propriété d’échangeabilité forte. On peut mener une analyse similaire sous des hypothèses où la symétrie entre les électeurs du même district est beaucoup moins forte et aboutir à des conclusions identiques. Par exemple, dans la lignée du beau travail précurseur de Penrose (1952), Barberà et Jackson (2006) mais aussi Le Breton et Van der Straeten (2015b)[28] considèrent des districts composés de blocs. Le mot bloc décrit l’idée de corrélations locales : les corrélations entre les préférences d’électeurs sont inexistantes entre les blocs mais fortes au sein des blocs. On retrouve en grande partie l’esprit des résultats obtenus dans le cas d’échangeabilité. Supposons que le district k soit composé de bk blocs équipeuplés de taille tk (donc bktk = nk) et que les préférences au sein de chaque bloc sont parfaitement corrélées. Si le profil des préférences d’un bloc est décrit par la probabilité ![]() , alors on obtient :

, alors on obtient :

En particulier, si le nombre de blocs bk est fixe (indépendant de la taille du district), on retrouve la formule de proportionnalité alors que si la taille tk d’un bloc est fixe, le nombre de blocs augmente indéfiniment avec la taille et on reproduit une formule du type racine carrée. Asymptotiquement on obtient :

2.4 Le cas de représentants utilitaristes

Citons enfin les travaux pionniers de Beisbart, Bovens et Hartmann (2005). Contrairement à ce qui est supposé dans les lignes qui précèdent, ils considèrent un modèle où la possibilité de corrélation cardinale est prise en considération et se focalisent sur le cas où les représentants sont de type utilitariste. Précisément, ils supposent (à des fins calculatoires) que pour tout k = 1, …, K, la loi λk est une loi gaussienne dont toutes les marginales sont égales. Soit μk et Ωk la moyenne et la matrice de variances-covariances de la loi λk. En supposant que λk est non biaisée, c’est-à-dire ici que μk = 0 et que toutes les corrélations sont identiques au sein d’un district, on obtient que ![]() suit une loi gaussienne de moyenne nulle et d’écart type

suit une loi gaussienne de moyenne nulle et d’écart type ![]() où ρk désigne le coefficient de corrélation. On en déduit que le poids de Barberà-Jackson du district k qui est ici le moment d’ordre 1 de la loi gaussienne tronquée

où ρk désigne le coefficient de corrélation. On en déduit que le poids de Barberà-Jackson du district k qui est ici le moment d’ordre 1 de la loi gaussienne tronquée ![]() est égal à

est égal à ![]()

![]() . Lorsque ρk ≠ 0, le poids de Barberà-Jackson du district k est donc asymptotiquement proportionnel à nk.

. Lorsque ρk ≠ 0, le poids de Barberà-Jackson du district k est donc asymptotiquement proportionnel à nk.

La principale leçon qualitative qui découle des arguments développés dans cette section est que la proportionnalité des poids aux populations semble s’imposer génériquement dans le modèle considéré par Barberà et Jackson et que le coefficient de proportionnalité dépendra du caractére plus ou moins consensuel du district. À l’extrême, un district clivé sur tous les sujets (IC) nous écarte donc de la proportionnalité, mais même lorsque ce n’est pas le cas, une forte concentration de la masse de probabilité autour de ![]() sera un indicateur très fort d’une société où les marges de victoire seront très serrées et où donc, finalement, le représentant ne représente pas grand chose au premier ordre. Rien d’étonnant qu’en pareil cas son poids soit affecté de peu de valeur dans le mécanisme optimal[29].

sera un indicateur très fort d’une société où les marges de victoire seront très serrées et où donc, finalement, le représentant ne représente pas grand chose au premier ordre. Rien d’étonnant qu’en pareil cas son poids soit affecté de peu de valeur dans le mécanisme optimal[29].

3. Robustesse aux changements de critères

Dans la section précédente, nous avons dérivé le mécanisme optimal de vote dans le cas où l’objectif poursuivi était la maximisation de l’utilité totale espérée. Nous avons démontré le résultat fondamental de Barberà et Jackson énonçant que ce mécanisme s’apparentait à un mécanisme pondéré majoritaire. Nous avons aussi analysé les arguments qui conduisaient à donner du poids au vote d’un district par rapport aux autres districts. Ce faisant, nous avons cependant passé sous silence un certain nombre de questions que nous allons examiner dans cette section ainsi que les réponses qui leur ont été apportées dans quelques contributions fondamentales.

Nous retiendrons ici le cas binaire particulier mais important évoqué à la fin de la section 2. Rappelons qu’il suppose que pour tout i ∈ N, Ui prend exclusivement les valeurs 1 et -1. Dans ce cas, le poids de Barberà-Jackson wk du district k est égal à l’espérance de la marge du camp victorieux.

3.1 Les objectifs égalitaristes

Dans les sections précédentes, nous avons privilégié le critère de maximisation de la somme des utilités espérées. Ceci ne surprendra pas les économistes tant ce critère est populaire dans leur communauté (même si ici il fait intervenir des espérances d’utilité et non des utilités). En revanche, en science politique, il est plus commun de privilègier un objectif mettant en avant un critère d’égalité. Le plus célèbre d’entre eux, « Un homme, une voix », suggère que le mécanisme doit être choisi de sorte que tous les citoyens jouissent (ex ante) de la même possibilité d’influencer le résultat de la décision collective. Le mot influence dans cette phrase n’a aucune raison de coïncider avec le mot utilité. Intuitivement, on imagine aisément qu’un citoyen influent verra plus souvent que d’autres ses préférences prises en compte dans le choix collectif et jouira donc finalement d’une utilité plus grande, mais la nature exacte de cette relation n’est pas immédiate. Elle dépendra du mécanisme C et du modèle probabiliste λ.

Le critère d’égalisation du pouvoir ou de l’influence était le plus populaire dans la littérature jusqu’à ce que, dans la lignée de la contribution de Barberà et Jackson, les approches utilitaristes se développent. Son origine remonte aux travaux pionners de Penrose (1946, 1952) et Banzhaf (1965). La notion clef est celle de joueur décisif (swing) : un votant est décisif chaque fois qu’il est en mesure de modifier le résultat du scrutin en modifiant l’expression de son bulletin. Le pouvoir ou l’influence d’un votant se définit alors comme sa probabilité a priori de déposer un bulletin décisif dans l’urne; cette même probabilité dépend évidement des hypothèses probabilistes faites sur le comportement de tous les citoyens.

Nous pouvons reprendre les élements de la section 2 pour décrire rapidement les principaux points du raisonnement[30]. Dans le modèle de Penrose-Banzhaf, chaque votant choisit de manière indépendante l’option 1 ou 0 avec probabilité ![]() , ce qui nous ramène au modèle IC. Sous cette hypothèse, toutes les 2n configurations de vote sont équiprobables, et le pouvoir d’un votant i est juste la proportion des configurations des votes des (n-1) autres votants pour lesquelles il est décisif. Ceci définit simplement le pouvoir de Banzhaf (non normalisé) du votant i, noté Bi (C) :

, ce qui nous ramène au modèle IC. Sous cette hypothèse, toutes les 2n configurations de vote sont équiprobables, et le pouvoir d’un votant i est juste la proportion des configurations des votes des (n-1) autres votants pour lesquelles il est décisif. Ceci définit simplement le pouvoir de Banzhaf (non normalisé) du votant i, noté Bi (C) :

Dans le contexte fédéral, il faut prendre en compte le fait que chaque individu i dépose son bulletin dans un district particulier k. Comme chaque représentant suit le souhait de la majorité de ses électeurs et que les votes sont indépendants entre districts, on a :

Dans un mécanisme indirect, le vote de i est décisif dans son district dans

configurations possibles parmi les ![]() possibles. Pour nk grand, ce rapport tend vers

possibles. Pour nk grand, ce rapport tend vers ![]() . D’autre part, si K est grand, qu’aucun district n’a un poids wk trop grand dans l’assemblée et qu’aucun comportement irrégulier n’est observé quant à la répartition de ceux-ci, Penrose affirme que le ratio des indices de pouvoir,

. D’autre part, si K est grand, qu’aucun district n’a un poids wk trop grand dans l’assemblée et qu’aucun comportement irrégulier n’est observé quant à la répartition de ceux-ci, Penrose affirme que le ratio des indices de pouvoir, ![]() entre les représentants des États k et k’ dans le jeu pondéré majoritaire est approximativement égal au rapport de leurs poids respectifs,

entre les représentants des États k et k’ dans le jeu pondéré majoritaire est approximativement égal au rapport de leurs poids respectifs, ![]() . Dès lors, l’égalité des pouvoirs est obtenue si

. Dès lors, l’égalité des pouvoirs est obtenue si

c’est-à-dire, si les poids wk sont proportionnels à ![]() .

.

Ce résultat est connu sous le nom de « Loi de la racine carrée de Penrose » et nous reviendrons sur les conditions de sa validité.

Préconiser l’adoption de poids proportionnels aux racines carrées des populations des États et l’utilisation d’un super quota n’est toutefois pas sans critique. En particulier, Gelman, Katz et Bafumi (2004) en compilant des décennies de données électorales montrent très clairement que les comportements des électeurs américains sont peu en phase avec l’hypothèse IC; plus précisement, ils montrent que les marges de victoire (mesurées en pourcentage) entre les deux grands Partis républicain et démocrate ne dépendent pas de la taille de l’État, alors que le modèle IC suggère des résultats plus serrés dans les États importants. Une réponse immédiate est de se tourner vers d’autres modèles probabilistes a priori. Comme dans la section 2, nous pouvons considérer le modèle IAC. Dans ce cas, la probabilité d’obtenir t voix pour l’option 1 parmi n votes est décrite désormais par :

Comme les votes entre États restent indépendants, l’équation (4) reste valable. Le pouvoir d’un individu j dans l’État k dépend des  configurations des autres votants pour lesquelles les votes pour 1 et 0 s’égalisent (avec nk impair). Ainsi,

configurations des autres votants pour lesquelles les votes pour 1 et 0 s’égalisent (avec nk impair). Ainsi,

Toujours du fait de l’indépendance des votes entre États, comme aucun de ceux-ci n’est biaisé en faveur d’une option a priori, chaque autre État votera pour 0 ou 1 avec une probabilité de ![]() . Dans le jeu entre États, si les conditions en sont vérifiées, l’approximation de Penrose peut s’appliquer : le rapport de pouvoir entre deux États s’approche du rapport des poids, et l’on en déduit

. Dans le jeu entre États, si les conditions en sont vérifiées, l’approximation de Penrose peut s’appliquer : le rapport de pouvoir entre deux États s’approche du rapport des poids, et l’on en déduit

Contrairement à la situation décrite sous l’hypothèse IC, le traitement égal entre les votants est désormais obtenu avec des poids proportionnels aux populations.

3.2 La validité du théorème limite de Penrose

Les deux résultats que nous venons d’évoquer reposent sur une idée commune : le ratio des indices de Banzhaf de deux joueurs est approximativement égal au ratio de leurs poids quand il y a suffisamment de joueurs et qu’aucun ne domine outrageusement l’assemblée. Cette propriété a fait l’objet d’une vaste littérature visant principalement à explorer les conditions de sa validité, qui ne sont pas détaillées dans les travaux de Penrose.

Lorsque K est grand et sous réserve que certaines conditions soient satisfaites, l’approximation (connue sous le nom de théorème limite de Penrose (LPT)) est valide (Lindner et Machover, 2004) dans le cas du quota majoritaire. En pratique, il reste à examiner si ces approximations sont valides « en moyenne »[31] et si elles le sont dans des cas particuliers importants. Chang, Chua et Machover (2006) procèdent à des simulations en tirant au hasard pour de nombreuses valeurs de l’entier K le vecteur w puis en calculant la moyenne et la variance de deux indices mesurant l’écart entre le vecteur de Banzhaf normalisé et le vecteur normalisé des poids. Ils confirment que lorsque le quota est le quota majoritaire, la convergence a lieu lorsque K tend vers des valeurs très grandes mais aussi que cette convergence cesse d’être vraie pour des quotas supérieurs.

Le principe égalitariste pose en réalité un problème très difficile. En pratique, les valeurs de K sont relativement petites et l’objectif égalitariste, dès l’instant où il ne peut pas être satisfait exactement ou presque exactement (il ne faut pas oublier que le problème est ici combinatoire), oblige à se donner un critère de minimisation par rapport à un objectif cible. On pourrait alors se donner comme objectif pour une norme donnée ![]() de déterminer un vecteur de poids w* et un quota q* tel que le vecteur de Banzhaf normalisé

de déterminer un vecteur de poids w* et un quota q* tel que le vecteur de Banzhaf normalisé ![]() résultant du jeu majoritaire pondéré

résultant du jeu majoritaire pondéré ![]() minimise la distance

minimise la distance ![]() . Nous nous sommes limités ici aux jeux majoritaires pondérés mais nous pourrions procéder de manière similaire pour un jeu simple W quelconque et remplacer

. Nous nous sommes limités ici aux jeux majoritaires pondérés mais nous pourrions procéder de manière similaire pour un jeu simple W quelconque et remplacer ![]() par β (W). Le vecteur β* est l’objectif cible, et dans le cas IC ci-dessus

par β (W). Le vecteur β* est l’objectif cible, et dans le cas IC ci-dessus  puisque l’on a vu que le pouvoir d’un État devait être proportionnel à la racine carré de sa population. Ce problème est connu sous le nom de problème de Banzhaf inverse (Alon et Edelman, 2010). Il n’est pas évident de savoir quels sont les vecteurs du simplexe qui peuvent s’écrire comme des vecteurs de Banzhaf normalisés d’un jeu simple adéquatement construit. Il en résulte que la résolution du problème de minimisation ci-dessus n’est pas un problème facile. On peut pour les toutes petites valeurs de K « passer en force » en énumérant au préalable l’ensemble des jeux (les nombres respectifs apparaissent dans l’annexe) mais rapidement (disons pour K ≥ 9) la nécessité de développer des méthodes algorithmiques intelligentes s’impose[32]. Il existe plusieurs contributions à cette littérature[33]. On peut citer par exemple le travail de Kurz (2012a) qui montre comment formuler le problème inverse comme un problème de programmation linéaire avec contraintes entières. Kurz et Napel (2014) utilisent cettte technique de résolution pour comparer (pour trois normes différentes) les performances de trois mécanismes de vote qui ont en commun de prendre comme vecteur de poids w le vecteur cible β* mais diffèrent quant aux quotas respectifs utilisés :

puisque l’on a vu que le pouvoir d’un État devait être proportionnel à la racine carré de sa population. Ce problème est connu sous le nom de problème de Banzhaf inverse (Alon et Edelman, 2010). Il n’est pas évident de savoir quels sont les vecteurs du simplexe qui peuvent s’écrire comme des vecteurs de Banzhaf normalisés d’un jeu simple adéquatement construit. Il en résulte que la résolution du problème de minimisation ci-dessus n’est pas un problème facile. On peut pour les toutes petites valeurs de K « passer en force » en énumérant au préalable l’ensemble des jeux (les nombres respectifs apparaissent dans l’annexe) mais rapidement (disons pour K ≥ 9) la nécessité de développer des méthodes algorithmiques intelligentes s’impose[32]. Il existe plusieurs contributions à cette littérature[33]. On peut citer par exemple le travail de Kurz (2012a) qui montre comment formuler le problème inverse comme un problème de programmation linéaire avec contraintes entières. Kurz et Napel (2014) utilisent cettte technique de résolution pour comparer (pour trois normes différentes) les performances de trois mécanismes de vote qui ont en commun de prendre comme vecteur de poids w le vecteur cible β* mais diffèrent quant aux quotas respectifs utilisés : ![]() et

et ![]() . La qualité des deux dernières méthodes a été découverte par Słomczyński et Życzkowski (2006, 2008, 2014)[34]. Les valeurs obtenues en cherchant numériquement la solution du problème inverse pour l’Europe à 25 et l’Europe à 27 sont compatibles avec une précision de 2 % avec les données obtenues sur la base des populations de l’Union. Ils montrent que dans le cas de l’Europe à 25 les ratios sont tous très voisins de 1 lorsque q est approximativement égal à 62 %[35]. Ils démontrent aussi que ce résultat est robuste dans le sens où il reste vrai pour des vecteurs de populations autres que le vecteur réel de populations.

. La qualité des deux dernières méthodes a été découverte par Słomczyński et Życzkowski (2006, 2008, 2014)[34]. Les valeurs obtenues en cherchant numériquement la solution du problème inverse pour l’Europe à 25 et l’Europe à 27 sont compatibles avec une précision de 2 % avec les données obtenues sur la base des populations de l’Union. Ils montrent que dans le cas de l’Europe à 25 les ratios sont tous très voisins de 1 lorsque q est approximativement égal à 62 %[35]. Ils démontrent aussi que ce résultat est robuste dans le sens où il reste vrai pour des vecteurs de populations autres que le vecteur réel de populations.

L’expression analytique du quota « optimal » (Słomczyński et Życzkowski, 2014) est égale à :

où xk désigne la part de la population du district k dans la population totale. S’il n’est pas connu avec certitude pour pouvoir être utilisé (parce que par exemple les populations des États sont susceptibles d’évoluer) comme c’est le cas dans la formule ci-dessus, on peut par exemple supposer qu’il est tiré au hasard uniformément dans le simplexe. Cette loi de tirage est un cas particulier d’une distribution de Dirichlet P. En faisant la moyenne de q par rapport à P, on obtient :

où :

En s’inspirant de résultats connus énonçant que  , on en déduit que :

, on en déduit que : ![]() .

.

3.3 Utilitarisme et égalitarisme

Rien n’interdit de remplacer le critère utilitariste par un critère utilitariste généralisé dans le sens où les utilités font l’objet d’un rééchelonnement concave de façon à refléter une préférence pour l’égalité. Le travail de Koriyama, Laslier, Macé et Treibich (2013) que nous allons décrire et motiver sur d’autres bases dans la section 4.1 peut être interprété comme une solution de ce problème dans le contexte du modèle aléatoire particulier qu’ils considèrent[36]. En pareil cas, l’objectif serait de maximiser :

où v est une fonction (strictement) concave définie sur R. Plus v est concave, plus l’attention se porte sur l’égalitarisme. Dans le cas où par exemple ![]() avec δ ≥ 0 (v(x) = ln(x) lorsque δ = 1), plus δ est élevé, plus le critère égalitariste prend de l’importance. Lorsque δ tend vers l’infini, le problème ci-dessous est équivalent à la maximisation du critère de Rawls[37] :

avec δ ≥ 0 (v(x) = ln(x) lorsque δ = 1), plus δ est élevé, plus le critère égalitariste prend de l’importance. Lorsque δ tend vers l’infini, le problème ci-dessous est équivalent à la maximisation du critère de Rawls[37] :

On pourrait ainsi de manière générale remplacer la doctrine utilitariste par des principes égalitaristes : un mécanisme C sera égalitariste s’il égalise ex ante les utilités des différents citoyens (Laruelle et Valenciano, 2010). Les deux objectifs, égalitariste et utilitariste, ne débouchent pas nécessairement sur les mêmes recommandations. Par exemple, dans le cas d’un modèle où chaque district a un nombre fixe de blocs, l’optimum utilitariste implique que l’utilité d’un membre d’un pays plus peuplé est plus élevée que celle d’un membre d’un pays moins peuplé. En revanche, comme le notent Barberà et Jackson, dans le cas où le modèle comporte un nombre variable de blocs de taille fixe par pays, les implications de l’optimum utilitariste en matière d’égalisation des utilités sont ambiguës. Barberà et Jackson donnent des exemples montrant que toutes les situations peuvent se produire[38].

3.4 Critères de succès, de déficit majoritaire espéré et d’efficacité majoritaire

Dans les versions égalitaristes et utilitaristes de l’objectif considéré jusqu’à présent, nous avons accordé beaucoup d’importance aux utilités des citoyens concernés par cette décision. Dans la version canonique sans biais du problème, nous avons supposé que l’utilité de l’alternative 1 pouvait prendre deux valeurs : 1 et -1. Dans ce cas, nous avons vu que l’utilité d’un citoyen se confond avec la probabilité de préférer 1 et d’un vote collectif en faveur de 1 moins la probabilité de préférer 0 et d’un vote collectif en faveur de 1. Sachant que la probabilité de préférer 0 est supposée égale à ![]() , l’utilité espérée peut aussi s’écrire comme la probabilité de préférer 1 et d’un vote collectif en faveur de 1 plus la probabilité de préférer 0 et d’un vote collectif en faveur de 0 moins

, l’utilité espérée peut aussi s’écrire comme la probabilité de préférer 1 et d’un vote collectif en faveur de 1 plus la probabilité de préférer 0 et d’un vote collectif en faveur de 0 moins ![]() , c’est-à-dire (à la constante

, c’est-à-dire (à la constante ![]() près) la probabilité de succès. Le critère utilitariste revient donc ici à maximiser la somme de probabilités de succès. Ex post on compte les pour et les contre et on opte pour la décision avec le support le plus grand. Notons que de façon équivalente, on pourrait considérer la qualité d’un mécanisme comme la différence entre l’espérance d’utilité totale du mécanisme majoritaire (qui est ici le mécanisme optimal ex ante et ex post) et l’espérance d’utilité totale pour le mécanisme considéré. La différence entre les deux quantités pour chaque réalisation possible des préférences individuelles vaut 0 dans le cas où le choix public coïncide avec le choix majoritaire et est égal à l’écart entre la taille du groupe de partisans de l’option choisie et la taille du groupe majoritaire dans le cas contraire. Avec cette normalisation, un mécanisme est de meilleure qualité lorsque cette mesure qui correspond au déficit majoritaire espéré (Felsenthal et Machover, 1998, 1999) est la plus petite possible. Notons que cette mesure correspond à une normalisation du critère de l’espérance d’utilité totale différente de celle retenue par Weber et introduite plus haut mais dans le même esprit.

près) la probabilité de succès. Le critère utilitariste revient donc ici à maximiser la somme de probabilités de succès. Ex post on compte les pour et les contre et on opte pour la décision avec le support le plus grand. Notons que de façon équivalente, on pourrait considérer la qualité d’un mécanisme comme la différence entre l’espérance d’utilité totale du mécanisme majoritaire (qui est ici le mécanisme optimal ex ante et ex post) et l’espérance d’utilité totale pour le mécanisme considéré. La différence entre les deux quantités pour chaque réalisation possible des préférences individuelles vaut 0 dans le cas où le choix public coïncide avec le choix majoritaire et est égal à l’écart entre la taille du groupe de partisans de l’option choisie et la taille du groupe majoritaire dans le cas contraire. Avec cette normalisation, un mécanisme est de meilleure qualité lorsque cette mesure qui correspond au déficit majoritaire espéré (Felsenthal et Machover, 1998, 1999) est la plus petite possible. Notons que cette mesure correspond à une normalisation du critère de l’espérance d’utilité totale différente de celle retenue par Weber et introduite plus haut mais dans le même esprit.

Par construction, cette mesure compte le nombre de personnes insatisfaites de la décision publique dès l’instant où ces personnes forment un groupe majoritaire dans la fédération. On pourrait imaginer une mesure plus qualitative où toutes les situations, où le choix majoritaire est pris en défaut, sont affectées du même poids. Dans ce cas, l’objectif que l’on cherche à minimiser est la probabilité qu’une telle situation se produise. Plusieurs mots sont utilisés dans la littérature pour qualifier une telle situation lorsqu’elle apparaît : on parle d’inefficacité majoritaire[39] chez les théoriciens du choix social, de paradoxe du referendum (Nurmi, 1999) ou encore d’élections inversées (Miller, 2012) pour n’en citer que quelques-uns. L’évaluation de cette probabilité pour des mécanismes C indirects donnés a été effectuée par peu d’auteurs car les calculs sont rapidement très difficiles même dans le cas symétrique. Considérons en effet tout d’abord le cas où les populations des différents districts sont toutes égales entre elles disons n1 = … = nk ≡ m et où les poids sont tous égaux avec quota majoritaire. La probabilité P(K, m) de l’événement « le mécanisme C (ainsi défini) produit une élection inversée » a été calculée par May (1949) dans le cas où le modèle λ est le modèle IAC. Il démontre en particulier que cette probabilité tend vers ![]() lorsque K et m tendent vers l’infini. Feix, Lepelley Merlin et Rouet (2004) et Lepelley, Merlin et Rouet (2011) ont retrouvé certains des calculs de May et ont aussi calculé explicitement cette probabilité dans le cas où K = 3, 4 et 5 et où m tend vers l’infini pour les modèles IC et IAC. À l’aide de simulations, ils étudient aussi le cas général, retrouvent sans surprise le résultat de May sous l’hypothèse IAC et montrent que cette probabilité tend vers 21 % lorsque K tend vers l'infini sous IC[40]. Lorsque la population totale n de la fédération est fixe et que les districts sont équipeuplés, la probabilité est nulle dans les cas où K = 1 et K = n. Beisbart et Bovens (2013) ont démontré dans ce contexte que le déficit majoritaire espéré est maximal lorsque le nombre de districts est égal à

lorsque K et m tendent vers l’infini. Feix, Lepelley Merlin et Rouet (2004) et Lepelley, Merlin et Rouet (2011) ont retrouvé certains des calculs de May et ont aussi calculé explicitement cette probabilité dans le cas où K = 3, 4 et 5 et où m tend vers l’infini pour les modèles IC et IAC. À l’aide de simulations, ils étudient aussi le cas général, retrouvent sans surprise le résultat de May sous l’hypothèse IAC et montrent que cette probabilité tend vers 21 % lorsque K tend vers l'infini sous IC[40]. Lorsque la population totale n de la fédération est fixe et que les districts sont équipeuplés, la probabilité est nulle dans les cas où K = 1 et K = n. Beisbart et Bovens (2013) ont démontré dans ce contexte que le déficit majoritaire espéré est maximal lorsque le nombre de districts est égal à ![]() [41].

[41].

Lorsque les districts ne sont pas équipeuplés, la caractérisation du (des) mécanisme(s) minimisant la probabilité de l’inefficience majoritaire/élection inversée est largement ouverte. Cette question a fait l’objet de travaux par Feix et al. (2008)[42], Lahrach et Merlin (2012) et Miller (2012) dans le cas du collège américain. Feix et al. ainsi que Lahrach et Merlin limitent leur exploration aux mécanismes de votes engendrés par des poids wk du type (nk)α où α ≥ 0. Notons que dans le cas où α tend vers l’infini, on est en présence d’un mécanisme dictatorial qui donne tout le pouvoir au représentant du district le plus peuplé. À l’inverse, la valeur α = 0 donne une voix à chaque représentant, indépendamment de la taille du district qu’il représente. Une étude complète du cas K = 3 apparaît dans Feix et al. (2008) pour une classe de modèles probabilistes couvrant IC et IAC. Pour une valeur quelconque de K, ils utilisent des simulations. Il ressort que dans le cas IAC, la règle qui minimise la probabilité du paradoxe du référendum est constamment la règle proportionnelle alors que dans le cas IC, la règle optimale impose une forme de dégressivité avec une valeur de α voisine de 0,4 pour de petites valeurs de K, mais tendant vers 0,5 lorsque K tend vers l’infini. On retrouve ainsi les conclusions qui semblent s’imposer dans la plupart des modèles que nous avons examinés, sans pour autant que l’on puisse ici donner une preuve formelle de l’optimalité de ces solutions (proportionnalité sous l’hypothèse IAC et loi de la racine carrée sous l’hypothèse IC) dans le cadre de la maximisation de l’efficacité majoritaire.

4. Des modèles alternatifs : le cadre du choix public

Le modèle canonique que nous venons de présenter n’est pas, loin de là, la seule route possible pour analyser les modes de scrutins indirects. Les contributions recensées dans cette section vont explorer trois autres pistes qui, à des titres divers, rompent[43] avec le modèle de choix binaire simple.

4.1 L’impact du nombre de décisions à prendre

Nous allons éliminer une fois pour toute à partir de maintenant le facteur ξ et même nous limiter (pour simplifier l’exposé) au cas où l’utilité de l’option 1 prend deux valeurs possibles (1 ou -1) avec la probabilité ![]() . Nous parlerons de succès pour l’électeur i lorsque la décision collective est identique à sa préférence individuelle. Si, comme nous l’avons supposé, l’utilité de la décision 0 est normalisée à 0, l’utilité espérée du citoyen i est égale à la probabilité de succès moins

. Nous parlerons de succès pour l’électeur i lorsque la décision collective est identique à sa préférence individuelle. Si, comme nous l’avons supposé, l’utilité de la décision 0 est normalisée à 0, l’utilité espérée du citoyen i est égale à la probabilité de succès moins ![]() . Notons que si nous avions supposé (en guise de normalisation) que l’utilité de la meilleure alternative de l’électeur i valait 1 et que celle de la moins bonne valait 0, alors l’utilité espérée du citoyen i aurait été égale à la probabilité de succès.

. Notons que si nous avions supposé (en guise de normalisation) que l’utilité de la meilleure alternative de l’électeur i valait 1 et que celle de la moins bonne valait 0, alors l’utilité espérée du citoyen i aurait été égale à la probabilité de succès.

Nous avons insisté sur le fait que l’analyse est menée dans un contexte dichotomique sans préciser cependant le nombre T de décisions de cette nature que le conseil aura à débattre[44]. Cette question est sans importance si nous supposons que les questions sont sans lien entre elles et que l’utilité de chaque électeur est la somme des utilités de chacune des décisions. Si les préférences sur chacune des décisions sont indépendantes et identiquement distribuées selon la loi λ, le mécanisme maximisant l’utilité totale espérée est le mécanisme de Barberà et Jackson. Ici, une conséquence est une suite de longueur T dont les coordonnées valent 0 ou 1. Une fois le mécanisme choisi, la probabilité que la tième coordonnée soit égale à 0 ou 1 dépend du mécanisme et du profil des préférences sur la tième coordonnée. L’utilité d’un citoyen porte donc sur une loterie dont une conséquence est une suite de 0 ou 1 et (du point de vue de chaque citoyen) une suite de succès et d’échecs selon que la décision collective est conforme ou non à son choix. Dans le cas où l’utilité d’une conséquence ne dépend que du nombre de succès t, l’utilité espérée du citoyen i est égale à :

où vi est la fonction de von Neumann-Morgenstern du citoyen i sur l’espace des conséquences pures qui ici est {0,1,…,T} et non {0,1}T et pi est la probabilité de succès du citoyen i (qui, rappelons-le, dépend de λ et du mécanisme C). Si λ est symétrique à l’échelle de chaque district (comme c’est le cas par exemple dans le cas d’échangeabilité), la probabilité pi ne dépend que du district auquel i appartient et sera notée abusivement pk (C) (pk (C) désigne donc la probabilité que sur l’une ou l’autre des T décisions, un citoyen générique du district k soit du bon côté).

Ce modèle général est introduit et exploré par Koriyama et al. (2013). Plus spécifiquement, ils supposent que νi ne dépend pas de i, que les districts sont indépendants entre eux et qu’il existe dans chaque district k un signal aléatoire qui prend les valeurs 0 ou 1 avec probabilité ![]() et que conditionnellement à la valeur de ce signal (0 ou 1), les citoyens de ce district votent (0 ou 1) avec probabilité μ >

et que conditionnellement à la valeur de ce signal (0 ou 1), les citoyens de ce district votent (0 ou 1) avec probabilité μ > ![]() . Ici, μ représente le niveau de corrélation entre les préférences au sein d’un district et est supposé être le même dans tous les districts. Le représentant du district k vote en fonction de la valeur du signal du district k.

. Ici, μ représente le niveau de corrélation entre les préférences au sein d’un district et est supposé être le même dans tous les districts. Le représentant du district k vote en fonction de la valeur du signal du district k.

La somme des utilités attachée au mécanisme C est donc égale à :

où pk (C) désigne la probabilité qu’un citoyen générique du district k soit du bon côté. Le principal objectif du travail de Koriyama et al. est de caractériser le(s) mécanisme(s) C maximisant la somme des utilités. Après avoir noté le caractère combinatoire de leur problème d’optimisation, ils l’écrivent comme un problème d’optimisation continue où la notion de jeu simple est remplacée par la notion de jeu simple probabiliste[45]. Ils démontrent que toutes les solutions du problème d’optimisation induisent le même vecteur p* = (p1*,…, pK*) de fréquences de succès et que nk > nk’ ⇒ pk* > pk’*. En considérant le vecteur des poids w* = (w1*,…, wK*) où wk* est proportionnel à nkU’ (pk*), ils démontrent que si U est croissante et strictement concave[46] alors toute solution du problème d’optimisation est un jeu probabiliste pondéré avec le vecteur de poids w* et le seuil ![]() . Le seul degré de liberté concerne la définition de la règle en cas d’égalité. Ils en déduisent facilement que le vecteur des poids du mécanisme optimal satisfait au principe de proportionnalité dégressive.

. Le seul degré de liberté concerne la définition de la règle en cas d’égalité. Ils en déduisent facilement que le vecteur des poids du mécanisme optimal satisfait au principe de proportionnalité dégressive.

Notons au passage que si v est linéaire alors les poids sont proportionnels aux populations alors que si la concavité est extrême (c’est-à-dire si l’objectif à maximiser est l’utilité espérée minimale) les poids sont tous égaux entre eux et la dégressivité est alors maximale. Le calcul des poids est en général un problème difficile. Macé et Treibich (2012) développent un algorithme itératif : ils partent d’un vecteur de poids initial et le modifient localement de façon intelligente afin d’obtenir un maximum local du problème numérique d’optimisation.

4.2 D’un choix dichotomique au choix sur un intervalle

Un autre modèle différent de celui considéré ici est décrit par le cas où l’ensemble des décisions publiques est un intervalle de la droite réelle et les fonctions d’utilités des citoyens sont supposées unimodales. Dans ce contexte, la notion de représentant majoritaire à l’échelle de chacun des districts est parfaitement définie (c’est l’électeur médian) et on peut reprendre l’analyse ci-dessus sur le plan conceptuel sans changer une virgule aux principales définitions de Barberà et Jackson. Ce modèle a d’abord été proposé par Maaser et Napel (2007), alors qu’ils cherchaient à égaliser la probabilité d’être décisif entre les électeurs de différents districts. Ce même objectif est poursuivi dans Kurz, Maaser et Napel (2017). Le modèle a été aussi repris dans la veine utilitariste dans Maaser et Napel (2012) pour minimiser l’écart entre les positions médianes issues des votes direct et indirect et dans Maaser et Napel (2014) pour rechercher le maximum d’utilité. Dans ce nouveau contexte, l’analogue de la distribution de probabilité l est une distribution aléatoire des points idéaux des différents citoyens (θi)1≤i≤n. Cette distribution définit K points idéaux médians ![]() qui en combinaison avec un vecteur de poids w = (w1,…, wK) définissent le point idéal dans la fédération (le « médian des médians »).

qui en combinaison avec un vecteur de poids w = (w1,…, wK) définissent le point idéal dans la fédération (le « médian des médians »).